AlphaGo其实很简单~

摘要

由于其巨大的搜索空间以及评估棋盘状态和落子的难度,围棋一直被认为是人工智能经典游戏中最具挑战性的游戏。在这篇文章里,作者介绍了一种新的AI围棋方法,它使用“价值网络”来评估棋盘位置和“策略网络”来选择落子。主模型以深度神经网络为主,训练由对人类专家的经验进行监督学习和自对弈的强化学习组成。研究者将训练成的价值网络、策略网络应用到蒙特卡洛搜索的过程中,从而增加了每个落子的价值。使用这种搜索算法,AlphaGo对其他围棋程序的胜率达到了99.8%,并以5比0击败了人类欧洲围棋冠军。

技术路线

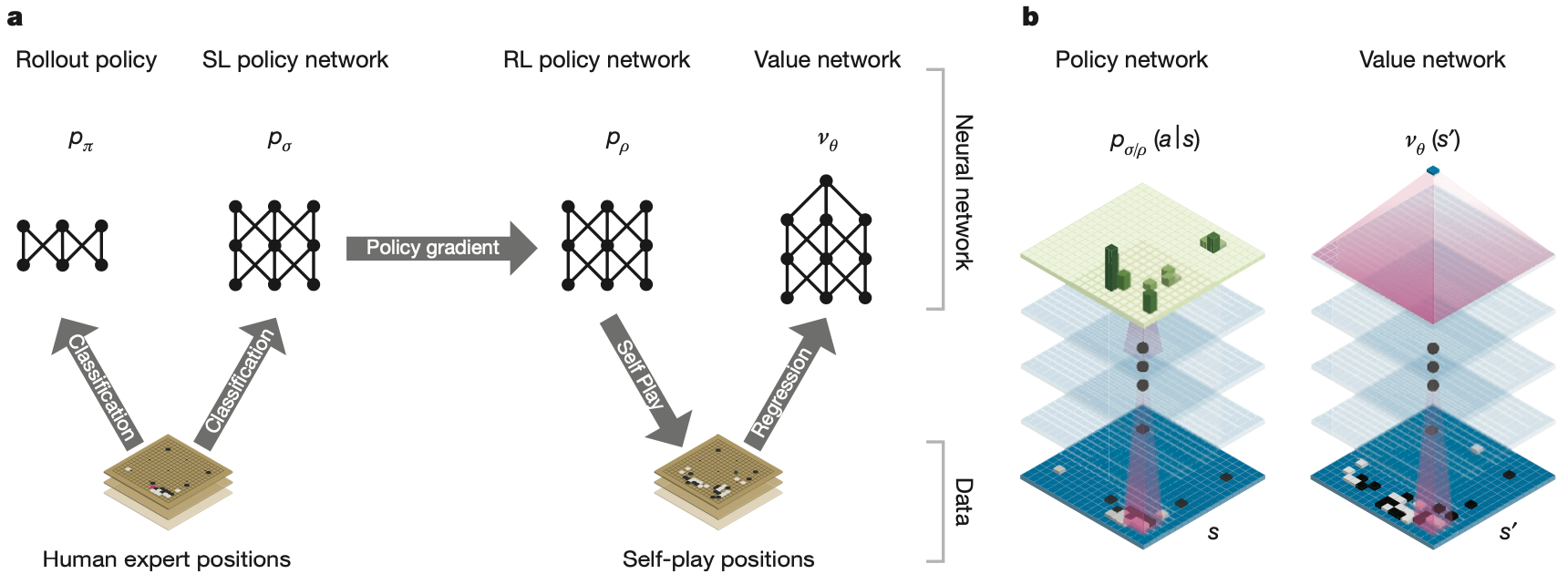

图a:p_{\pi} 和 p_{\sigma} 使用监督学习学习人类专家在不同棋盘状态下的落子,p_{\pi} 是一个更加轻量级的网络。p_{\rho} 的网络架构和 p_{\sigma} 想同,并且参数被初始化为训练好的p_{\sigma} 的参数,然后通过策略梯度强化学习自对弈进行改进,以最大化获胜的概率。通过使用强化学习策略网络 p_{\rho} 自对弈生成一个新的数据集。最后,回归训练一个价值网络 v_{\theta},以根据新数据集中的数据学习当前棋盘玩家获胜的期望。

图b:AlphaGo 中使用的神经网络架构的示意图。策略网络将棋盘状态 s 作为输入,通过参数为 \sigma 或 \rho的策略网络输出概率分布 p_{\sigma}(a|s) 或 p_{\rho}(a|s) 表示为了取胜当前棋盘每个合法位置的落子收益期望。价值网络类似地使用多个卷积层,参数为 \theta,输出一个标量值 v_{\theta}(s') 来预测当前棋盘状态的获胜期望。

策略网络的监督学习

训练的第一个阶段是使用监督学习学习人类专家的经验。SL 策略网络 p_{\sigma}(a|s) 在权重为 \sigma 的卷积层和非线性整流器之间交替,最终的 softmax 层输出所有合法落子位置的概率分布。策略网络的输入是棋盘状态的简单表示。策略网络在随机采样的状态-动作对上进行训练,使用随机梯度上升来最大化在状态 s 中选择的人类动作的可能性

\Delta\sigma\propto\frac{\partial p_{\sigma}(a|s)}{\partial\sigma} 作者从 KGS Go Server 的 3000 万个状态-动作训练了一个 13 层的策略网络,称为 SL(SupervisedLearning) 策略网络。该网络预测在测试集上的准确率为 57.0%,远远高于基准模型的 44.4%。然而,准确性的小幅提高会导致计算开销的增长,较大的网络可以获得更好的准确性,但在搜索过程中评估速度较慢。作者还训练了一个更快但不太准确的策略网络 p_{\pi}(a|s),使用更轻量级的特征的线性 softmax 达到了 24.2% 的准确率。p_{\pi}(a|s)选择一个动作只需要2 \mu s,比p_{\sigma}(a|s) 的3 ms要快得多。

策略网络的强化学习

训练的第二阶段旨在通过策略梯度强化学习 (RL) 改进策略网络。RL 策略网络 p_{\rho} 在结构上与 SL 策略网络相同,并且其权重 \rho 被初始化为相同的值,即 \rho = \sigma。使用随机化的动作采样策略放置过拟合,每个episode结束的时候设定胜方的reward为1,负方的reward为-1。然后在每个时间步 t,通过随机梯度上升最大化获胜的期望

\Delta\sigma\propto\frac{\partial p_{\rho}(a_t|s_t)}{\partial\sigma}z_t.值网络的强化学习

训练的最后一个阶段是评估每个棋盘状态获胜的期望,估计一个价值函数 v^p(s),训练时双方玩家都使用策略 p 预测的位置 s 的结果

v^p(s)=\mathbb{E}[z_t=z|s_t=s,a_{t\cdots T}\sim p]. RL价值网络与策略网络有相似的结构,参数为 \theta,使用策略梯度的MSE进行更新

\Delta\sigma\propto\frac{\partial v_{\theta}(s)}{\partial\theta}(z-v_{\theta}(s)).蒙特卡洛搜索

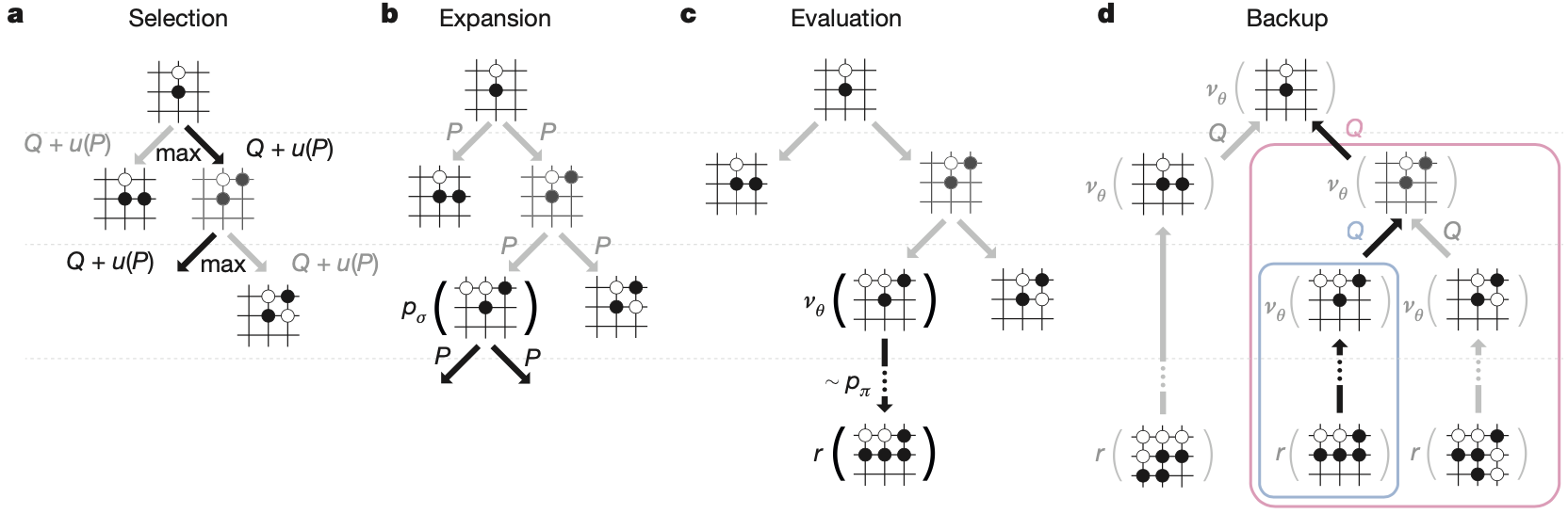

在对战中,AlphaGo 在 MCTS 算法中结合了策略和价值网络,该算法通过前瞻搜索来选择动作。搜索树的每条边 (s, a) 存储一个动作值 Q(s, a)、访问计数 N(s, a) 和先验概率 P(s, a)。从根状态开始模拟遍历可能的棋盘状态。 在每个模拟的每个时间步 t,从状态 s_t 中选择一个动作 a_t

a_t = \arg\max_a(Q(s_t,a)+u(s_t,a))来最大化价值+bonus

u(s,a) \propto \frac{P(s,a)}{1+N(s,a)}. Bonus 正比于先验概率,但是随着访问次数递减。当遍历在第L步到达叶节点 s_L 时,叶节点继续扩展,节点 s_L 仅由 SL 策略网络 p_\sigma 处理一次得到新的叶节点,输出概率存储为每个合法动作 a 的先验概率 P,p(s,a) = p_\sigma(a|s)。叶节点以两种不同的方式进行评估:首先是价值网络 v_\theta(s_L);其次,通过使用轻量级策略网络 \pi 随机出的从 L 直到最终步骤 T,使用混合参数 \lambda 将这些评估组合成叶节点的评估

V(s_L)=(1-\lambda)v_\theta(s_L)+\lambda z_L.在模拟结束时,更新所有遍历到的边的动作值和访问次数

N(s,a)=\sum_{i=1}^{n}1(s,a,i)\\

Q(s,a)=\frac{1}{N(s,a)}\sum_{i=1}^{n}1(s,a,i)V(s_L^i). 其中 s_i 是第 i 次模拟的叶节点,1(s, a, i) 表示在第 i 次模拟期间是否遍历了边 (s, a)。搜索完成后,算法从根位置选择访问次数最多的移动,因为这是根据概率分布采样的,被访问的次数阅读说明价值越大。

Thanks for the good writeup. It if truth be told was once a amusement account it. Look complex to far added agreeable from you! By the way, how can we be in contact?

https://postheaven.net/gumshape0/partying-the-legacy-associated-with-henry-thierry-also-referred-to-as

кайт египет

кайт школа египет

cialis 5 mg originale prezzo : an effective drug containing tadalafil, is used for erectile dysfunction and benign prostatic hyperplasia. In Italy, a 28-tablet pack of Cialis 5 mg is priced at around €165.26, though prices vary by pharmacy and discounts. Generic alternatives, like Tadalafil DOC Generici, cost €0.8–€2.6 per tablet, providing a budget-friendly option. Consult a doctor, as a prescription is needed.

погода хургада апрель 2023

https://med-express.spb.ru/kapelnicza-ot-pohmelya-effektivnyj-sposob-vosstanovleniya-organizma/

Hi there! I know this is kinda off topic nevertheless I’d figured I’d ask. Would you be interested in exchanging links or maybe guest writing a blog article or vice-versa? My site discusses a lot of the same subjects as yours and I feel we could greatly benefit from each other. If you might be interested feel free to shoot me an e-mail. I look forward to hearing from you! Fantastic blog by the way!

https://imperialgroup.com.ua/yak-vybraty-ta-vstanovyty-linzy-v-fary

https://oboronspecsplav.ru/

Nice post. I learn something new and challenging on blogs I stumbleupon on a daily basis. It’s always useful to read content from other writers and use something from other sites.

my Zain

«Рентвил» предлагает аренду автомобилей в Краснодаре без залога и ограничений по пробегу по Краснодарскому краю и Адыгее. Требуется стаж от 3 лет и возраст от 23 лет. Оформление за 5 минут онлайн: нужны только фото паспорта и прав. Подача авто на жд вокзал и аэропорт Краснодар Мин-воды Сочи . Компания работает 10 лет , автомобили проходят своевременное ТО. Доступны детские кресла. Бронируйте через сайт аренда авто краснодар

Howdy! This is my 1st comment here so I just wanted to give a quick shout out and tell you I really enjoy reading through your blog posts. Can you recommend any other blogs/websites/forums that deal with the same topics? Thank you so much!

Zain recharge

Thank you for sharing your info. I truly appreciate your efforts and I will be waiting for your next post thank you once again.

prepaid Zain

посредник в Китае В эпоху глобализации и стремительного развития мировой экономики, Китай занимает ключевую позицию в качестве крупнейшего производственного центра. Организация эффективных и надежных поставок товаров из Китая становится стратегически важной задачей для предприятий, стремящихся к оптимизации затрат и расширению ассортимента. Наша компания предлагает комплексные решения для вашего бизнеса, обеспечивая бесперебойные и выгодные поставки товаров напрямую из Китая.

May I just say what a comfort to discover someone who really knows what they are talking about online. You actually know how to bring an issue to light and make it important. More and more people should read this and understand this side of the story. I was surprised that you’re not more popular since you surely possess the gift.

zain kuwait recharge

Шкаф Кухня – сердце дома, место, где рождаются кулинарные шедевры и собирается вся семья. Именно поэтому выбор мебели для кухни – задача ответственная и требующая особого подхода. Мебель на заказ в Краснодаре – это возможность создать уникальное пространство, идеально отвечающее вашим потребностям и предпочтениям.

https://выкуп-авто-пермь.рф/kak-prodat-nasledstvo-avto

Attractive component of content. I just stumbled upon your site and in accession capital to say that I acquire actually loved account your blog posts. Any way I’ll be subscribing for your augment or even I achievement you get entry to consistently quickly.

hafilat recharge

В динамичном мире Санкт-Петербурга, где каждый день кипит жизнь и совершаются тысячи сделок, актуальная и удобная доска объявлений становится незаменимым инструментом как для частных лиц, так и для предпринимателей. Наша платформа – это ваш надежный партнер в поиске и предложении товаров и услуг в Северной столице. Объявления частных лиц

варфейс акк В мире онлайн-шутеров Warface занимает особое место, привлекая миллионы игроков своей динамикой, разнообразием режимов и возможностью совершенствования персонажа. Однако, не каждый готов потратить месяцы на прокачку аккаунта, чтобы получить желаемое оружие и экипировку. В этом случае, покупка аккаунта Warface становится привлекательным решением, открывающим двери к новым возможностям и впечатлениям.

What’s up to every body, it’s my first go to see of this web site; this web site includes awesome and in fact good data designed for readers.

https://mitsubishi-nikol-motors.com.ua/yak-vstanovyty-bi-led-linzy-porady-ta-rekomendatsii-dlya-avtolyubyteliv

роп Роп – Русский роп – это больше, чем просто музыка. Это зеркало современной российской души, отражающее её надежды, страхи и мечты. В 2025 году жанр переживает новый виток развития, впитывая в себя элементы других стилей и направлений, становясь всё более разнообразным и эклектичным. Популярная музыка сейчас – это калейдоскоп звуков и образов. Хиты месяца мгновенно взлетают на вершины чартов, но так же быстро и забываются, уступая место новым музыкальным новинкам. 2025 год дарит нам множество талантливых российских исполнителей, каждый из которых вносит свой неповторимый вклад в развитие жанра.

Поставки товаров из Китая – это сложный и многогранный процесс, который требует глубоких знаний логистики, таможенного законодательства и специфики китайского рынка. Когда речь идет об оптимизации этого процесса, на сцену выходит посредник в Китае. Этот специалист или компания берет на себя роль связующего звена между российским бизнесом и китайскими производителями, упрощая коммуникацию, контроль качества и организацию доставки. Выкуп товара из Китая – ключевой этап в импортных операциях. Особенно популярен выкуп с 1688 – крупнейшей оптовой онлайн-площадки Китая, предлагающей широкий ассортимент товаров по конкурентным ценам. Опт из Китая привлекает предпринимателей, стремящихся к масштабированию бизнеса и снижению закупочной стоимости. Важно понимать, что работа с оптовыми поставщиками требует внимательности и опыта, чтобы избежать недобросовестных поставщиков и получить качественный товар. Среди наиболее востребованных категорий товаров, импортируемых из Китая, выделяются оборудование и одежда. Оборудование из Китая часто отличается оптимальным соотношением цены и качества, что делает его привлекательным для производственных предприятий. Одежда из Китая продолжает оставаться популярной благодаря разнообразию моделей, материалов и ценовых категорий. Успешная организация поставок из Китая требует комплексного подхода, включающего выбор надежного посредника, тщательный отбор поставщиков, контроль качества продукции, оптимизацию логистических маршрутов и грамотное таможенное оформление. Только в этом случае бизнес сможет извлечь максимальную выгоду из сотрудничества с китайскими партнерами и укрепить свои позиции на рынке. выкуп товара из китая

Rainbet code ILBET В динамичном мире онлайн-развлечений Rainbet занимает особое место, предоставляя игрокам широкие возможности для азартных игр и спортивных ставок. Для максимального увеличения выгоды и усиления азарта используйте промокод ILBET при регистрации или внесении депозита. Этот код активирует эксклюзивные бонусы, акции и предложения, разработанные как для новичков, так и для опытных игроков.

красное море температура воды

chicken road 2025 Chicken Road: Взлеты и Падения на Пути к Успеху Chicken Road – это не просто развлечение, это обширный мир возможностей и тактики, где каждое решение может привести к невероятному взлету или полному краху. Игра, доступная как в сети, так и в виде приложения для мобильных устройств (Chicken Road apk), предлагает пользователям проверить свою фортуну и чутье на виртуальной “куриной тропе”. Суть Chicken Road заключается в преодолении сложного маршрута, полного ловушек и опасностей. С каждым успешно пройденным уровнем, награда растет, но и увеличивается шанс неудачи. Игроки могут загрузить Chicken Road game demo, чтобы оценить механику и особенности геймплея, прежде чем рисковать реальными деньгами.

Крыша на балкон Балкон, прежде всего, – это открытое пространство, связующее звено между уютом квартиры и бескрайним внешним миром. Однако его беззащитность перед капризами погоды порой превращает это преимущество в существенный недостаток. Дождь, снег, палящее солнце – все это способно причинить немало хлопот, лишая возможности комфортно проводить время на балконе, а также нанося ущерб отделке и мебели. Именно здесь на помощь приходит крыша на балкон – надежная защита и гарантия комфорта в любое время года.

roobet bonus WEB3 В мире онлайн-казино инновации не стоят на месте, и Roobet находится в авангарде этих перемен. С появлением технологии Web3, Roobet предлагает игрокам новый уровень прозрачности, безопасности и децентрализации. Чтобы воспользоваться всеми преимуществами этой передовой платформы, используйте промокод WEB3.

Бизнес-аналитика Бизнес-стратегия: создайте конкурентное преимущество. В условиях жесткой конкуренции важно иметь четкую и действенную бизнес-стратегию. Профессиональный ментор поможет вам определить уникальные преимущества, сформировать позиционирование, разработать план действий. Вместе вы создадите стратегию, которая выделит ваш бизнес и обеспечит долгосрочный рост. Не позволяйте конкуренции застать вас врасплох — инвестируйте в экспертную поддержку. Создайте рабочую стратегию. Закажите консультацию и начните строить стабильное будущее своей компании уже сегодня.

pinco Pinco, Pinco AZ, Pinco Casino, Pinco Kazino, Pinco Casino AZ, Pinco Casino Azerbaijan, Pinco Azerbaycan, Pinco Gazino Casino, Pinco Pinco Promo Code, Pinco Cazino, Pinco Bet, Pinco Yukl?, Pinco Az?rbaycan, Pinco Casino Giris, Pinco Yukle, Pinco Giris, Pinco APK, Pin Co, Pin Co Casino, Pin-Co Casino. Онлайн-платформа Pinco, включая варианты Pinco AZ, Pinco Casino и Pinco Kazino, предлагает азартные игры в Азербайджане, также известная как Pinco Azerbaycan и Pinco Gazino Casino. Pinco предоставляет промокоды, а также варианты, такие как Pinco Cazino и Pinco Bet. Пользователи могут загрузить приложение Pinco (Pinco Yukl?, Pinco Yukle) для доступа к Pinco Az?rbaycan и Pinco Casino Giris. Pinco Giris доступен через Pinco APK. Pin Co и Pin-Co Casino — это связанные термины.

мод на тик ток 2025 Мир мобильных приложений не стоит на месте, и Тик Ток продолжает оставаться одной из самых популярных платформ для создания и обмена короткими видео. Но что, если стандартной функциональности вам недостаточно? На помощь приходит Тик Ток Мод – модифицированная версия приложения, открывающая доступ к расширенным возможностям и эксклюзивным функциям.

Тик ток мод на андроид Тикток Мод: Откройте Новые Горизонты Видеоконтента на Вашем Android Мир социальных сетей постоянно эволюционирует, и TikTok занимает в нем лидирующие позиции. Но что, если я скажу вам, что можно расширить возможности этой платформы, получив доступ к функциям, недоступным в стандартной версии? Речь идет о ТикТок моде. ТикТок Мод: Что это такое? ТикТок мод – это модифицированная версия популярного приложения, предоставляющая расширенные возможности для пользователей Android. Скачать тик ток мод на андроид – значит открыть дверь в мир, где границы возможностей TikTok размываются.

легальная вебкам работа в Польше Стань вебкам моделью в польской студии, работающей в Варшаве! Открыты вакансии для девушек в Польше, особенно для тех, кто говорит по-русски. Ищешь способ заработать онлайн в Польше? Предлагаем подработку для девушек в Варшаве с возможностью работы в интернете, даже с проживанием. Рассматриваешь удаленную работу в Польше? Узнай, как стать вебкам моделью и сколько можно заработать. Работа для украинок в Варшаве и высокооплачиваемые возможности для девушек в Польше ждут тебя. Мы предлагаем легальную вебкам работу в Польше, онлайн работа без необходимости знания польского языка. Приглашаем девушек без опыта в Варшаве в нашу вебкам студию с обучением. Возможность заработка в интернете без вложений. Работа моделью онлайн в Польше — это шанс для тебя! Ищешь “praca dla dziewczyn online”, “praca webcam Polska”, “praca modelka online” или “zarabianie przez internet dla kobiet”? Наше “agencja webcam Warszawa” и “webcam studio Polska” предлагают “praca dla mlodych kobiet Warszawa” и “legalna praca online Polska”. Смотри “oferty pracy dla Ukrainek w Polsce” и “praca z domu dla dziewczyn”.

дебетовая карта курьером Путеводитель по миру удобных банковских карт. Оформить современную дебетовую карту стало просто и удобно благодаря нашей поддержке. Выберите карту, которая идеально вам подходит, и наслаждайтесь всеми преимуществами современного финансового сервиса. Что мы предлагаем? Практические советы: Полезные лайфхаки и рекомендации для эффективного использования вашей карты. Свежие акции: Будьте в курсе всех актуальных предложений и специальных условий от наших банков-партнеров. Преимущества нашего сообщества. Полная информация о различных видах карт, особенностях тарифов и комиссий. Регулярно обновляемые материалы с актуальными данными и последними новостями о продуктах российских банков. Присоединяйтесь к нашему сообществу, чтобы сделать ваши финансовые решения простыми, быстрыми и безопасными. Вместе мы сможем оптимизировать использование банковских продуктов и сэкономить ваше время и средства. Наша цель — помочь вам эффективно управлять своими финансами и получать максимальную выгоду от каждого взаимодействия с банком.

https://amlkyc.tech/

вакансии для девушек в Польше Стань вебкам моделью в польской студии, работающей в Варшаве! Открыты вакансии для девушек в Польше, особенно для тех, кто говорит по-русски. Ищешь способ заработать онлайн в Польше? Предлагаем подработку для девушек в Варшаве с возможностью работы в интернете, даже с проживанием. Рассматриваешь удаленную работу в Польше? Узнай, как стать вебкам моделью и сколько можно заработать. Работа для украинок в Варшаве и высокооплачиваемые возможности для девушек в Польше ждут тебя. Мы предлагаем легальную вебкам работу в Польше, онлайн работа без необходимости знания польского языка. Приглашаем девушек без опыта в Варшаве в нашу вебкам студию с обучением. Возможность заработка в интернете без вложений. Работа моделью онлайн в Польше — это шанс для тебя! Ищешь “praca dla dziewczyn online”, “praca webcam Polska”, “praca modelka online” или “zarabianie przez internet dla kobiet”? Наше “agencja webcam Warszawa” и “webcam studio Polska” предлагают “praca dla mlodych kobiet Warszawa” и “legalna praca online Polska”. Смотри “oferty pracy dla Ukrainek w Polsce” и “praca z domu dla dziewczyn”.

собрать компьютер онлайн Собрать компьютер онлайн: Удобство и контроль Онлайн сборка компьютера позволяет вам контролировать каждый этап процесса. Вы выбираете компоненты, следите за ценами и создаете машину, которая идеально соответствует вашему бюджету.

Дом на побережье Сочи – это не просто город, это мечта, воплощенная в реальность. Лазурное море, величественные горы, пышная зелень и мягкий климат делают его идеальным местом для жизни, отдыха и инвестиций. Если вы стремитесь к комфорту, красоте и перспективному будущему, то недвижимость в Сочи – это то, что вам нужно.

компьютер для стрима купить

кайтсерфинг

“Новости Новороссийска” – это не просто агрегатор информации, это платформа для диалога между горожанами и властью. Здесь можно задать вопрос чиновнику, оставить жалобу или просто выразить свое мнение по поводу той или иной городской проблемы. Благодаря оперативности и открытости, паблик стал незаменимым инструментом для тех, кто хочет быть в курсе всего, что происходит в Новороссийске. Новости Новороссийска Каждое утро начинается с просмотра ленты новостей, где местные жители делятся фотографиями рассветов над морем, а журналисты рассказывают о планах по развитию городской инфраструктуры. Вечером же паблик превращается в площадку для обсуждения насущных проблем: пробок на дорогах, благоустройства парков и скверов, качества жилищно-коммунальных услуг.

BestGold: Сияние золота и блеск бриллиантов в Краснодаре В сердце Краснодарского края, где солнце ласкает поля и виноградники, расцветает мир изысканных ювелирных украшений BestGold. Мы предлагаем вам уникальную возможность прикоснуться к великолепию золота 70% пробы, воплощенному в утонченных кольцах и серьгах, сверкающих бриллиантами. Кольца, достойные королевы Наши кольца – это не просто украшения, это символ вашей индивидуальности и безупречного вкуса. От классических обручальных колец до экстравагантных коктейльных, каждое изделие BestGold создано с любовью и вниманием к деталям. Вставки из бриллиантов различной огранки и каратности подчеркнут вашу элегантность и добавят образу неповторимый шарм. купить кольцо золото Серьги, подчеркивающие красоту Серьги BestGold – это идеальное дополнение к любому наряду. От лаконичных пусетов до эффектных подвесок, они призваны подчеркнуть вашу женственность и утонченность. Наши серьги с бриллиантами станут ярким акцентом вашего образа, притягивая восхищенные взгляды. Ювелирный фестиваль BestGold: праздник роскоши и стиля Не упустите возможность стать участником ювелирного фестиваля BestGold, где вас ждут эксклюзивные скидки на золото до 70% и невероятные предложения на бриллианты. Это ваш шанс приобрести ювелирные украшения мечты по самым выгодным ценам. BestGold: выбирайте лучшее, выбирайте золото! Погрузитесь в мир роскоши и блеска вместе с BestGold. Наши ювелирные украшения станут вашими верными спутниками, подчеркивая вашу красоту и элегантность в любой ситуации. Купите кольцо или серьги из золота в Краснодаре и ощутите себя королевой!

Аренда авто в Краснодаре Прокат авто Краснодар: Легкость и доступность Прокат авто в Краснодаре стал еще более легким и доступным благодаря онлайн-сервисам и удобным приложениям. Вы можете забронировать автомобиль заранее, выбрать удобное место получения и возврата, а также получить квалифицированную консультацию специалистов.

Wow, superb blog layout! How long have you been blogging for? you make blogging look easy. The overall look of your site is fantastic, as well as the content!

bus card balance check online

кайтсёрфинг анапа Рерайт текста о кайтсерфинге в Анапе (30 вариантов):

May I simply say what a comfort to discover an individual who genuinely understands what they’re talking about online. You definitely know how to bring an issue to light and make it important. A lot more people ought to look at this and understand this side of your story. It’s surprising you are not more popular because you definitely possess the gift.

hafilat bus card balance check

Balloons Dubai https://balloons-dubai1.com stunning balloon decorations for birthdays, weddings, baby showers, and corporate events. Custom designs, same-day delivery, premium quality.

ultimate AI porn maker generator. Create hentai art, porn comics, and NSFW with the best AI porn maker online. Start generating AI porn now!

Профессиональное https://kosmetologicheskoe-oborudovanie-msk.ru для салонов красоты, клиник и частных мастеров. Аппараты для чистки, омоложения, лазерной эпиляции, лифтинга и ухода за кожей.

ultimate createporn AI generator. Create hentai art, porn comics, and NSFW with the best AI porn maker online. Start generating AI porn now!

Защитные кейсы plastcase.ru в Санкт-Петербурге — надежная защита оборудования от влаги, пыли и ударов. Большой выбор размеров и форматов, ударопрочные материалы, индивидуальный подбор.

Защитные кейсы https://plastcase.ru в Санкт-Петербурге — надежная защита оборудования от влаги, пыли и ударов. Большой выбор размеров и форматов, ударопрочные материалы, индивидуальный подбор.

займ по паспорту онлайн https://zajmy-onlajn.ru

займ онлайн без истории быстрые онлайн займы без карты

официальный сайт ПокерОК

официальный сайт ПокерОК

официальный сайт ПокерОК

Официальный сайт онлайн рума ПокерОК

Эта познавательная публикация погружает вас в море интересного контента, который быстро захватит ваше внимание. Мы рассмотрим важные аспекты темы и предоставим вам уникальныеInsights и полезные сведения для дальнейшего изучения.

Ознакомиться с деталями – https://nakroklinikatest.ru/

кейс защитный fs купить http://plastcase.ru

кейс защитный сорокин plastcase

кайт сафари соловейкин Кайт Египет привлекает кайтеров со всего мира своими теплыми водами и благоприятным ветром.

помощь в написании отчета по практике отчет по практике сколько стоит

заказать отчет по практике купить отчет по учебной практике

микрозайм без процентов http://zajmy-onlajn.ru

получить займ онлайн https://zajmy-onlajn.ru

где взять займ без отказа [url=https://www.zajm-bez-otkaza-1.ru]где взять займ без отказа[/url] .

онлайн кредит без отказа бишкек [url=http://kredit-bez-otkaza-1.ru/]онлайн кредит без отказа бишкек[/url] .

I believe everything published made a bunch of sense. However, what about this? suppose you added a little content? I ain’t saying your content is not solid, but suppose you added a post title that makes people desire more? I mean %BLOG_TITLE% is a little vanilla. You could peek at Yahoo’s home page and see how they write article headlines to grab viewers to open the links. You might add a related video or a pic or two to grab readers interested about everything’ve written. Just my opinion, it might bring your blog a little livelier.

cialis 5 mg prezzo

шторы день ночь Рулонные шторы на пластиковых окнах – это современное и функциональное решение, которое идеально подходит для любого интерьера. Шторы Пятигорск

авто в аренду краснодар Аренда авто без залога: Экономьте свои средства и нервы! Наслаждайтесь поездкой без лишних финансовых обязательств.

Натяжные потолки Томилино Цена за метр натяжного потолка зависит от материала, фактуры и производителя. Натяжной потолок в зал

warface аккаунт Приобретение нового оружия в Warface – это отличный способ улучшить свою статистику, разнообразить игровой процесс и стать более эффективным в бою. Варфейс купить пин код

Thank you for the auspicious writeup. It in reality was once a enjoyment account it. Glance complicated to more brought agreeable from you! However, how could we communicate?

quanto dura l’effetto del tadalafil 5 mg?

Перед началом терапии врач собирает анамнез, оценивает состояние органов-мишеней (печень, почки, сердце), проводит лабораторные тесты на уровень электролитов и маркёры цирроза. Результаты обследования играют ключевую роль при выборе схемы инфузий и психотерапевтических методик.

Получить дополнительные сведения – [url=https://lechenie-alkogolizma-tyumen10.ru/]lechenie alkogolizma tjumen'[/url]

Этот информативный материал предлагает содержательную информацию по множеству задач и вопросов. Мы призываем вас исследовать различные идеи и факты, обобщая их для более глубокого понимания. Наша цель — сделать обучение доступным и увлекательным.

Узнать больше – https://vyvod-iz-zapoya-1.ru/

При длительном запое или серьезной алкогольной интоксикации часто нет возможности или желания ехать в стационар. В таких ситуациях оптимальным решением становится вызов нарколога на дом в Сочи. Специалисты клиники «Жизнь без Запоя» круглосуточно приезжают к пациентам, оперативно оказывают медицинскую помощь и проводят профессиональную детоксикацию организма прямо в домашних условиях. Благодаря комфортному лечению на дому пациенты быстрее восстанавливаются, избегают дополнительного стресса и осложнений, связанных с госпитализацией.

Исследовать вопрос подробнее – [url=https://narcolog-na-dom-sochi0.ru/]нарколог на дом клиника сочи[/url]

1000 рублей за регистрацию вывод сразу без вложений в казино отзывы Многие казино, стремясь привлечь новых клиентов, предлагают 1000 рублей за регистрацию с моментальным выводом, не требующим никаких вложений. Это привлекательная возможность для тех, кто хочет испытать свою удачу без риска для собственного бюджета. 1000 рублей за регистрацию в казино без депозита вывод сразу

Как отмечают наркологи нашей клиники, чем раньше пациент получает необходимую помощь, тем меньше риск тяжелых последствий и тем быстрее восстанавливаются функции организма.

Получить дополнительные сведения – [url=https://kapelnica-ot-zapoya-sochi0.ru/]капельница от запоя выезд в сочи[/url]

Во Владимире и области работают десятки клиник, предлагающих помощь зависимым, но не все учреждения соответствуют современным медицинским и психологическим стандартам. Чтобы выбрать действительно эффективное лечение, нужно ориентироваться на проверенные критерии. В этом материале мы рассмотрим, на что стоит обратить внимание при выборе наркологического центра.

Подробнее – [url=https://lechenie-narkomanii-vladimir10.ru/]лечение наркомании нарколог[/url]

Наша наркологическая клиника предоставляет круглосуточную помощь, использует только сертифицированные медикаменты и строго соблюдает полную конфиденциальность лечения.

Детальнее – https://kapelnica-ot-zapoya-sochi0.ru/kapelnicza-ot-zapoya-na-domu-sochi

Для эффективного лечения алкогольной интоксикации и восстановления организма врачи клиники «АлкоДоктор» используют комплекс препаратов, которые индивидуально подбираются с учетом состояния пациента.

Выяснить больше – [url=https://kapelnica-ot-zapoya-sochi0.ru/]капельница от запоя вызов город[/url]

Группа препаратов

Ознакомиться с деталями – https://kapelnica-ot-zapoya-sochi0.ru/kapelnicza-ot-zapoya-na-domu-sochi

Перед началом терапии врач собирает анамнез, оценивает состояние органов-мишеней (печень, почки, сердце), проводит лабораторные тесты на уровень электролитов и маркёры цирроза. Результаты обследования играют ключевую роль при выборе схемы инфузий и психотерапевтических методик.

Детальнее – https://lechenie-alkogolizma-tyumen10.ru/klinika-lecheniya-alkogolizma-tyumen

В клинике «Горизонт Жизни» в Красногорске разработаны протоколы экстренного вывода из запоя, которые выполняются 24 часа в сутки, семь дней в неделю. Благодаря выезду бригады врачей-наркологов и оснащённости современным оборудованием мы оказываем помощь в кратчайшие сроки, обеспечивая максимальную безопасность и комфорт пациенту.

Узнать больше – https://vyvod-iz-zapoya-krasnogorsk2.ru/vyvod-iz-zapoya-cena/

Капельница от запоя — это комплексная процедура, направленная на быстрое выведение токсинов, нормализацию обменных процессов и восстановление жизненно важных функций организма. Врачи-наркологи подбирают индивидуальный состав капельницы, исходя из состояния пациента. В стандартный набор препаратов обычно входят:

Исследовать вопрос подробнее – [url=https://kapelnica-ot-zapoya-sochi00.ru/]капельница от запоя на дому краснодарский край[/url]

Для эффективного лечения алкогольной интоксикации и восстановления организма врачи клиники «АлкоДоктор» используют комплекс препаратов, которые индивидуально подбираются с учетом состояния пациента.

Изучить вопрос глубже – [url=https://kapelnica-ot-zapoya-sochi0.ru/]поставить капельницу от запоя в сочи[/url]

Основная проблема запоя заключается в том, что человек постепенно теряет контроль над ситуацией, а его организм подвергается всё более тяжёлой интоксикации. Определить момент, когда требуется немедленное обращение за помощью, несложно, если внимательно следить за состоянием человека.

Подробнее тут – http://vyvod-iz-zapoya-korolev2.ru/vyvod-iz-zapoya-na-domu/https://vyvod-iz-zapoya-korolev2.ru

Наша наркологическая клиника предоставляет круглосуточную помощь, использует только сертифицированные медикаменты и строго соблюдает полную конфиденциальность лечения.

Детальнее – [url=https://kapelnica-ot-zapoya-sochi0.ru/]вызвать капельницу от запоя на дому сочи[/url]

Мы оказываем услуги 24 часа в сутки, 7 дней в неделю, без выходных и праздников. Это позволяет:

Исследовать вопрос подробнее – [url=https://narkologicheskaya-klinika-vladimir10.ru/]бесплатная наркологическая клиника владимир[/url]

В нашей клинике применяются различные техники кодирования, которые подбираются с учётом медицинских показаний, психологического состояния и пожеланий пациента.

Получить дополнительную информацию – http://kodirovanie-ot-alkogolizma-odintsovo2.ru

Наша наркологическая клиника предоставляет круглосуточную помощь, использует только сертифицированные медикаменты и строго соблюдает полную конфиденциальность лечения.

Углубиться в тему – [url=https://kapelnica-ot-zapoya-sochi0.ru/]kapelnicza-ot-zapoya-na-domu sochi[/url]

Наркологическая помощь в «Тюменьбезалко» основана на принципах доказательной медицины и индивидуального подхода. Каждый пациент проходит тщательное обследование и консультацию узких специалистов — кардиолога, гастроэнтеролога, невролога. Такой комплексный анализ позволяет не только вывести организм из интоксикации, но и скорректировать течение сопутствующих заболеваний, что повышает безопасность лечения.

Разобраться лучше – http://lechenie-alkogolizma-tyumen10.ru/klinika-lecheniya-alkogolizma-tyumen/https://lechenie-alkogolizma-tyumen10.ru

Капельница от запоя является неотъемлемой процедурой при острых и хронических отравлениях алкоголем. Она помогает стабилизировать состояние пациента, избежать тяжелых последствий и максимально быстро вернуться к нормальной жизни. Вызов врача для проведения процедуры рекомендуется в следующих ситуациях:

Подробнее тут – [url=https://kapelnica-ot-zapoya-sochi0.ru/]капельница от запоя на дому в сочи[/url]

Школа Саморазвития https://bznaniy.ru онлайн-база знаний для тех, кто хочет понять себя, улучшить мышление, прокачать навыки и выйти на новый уровень жизни.

Для каждого пациента используется индивидуальный монитор жизненно важных функций, передающий данные врачу в клинике через защищённый канал связи. Это обеспечивает безопасность при лечении как лёгких, так и тяжёлых форм интоксикации, снижая вероятность осложнений.

Подробнее можно узнать тут – [url=https://narkologicheskaya-klinika-tyumen10.ru/]наркологическая клиника[/url]

Если состояние пациента не позволяет доставить его в стационар, на дом выезжает врач-нарколог с необходимым оборудованием. Применяются капельницы, дезинтоксикационная терапия, медикаментозная коррекция поведения и поддержка родственников.

Ознакомиться с деталями – [url=https://narkologicheskaya-pomoshh-tula10.ru/]narkologicheskaya pomoshch na domu tula[/url]

На базе частной клиники «Здоровье+» пациентам доступны как экстренные, так и плановые формы наркологической помощи. Все процедуры соответствуют стандартам Минздрава РФ и проводятся с соблюдением конфиденциальности.

Изучить вопрос глубже – [url=https://narkologicheskaya-pomoshh-tula10.ru/]срочная наркологическая помощь[/url]

Наша наркологическая клиника предоставляет круглосуточную помощь, использует только сертифицированные медикаменты и строго соблюдает полную конфиденциальность лечения.

Подробнее можно узнать тут – [url=https://kapelnica-ot-zapoya-sochi0.ru/]posle-kapelniczy-ot-zapoya sochi[/url]

В условиях стационара или на дневном стационаре применяются сбалансированные инфузионные растворы, витамины, антиоксиданты и препараты для поддержки печени. Цель — минимизировать интоксикацию и предотвратить осложнения.

Подробнее тут – [url=https://lechenie-alkogolizma-tyumen10.ru/]лечение алкоголизма в тюмени[/url]

Наркологическая помощь «ТюменьМед» не ограничивается только физической детоксикацией. В состав команды входят психологи и социальные работники, которые проводят мотивационные беседы, обучают навыкам самоконтроля и оказывают помощь в планировании досуга и социальных активностей после детоксикации.

Получить больше информации – http://

Группа препаратов

Подробнее можно узнать тут – [url=https://kapelnica-ot-zapoya-sochi0.ru/]kapelnicza-ot-zapoya-na-domu sochi[/url]

Действие и назначение

Подробнее тут – https://kapelnica-ot-zapoya-sochi0.ru

Действие и назначение

Подробнее – http://kapelnica-ot-zapoya-sochi0.ru/kapelnicza-ot-zapoya-na-domu-sochi/

Алкогольный запой — это острое состояние тяжёлой интоксикации, при котором организм накапливает критические уровни продуктов распада этанола и перестаёт справляться с их нейтрализацией. При этом страдают важнейшие органы и системы: печень, почки, сердце, центральная нервная система. Без квалифицированной медицинской помощи риск развития судорог, алкогольного делирия и полиорганной недостаточности возрастает многократно.

Углубиться в тему – [url=https://vyvod-iz-zapoya-krasnogorsk2.ru/]вывод из запоя на дому[/url]

Для эффективного лечения алкогольной интоксикации и восстановления организма врачи клиники «АлкоДоктор» используют комплекс препаратов, которые индивидуально подбираются с учетом состояния пациента.

Углубиться в тему – http://kapelnica-ot-zapoya-sochi0.ru/

Медикаментозное кодирование проводится с помощью препаратов, блокирующих ферменты, ответственные за расщепление этанола, что вызывает выраженное неприятие алкоголя при попытке его употребления. Препараты вводятся внутримышечно или с помощью подкожных имплантов и действуют в течение нескольких месяцев, обеспечивая длительный эффект.

Узнать больше – https://kodirovanie-ot-alkogolizma-odintsovo2.ru/kodirovanie-ot-alkogolizma-cena/

Индивидуальный план включает детоксикацию, медикаментозную поддержку, психотерапию и реабилитацию. Специалисты учитывают:

Исследовать вопрос подробнее – [url=https://lechenie-alkogolizma-tyumen10.ru/]анонимное лечение алкоголизма тюмень[/url]

бездепозитный бонус игровые автоматы с выводом денег Бездепозитный бонус – это шанс сорвать куш, не вкладывая ни копейки. Он позволяет испытать азарт, риск и радость победы, не испытывая страха потери собственных средств. Это особенно ценно для начинающих игроков, которые еще не готовы рисковать большими суммами. Бездепозитный бонус в казино

Этот информационный материал привлекает внимание множеством интересных деталей и необычных ракурсов. Мы предлагаем уникальные взгляды на привычные вещи и рассматриваем вопросы, которые волнуют общество. Будьте в курсе актуальных тем и расширяйте свои знания!

Выяснить больше – https://www.studioto.com/2022/03/11/dating-professional-review-of-shagle

В этой статье-обзоре мы соберем актуальную информацию и интересные факты, которые освещают важные темы. Читатели смогут ознакомиться с различными мнениями и подходами, что позволит им расширить кругозор и глубже понять обсуждаемые вопросы.

Выяснить больше – https://aata.mx/index.php/2024/02/29/hola-mundo

В этой статье-обзоре мы соберем актуальную информацию и интересные факты, которые освещают важные темы. Читатели смогут ознакомиться с различными мнениями и подходами, что позволит им расширить кругозор и глубже понять обсуждаемые вопросы.

Детальнее – https://www.nickatie.com/2020/12/12/233

Этот обзорный материал предоставляет информационно насыщенные данные, касающиеся актуальных тем. Мы стремимся сделать информацию доступной и структурированной, чтобы читатели могли легко ориентироваться в наших выводах. Познайте новое с нашим обзором!

Получить дополнительную информацию – https://www.edmdjbookings.com/edmdjbookings-com-faceomslag

В этой публикации мы предлагаем подробные объяснения по актуальным вопросам, чтобы помочь читателям глубже понять их. Четкость и структурированность материала сделают его удобным для усвоения и применения в повседневной жизни.

Ознакомиться с деталями – https://mbale.mubs.ac.ug/hello-world

В этой публикации мы сосредоточимся на интересных аспектах одной из самых актуальных тем современности. Совмещая факты и мнения экспертов, мы создадим полное представление о предмете, которое будет полезно как новичкам, так и тем, кто глубоко изучает вопрос.

Узнать больше – https://statuscaptions.com/rap-lyrics-captions.html

Этот интересный отчет представляет собой сборник полезных фактов, касающихся актуальных тем. Мы проанализируем данные, чтобы вы могли сделать обоснованные выводы. Читайте, чтобы узнать больше о последних трендах и значимых событиях!

Исследовать вопрос подробнее – https://meijerexclusiveline.nl/hallo-wereld

В этой статье собраны факты, которые освещают целый ряд важных вопросов. Мы стремимся предложить читателям четкую, достоверную информацию, которая поможет сформировать собственное мнение и лучше понять сложные аспекты рассматриваемой темы.

Получить дополнительную информацию – https://statuscaptions.com/aai-birthday-wishes-in-marathi.html

В этой статье-обзоре мы соберем актуальную информацию и интересные факты, которые освещают важные темы. Читатели смогут ознакомиться с различными мнениями и подходами, что позволит им расширить кругозор и глубже понять обсуждаемые вопросы.

Детальнее – http://www.andyliffner.com/?attachment_id=99

Этот обзорный материал предоставляет информационно насыщенные данные, касающиеся актуальных тем. Мы стремимся сделать информацию доступной и структурированной, чтобы читатели могли легко ориентироваться в наших выводах. Познайте новое с нашим обзором!

Ознакомиться с деталями – https://www.burtontownhall.co.uk/events/strikers-the-vale-rawlings-story

Для пациентов, требующих круглосуточного наблюдения, клиника «Полярис» предлагает стационар VIP-класса. Здесь созданы все условия для быстрого восстановления: удобные палаты, индивидуальное меню, зоны отдыха и консультации профильных специалистов.

Углубиться в тему – https://narkologicheskaya-klinika-arkhangelsk0.ru/platnaya-narkologicheskaya-klinika-arkhangelsk

Процесс терапии в клинике построен по поэтапной схеме, включающей:

Ознакомиться с деталями – [url=https://lechenie-alkogolizma-arkhangelsk0.ru/]наркология лечение алкоголизма[/url]

Алкоголизм — хроническое заболевание, требующее комплексного подхода и круглосуточного контроля. Клиника «УралМед» в Екатеринбурге предлагает полный спектр услуг для пациентов любого уровня зависимости: от экстренной детоксикации до долгосрочной реабилитации. Главные принципы работы — абсолютная анонимность, индивидуальный план лечения и постоянное сопровождение квалифицированной командой специалистов.

Получить дополнительную информацию – http://lechenie-alkogolizma-ekaterinburg0.ru/anonimnoe-lechenie-alkogolizma-v-ekb/

Понимание того, какие учреждения действительно способны помочь, позволяет избежать ошибок и не тратить время на неэффективные попытки лечения. Ключевыми признаками являются наличие медицинской лицензии, опытные специалисты, прозрачные условия и отзывы пациентов.

Получить больше информации – https://narkologicheskaya-pomoshh-arkhangelsk0.ru/anonimnaya-narkologicheskaya-pomoshh-arkhangelsk/

«В первые часы после окончания запоя организм наиболее уязвим, и своевременное вмешательство значительно снижает риски осложнений», — подчёркивает заведующая отделением наркологической реанимации Елена Морозова.

Исследовать вопрос подробнее – [url=https://vyvod-iz-zapoya-krasnogorsk2.ru/]vyvod iz zapoya krasnogorsk[/url]

Алкоголизм — хроническое заболевание, требующее комплексного подхода и круглосуточного контроля. Клиника «УралМед» в Екатеринбурге предлагает полный спектр услуг для пациентов любого уровня зависимости: от экстренной детоксикации до долгосрочной реабилитации. Главные принципы работы — абсолютная анонимность, индивидуальный план лечения и постоянное сопровождение квалифицированной командой специалистов.

Детальнее – [url=https://lechenie-alkogolizma-ekaterinburg0.ru/]лечение алкоголизма на дому[/url]

Чтобы обеспечить безопасное выведение психоактивных веществ и восстановление организма, применяется детоксикация под контролем врача-нарколога и анестезиолога-реаниматолога.

Подробнее можно узнать тут – https://lechenie-narkomanii-arkhangelsk0.ru

После диагностики выявленные нарушения восполняются посредством инфузий с витаминами группы B, C, магнием и элементами.

Углубиться в тему – [url=https://lechenie-alkogolizma-ekaterinburg0.ru/]центр лечения алкоголизма екатеринбург[/url]

В случаях, когда транспортировка в клинику затруднительна или пациент испытывает выраженный стресс, возможно выездное консультирование и начальная детоксикация на дому. Врач прибывает с портативным набором для инфузий, оперативно stabilizирует состояние и даёт рекомендации по дальнейшим действиям.

Подробнее можно узнать тут – [url=https://lechenie-alkogolizma-ekaterinburg0.ru/]принудительное лечение от алкоголизма[/url]

Как подчёркивает специалист ФГБУ «НМИЦ психиатрии и наркологии», «без участия квалифицированной команды невозможно обеспечить комплексный подход к пациенту, особенно если речь идёт о длительном стаже употребления и осложнённой картине заболевания». Отсюда следует — изучение состава персонала должно быть одним из первых шагов.

Получить больше информации – [url=https://lechenie-alkogolizma-murmansk0.ru/]lechenie-alkogolizma-murmansk0.ru/[/url]

Проблемы зависимости требуют оперативного вмешательства. Чем раньше начато лечение, тем выше вероятность полного восстановления. Наркологическая помощь в Архангельске представлена как государственными, так и частными клиниками, каждая из которых предлагает свой уровень сервиса и спектр услуг. Однако для получения эффективной и безопасной помощи важно понимать, какие критерии определяют качество наркологической поддержки.

Подробнее тут – [url=https://narkologicheskaya-pomoshh-arkhangelsk0.ru/]скорая наркологическая помощь архангельск[/url]

Если пациенту требуется постоянный мониторинг или комплексное лечение, мы обеспечиваем круглосуточное пребывание в стационаре. Здесь доступны углублённая диагностика — УЗИ органов брюшной полости, расширенные анализы крови, кардиомониторинг — и коррекция терапии в режиме реального времени. Комфортные палаты, ежедневное наблюдение медсестры и консультации психотерапевта создают условия для быстрого и безопасного выхода из зависимости.

Ознакомиться с деталями – https://narkologicheskaya-pomoshh-ekaterinburg0.ru/vyzvat-narkologicheskuyu-pomoshh-v-ekb

Согласно информации, опубликованной на сайте Минздрава РФ, успешная наркологическая помощь невозможна без своевременной диагностики, комплексного подхода и участия квалифицированных специалистов. Именно такие параметры становятся решающими при выборе учреждения, куда обратится пациент или его родственники.

Ознакомиться с деталями – [url=https://narkologicheskaya-pomoshh-arkhangelsk0.ru/]платная наркологическая помощь архангельск[/url]

В случаях, когда транспортировка в клинику затруднительна или пациент испытывает выраженный стресс, возможно выездное консультирование и начальная детоксикация на дому. Врач прибывает с портативным набором для инфузий, оперативно stabilizирует состояние и даёт рекомендации по дальнейшим действиям.

Ознакомиться с деталями – [url=https://lechenie-alkogolizma-ekaterinburg0.ru/]наркологическое лечение алкоголизма[/url]

Нередко пациенту требуется не только медикаментозная поддержка, но и психологическое сопровождение. Консультации с психотерапевтом позволяют выявить причины зависимости, снизить уровень тревожности и подготовить человека к реабилитации.

Подробнее можно узнать тут – [url=https://narkologicheskaya-pomoshh-arkhangelsk0.ru/]скорая наркологическая помощь архангельск.[/url]

Алкоголизм — хроническое заболевание, требующее комплексного подхода и круглосуточного контроля. Клиника «УралМед» в Екатеринбурге предлагает полный спектр услуг для пациентов любого уровня зависимости: от экстренной детоксикации до долгосрочной реабилитации. Главные принципы работы — абсолютная анонимность, индивидуальный план лечения и постоянное сопровождение квалифицированной командой специалистов.

Получить больше информации – [url=https://lechenie-alkogolizma-ekaterinburg0.ru/]лечение алкоголизма в екатеринбурге[/url]

В случаях, когда транспортировка в клинику затруднительна или пациент испытывает выраженный стресс, возможно выездное консультирование и начальная детоксикация на дому. Врач прибывает с портативным набором для инфузий, оперативно stabilizирует состояние и даёт рекомендации по дальнейшим действиям.

Узнать больше – [url=https://lechenie-alkogolizma-ekaterinburg0.ru/]лечение наркомании и алкоголизма в екатеринбурге[/url]

В случаях, когда транспортировка в клинику затруднительна или пациент испытывает выраженный стресс, возможно выездное консультирование и начальная детоксикация на дому. Врач прибывает с портативным набором для инфузий, оперативно stabilizирует состояние и даёт рекомендации по дальнейшим действиям.

Детальнее – [url=https://lechenie-alkogolizma-ekaterinburg0.ru/]клиника лечения алкоголизма екатеринбург.[/url]

Нередко пациенту требуется не только медикаментозная поддержка, но и психологическое сопровождение. Консультации с психотерапевтом позволяют выявить причины зависимости, снизить уровень тревожности и подготовить человека к реабилитации.

Ознакомиться с деталями – [url=https://narkologicheskaya-pomoshh-arkhangelsk0.ru/]скорая наркологическая помощь в архангельске[/url]

В программе используются когнитивно-поведенческая терапия, мотивационное интервьюирование, арт- и телесно-ориентированные практики. Занятия помогают пациенту осознать причины употребления, выработать навыки управления эмоциями и стрессом, сформировать устойчивую внутреннюю мотивацию к отказу от вещества.

Исследовать вопрос подробнее – https://lechenie-narkomanii-arkhangelsk0.ru/lechenie-narkomanii-anonimno-arkhangels

Борьба с наркотической зависимостью требует системного подхода и участия опытных специалистов. Важно понимать, что лечение наркомании — это не только снятие ломки, но и длительная психотерапия, обучение новым моделям поведения, работа с семьёй. Согласно рекомендациям Минздрава РФ, наиболее стабильные результаты достигаются при прохождении курса реабилитации под наблюдением профессиональной команды в специализированном центре.

Изучить вопрос глубже – http://

Наркологическая клиника «Ренессанс» в Екатеринбурге предоставляет полный спектр услуг по лечению зависимости от психоактивных веществ. В основе её работы лежит интеграция современных медицинских технологий, психологических методов и социальной реабилитации. Комплексный подход позволяет не только купировать острые симптомы интоксикации, но и формировать у пациента устойчивую мотивацию к трезвому образу жизни. Высокая квалификация врачей-наркологов, психотерапевтов и социальных педагогов гарантирует индивидуальный маршрут выздоровления для каждого обратившегося.

Детальнее – [url=https://lechenie-narkomanii-ekaterinburg0.ru/]лечение наркомании и алкоголизма свердловская область[/url]

Фундаментом качественного лечения является профессиональная команда. Только при участии врачей-наркологов, психиатров, клинических психологов, терапевтов и консультантов по зависимому поведению можно говорить о комплексной помощи. По словам специалистов ФГБУН «Национальный научный центр наркологии», именно междисциплинарный подход формирует устойчивую динамику на всех этапах терапии — от стабилизации состояния до ресоциализации пациента.

Изучить вопрос глубже – http://narkologicheskaya-klinika-tula10.ru/anonimnaya-narkologicheskaya-klinika-tula/

What a stuff of un-ambiguity and preserveness of precious experience about unexpected emotions.

tadalafil sandoz 5 mg

Выезд на дом подходит тем, кто не нуждается в круглосуточном наблюдении, но требует срочной детоксикации. Бригада врачей приезжает в течение 60 минут, проводит экспресс-диагностику (АД, пульс, сатурация и неврологический статус) и устанавливает внутривенную капельницу с индивидуально подобранным составом растворов. Уже через 1–2 часа пациенты отмечают существенное облегчение.

Детальнее – [url=https://vyvod-iz-zapoya-krasnogorsk2.ru/]vyvod iz zapoya anonimno[/url]

Нередко пациенту требуется не только медикаментозная поддержка, но и психологическое сопровождение. Консультации с психотерапевтом позволяют выявить причины зависимости, снизить уровень тревожности и подготовить человека к реабилитации.

Получить больше информации – https://narkologicheskaya-pomoshh-arkhangelsk0.ru/neotlozhnaya-narkologicheskaya-pomoshh-arkhangelsk/

Чтобы обеспечить безопасное выведение психоактивных веществ и восстановление организма, применяется детоксикация под контролем врача-нарколога и анестезиолога-реаниматолога.

Получить дополнительную информацию – [url=https://lechenie-narkomanii-arkhangelsk0.ru/]центр лечения наркомании архангельск.[/url]

Понимание того, какие учреждения действительно способны помочь, позволяет избежать ошибок и не тратить время на неэффективные попытки лечения. Ключевыми признаками являются наличие медицинской лицензии, опытные специалисты, прозрачные условия и отзывы пациентов.

Ознакомиться с деталями – [url=https://narkologicheskaya-pomoshh-arkhangelsk0.ru/]скорая наркологическая помощь[/url]

Запой — тяжёлое состояние алкогольной зависимости, при котором организм постоянно подвергается токсическому воздействию алкоголя. Это не просто неприятное явление, а угрожающее жизни состояние, которое требует немедленного медицинского вмешательства. Наркологическая клиника «Воздух Свободы» в Люберцах предлагает профессиональный и эффективный вывод из запоя с индивидуальным подходом и максимальным уровнем конфиденциальности.

Получить больше информации – [url=https://vyvod-iz-zapoya-lyubertsy2.ru/]vyvod iz zapoya kruglosutochno[/url]

Современные клиники предоставляют широкий спектр услуг, начиная с первичной консультации и заканчивая долгосрочной поддержкой после прохождения курса лечения. Ключевым этапом является детоксикация — процедура, направленная на выведение токсинов и стабилизацию физического состояния пациента.

Подробнее – http://narkologicheskaya-pomoshh-arkhangelsk0.ru

Чтобы обеспечить безопасное выведение психоактивных веществ и восстановление организма, применяется детоксикация под контролем врача-нарколога и анестезиолога-реаниматолога.

Исследовать вопрос подробнее – [url=https://lechenie-narkomanii-arkhangelsk0.ru/]центр лечения наркомании в архангельске[/url]

После диагностики выявленные нарушения восполняются посредством инфузий с витаминами группы B, C, магнием и элементами.

Получить дополнительные сведения – [url=https://lechenie-alkogolizma-ekaterinburg0.ru/]lechenie-alkogolizma-ekaterinburg0.ru/[/url]

После диагностики выявленные нарушения восполняются посредством инфузий с витаминами группы B, C, магнием и элементами.

Углубиться в тему – [url=https://lechenie-alkogolizma-ekaterinburg0.ru/]лечение наркомании и алкоголизма[/url]

В случаях, когда транспортировка в клинику затруднительна или пациент испытывает выраженный стресс, возможно выездное консультирование и начальная детоксикация на дому. Врач прибывает с портативным набором для инфузий, оперативно stabilizирует состояние и даёт рекомендации по дальнейшим действиям.

Ознакомиться с деталями – https://lechenie-alkogolizma-ekaterinburg0.ru/

Кодирование создаёт стойкое отвращение к этилированному спирту за счёт фармакологического или психотерапевтического воздействия, а дальнейшая работа с психологом помогает сформировать новую модель поведения и мотивацию к сохранению трезвости. Современные технологии в сочетании с индивидуальным подходом делают процедуру безопасной и максимально комфортной для пациента.

Ознакомиться с деталями – [url=https://kodirovanie-ot-alkogolizma-odintsovo2.ru/]клиника кодирования от алкоголизма[/url]

shipping from china to dubai China to UAE: Analyzing Trade Dynamics & Economic Partnerships

Клиника «УралМед» работает без выходных и праздников: прием пациентов — круглосуточно. Это позволяет оказывать экстренную помощь при острых состояниях, а также вести наблюдение за динамикой восстановления здоровья в ночные часы.

Ознакомиться с деталями – [url=https://lechenie-alkogolizma-ekaterinburg0.ru/]centr lecheniya alkogolizma ekaterinburg[/url]

Самолечение или игнорирование проблемы часто приводит к серьёзным осложнениям. Только профессиональная помощь гарантирует безопасный выход из алкогольного кризиса и минимизирует негативные последствия для организма.

Получить больше информации – [url=https://vyvod-iz-zapoya-lyubertsy2.ru/]vyvod iz zapoya lyubercy[/url]

Первое, на что стоит обратить внимание — медицинский состав клиники. Опытные врачи-наркологи, психотерапевты, специалисты по аддиктологии и социальные работники составляют основу эффективной терапии. Их взаимодействие позволяет точно определить стадию зависимости, выявить сопутствующие психические или соматические заболевания и выстроить логичную схему лечения.

Ознакомиться с деталями – [url=https://narkologicheskaya-klinika-murmansk0.ru/]наркологическая клиника в мурманске[/url]

пионы москва Доставка пионов в Москве: Изысканное прикосновение к совершенству. Ощутите нежность шелковистых лепестков, представьте тонкий аромат, наполняющий пространство, и осознайте, что роскошь может быть доступной. Мы предлагаем не просто доставку цветов, а создание момента, который запомнится надолго. Наша коллекция включает в себя редкие сорта пионов, отобранные с особой тщательностью, чтобы удовлетворить даже самый изысканный вкус. От классических розовых букетов до смелых композиций с экзотическими оттенками – у нас вы найдете идеальный подарок для любого случая. Мы ценим ваше время, поэтому гарантируем быструю и надежную доставку по Москве.

Если пациенту требуется постоянный мониторинг или комплексное лечение, мы обеспечиваем круглосуточное пребывание в стационаре. Здесь доступны углублённая диагностика — УЗИ органов брюшной полости, расширенные анализы крови, кардиомониторинг — и коррекция терапии в режиме реального времени. Комфортные палаты, ежедневное наблюдение медсестры и консультации психотерапевта создают условия для быстрого и безопасного выхода из зависимости.

Разобраться лучше – https://narkologicheskaya-pomoshh-ekaterinburg0.ru/skoraya-narkologicheskaya-pomoshh-v-ekb

Первичный этап заключается в оценке состояния пациента и быстром подборе схемы инфузионной терапии. Врач фиксирует показания ЭКГ, сатурацию кислорода и биохимический параметр глюкозы в крови. После этого подключается капельница с раствором для выведения продуктов распада алкоголя и одновременной коррекции показателей обмена веществ. Последующие визиты врача позволяют скорректировать терапию и предотвратить развитие побочных реакций.

Подробнее – http://narkologicheskaya-pomoshh-ekaterinburg0.ru

скачать игры без торрента Скачать игры с облака Mail: Играйте где угодно, когда угодно. Облако Mail – это ваша мобильная библиотека игр, всегда под рукой. Загружайте, скачивайте и запускайте игры на любом устройстве, имеющем доступ к интернету. Насладитесь свободой и гибкостью, выбирая из постоянно пополняющегося каталога.

В этом обзорном материале представлены увлекательные детали, которые находят отражение в различных аспектах жизни. Мы исследуем непонятные и интересные моменты, позволяя читателю увидеть картину целиком. Погрузитесь в мир знаний и удивительных открытий!

Ознакомиться с деталями – http://androp-rono.ru/%D1%84%D1%83%D0%BD%D0%BA%D1%86%D0%B8%D0%BE%D0%BD%D0%B0%D0%BB%D1%8C%D0%BD%D0%B0%D1%8F-%D0%B3%D1%80%D0%B0%D0%BC%D0%BE%D1%82%D0%BD%D0%BE%D1%81%D1%82%D1%8C/item/2650-%D0%B0%D0%BD%D0%B4%D1%80%D0%BE%D0%BF%D0%BE%D0%B2%D1%81%D0%BA%D0%B0%D1%8F-%D1%86%D0%B8%D1%84%D1%80%D0%B0?start=210

Этот информационный обзор станет отличным путеводителем по актуальным темам, объединяющим важные факты и мнения экспертов. Мы исследуем ключевые идеи и представляем их в доступной форме для более глубокого понимания. Читайте, чтобы оставаться в курсе событий!

Подробнее можно узнать тут – https://www.knowledgequran.com/our-nearness-to-day-of-judgement

Эта статья сочетает познавательный и занимательный контент, что делает ее идеальной для любителей глубоких исследований. Мы рассмотрим увлекательные аспекты различных тем и предоставим вам новые знания, которые могут оказаться полезными в будущем.

Разобраться лучше – https://www.meincreative.at/example-post-3

Эта информационная заметка содержит увлекательные сведения, которые могут вас удивить! Мы собрали интересные факты, которые сделают вашу жизнь ярче и полнее. Узнайте нечто новое о привычных аспектах повседневности и откройте для себя удивительный мир информации.

Подробнее – https://diamondrvpark.com/hello-world

В этой информационной статье вы найдете интересное содержание, которое поможет вам расширить свои знания. Мы предлагаем увлекательный подход и уникальные взгляды на обсуждаемые темы, побуждая пользователей к активному мышлению и критическому анализу!

Выяснить больше – https://kendrasmiley.com/cropped-042-jpg/?thc-month=202904

Эта статья сочетает в себе как полезные, так и интересные сведения, которые обогатят ваше понимание насущных тем. Мы предлагаем практические советы и рекомендации, которые легко внедрить в повседневную жизнь. Узнайте, как улучшить свои навыки и обогатить свой опыт с помощью простых, но эффективных решений.

Углубиться в тему – https://gulfcoastpwr.com/2024/04/02/hello-world

В этой публикации мы сосредоточимся на интересных аспектах одной из самых актуальных тем современности. Совмещая факты и мнения экспертов, мы создадим полное представление о предмете, которое будет полезно как новичкам, так и тем, кто глубоко изучает вопрос.

Подробнее – https://avtox.net

В этой статье представлен занимательный и актуальный контент, который заставит вас задуматься. Мы обсуждаем насущные вопросы и проблемы, а также освещаем истории, которые вдохновляют на действия и изменения. Узнайте, что стоит за событиями нашего времени!

Изучить вопрос глубже – https://vickys.com.br/2024/05/19/prefeitura-inicia-projeto-jovem-empreendedor-com-acao-do-cras-vitoria-regia-voltado-a-estudantes-agencia-de-noticias

В этом интересном тексте собраны обширные сведения, которые помогут вам понять различные аспекты обсуждаемой темы. Мы разбираем детали и факты, делая акцент на важности каждого элемента. Не упустите возможность расширить свои знания и взглянуть на мир по-новому!

Получить дополнительную информацию – https://statuscaptions.com/wedding-captions.html

В этом обзорном материале представлены увлекательные детали, которые находят отражение в различных аспектах жизни. Мы исследуем непонятные и интересные моменты, позволяя читателю увидеть картину целиком. Погрузитесь в мир знаний и удивительных открытий!

Изучить вопрос глубже – http://domainedebokassa.com/img_20171017_094630

В этом исследовании рассмотрены методы лечения зависимостей и их эффективность. Мы проанализируем различные подходы, используемые в реабилитационных центрах, и представим данные о результативности программ. Читатели получат надежные и научно обоснованные сведения о данной проблеме.

Подробнее тут – [url=https://narkolog-na-dom-krasnodar15.ru/]врач нарколог на дом[/url]

Этот интересный отчет представляет собой сборник полезных фактов, касающихся актуальных тем. Мы проанализируем данные, чтобы вы могли сделать обоснованные выводы. Читайте, чтобы узнать больше о последних трендах и значимых событиях!

Подробнее можно узнать тут – https://softtech-engr.com/icon-1

В этой информационной статье вы найдете интересное содержание, которое поможет вам расширить свои знания. Мы предлагаем увлекательный подход и уникальные взгляды на обсуждаемые темы, побуждая пользователей к активному мышлению и критическому анализу!

Углубиться в тему – https://statuscaptions.com/corporate-event-planner-in-nyc-can-transform-your-event.html

Эта информационная заметка предлагает лаконичное и четкое освещение актуальных вопросов. Здесь вы найдете ключевые факты и основную информацию по теме, которые помогут вам сформировать собственное мнение и повысить уровень осведомленности.

Подробнее можно узнать тут – https://ap35.de/it/architekturgespraeche-4

В этой публикации мы рассматриваем важную тему борьбы с зависимостями, включая алкогольную и наркотическую зависимости. Мы обсудим методы лечения, реабилитации и поддержку, которые могут помочь людям, столкнувшимся с этой проблемой. Читатели узнают о перспективах выздоровления и важности комплексного подхода.

Выяснить больше – [url=https://narkolog-na-dom-krasnodar16.ru/]vyzvat-narkologa-na-dom[/url]

В этой публикации мы сосредоточимся на интересных аспектах одной из самых актуальных тем современности. Совмещая факты и мнения экспертов, мы создадим полное представление о предмете, которое будет полезно как новичкам, так и тем, кто глубоко изучает вопрос.

Разобраться лучше – https://profinderinternational.com/blog/navigating-remote-staff-success-key-metrics-and-strategies-for-law-firms

В этой статье-обзоре мы соберем актуальную информацию и интересные факты, которые освещают важные темы. Читатели смогут ознакомиться с различными мнениями и подходами, что позволит им расширить кругозор и глубже понять обсуждаемые вопросы.

Получить дополнительную информацию – http://kendrasmiley.com/cropped-042-jpg/?thc-month=203610

Наркологическая клиника “Аура Здоровья” — специализированное учреждение, предоставляющее профессиональную помощь людям, страдающим алкогольной и наркотической зависимостью. Мы стремимся помочь пациентам преодолеть зависимости и обрести контроль над своей жизнью, используя современные методики лечения и поддержки.

Подробнее тут – https://медицинский-вывод-из-запоя.рф/vyvod-iz-zapoya-v-kruglosutochno-v-rostove-na-donu.xn--p1ai/

Мы понимаем, что каждая минута имеет решающее значение, поэтому наши специалисты готовы выехать на дом в кратчайшие сроки и провести все необходимые процедуры по детоксикации организма. Наша цель — помочь пациенту вернуться к нормальной жизни без лишних стрессов и рискованных попыток самостоятельного лечения.

Получить дополнительную информацию – [url=https://vyvod-iz-zapoya-krasnodar00.ru/]вывод из запоя на дому[/url]

Наши специалисты всегда относятся к пациентам с уважением и вниманием, создавая атмосферу доверия и поддержки. Они проводят всестороннее обследование, выявляют причины зависимости и разрабатывают индивидуальные стратегии лечения. Профессионализм и компетентность врачей являются основой успешного восстановления наших пациентов.

Получить дополнительную информацию – http://срочно-вывод-из-запоя.рф/vyvod-iz-zapoya-v-kruglosutochno-v-chelyabinske.xn--p1ai/

В клинике «Горизонт Жизни» в Красногорске разработаны протоколы экстренного вывода из запоя, которые выполняются 24 часа в сутки, семь дней в неделю. Благодаря выезду бригады врачей-наркологов и оснащённости современным оборудованием мы оказываем помощь в кратчайшие сроки, обеспечивая максимальную безопасность и комфорт пациенту.

Разобраться лучше – http://vyvod-iz-zapoya-krasnogorsk2.ru/

Выезд врача-нарколога из клиники «ТрезвоПрофи» на дом происходит в любое время суток, включая выходные и праздники. Перед началом детоксикации врач проводит осмотр, измеряет давление, частоту пульса, уровень кислорода в крови и подбирает индивидуальную схему лечения. Сама процедура обычно занимает от 1 до 2 часов и проводится под строгим контролем врача.

Получить дополнительную информацию – [url=https://kapelnica-ot-zapoya-sochi00.ru/]капельница от запоя анонимно в сочи[/url]

Запой — это тяжёлое состояние, характеризующееся длительным употреблением алкоголя, при котором человек не в силах самостоятельно прекратить пить. Алкогольная интоксикация при длительных запоях вызывает нарушения в работе всех органов и систем, приводя к серьёзным последствиям, таким как инфаркты, инсульты, психозы и даже летальный исход. В такой ситуации единственным надёжным решением становится обращение за профессиональной помощью.

Исследовать вопрос подробнее – http://vyvod-iz-zapoya-korolev2.ru/srochnyj-vyvod-iz-zapoya/

Наши специалисты всегда относятся к пациентам с уважением и вниманием, создавая атмосферу доверия и поддержки. Они проводят всестороннее обследование, выявляют причины зависимости и разрабатывают индивидуальные стратегии лечения. Профессионализм и компетентность врачей являются основой успешного восстановления наших пациентов.

Ознакомиться с деталями – http://срочно-вывод-из-запоя.рф/

Команда врачей клиники “Чистый Путь” состоит из квалифицированных специалистов в области наркологии с обширным опытом работы. Каждый врач обладает глубокими знаниями в фармакологии, психофармакологии и психотерапии, регулярно повышает свою квалификацию на профильных конференциях и семинарах, чтобы использовать в своей практике самые современные и эффективные методы лечения.

Разобраться лучше – https://срочно-вывод-из-запоя.рф/vyvod-iz-zapoya-cena-v-chelyabinske.xn--p1ai

После окончания врач дает консультации и рекомендации по восстановлению организма и профилактике повторных запоев.

Разобраться лучше – [url=https://vyvod-iz-zapoya-krasnodar0.ru/]вывод из запоя на дому цена[/url]

Миссия клиники “Чистый Путь” — способствовать выздоровлению и реабилитации людей, оказавшихся в плену зависимости. Мы обеспечиваем комплексный подход, включающий медицинское лечение, психологическую помощь и социальную адаптацию. Наша задача — не только устранить физическую зависимость, но и восстановить психологическое здоровье пациента, чтобы он смог вернуться к полноценной жизни в обществе.

Разобраться лучше – https://срочно-вывод-из-запоя.рф/vyvod-iz-zapoya-v-kruglosutochno-v-chelyabinske.xn--p1ai/

Группа препаратов

Узнать больше – [url=https://kapelnica-ot-zapoya-sochi0.ru/]капельница от запоя выезд сочи[/url]

Чем дольше человек находится в состоянии запоя, тем больше накапливаются токсины в организме, что негативно сказывается на всех системах. Отказ от алкоголя без должного контроля может привести к серьезным последствиям, таким как:

Подробнее тут – [url=https://narcolog-na-dom-krasnodar0.ru/]выезд нарколога на дом краснодар[/url]

Для детоксикации и восстановления организма после запоя используются только сертифицированные лекарственные препараты с доказанной эффективностью и безопасностью:

Ознакомиться с деталями – https://narcolog-na-dom-sochi0.ru/narkolog-na-dom-czena-sochi/

Мы также уделяем большое внимание социальной адаптации. Пациенты учатся восстанавливать навыки общения и обретать уверенность в себе, что помогает в будущем избежать рецидивов и успешно вернуться к полноценной жизни, будь то работа или учеба.

Выяснить больше – http://быстро-вывод-из-запоя.рф/vyvod-iz-zapoya-v-kruglosutochno-v-volgograde.xn--p1ai/

Миссия клиники “Чистый Путь” — способствовать выздоровлению и реабилитации людей, оказавшихся в плену зависимости. Мы обеспечиваем комплексный подход, включающий медицинское лечение, психологическую помощь и социальную адаптацию. Наша задача — не только устранить физическую зависимость, но и восстановить психологическое здоровье пациента, чтобы он смог вернуться к полноценной жизни в обществе.

Детальнее – http://срочно-вывод-из-запоя.рф/vyvod-iz-zapoya-v-stacionare-v-chelyabinske.xn--p1ai/https://срочно-вывод-из-запоя.рф

Мы понимаем, что каждая минута имеет решающее значение, поэтому наши специалисты готовы выехать на дом в кратчайшие сроки и провести все необходимые процедуры по детоксикации организма. Наша цель — помочь пациенту вернуться к нормальной жизни без лишних стрессов и рискованных попыток самостоятельного лечения.

Углубиться в тему – [url=https://vyvod-iz-zapoya-krasnodar00.ru/]вывод из запоя клиника краснодар[/url]

«Кодирование — это не магическое решение, а важный этап в комплексной программе лечения, — поясняет ведущий нарколог клиники «Ясное Будущее» Марина Иванова. — Главное — сочетание фармакологического воздействия и последующей работы с психологом для формирования устойчивой мотивации к трезвости».

Подробнее можно узнать тут – [url=https://kodirovanie-ot-alkogolizma-odintsovo2.ru/]кодирование от алкоголизма гипнозом[/url]

Миссия клиники “Чистый Путь” — способствовать выздоровлению и реабилитации людей, оказавшихся в плену зависимости. Мы обеспечиваем комплексный подход, включающий медицинское лечение, психологическую помощь и социальную адаптацию. Наша задача — не только устранить физическую зависимость, но и восстановить психологическое здоровье пациента, чтобы он смог вернуться к полноценной жизни в обществе.

Ознакомиться с деталями – http://срочно-вывод-из-запоя.рф

Миссия клиники “Чистый Путь” — способствовать выздоровлению и реабилитации людей, оказавшихся в плену зависимости. Мы обеспечиваем комплексный подход, включающий медицинское лечение, психологическую помощь и социальную адаптацию. Наша задача — не только устранить физическую зависимость, но и восстановить психологическое здоровье пациента, чтобы он смог вернуться к полноценной жизни в обществе.

Получить дополнительную информацию – http://срочно-вывод-из-запоя.рф/vyvod-iz-zapoya-v-stacionare-v-chelyabinske.xn--p1ai/https://срочно-вывод-из-запоя.рф

Наркологическая клиника “Чистый Путь” находится по адресу: г. Челябинск, ул. Пушкина, д. 68, корп. 1. Мы работаем ежедневно с 9:00 до 21:00 без выходных. Наши специалисты всегда готовы проконсультировать вас и ответить на все вопросы, касающиеся лечения зависимостей. Мы гарантируем конфиденциальность и индивидуальный подход к каждому пациенту.

Выяснить больше – http://срочно-вывод-из-запоя.рф

Чем дольше человек находится в состоянии запоя, тем больше накапливаются токсины в организме, что негативно сказывается на всех системах. Отказ от алкоголя без должного контроля может привести к серьезным последствиям, таким как:

Углубиться в тему – [url=https://narcolog-na-dom-krasnodar0.ru/]нарколог на дом вывод краснодар[/url]

В этой статье мы подробно рассматриваем проверенные методы борьбы с зависимостями, включая психотерапию, медикаментозное лечение и поддержку со стороны общества. Мы акцентируем внимание на важности комплексного подхода и возможности успешного восстановления для людей, столкнувшихся с этой проблемой.

Получить дополнительные сведения – [url=https://narkolog-na-dom-krasnodar15.ru/]narkolog-na-dom-krasnodar15.ru[/url]

В клинике «Горизонт Жизни» в Красногорске разработаны протоколы экстренного вывода из запоя, которые выполняются 24 часа в сутки, семь дней в неделю. Благодаря выезду бригады врачей-наркологов и оснащённости современным оборудованием мы оказываем помощь в кратчайшие сроки, обеспечивая максимальную безопасность и комфорт пациенту.

Подробнее тут – [url=https://vyvod-iz-zapoya-krasnogorsk2.ru/]narkolog vyvod iz zapoya[/url]

Дополнительно, если у пациента отмечаются психические нарушения — галлюцинации, агрессия или спутанность сознания, это является прямым сигналом к срочному вмешательству. В этом случае своевременное лечение помогает предотвратить риск инсульта, инфаркта или других серьезных заболеваний.

Получить дополнительную информацию – [url=https://vyvod-iz-zapoya-krasnodar00.ru/]наркологический вывод из запоя в краснодаре[/url]

На дом выезжает квалифицированный врач, который проводит процедуру детоксикации в комфортных условиях, позволяя пациенту избежать стресса и огласки. С помощью капельницы и медикаментов нормализуется состояние, восстанавливаются основные функции организма. Процедура длится несколько часов, после чего врач оставляет рекомендации по поддерживающему лечению.

Получить больше информации – [url=https://vyvod-iz-zapoya-lyubertsy2.ru/]vyvod iz zapoya kapelnica[/url]

После поступления вызова клиника «ЗдоровьеНорм» отправляет к пациенту опытного нарколога, который прибывает на дом в течение 30–60 минут. По приезду врач проводит комплексную диагностику, включающую измерение артериального давления, пульса, уровня кислорода в крови и тщательную оценку общего состояния пациента. На основе полученных данных специалист подбирает индивидуальную схему лечения.

Получить дополнительные сведения – [url=https://narcolog-na-dom-krasnodar0.ru/]нарколог на дом вывод из запоя[/url]

Команда врачей клиники “Чистый Путь” состоит из квалифицированных специалистов в области наркологии с обширным опытом работы. Каждый врач обладает глубокими знаниями в фармакологии, психофармакологии и психотерапии, регулярно повышает свою квалификацию на профильных конференциях и семинарах, чтобы использовать в своей практике самые современные и эффективные методы лечения.

Исследовать вопрос подробнее – http://срочно-вывод-из-запоя.рф

После поступления вызова клиника «ЗдоровьеНорм» отправляет к пациенту опытного нарколога, который прибывает на дом в течение 30–60 минут. По приезду врач проводит комплексную диагностику, включающую измерение артериального давления, пульса, уровня кислорода в крови и тщательную оценку общего состояния пациента. На основе полученных данных специалист подбирает индивидуальную схему лечения.

Подробнее можно узнать тут – https://narcolog-na-dom-krasnodar0.ru/narkolog-na-dom-czena-krasnodar/

Домашний формат идеально подходит для тех, кто находится в удовлетворительном состоянии и не требует круглосуточного контроля.

Подробнее можно узнать тут – [url=https://vyvod-iz-zapoya-lyubertsy2.ru/]вывод из запоя[/url]

Медицинская публикация представляет собой свод актуальных исследований, экспертных мнений и новейших достижений в сфере здравоохранения. Здесь вы найдете информацию о новых методах лечения, прорывных технологиях и их практическом применении. Мы стремимся сделать актуальные медицинские исследования доступными и понятными для широкой аудитории.

Ознакомиться с деталями – [url=https://narkolog-na-dom-krasnodar17.ru/]нарколог на дом[/url]

Длительный запой способен нанести непоправимый вред организму, привести к тяжелым нарушениям работы внутренних органов и поставить под угрозу жизнь пациента. В таких случаях необходимо срочное медицинское вмешательство, которое позволяет быстро стабилизировать состояние, вывести токсины и предотвратить развитие опасных осложнений. Клиника «ЗдоровьеНорм» в Краснодаре предлагает профессиональный вывод из запоя на дому, обеспечивая комплексное лечение с максимальной оперативностью и полной конфиденциальностью.

Исследовать вопрос подробнее – [url=https://vyvod-iz-zapoya-krasnodar00.ru/]вывод из запоя недорого краснодар[/url]

В клинике «Воздух Свободы» процедура вывода из запоя в Люберцах начинается с комплексной диагностики. Врач проводит первичный осмотр, измеряет жизненные показатели и подбирает препараты, которые быстро снимают симптомы интоксикации. В зависимости от состояния пациента, лечение может проходить дома или в стационаре клиники.

Выяснить больше – https://vyvod-iz-zapoya-lyubertsy2.ru/vyvod-iz-zapoya-anonimno

Миссия клиники “Чистый Путь” — способствовать выздоровлению и реабилитации людей, оказавшихся в плену зависимости. Мы обеспечиваем комплексный подход, включающий медицинское лечение, психологическую помощь и социальную адаптацию. Наша задача — не только устранить физическую зависимость, но и восстановить психологическое здоровье пациента, чтобы он смог вернуться к полноценной жизни в обществе.

Ознакомиться с деталями – https://срочно-вывод-из-запоя.рф/vyvod-iz-zapoya-cena-v-chelyabinske.xn--p1ai

Команда врачей клиники “Чистый Путь” состоит из квалифицированных специалистов в области наркологии с обширным опытом работы. Каждый врач обладает глубокими знаниями в фармакологии, психофармакологии и психотерапии, регулярно повышает свою квалификацию на профильных конференциях и семинарах, чтобы использовать в своей практике самые современные и эффективные методы лечения.

Углубиться в тему – https://срочно-вывод-из-запоя.рф/vyvod-iz-zapoya-anonimno-v-chelyabinske.xn--p1ai

Наркологическая клиника “Чистый Путь” — это специализированное медицинское учреждение, предоставляющее помощь людям, страдающим от алкогольной и наркотической зависимости. Наша цель — помочь пациентам справиться с зависимостью, вернуться к здоровой и полноценной жизни, используя эффективные методы лечения и всестороннюю поддержку.

Получить больше информации – http://срочно-вывод-из-запоя.рф/vyvod-iz-zapoya-anonimno-v-chelyabinske.xn--p1ai/

Вызов нарколога на дом становится необходимым при любых состояниях, когда отказ от алкоголя сопровождается выраженными симптомами интоксикации и абстиненции. Основные ситуации, в которых срочно требуется профессиональная помощь врача:

Детальнее – [url=https://narcolog-na-dom-sochi0.ru/]нарколог на дом сочи[/url]