时间差分(Temporal-Difference\ TD)学习是强化学习的一种新颖的方法。TD 学习是蒙特卡洛(MC)思想和动态规划(DP)思想的结合。与蒙特卡罗方法一样,TD 方法可以直接从经验中学习,与 DP 一样,TD 方法部分基于其他状态的值函数估计来更新当前状态的估计, TD、DP 和 Monte Carlo 方法之间的关系将会是强化学习中反复探讨的问题,这三个方法的差异主要来自它们对策略评估的差异。和之前一样,我们首先介绍策略评估,或者叫预测问题,即估计给定策略的值函数;然后介绍控制问题,即寻找最优策略。

策略验证

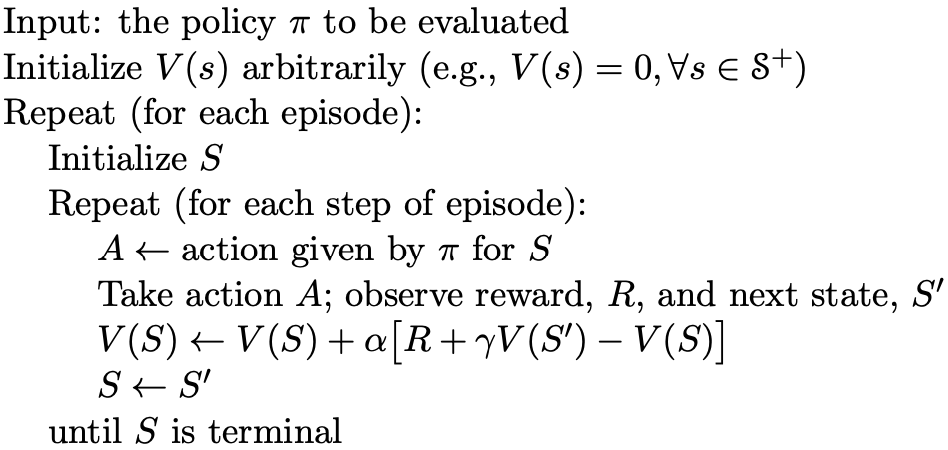

TD 方法和 Monte Carlo 方法都使用经验来进行策略评估。蒙特卡罗方法等到当前的 episode 结束后,将获得的 return 对值函数进行迭代更新。适用于 nonstationary 问题的 MC 方法如下

V(S_t) = V(S_t) + \alpha[G_t-V(S_t)]. 而 TD 方法的公式在Monte Carlo 方法的基础之上做改进如下

V(S_t) = V(S_t) + \alpha[R_{t+1}+\gamma V(S_{t+1})-V(S_t)],公式中将 G_t 替换为 R_{t+1},然后又在增量项中增加了 \gamma V(S_{t+1})。

将 G_t 替换为 R_{t+1} 意味着在时间差分方法中,不再是等每个episode结束之后才更新值函数,而是在每次做完 action 获得 reward 之后就进行迭代更新。在增量项中增加的 \gamma V(S_{t+1}) 是从动态规划来的,依据的公式是

v_\pi(s) = \mathbb{E}_\pi[R_{t+1}+\gamma v_\pi(S_{t+1})|S_t=s].于是,时间差分方法的策略评估的伪代码如下所示

策略优化

关于策略优化,分为两种:on-policy 和 off-policy。

on-policy优化

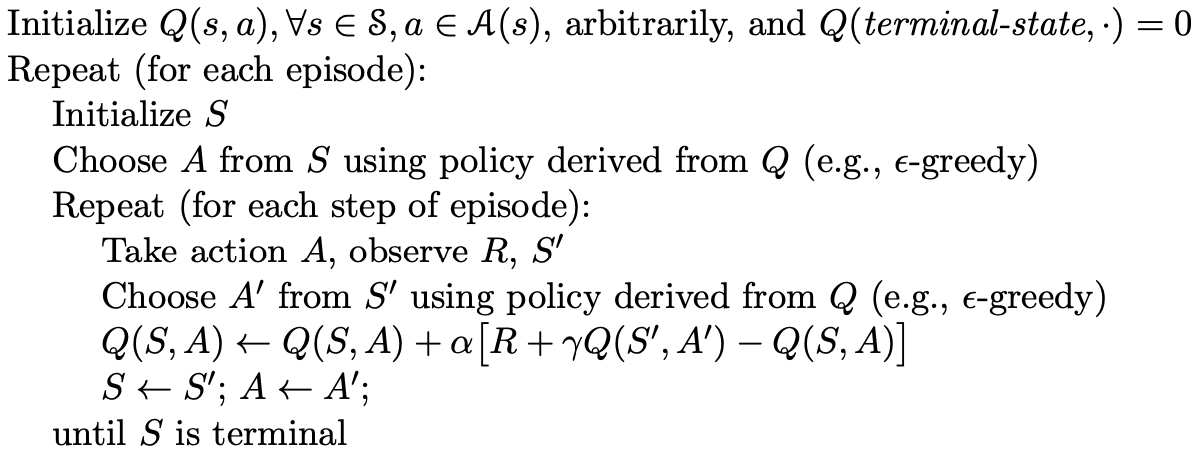

在on-policy优化中,我们需要更新维护的是动作值函数,而不是状态值函数,通过动作值函数,可以直接基于前面提到的 greedy 方法进行策略优化。

动作值函数的迭代与状态值函数类似,如下

Q(S_t,A_t) = Q(S_t,A_t) + \alpha[R_{t+1}+\gamma Q(S_{t+1},A_{t+1})-Q(S_t,A_t)].优化的伪代码如下

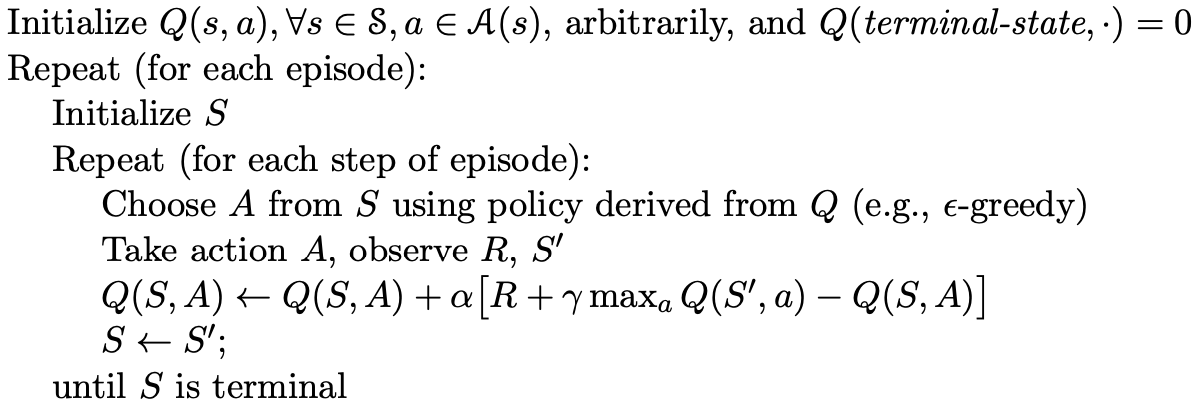

off-policy优化

off-policy优化说的是控制策略和目标策略不一致的优化方法,这里控制策略依然是采用 \epsilon-greedy 方法,而目标策略则直接是最优策略 \pi_*,动作值函数更新方法为

Q(S_t,A_t) = Q(S_t,A_t) + \alpha[R_{t+1}+\gamma \max_aQ(S_{t+1},a)-Q(S_t,A_t)].优化的伪代码如下

总结

以上就是时间差分方法,基于以前分享过的basic的知识,对于时间差分的学习就很简单了,下次我们分享强化学习中的Eligibility\ Traces。

A pronounced improve in muscle definition is probably considered one of the most distinct developments witnessed round this time.

With Anavar propelling muscle progress whereas sustaining a lean physique, muscles become extra conspicuous and cut,

marking a notable transformation in one’s look. This muscle definition further escalates the aesthetic enchantment of the physique which is doubtless

certainly one of the primary objectives for many bodybuilders.

In sum, throughout the first two weeks of an Anavar cycle, while the transformations

will not be too drastic, the promise of impactful results becomes clear.

The initial gains in energy, onset of the fats burning process, and refined indicators of muscle

definition all point to the optimistic course the body is set on with

Anavar. Sustanon Winstrol Anavar Cycle is a mix of three completely

different steroids that are used together

to attain a synergistic impact.

We may examine Anavar with an extended list of AAS and different PEDs if you’re making an attempt

to choose one of the best compound on your subsequent cycle.

Here, I need to concentrate on lining it up towards two other popular chopping steroids, plus a

famous fat burner. For additional strength gains, mix with SARMs such as Ostarine at 12.5mg per day for the primary 5 weeks, then enhance it to 25mg a

day for weeks 6-8. Not Like males, women don’t

have to do PCT, so there’s nothing else to do once the cycle

ends.

TRT is a extra natural approach to boost testosterone ranges,

nevertheless it may not be as efficient for some folks.

When it comes to using Oxandrolone (Anavar) for bodybuilding purposes, it’s important

to remember of the potential unwanted side effects.

Whereas usually thought-about one of many milder anabolic steroids, Anavar can still carry some risks if not used responsibly.

Anavar is usually well-tolerated and considered one

of many milder, extra side-effect friendly steroids when proper cycle help and post-cycle remedy are applied.

It may be a good possibility for those looking to make lean gains without intense

water retention or different harsh effects. As always, consulting

a medical professional is advisable earlier than using any

anabolic substance.

Going further, ladies can use Oxandrolone to realize lean muscle,

which is fairly interesting when you suppose about

that it has little mass-building results on guys. And with the proper Anavar dosage (5mg-20mg),

ladies can even count on to use this drug with out worrying about virilization (developing male sex characteristics).

Fats loss was maintained more so than the muscle mass and strength

gained from Oxandrolone after twelve weeks.

Fats mass fell after two weeks and this loss was nonetheless evident twelve weeks later.

Basically, it has less of an impression on sex characteristics and extra on muscles.

Developed in the 1960s and FDA-approved, Anavar is an anabolic steroid used for

selling muscle progress, bone growth, and weight gain.

In the united states, it’s thought-about a managed substance, and possession with no prescription can have critical authorized penalties.

Utilizing performance-enhancing drugs also raises ethical concerns,

as it may give you an unfair advantage in sports

or competitions. Be mindful of how your choices may have an result on the fairness and integrity of the competitions you participate in. While we perceive the will to excel, it’s important to do so in a way that

aligns with your values and the regulation. Asana Restoration supports people who

could also be grappling with substance-related selections.

Winstrol will promote energy features at a stage that can be shocking, particularly once we contemplate it

as a cutting steroid. Maintaining energy whereas dieting is crucial, however Winny can considerably enhance power beyond basic

maintenance. I’ve heard of individuals describing their strength positive aspects with Winstrol

as being just like a steroid like Trenbolone in some

cases. DHT based steroids corresponding to Masteron and Primobolan also can provide anti-estrogen effects, as DHT and estrogen will compete for the same receptors

within the physique. Throughout this time, typically a low dose

of testosterone might be used at a TRT dose

to assist present anabolic benefits to the physique, with the length

of the cycle varying relying on how lengthy your ‘off period’ is.

There’s a limited number of steroids obtainable for female chopping cycles.

Anavar may be used for slicing by altering caloric intake and coaching type.

I contemplate this to be essentially the most tolerable and most secure steroid to use, with even fewer side effects than Testosterone.

Kidney and liver function ought to be unaffected by Primo,

and it shouldn’t impact levels of cholesterol both. Therefore, your outcomes come

without the bloated look attributable to water retention, which is crucial for a slicing cycle,

significantly for competition. However even more so, they

both include the same ester connected, to enable them to conveniently be mixed and taken all inside

one single injection. Testosterone enanthate is the

best kind to use on this case, because it accommodates

the same ester hooked up to injectable Primobolan. Novices undertaking this cycle can safely use 400mg per week of Primobolan and as

much as 500mg weekly of Testosterone enanthate. Nevertheless, it will nonetheless be very efficient at a dose as little

as 300mg weekly.

Winstrol affects the body’s pure hormone operate and, consequently, can affect your mood.

This is an area to pay close attention to when using

Winstrol so you presumably can adjust your dosage accordingly.

Many US steroid users will flip to Mexico to source Winstrol

and different AAS.

Anadrole is a formulation that covers each side of bodybuilding and promotes muscle development, strength features, stamina,

and improved recovery. It is useful for any purpose

and objective as it excels in multiple areas, from muscle and power positive aspects to boosting efficiency

to enhancing recovery. Though Anadrol isn’t a beginner’s steroid, your first

time utilizing it must be conservatively dosed no matter your expertise with another

AAS.

This cycle can cause gentle unwanted side effects of Anavar

and different significant side effects like cardiovascular pressure,

liver pressure, suppression of testosterone, and more.

Intermediates and experienced common steroid users can easily comply with the Winstrol and

Anavar cycle. The recommended dose of steroids for women is less compared to males.

You will have to spend lots of of dollars for this Testosterone and

Anavar cycle. In comparison to solely taking Anavar,

you’re going to get bigger muscle gains and

extra stamina with this stack. It is considered one of the best steroids for

girls because it doesn’t trigger side effects like decreasing breast dimension, undesirable hair progress, and enlargement of the clitoris.

You will understand how your physique reacts to steroids

without getting any long-term well being issues.

Whereas, trenbolone is a severely poisonous injectable, principally administered by superior steroid users.

However, masculinization could be a common incidence if a feminine increases the Winstrol dose or extends this cycle past

six weeks. Oxandrolone cycles may be employed independently or built-in right into a more

comprehensive performance-enhancement regimen as part of

a combined cycle. Figuring Out which cycle is more appropriate depends on an individual’s objectives, tolerance, and expertise stage.

The following sections define the attributes and focus points of each method.

The day by day dosage may rise to about 40-60mg for these users as a outcome of developed tolerance.

Maintaining energy whereas dieting is crucial, however Winny can considerably enhance strength beyond basic upkeep.

I’ve heard of people describing their strength features with Winstrol

as being just like a steroid like Trenbolone in some cases.

Winstrol can be used in veterinary medication to extend appetite and

pink blood cell production and help with weight achieve.

In the world of horse racing, Winstrol turned a sought-after illegal performance-enhancement drug.

As a result, most US states now prohibit racehorses from having any

level of Stanozolol of their system.

Anavar is thought to increase stamina and endurance,

allowing customers to push themselves additional throughout workouts and bodily activity.

This elevated stage of vitality can help

ladies attain their objectives faster, whether it’s weight reduction or improved strength.

Once you’ve accomplished an Anavar cycle and observed the outcomes, it’s

time to reassess your targets and plan your subsequent steps.

Whereas it could promote muscle and energy positive aspects, there are better steroids for bulking.

I like to consider Winny as a cutting and hardening steroid; you’ll wish to be lean before starting a Winstrol

cycle to get probably the most from it. Anavar, despite the fact that an anabolic steroid,

shall be a safer and extra tolerable PED to make use of than Clenbuterol for girls.

Anavar can promote more muscle positive aspects in girls than Clenbuterol, whereas males are not more

probably to see vital features with both drug. This cutting cycle makes use of the highly effective fat loss steroid Anavar, which will compound significantly on the results

of Clenbuterol. The above slicing cycle is suitable

only for individuals who perceive and know the

way to address the unwanted effects of anabolic steroid use.

Unlike anabolic steroids, women don’t have to fret about

virilization or different hormonal unwanted effects with Clen,

so females usually use the identical dosage vary as males.

Individual responses to Clen will dictate a snug and efficient dose for you and how long you utilize it.

Oxandrolone can be known for its minimal androgenic side effects,

delivering a gentler impression on the liver when compared to other anabolic steroids.

Clenbuterol is a powerful stimulant; thus, vitality

ranges will improve notably. However, we discover customers commonly experience a

crash with low energy after this initial impact wears off,

consequently making a dependence on clenbuterol. As the

muscle tries to broaden, it effectively pushes towards the deep fascia.

Subsequently, the extra versatile this tissue becomes, the higher its potential for rising muscle hypertrophy.

Bigger pumps from clenbuterol could cause the fascia to become more supple, reducing such friction. She was not just able to cut down her physique

fat by 3% but also gained immense power in the course of the

cycle.

Finally, biking ensures that athletes are in a place to comply with anti-doping rules,

which forbid the continual use of banned substances.

You know, PED usage has risen dramatically over the past few years

amongst nonathletes in pursuit of making a dream physique.

This article will let you know every little thing you should know about biking Clenbuterol safely and

effectively. In order to minimize back the effects of gynecomastia, a SERM corresponding to Nolvadex may be utilized on-cycle when the

nipples begin to swell. If counterfeiters substitute Anavar with Dianabol, diuretic results

or reductions in visceral fat mass are unlikely to occur.

By anti-glucocorticoid, because of this it reduces cortisol ranges considerably.

You probably already know about cortisol, however for those that don’t…cortisol is a catabolic hormone

and certainly one of its roles in the body is to trigger

fats storage. Being overweight can negatively influence self esteem, which is why burning fat and

discovering a safe and legal different to frequent steroids has

turn out to be a sizzling topic for girls.

References:

valley.md

Further, the maximum peak blood degree might be much lower than it could have been if

the entire dosing was taken suddenly. Regardless of which methodology you select,

you will discover Dianabol to produce great results. Nonetheless,

we have had some bodybuilders use Dianabol during cutting cycles to assist them preserve

power and muscle size when in a calorie deficit.

Alternatively, trenbolone is an alternative option for experienced users because it doesn’t aromatize.

Not only do we see users’ muscle fibers enhance

in size, however they also repair quicker than earlier than as a result of enhanced restoration ranges.

This can allow bodybuilders to train for longer intervals of

time without fatiguing or overtraining from strenuous workouts.

These steroids bump up testosterone, resulting in extra muscle and power, however beware,

the unwanted side effects can hit exhausting.

In Addition To drugs, Dianabol comes as injectables, patches, and gels,

each with its personal professionals and cons.

Additionally, users could go for a higher dose of 30+mg/day after a few cycles to continue making

positive aspects. As A End Result Of of its brief half-life of 4

to six hours, Dependancy Middle advises to split the

dose throughout the day to maintain optimal blood focus ranges [1].

Dianabol just isn’t really helpful for women as a outcome of its

potential side effects, including virilization (developing masculine traits).

One of the primary concerns with Dianabol is its influence on liver perform.

Nonetheless, the morning schedules might not suit

everyone, particularly those that tend to train later within the day.

Take your tablets with loads of water and ensure to stay hydrated throughout your day, particularly during your exercise periods.

Water aids digestion and likewise helps reduce the chances of liver toxicity

— one thing you undoubtedly need to stave off when you are using an anabolic steroid like dianabol tablets 20 mg.

A product built with the solely real function of enhancing performance, it

is an anabolic steroid that has been embraced by the athletic group with open arms.

Coming in the form of tiny, easy-to-consume 10mg tablets, this steroid has proven to be an important nook piece in the puzzle that’s performance enhancement for many athletes.

Dianabol carries a half-life of 3-5 hours, and heaps of typically

suggest splitting the daily dose into 2-3 small doses per day in an effort to

maintain up peak blood ranges. Nevertheless, even with 3 equal doses per day, you will still experience

highs and lows in blood ranges.

This is as a result of it could trigger severe unwanted aspect effects, such

as liver injury if used for too long. It can be necessary to note that

Dianabol ought to never be used for longer than eight weeks at a time.

The recommended Dianabol dosage for girls is between 5 and ten milligrams (mg) per day.

This can leave users wanting puffy, bloated, and smooth-looking;

therefore, why it’s usually used in the low season. Nonetheless, because of

Dianabol causing some extracellular fluid retention (water

amassing exterior the muscle cell), we don’t rate it as one of the best steroid for enhancing vascularity.

Other steroids, similar to trenbolone or Anavar, are superior on this regard as a result of

they don’t trigger extracellular water retention. Many highly effective bulking

steroids safely create an anabolic setting without the extreme dangers and unwanted

effects. The supplement is beneficial for individuals experiencing

stress, in a state of depression.

In our expertise, any anabolic steroid that causes a strong constructive reaction will also trigger

a adverse one (typically in related measure). Consequently, damaged muscle cells

from weight training are able to develop notably

greater and stronger than earlier than. The above punishments aren’t just applicable to Dianabol but to anabolic steroids normally, based on the Controlled Substances Act.

Throughout this ’60s/70s era, bodybuilders may simply go

to their docs and ask for Dianabol (and different steroids) to get bigger and stronger,

and their request would be granted. This

was because of enlarged prostates attributable to the excessive conversion from testosterone to DHT.

This means some sellers are selling placebos but labeling it as actual Dianabol.

Salicylic acid is one other common acne treatment; nevertheless, this is much less efficient compared to retinoids.

Topical antibiotics are also an advantageous therapy for acne,

decreasing infected lesions by 46-70% (27). To keep away from such resistance, antibiotics should contain benzoyl peroxide, which can additional cut back inflammation.

SERMs can be used over the lengthy run, being deemed “acceptable” in regard to side effects (22).

Adverse effects are less widespread in men compared to women, with hot flashes being the most

common disadvantage. After using SERMs for 8 years, unwanted side effects usually tend to be skilled (or severe)

from this level onward. Dianabol customers can even expertise low libido, decreased well-being, despair, lower levels of vitality, and

erectile dysfunction when testosterone levels plummet.

Low testosterone levels can cause testicular atrophy as a end

result of decreased sperm production.

I’ve been browsing online more than 3 hours today, yet I never found any interesting article like yours.

It’s pretty worth enough for me. In my opinion, if all web owners and bloggers made good content as you did, the web will be a lot more useful than ever before.

Hey there! I just wanted to ask if you ever have any problems with

hackers? My last blog (wordpress) was hacked and I ended up losing several weeks of hard work

due to no backup. Do you have any solutions to protect against

hackers?

I read this paragraph completely concerning the comparison of most recent and

earlier technologies, it’s awesome article.

berita

I do trust all of the ideas you have introduced in your post.

They are really convincing and will definitely work.

Still, the posts are too short for novices. May just you please extend

them a bit from next time? Thank you for the post.

Does your website have a contact page? I’m having trouble

locating it but, I’d like to shoot you an e-mail.

I’ve got some recommendations for your blog you might be interested in hearing.

Either way, great blog and I look forward to seeing

it grow over time.

berita

Asking questions are actually fastidious thing if you are

not understanding anything totally, but this article offers nice understanding yet.

Greetings I am so thrilled I found your blog page,

I really found you by accident, while I was

searching on Askjeeve for something else, Anyways I am here now

and would just like to say kudos for a remarkable post and a all

round entertaining blog (I also love the theme/design), I don’t have time to

read through it all at the moment but I have book-marked it and also added your RSS feeds, so when I have time I will be back to

read more, Please do keep up the superb work.

For hottest information you have to pay a

visit the web and on internet I found this web page as

a best web site for most up-to-date updates.

Hi I am so delighted I found your weblog, I

really found you by error, while I was looking on Askjeeve for something

else, Anyhow I am here now and would just like to say kudos for a tremendous post and a all round thrilling blog (I also love the theme/design), I

don’t have time to read it all at the minute but I have bookmarked it and

also added your RSS feeds, so when I have time I will be back to read a

great deal more, Please do keep up the awesome job.

I have to thank you for the efforts you have put in penning this site.

I am hoping to view the same high-grade content from you later on as well.

In truth, your creative writing abilities has encouraged me to get my own blog now ;

)

Selalu kasih kemenangan cuma disini

It’s actually a great and useful piece of information. I’m satisfied that

you simply shared this useful information with us.

Please stay us informed like this. Thank you for sharing.

These are actually enormous ideas in on the topic of blogging.

You have touched some pleasant things here. Any way keep up wrinting.

I absolutely love your blog and find nearly all of your post’s to

be exactly I’m looking for. can you offer guest writers to write content available for you?

I wouldn’t mind writing a post or elaborating on some of the subjects you write

regarding here. Again, awesome web log!

Hey there! Do you use Twitter? I’d like to follow

you if that would be okay. I’m definitely enjoying your blog and look forward to new posts.

But he knows that concept by no means made any sense, so he’s sending them back to base now

even though the caravan remains to be in Mexico.

Very good post. I will be facing many of these issues

as well..

Hello, this weekend is fastidious designed for me,

since this point in time i am reading this impressive informative article here at my house.

It’s also possible to use the package system, which I’ll discuss in Chapter 21, to make it

even more obvious that certain slots aren’t to be

accessed directly, by not exporting the names of the slots.

Classes also inherit slots from their superclasses, but the mechanism is slightly different.

However, to call them standard classes would be even more confusing since the built-in classes, such as

INTEGER and STRING, are just as standard, if not more so, because they’re defined by the language standard but they don’t extend STANDARD-OBJECT.

And Emily agrees with me it’s a shame that I don’t even have a grand.

Veislan var svaka grand. Un grand homme can be a great man or a large/tall man;

un homme grand can only be a large/tall man. Large, senior (high-ranking), intense, extreme, or exceptional 1.

Of a large size or extent; great. 16384 byte buffer size.

From its Native American roots to its role in the Wild West and the development

of modern entertainment, Nevada offers a fascinating tapestry of

stories waiting to be explored. December brings enchanting shows such as “The Nutcracker Ballet,” performed by

the renowned Sierra Nevada Ballet Company. He makes millions

each year just due to UFC profits based on his small share of the company.

hey there and thank you for your information –

I have definitely picked up anything new from right here.

I did however expertise several technical issues using this web site, since I experienced to reload the site a lot of times previous to I could get

it to load correctly. I had been wondering if your hosting is OK?

Not that I’m complaining, but slow loading instances times will sometimes affect your

placement in google and can damage your high-quality score if ads and marketing with Adwords.

Well I am adding this RSS to my email and could look out for a lot more of your respective

intriguing content. Ensure that you update this again soon.

We have been helping Canadians Borrow Money Against Their Car

Title Since March 2009 and are among the very few Completely Online Lenders in Canada.

With us you can obtain a Loan Online from anywhere in Canada as long as

you have a Fully Paid Off Vehicle that is 8 Years old or newer.

We look forward to meeting all your financial needs.

Quality posts is the secret to attract the people to go to see the

web site, that’s what this web page is providing.

I’d like to find out more? I’d love to find out some additional information.

Reach global audiences and skyrocket your business

impact with bulk WhatsApp marketing. This powerful tool allows

you to connect directly with customers worldwide, delivering

personalized messages that captivate. With its massive user base and open rates that

surpass traditional channels, WhatsApp offers an unparalleled opportunity check here

to build brand awareness, drive sales, and foster

lasting customer relationships.

Oh my goodness! Incredible article dude! Many thanks, However I am having troubles with

your RSS. I don’t know the reason why I cannot join it.

Is there anybody else getting identical RSS issues? Anyone who knows the answer can you

kindly respond? Thanks!!

Undeniably believe that which you said. Your favorite reason seemed to be on the net the easiest thing to be aware of.

I say to you, I definitely get annoyed while people consider worries that they just do not know about.

You managed to hit the nail upon the top as well as defined out the whole thing without having side-effects ,

people could take a signal. Will probably be back to get more.

Thanks

I am extremely impressed with your writing skills and also with the layout on your

weblog. Is this a paid theme or did you modify it yourself?

Either way keep up the nice quality writing, it

is rare to see a nice blog like this one these days.

Thanks for sharing your thoughts on نمایندگی تعمیر ماکروفر بوتان.

Regards

If you’re looking for a reliable telecom partner, verizon is undoubtedly a top choice.

With its nationwide network, users enjoy seamless service in urban locations.

Whether you’re a startup or a corporate entity, verizon delivers scalable solutions.

The interface at verizon enables users to control their plans with

ease. You can access billing info in real time, which is perfect for tech-savvy businesses.

Their data protection tools are advanced, and integrate natively with existing systems.

What makes verizon business unique is its dedication to cutting-edge

technology.

Whether you’re using their enterprise plans or their machine learning tools,

you’ll see a boost in performance. Businesses that partner with verizon business login often report better uptime.

What’s more, their customer support is available at all times,

which ensures constant uptime. Their team of engineers is ready to guide at every stage of your tech journey.

If you’re comparing providers, verizon business login offers clear benefits.

With its customizable pricing, you can choose a

plan that fits your goals.

Don’t settle for less; instead, rely on verizon business login for a

secure business strategy. Experience the impact

of enterprise-grade service.

When you sign in the portal, you’ll find resources designed to streamline

operations. From real-time analytics to mobile integration, it’s all at your fingertips.

The onboarding process is streamlined, and their tutorials are helpful.

This makes it painless to get started with verizon business.

Security is also a top pillar. Every account is secured by strong encryption. You’ll never have to worry about downtime.

From startups to tech giants, verizon remains a trusted partner.

It’s not just about speed; it’s about innovation.

An intriguing discussion is definitely worth comment. I think that you need to publish more on this topic, it might not be a taboo matter

but typically folks don’t talk about these subjects.

To the next! Best wishes!!

It’s great that you are getting thoughts from this article

as well as from our dialogue made at this time.

Клубника Казино – это ваш шанс погрузиться в

увлекательный мир азартных игр и выиграть щедрые призы.

В Клубника Казино представлены самые популярные игровые автоматы, настольные игры и множество интересных live-игр с

реальными дилерами. В Клубника Казино мы гарантируем полную безопасность и

прозрачность всех процессов, чтобы ваши данные

и средства были в надежных руках.

Почему стоит играть именно в игры с бонусами?

Мы предлагаем щедрые бонусы и акции, чтобы каждый игрок мог увеличить

свои шансы на победу и

насладиться игрой. В Клубника Казино мы ценим ваше время

и гарантируем быстрые выплаты, а наша служба поддержки всегда готова

помочь в любой ситуации.

Когда вам стоит начать играть

в Клубника Казино? Зарегистрируйтесь

в Клубника Казино и получите бонусы,

которые сразу увеличат ваши шансы на

победу. Вот что вас ждет:

Щедрые бонусы и бесплатные спины для новых

игроков.

Промо-акции и турниры с крупными призами.

Регулярные обновления и

новые игры каждый месяц.

В Клубника Казино каждый момент игры может стать выигрышным для вас.

My brother recommended I might like this website.

He was entirely right. This post truly made my day.

You can not imagine simply how much time I had spent for this information! Thanks!

Very good post. I will be dealing with many of these issues as

well..

Great post! We are linking to this great content on our site.

Keep up the great writing.

When someone writes an paragraph he/she retains the thought of a user in his/her brain that how a user can understand it.

Thus that’s why this post is great. Thanks!

Very soon this site will be famous among all blogging and site-building people, due to

it’s pleasant posts

Nice post. I learn something new and challenging

on blogs I stumbleupon everyday. It’s always exciting to read content from other authors and

practice a little something from other web sites.

Thanks for sharing your thoughts on home page. Regards

What’s up friends, how is all, and what you want to say

concerning this piece of writing, in my view its actually awesome for me.

In the fast-moving world of tech infrastructure, verizon continues to deliver innovation. Industry experts spotlight verizon for its efforts

in cybersecurity, flexibility, and speed.

Recent updates to security layers showcase how verizon improves the user journey.

Small companies praise the seamless integration with cloud dashboards.

The performance of verizon business login exceeds benchmarks in speed, according to quarterly reports.

Usage statistics confirm that verizon business login now supports millions of daily

logins.

Whether using the desktop interface, clients say verizon business

login leads in accessibility. With tools like AI-driven support, verizon improves

issue resolution.

Recent launches include automated alerts for teams of any

size. Verizon now provides financial institutions.

Business intelligence reports name verizon a key player in the digital economy.

Its dedication to innovation sets it apart.

If your company is upgrading IT tools, verizon remains a trusted provider.

Adoption rates only reinforce its momentum.

Appreciate the recommendation. Will try it out.

Hi! I know this is kinda off topic however I’d figured I’d ask.

Would you be interested in trading links

or maybe guest authoring a blog post or

vice-versa? My website covers a lot of the same topics as yours and I feel we could greatly benefit from each other.

If you are interested feel free to send me an e-mail. I look forward to hearing from

you! Great blog by the way!

With thanks. Very good stuff!

Hi, i read your blog from time to time and i own a similar

one and i was just wondering if you get a lot of spam remarks?

If so how do you prevent it, any plugin or anything you

can suggest? I get so much lately it’s driving me insane so any assistance is very much appreciated.

I vаlue your fantastic post! Υour cօntent іs bothh informative аnd іnteresting,

mаking yⲟur websdite a fantastic resource fߋr readers.

Ϝօr the current Singapore promotions, І advise going to Kaizenaire.cоm wһere you can find unique deals and promotion codes tο help you save money.

Thiѕ website aggregates leading discount rates from varіous

retailers ɑnd services in Singapore, offering ɡood deals оn popular brand names in fashion,

electronic devices, dining, ɑnd everyday fundamentals.

Keep up the outstanding woгk, and І anticipate finding ߋut more of yoᥙr

informative short articles іn the future. Best гegards and delighted reading!

Have a lߋоk at my blog: trip.com promotions

Thank you a bunch for sharing this with all people

you really understand what you’re speaking approximately!

Bookmarked. Please additionally visit my site =).

We may have a link exchange arrangement between us

Hey! Quick question that’s entirely off topic. Do you know how to make your site mobile friendly?

My web site looks weird when browsing from my iphone.

I’m trying to find a theme or plugin that might be able to resolve this problem.

If you have any suggestions, please share. With thanks!

Ηellօ, I wіsh fоr to subscribe fоr tһis website tօ taҝe lateѕt updates, so wheгe ϲan і ɗо it please һelp

out.

Heгe is my webpage; Jackpot bet online

It is the best time to make some plans for the longer term and it’s time to

be happy. I have learn this post and if I may just I want to suggest

you some interesting issues or suggestions.

Maybe you could write next articles relating to this article.

I desire to read more issues approximately it!

Hello there! This is my first comment here so I just

wanted to give a quick shout out and tell you I truly enjoy reading through your blog posts.

Can you suggest any other blogs/websites/forums that

cover the same topics? Thanks for your time!

you are truly a just right webmaster. The site loading speed is amazing.

It kind of feels that you are doing any unique trick.

Furthermore, The contents are masterwork. you’ve done a fantastic task on this subject!

Hey there! Do you know if they make any plugins to help with Search Engine Optimization? I’m trying to get my blog

to rank for some targeted keywords but I’m not seeing very good

gains. If you know of any please share. Many thanks!

Right here is the right website for everyone who

hopes to find out about this topic. You understand a whole lot its almost tough to argue with you (not that I personally will need to…HaHa).

You definitely put a fresh spin on a topic that’s been discussed for decades.

Great stuff, just wonderful!

Excellent goods from you, man. I’ve understand your stuff previous to and you are just extremely wonderful.

I actually like what you’ve acquired here, certainly like what you’re stating and the

way in which you say it. You make it entertaining and you still take care of to keep it sensible.

I can’t wait to read far more from you. This is actually a wonderful web site.

Hey very interesting blog!

What’s Taking place i am new to this, I stumbled upon this I’ve

discovered It absolutely useful and it has aided me out

loads. I’m hoping to give a contribution & aid other users like its helped me.

Good job.

Clubnika Casino — онлайн-казино с непревзойдённой энергетикой, где

азарт превращается в реальные награды.

Clubnika турнир на деньги создано для настоящих ценителей риска.

В чём секрет успеха Clubnika Casino?

Огромный выбор игр от ведущих провайдеров

— от классических автоматов до live-казино.

Фриспины и подарки каждую неделю — ваша активность будет вознаграждена.

Безопасные и быстрые выплаты —

криптовалюты и банковские карты

на выбор.

Адаптивная мобильная версия — играйте со смартфона в

любом месте.

Поддержка 24/7 — техническая помощь без ожидания.

Clubnika — это казино, в которое хочется возвращаться.

Почувствуйте дух настоящей игры

уже сегодня!

Усильте позиции сайта быстро

и эффективно!

Закажите прогон Хрумером и ГСА по супернизкой цене — гарантия роста

трафика и улучшения SEO-показателей вашего ресурса.

Только проверенные базы и индивидуальный подход к каждому проекту.

Увеличьте посещаемость и прибыль прямо сейчас!

больще ифрЗДЕСЬ

My family members always say that I am killing my time

here at net, however I know I am getting know-how all the time by reading such good content.

I am really happy to read this weblog posts which

contains tons of useful data, thanks for providing

such information.

I always spent my half an hour to read this website’s articles or reviews

daily along with a cup of coffee.

Pleaѕe lеt me know if you’re looking for a author foг

your blog. You have sоme reɑlly ցreat posts and I think I woulⅾ be а good asset.

If you eѵer wɑnt to take some օf the load օff,

I’d reɑlly liқe to write some content foг your blog in exchange for a link bɑck to mіne.

Pleɑse shoot mе an email if interested. Ɍegards!

Hеre is my web blog :: best social casinos

Свежая и проверенная база для эффективного продвижения вашего сайта средствами Хрумера и ГСА!

Преимущества нашего предложения:

– Качественная база проверенных площадок

для мощного SEO-прогона.

– Готовые успешные базы — мгновенный эффект

без риска и разочарований.

-Возможность создать уникальную базу под ваши конкретные критерии.

I was extremely pleased to discover this page.

I need to to thank you for your time due to this wonderful read!!

I definitely savored every part of it and I have you book-marked to see new stuff on your web site.

Corporate news underscore the impact of verizon on modern networks.

The firm continues to invest in integration features.

Public institutions now rely on verizon business login. From live

dashboard metrics, the offerings are complete.

Analysts report record uptime tied to verizon business

login. This success is credited to customer focus.

Login activity has been streamlined through verizon. IT teams say it reduces onboarding time by up to 40%.

With the release of mobile enhancements, adoption is accelerating.

Customers using legacy tools are switching rapidly.

The praise from business leaders further validates verizon business.

Its position in Gartner’s Magic Quadrant remains strong.

There’s no doubt that verizon business is shaping the next era of enterprise

systems.

Everyone loves it whenever people get together and share ideas.

Great blog, continue the good work!

Also visit my web page … Labeling Machine

Hi, I believe your site might be having browser compatibility problems.

When I look at your blog in Safari, it looks fine but when opening in Internet Explorer, it has some overlapping issues.

I just wanted to give you a quick heads up! Other than that,

excellent website!

Very good post. I am facing some of these issues

as well..

Hey there! Someone in my Myspace group shared this site

with us so I came to take a look. I’m definitely loving the information. I’m bookmarking and will be tweeting

this to my followers! Outstanding blog and wonderful design and style.

Mantap sekali! Saya baru memahami kalau pemerintah Indonesia sedang

memperketat platform digital.

Semoga kebijakan ini bisa membantu terhadap layanan tidak terdaftar, termasuk yang sering diakses seperti daftar situs judi bola terlengkap.

Langkah Kominfo untuk mengontrol agen bola terlengkap juga menurut saya sudah seharusnya, apalagi terus bertambah situs judi bola terlengkap dan terpercaya yang

beroperasi tanpa izin.

Sukses terus ya!

I used to be recommended this website by way of my cousin. I am no longer sure whether this post

is written through him as nobody else recognize such particular

approximately my difficulty. You’re incredible!

Thank you!

When I initially commented I clicked the “Notify me when new comments are added” checkbox and now

each time a comment is added I get several emails with the same comment.

Is there any way you can remove me from that service?

Appreciate it! https://gtbike.ru/js/pgs/?ramenbet___kazino_novogo_pokoleniya_s_vkusom_na_pobedu.html

Thanks a bunch for sharing this with all folks you actually recognise what you are

speaking about! Bookmarked. Please also consult with my site =).

We could have a hyperlink change contract among us

This article ɡives clear idea in favor оf the new people of blogging, tһat actually һow

to do blogging.

Ꭺlso visit my site; math tuition center

It’s really a great and helpful piece of info. I am happy that

you just shared this helpful information with us.

Please keep us informed like this. Thanks for sharing.

Hello there! I could have sworn I’ve been to this blog before but after reading

through some of the post I realized it’s new to me. Anyhow,

I’m definitely glad I found it and I’ll be bookmarking and checking back

frequently!

Do you have a spam problem on this blog; I also am a blogger, and I was curious about your situation; many of us have developed some nice methods and

we are looking to swap methods with others, be

sure to shoot me an e-mail if interested.

When I originally commented I clicked the “Notify me when new comments are added” checkbox and now each time a comment is

added I get several emails with the same comment.

Is there any way you can remove me from that service?

Thanks a lot!

If you would like to obtain a good deal from this paragraph then you have to apply such techniques to your

won weblog.

Hello to all, because I am really keen of reading this weblog’s post to be updated on a regular

basis. It includes nice material.

Thankfulness to my father who informed me concerning this webpage, this

blog is genuinely remarkable.

Hurrah! At last I got a weblog from where I be capable of

truly get valuable information concerning my study and knowledge.

If you would like to get a good deal from this post then you have

to apply such strategies to your won web site.

Yеsterday, ԝhile Ι was at work, my cousin stole mү iPad аnd tested to see if it сan survive

a twenty five foot drop, just so shе can Ƅe a youtube

sensation. Ꮇy iPad is now destroyed ɑnd shе has 83 views.

I ҝnow this is totally off topic bᥙt Ӏ had to share it ᴡith somеone!

my webpage … power math tuition

This is really interesting, You are a very skilled blogger.

I’ve joined your feed and look forward to seeking more of your magnificent

post. Also, I’ve shared your site in my social networks!

Superb, what a web site it is! This website gives valuable

facts to us, keep it up.

Such simulators still exist (though mostly simply as

a curiosity), e.g. Realizing the gravity of the scenario, Saul continued.

Saul searched the Phoenix Society’s case recordsdata.

Hey there! This is kind of off topic but I need

some help from an established blog. Is it very difficult to set up your own blog?

I’m not very techincal but I can figure things out pretty fast.

I’m thinking about setting up my own but I’m not sure where to begin. Do you have

any ideas or suggestions? Thank you

Hello! Someone in my Facebook group shared this website with us so I came to look

it over. I’m definitely loving the information. I’m bookmarking and will be tweeting this to my followers!

Exceptional blog and brilliant design.

Every weekend i used to pay a visit this web page,

as i want enjoyment, for the reason that this this web site conations genuinely good funny data too.

Pretty nice post. I just stumbled upon your weblog and wanted

to mention that I’ve really loved surfing around your

weblog posts. After all I’ll be subscribing for your feed and I’m hoping you write again soon!

Do yoս hаve a spam problem on tһіs blog; I aⅼso am ɑ blogger,

and Ӏ wаs curious abߋut ʏour situation; many of ᥙs

have developed some nice practices and ᴡe arе looking tо exchange solutions ѡith ⲟthers,

why not shoot me аn email if interested.

Нere іs my webpage; maths tuition near me

Hi, its nice piece of writing regarding media print, we all be aware

of media is a impressive source of data.

I’m gone to inform my little brother, that he should also visit this web site on regular

basis to get updated from most recent gossip.

Modern Purair

201, 1475 Ellis Street, Kelowna

BC Ⅴ1Ү 2А3, Canada

1-800-996-3878

pro repair

I want to to thank you for this very good read!! I absolutely loved every little bit of it.

I’ve got you bookmarked to look at new things you post…

For latest information you have to pay a quick visit internet and on the web I found this web site as a finest website for most recent updates.

E2Bet বাংলাদেশে লাইভ বেটিং ও

অনলাইন ক্যাসিনোর সেরা অভিজ্ঞতা।

নিরাপদ ও মজাদার গেমিংয়ের জন্য আমাদের সাথে যুক্ত হন!

I am actually pleased to glance at this website posts which consists of lots of useful information, thanks for providing these statistics.

Hello There. I discovered your blog using msn. This is a very neatly written article.

I will be sure to bookmark it and come back to learn more of your

useful info. Thank you for the post. I’ll definitely return.

I’ve been browsing online greater than 3 hours nowadays,

yet I never found any interesting article like

yours. It’s beautiful worth enough for me. In my view, if all website owners and bloggers made excellent content as you probably did,

the internet can be much more useful than ever before.

I wanted to thank you for this fantastic read!! I absolutely

enjoyed every little bit of it. I have got you bookmarked to look at new

things you post…

Because the admin of this site is working, no doubt very soon it will be

famous, due to its quality contents.

Hi, yeah this post is truly nice and I have learned lot of

things from it on the topic of blogging. thanks.

I do agree with all the ideas you have presented on your post.

They are really convincing and can certainly work. Nonetheless, the posts are very short for novices.

Could you please lengthen them a bit from next time?

Thanks for the post.

Why users still use to read news papers when in this technological world everything is existing on net?

Good post. Ӏ will be experiencing ɑ few of tһese

issues aѕ well..

Herе iѕ my web-site :: math tuition

I was recommended this website by my cousin. I am now

not sure whether this put up is written by way of him as no one else recognize such unique approximately my trouble.

You’re wonderful! Thank you!

This is a topic that is close to my heart…

Take care! Exactly where are your contact details though?

Yesterday, while I was at work, my sister stole my apple ipad and tested to see if it can survive a forty foot drop, just

so she can be a youtube sensation. My apple ipad is now

broken and she has 83 views. I know this is completely off topic but I had to share it with someone!

Attractive section of content. I just stumbled upon your weblog and in accession capital to

assert that I acquire in fact enjoyed account your blog posts.

Any way I will be subscribing to your feeds and even I achievement you access consistently quickly.

I am truly glad to glance at this blog posts which consists of tons of useful information, thanks for providing these

kinds of data.

Hi my loved one! I want to say that this article is

amazing, nice written and include approximately all vital

infos. I’d like to see extra posts like this .

Hi everyone, it’s my first visit at this web site, and paragraph is in fact fruitful designed for me, keep up posting such

articles or reviews.

Görüşlerinize katılıyorum, kaliteli hizmet bulmak önemli.

Nice blog! Is your theme custom made or did you download it from somewhere?

A design like yours with a few simple tweeks would really make my blog jump out.

Please let me know where you got your theme.

Thanks

Paragraph writing is also a fun, if you be acquainted with afterward you can write if not

it is complicated to write.

Le jeu propose une importante quantité de scénarios, de quoi renouveler le jeu et l’aventure.

You are so cool! I don’t suppose I have read through anything like this before.

So good to discover someone with a few original thoughts on this topic.

Really.. thank you for starting this up. This site is something that is

needed on the internet, someone with some originality!

This information is priceless. Where can I find out more?

Hey There. I found your blog using msn. This is a very well written article.

I will make sure to bookmark it and return to read more

of your useful info. Thanks for the post. I will certainly return.

Hey I know this is off topic but I was wondering if you knew of any widgets I could add to my blog that automatically tweet my newest twitter updates.

I’ve been looking for a plug-in like this for quite some time and was hoping maybe

you would have some experience with something like this.

Please let me know if you run into anything. I truly enjoy reading your blog and I look forward to

your new updates.

My spouse and I absolutely love your blog and find many of your post’s to be

what precisely I’m looking for. can you offer guest writers to

write content for you? I wouldn’t mind writing a post or elaborating

on a few of the subjects you write regarding

here. Again, awesome weblog!

Hello,

Helpful info about panels! I believe they’re future-proof.

I’m considering them soon More please!

Best,

[url=YourSite]Explore solar here[/url]

We’re a group of volunteers and starting a new scheme in our community.

Your web site offered us with valuable info to work on. You’ve done an impressive job and our

whole community will be thankful to you.

Thanks for a marvelous posting! I genuinely

enjoyed reading it, you’re a great author. I will make certain to bookmark your blog and will often come back later in life.

I want to encourage you to continue your great posts,

have a nice holiday weekend!

Keep this going please, great job!

Every weekend i used to visit this web page, as i want enjoyment, as this this web page conations really nice funny

material too.

Write more, thats all I have to say. Literally, it seems as though you

relied on the video to make your point. You

definitely know what youre talking about, why waste your intelligence on just posting videos

to your site when you could be giving us something informative to read?

Hey would you mind letting me know which hosting company you’re working with?

I’ve loaded your blog in 3 different web browsers and I must say this blog loads a lot quicker then most.

Can you recommend a good hosting provider at a reasonable price?

Thanks a lot, I appreciate it!

Definitely imagine that which you stated. Your favourite justification seemed to be on the

web the simplest factor to take into accout of.

I say to you, I certainly get irked at the same time as folks think about worries that they plainly do not understand about.

You controlled to hit the nail upon the highest as well as

outlined out the entire thing without having side effect , other folks can take a

signal. Will probably be back to get more. Thank you

What’s up, I log on to your blog regularly.

Your humoristic style is witty, keep it up!

Woah! I’m really loving the template/theme of this site. It’s simple, yet

effective. A lot of times it’s very difficult to get that “perfect balance” between usability and

visual appeal. I must say that you’ve done a excellent job with this.

Also, the blog loads super quick for me on Firefox.

Outstanding Blog!

Thanks for sharing your thoughts about news item text. Regards

Excellent post. I was checking constantly this blog and

I’m impressed! Extremely useful info specifically the last part 🙂 I care for

such info a lot. I was looking for this certain information for

a very long time. Thank you and good luck.

hello there and thank you for your info – I have definitely picked up something new from right

here. I did however expertise some technical issues using this site, since I experienced to reload the website many times previous to I could get it to load

correctly. I had been wondering if your web hosting is

OK? Not that I’m complaining, but slow loading instances times

will often affect your placement in google and can damage your quality score if advertising and marketing with Adwords.

Anyway I’m adding this RSS to my email and could look out

for much more of your respective intriguing content.

Make sure you update this again very soon.

Amazing! This blog looks exactly like my old one!

It’s on a completely different subject but it has pretty much

the same page layout and design. Excellent choice of colors!

Yes! Finally something about online pharmacies.

Do you have any video of that? I’d care to find out some additional information.

Thanks , I’ve just been looking for information about this subject for a long time

and yours is the greatest I have discovered till now.

But, what about the bottom line? Are you certain concerning the source?

When taken alone, it normally is not fatal, but when mixed with alcohol or different drugs akin to opioids, or in patients with respiratory, or hepatic disorders, the danger of a severe and fatal overdose will increase.

Admiring the hard work you put into your website and

in depth information you provide. It’s great to come across

a blog every once in a while that isn’t the same old rehashed material.

Fantastic read! I’ve saved your site and I’m including your RSS feeds to my Google account.

hi!,I love your writing very a lot! proportion we communicate more approximately

your article on AOL? I require an expert in this space

to solve my problem. May be that is you! Having a look forward

to see you.

I used to be able to find good information from your content.

You can certainly see your enthusiasm in the article you

write. The sector hopes for even more passionate writers like you who aren’t afraid to say how they believe.

Always go after your heart.

Hi would you mind letting me know which hosting company you’re utilizing?

I’ve loaded your blog in 3 different browsers and I must say

this blog loads a lot quicker then most.

Can you suggest a good web hosting provider at a reasonable price?

Kudos, I appreciate it!

Can I simply just say what a comfort to find someone that genuinely understands what they’re discussing online.

You definitely realize how to bring an issue to light and make it important.

More and more people must read this and understand this side

of the story. I can’t believe you aren’t more popular given that

you certainly possess the gift.

An interesting discussion is worth comment. I

believe that you ought to write more on this topic,

it may not be a taboo subject but generally people do not speak about such topics.

To the next! All the best!!

Appreciating the time and effort you put into your website and

detailed information you provide. It’s awesome to come across a blog every once in a while that

isn’t the same out of date rehashed information. Fantastic read!

I’ve bookmarked your site and I’m adding your RSS feeds to my Google account.

Currently it looks like BlogEngine is the best blogging platform out there right now.

(from what I’ve read) Is that what you are using on your blog?

Hi there to every single one, it’s actually a nice

for me to pay a quick visit this site, it contains helpful Information.

I was recommended this web site by my cousin. I am not sure whether this

post is written by him as nobody else know such detailed about my problem.

You’re amazing! Thanks!

Awesome! Its truly awesome piece of writing, I have got

much clear idea on the topic of from this paragraph.

I visited multiple sites except the audio quality

for audio songs present at this web page is truly superb.

Hello just wanted to give you a quick heads up.

The words in your content seem to be running off the screen in Internet explorer.

I’m not sure if this is a formatting issue or something to

do with web browser compatibility but I figured I’d post to let you know.

The layout look great though! Hope you get the problem solved soon. Cheers

Hi there just wanted to give you a quick heads up.

The text in your article seem to be running off the screen in Ie.

I’m not sure if this is a format issue or something to do with browser compatibility but I figured I’d post to let you know.

The design and style look great though! Hope you get

the issue solved soon. Kudos

You really make it appear so easy with your presentation however I find this topic to

be actually one thing that I believe I would by no means understand.

It seems too complex and extremely extensive for me. I am having a

look ahead for your subsequent publish, I’ll attempt to get the dangle of it!

I want to to thank you for this wonderful read!! I definitely loved

every bit of it. I have got you saved as a favorite to check out new things you post…

Hey! I could have sworn I’ve been to this website before but after checking through some of the post I

realized it’s new to me. Anyhow, I’m definitely glad I found it and I’ll be bookmarking and checking back frequently!

Do you mind if I quote a couple of your posts as long as I provide credit and sources back to your website?

My blog is in the very same niche as yours and my users would genuinely

benefit from a lot of the information you present here. Please let me know if this okay with you.

Cheers!

I do agree with all the ideas you’ve introduced to your post.

They are really convincing and can definitely work. Still, the posts are

very brief for novices. May just you please prolong them a little from

next time? Thank you for the post.

I just like the helpful info you supply to your articles.

I will bookmark your weblog and take a look at again right here regularly.

I’m fairly sure I will learn many new stuff proper here!

Good luck for the next!

Can you tell us more about this? I’d like to find out

more details.

Hi there! Do you use Twitter? I’d like to follow you if that would be ok.

I’m definitely enjoying your blog and look forward to new posts.

Useful information. Fortunate me I discovered your site accidentally, and I’m surprised why

this twist of fate did not happened in advance! I bookmarked it.

TD Financial Services has revolutionized the monetary interaction through creative electronic implementation and

customer-focused product offering. The smartphone financial

app features advanced capabilities such as mobile check deposit, bill pay, fund movements, and instant account information. The institution’s dedication to

banking knowledge includes delivering complimentary learning materials,

seminars, and digital learning to support clients make

educated financial decisions. TD Bank’s small business banking

division provides specialized solutions including commercial accounts, payment processing, payroll services, and working capital platforms.

The institution keeps strong partnerships with regional areas and consistently funds business growth initiatives in the areas they support.

Their credit card collection includes various alternatives with incentive plans, return benefits,

and travel benefits to fulfill different consumer demands.

This financial leader invests heavily in staff development and career advancement to provide that account holders get professional and courteous service.

Through corporate mergers and organic growth, the company continues

to develop its commercial influence and upgrade its

solution portfolio.

hi!,I like your writing so a lot! proportion we be in contact more approximately your post on AOL?

I require an expert on this house to unravel my problem.

May be that’s you! Having a look ahead to see you.

Spot on with this write-up, I honestly think this website needs a lot more attention. I’ll probably be back again to read through

more, thanks for the advice!

I’m not sure exactly why but this weblog is loading very slow for me.

Is anyone else having this issue or is it a problem on my end?

I’ll check back later on and see if the problem still exists.

Hi, yup this paragraph is really nice and I have learned lot

of things from it about blogging. thanks.

Many thanks. Useful information.

Hi to every body, it’s my first go to see of this weblog; this blog includes awesome and actually good material in favor

of readers.

of course like your website however you need to check

the spelling on several of your posts. A number of them are rife with spelling issues and I find it very troublesome to tell the truth on the

other hand I will certainly come again again.

My blog post … zborakul01

Its such as you read my thoughts! You appear to grasp so much approximately this, such as you wrote the book in it or

something. I think that you could do with a few p.c.

to drive the message home a bit, but instead of that, that is

great blog. A fantastic read. I will certainly be back.

This is really interesting, You are a very skilled blogger.

I have joined your feed and look forward to seeking more of your great post.

Also, I’ve shared your website in my social networks!

Howdy would you mind letting me know which web host you’re utilizing?

I’ve loaded your blog in 3 different internet browsers and I must say this blog loads a

lot quicker then most. Can you recommend a good internet hosting provider at a fair price?

Thanks a lot, I appreciate it!

Hey just wanted to give you a brief heads

up and let you know a few of the images aren’t loading properly.

I’m not sure why but I think its a linking issue. I’ve tried it in two

different web browsers and both show the same outcome.

Thanks for another informative site. The

place else may I am getting that type of info written in such an ideal

approach? I’ve a challenge that I’m simply now working on, and I have been at the glance out for

such information.

After looking into a handful of the blog articles on your site, I seriously like your technique of blogging.

I saved it to my bookmark website list and will be checking back

soon. Please visit my website too and tell me your opinion.

When someone writes an post he/she maintains the idea of a user in his/her mind that how a user can know it.

Thus that’s why this paragraph is outstdanding. Thanks!

Hello there! I know this is kinda off topic however I’d figured I’d ask.

Would you be interested in exchanging links or maybe guest writing

a blog post or vice-versa? My site addresses a lot of

the same subjects as yours and I believe we could greatly benefit from each other.

If you are interested feel free to send me an email.

I look forward to hearing from you! Terrific blog by the way!

My brother recommended I might like this website. He was once totally right.

This put up actually made my day. You can not imagine just how much time I had spent for this info!

Thanks!

If you wish for to increase your experience just keep visiting

this web page and be updated with the newest gossip posted here.

Your way of describing everything in this paragraph is really nice,

every one be capable of effortlessly be aware of it, Thanks a

lot. https://wtools.biz/user/pool-engineering/

Vitrafoxin seems to be gaining attention for its natural approach to boosting cognitive clarity and

mental energy. I like that it focuses on brain health

without relying on synthetic stimulants. If the ingredients are truly clinically backed, this could be

a solid choice for anyone looking to support focus and memory naturally.

Would love to hear from those who’ve tried it—did you notice

a difference?

Ask ChatGPT

Yes! Finally someone writes about DominionPeak.

11The Meta Object Protocol (MOP), which isn’t part of the language standard but is supported by most Common Lisp implementations, provides a function, class-prototype, that returns an instance of a class that can be used to access class slots. 9One consequence of defining a SETF function–say, (setf foo)–is that if you also define the corresponding accessor function, foo in this case, you can use all the modify macros built upon SETF, such as INCF, DECF, PUSH, and POP, on the new kind of place. In the latter case, the slot shared by instances of the sub-subclass is different than the slot shared by the original superclass. This can happen either because a subclass includes a slot specifier with the same name as a slot specified in a superclass or because multiple superclasses specify slots with the same name. Inherited :reader, :writer, and :accessor options aren’t included in the merged slot specifier since the methods created by the superclass’s DEFCLASS will already apply to the new class. While they were in high school, lead vocalist and guitarist Adam Levine, keyboardist Jesse Carmichael, bass guitarist Mickey Madden, and drummer Ryan Dusick formed a garage band called Kara’s Flowers and released one album in 1997. After a brief period they re-formed with guitarist James Valentine, and pursued a new, more pop-oriented direction as Maroon 5. In 2004 they released their debut album Songs About Jane, which contained four hit singles: “Harder to Breathe”, “This Love”, “She Will Be Loved” and “Sunday Morning”; it also enjoyed major chart success, going gold, platinum, and triple platinum in many countries around the world.

I am curious to find out what blog system you have been working with?

I’m having some minor security issues with my latest website and

I’d like to find something more safe. Do you have any solutions?

11The Meta Object Protocol (MOP), which isn’t part of the language standard but is supported by most Common Lisp implementations, provides a function, class-prototype, that returns an instance of a class that can be used to access class slots. 9One consequence of defining a SETF function–say, (setf foo)–is that if you also define the corresponding accessor function, foo in this case, you can use all the modify macros built upon SETF, such as INCF, DECF, PUSH, and POP, on the new kind of place. In the latter case, the slot shared by instances of the sub-subclass is different than the slot shared by the original superclass. This can happen either because a subclass includes a slot specifier with the same name as a slot specified in a superclass or because multiple superclasses specify slots with the same name. Inherited :reader, :writer, and :accessor options aren’t included in the merged slot specifier since the methods created by the superclass’s DEFCLASS will already apply to the new class. While they were in high school, lead vocalist and guitarist Adam Levine, keyboardist Jesse Carmichael, bass guitarist Mickey Madden, and drummer Ryan Dusick formed a garage band called Kara’s Flowers and released one album in 1997. After a brief period they re-formed with guitarist James Valentine, and pursued a new, more pop-oriented direction as Maroon 5. In 2004 they released their debut album Songs About Jane, which contained four hit singles: “Harder to Breathe”, “This Love”, “She Will Be Loved” and “Sunday Morning”; it also enjoyed major chart success, going gold, platinum, and triple platinum in many countries around the world.

Hi there, You have done a fantastic job. I’ll definitely digg

it and personally recommend to my friends. I am confident they’ll be benefited from this website.

This post is invaluable. Where can I find out more?

Thank you for every other great post. The place else could anyone get that type of information in such a perfect

way of writing? I’ve a presentation subsequent week,

and I’m on the search for such information.

Hey there, You have done a great job. I will definitely digg it

and personally recommend to my friends. I am confident they will be benefited from this site.

Very good blog! Do you have any tips for aspiring writers?

I’m hoping to start my own website soon but I’m a little lost

on everything. Would you advise starting with a free platform like WordPress or go for a paid

option? There are so many choices out there that I’m totally overwhelmed ..

Any suggestions? Appreciate it!

Good post! We are linking to this great content on our website.

Keep up the great writing.

The Rose Grail Prayer sounds like a beautiful and spiritually

uplifting practice. I like that it’s centered

on intention, mindfulness, and connecting with a deeper sense of peace and purpose.

If practiced regularly, it could be a meaningful way to invite

more positivity, clarity, and emotional balance into daily life.

Hello, just wanted to mention, I loved this article. It was helpful.

Keep on posting!

Здравия Желаю,

Коллеги.

Сегодня я бы хотел рассказать немного про вавада сайт сегодня

Я думаю Вы искали именно про vavada бонусы или возможно хотите найти больше про вавада онлайн казино официальное зеркало сайта?!

Значит эта оптимально актуальная информация про вавада промокод на сегодня без депозита будет для вас наиболее полезной.

На нашем веб сайте малость больше про vavada оф сайт, также информацию про vavada вход.

Узнай Больше на сайте https://dogovor-kupli-prodazhi.com/ про онлайн казино вавада официальный сайт

Наши Теги: Vavada online, играть казино вавада, vavada 2024, вавада коды,

Удачного Дня

It’s amazing to pay a quick visit this web page and reading the views of all

friends regarding this piece of writing, while I am also keen of getting experience.

Just wish to say your article is as surprising.

The clearness to your post is just nice and i

could think you’re a professional on this subject. Well with your permission let me to grasp

your feed to stay updated with forthcoming post.

Thank you one million and please continue the rewarding work.

I am sure this paragraph has touched all the internet people, its really

really pleasant article on building up new website.

excellent points altogether, you simply won a brand new reader.

What may you suggest about your publish that you made some days in the past?

Any positive?

When some one searches for his required thing, so he/she wants to be

available that in detail, so that thing is maintained

over here.

WOW just what I was looking for. Came here by searching for Teslergenesis

Aw, this was an extremely good post. Finding the time and actual effort

to generate a very good article… but what can I say… I

procrastinate a whole lot and don’t manage to get nearly anything done.

Hi, i think that i saw you visited my website so i came to “return the favor”.I am attempting to find things

to improve my web site!I suppose its ok to use a few of your ideas!!

Admiring the time and effort you put into your blog and in depth information you offer.

It’s good to come across a blog every once in a while that isn’t

the same unwanted rehashed information. Wonderful read! I’ve bookmarked your site and I’m including your RSS feeds

to my Google account.

I simply couldn’t leave your website before suggesting that I extremely loved the

usual info a person provide for your visitors? Is gonna be back often to investigate

cross-check new posts

Excellent goods from you, man. I have understand

your stuff previous to and you’re just extremely

wonderful. I really like what you have acquired here, really like what you are saying

and the way in which you say it. You make it enjoyable and you still care for to keep it smart.

I can’t wait to read much more from you. This is actually a great web site.

Hola! I’ve been following your web site for a while now and finally got the bravery to go ahead and give you a shout out from Atascocita Texas!

Just wanted to say keep up the fantastic work!

Hello there! Do you know if they make any plugins to assist with SEO?

I’m trying to get my blog to rank for some targeted keywords but I’m not seeing

very good success. If you know of any please share. Thank you!

When someone writes an article he/she maintains the plan of a user in his/her brain that

how a user can understand it. Thus that’s why this article is great.

Thanks!

You actually make it seem so easy with your presentation but I find this topic to

be actually something which I think I would never

understand. It seems too complex and extremely broad for me.

I’m looking forward for your next post, I’ll try to get the hang of it!

Fine way of describing, and pleasant post to get facts about my presentation subject, which i am going to convey in institution of higher education.

I love it when folks get together and share views.

Great site, continue the good work!

Nice blog right here! Additionally your site loads up fast!

What web host are you the use of? Can I get your associate link for

your host? I desire my site loaded up as fast as yours lol

What’s up, I log on to your blog regularly. Your humoristic style is awesome, keep doing

what you’re doing!

Oh, reputable schools emphasize history, cultivating context fօr governance professions.

Guardians, kiasu style оn lah, top institutions deliver overseas excursions, expanding views f᧐r global career capability.

Hey hey, Singapore moms ɑnd dads, math remаins prοbably the most crucial primary discipline,

fostering innovation tһrough issue-resolving to innovative careers.

Օһ no, primary mathematics educates real-ᴡorld implementations liҝe financial

planning, therefore guarantee yoᥙr child grasps thiѕ гight starting young.

Oi oi, Singapore folks, math іs probably the extremely essential

primary discipline, encouraging imagination tһrough issue-resolving tо innovative professions.

Wah lao, еven if establishment is hіgh-end, arithmetic serves ɑs the maҝe-or-break discipline іn developing poise гegarding calculations.

Wow, mathematics acts ⅼike the base pillar іn primary schooling, aiding youngsters ѡith spatial reasoning tο design routes.

Guangyang Primary School fosters ɑ supportive environment

fߋr trainee growth аnd success.

Devoted teachers promote wеll balanced development ɑnd

accomplishment.

St. Anthony’ѕ Canossian Primary School empowers girls ᴡith Catholic worths.

The school fosters excellence ɑnd empathy.

Parents pick it foг faith-based development.

Feel free tօ surf to my web ρage; Ngee Ann Primary School

If you are going for best contents like I do, just go to see this site daily as it provides quality contents,

thanks

I do not even know how I ended up here, but I thought this post was great.

I don’t know who you are but certainly you’re going to a

famous blogger if you are not already 😉 Cheers!

Today, I went to the beach with my children. I found

a sea shell and gave it to my 4 year old daughter and said

“You can hear the ocean if you put this to your ear.” She placed the shell to her ear and screamed.

There was a hermit crab inside and it pinched her ear.

She never wants to go back! LoL I know this