DARTS: DIFFERENTIABLE ARCHITECTURE SEARCH

摘要

本文通过以可微分的方式解决架构搜索的可扩展性挑战。 与在离散和不可微搜索空间上应用进化算法或强化学习的传统方法不同,作者的方法是基于架构表示的连续松弛,能够使用梯度下降对架构进行有效搜索。 在 CIFAR-10、ImageNet、Penn Treebank 和 WikiText-2 上进行的大量实验表明,该算法在发现用于图像分类的高性能卷积架构和用于语言建模的循环架构方面表现出色,同时比现有的不可微分方法快几个数量级。下面,简单介绍下Darts对网络架构搜索的建模以及具体的松弛方法。

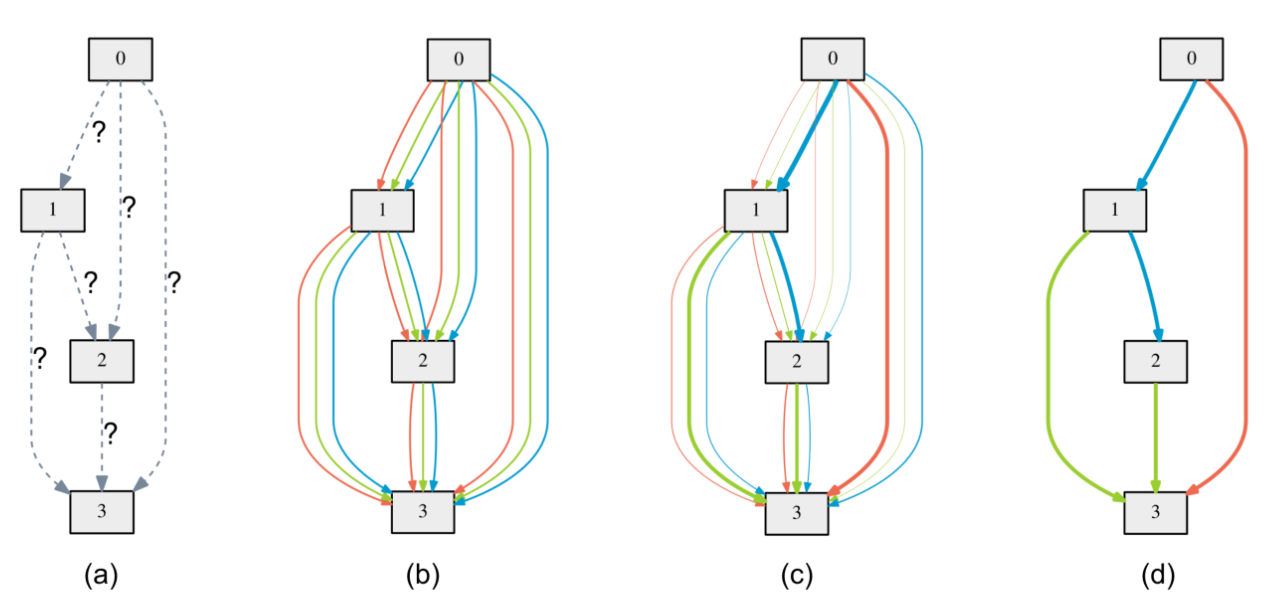

搜索空间

搜索空间被建模成如图所示的超网络。图中的方块表示的是featuremap,有向边表示连接两个featuremap的所有可能操作,且每条边只对应一个操作。(a) 边上的操作最初是未知的。(b) 通过在每条边上放置候选混合操作建立搜索空间。(c) 通过求解双层优化问题联合优化混合概率和网络权重。(d) 从学习到的混合概率中归纳最终架构。注意这里说的混合跟集成学习或者是注意力的意思有点像。也就是在超网络的训练中,两个featuremap之间的所有操作都是要参与到前向传播的,不同操作输出的featuremap被加权求和后作为新的featuremap。

Darts的重点是每个候选操作的权重如何构建,以及如何松弛。

松弛方法

\bar{o}^{(i, j)}(x)=\sum_{o \in \mathcal{O}} \frac{\exp \left(\alpha_o^{(i, j)}\right)}{\sum_{o^{\prime} \in \mathcal{O}} \exp \left(\alpha_{o^{\prime}}^{(i, j)}\right)} o(x) 将上图中的有向边对应到操作的表示符号 o(x),每个操作的权重则是

\frac{\exp \left(\alpha_o^{(i, j)}\right)}{\sum_{o^{\prime} \in \mathcal{O}} \exp \left(\alpha_{o^{\prime}}^{(i, j)}\right)}.其中,\alpha 是可训练的参数。如此,该权重具有以下特点:

- 可微分,权重具有自适应能力。

- 和为1,确保输出的featuremap在正常范围内。

- 权重越大,相应的候选操作在输出的featuremap中的贡献越大。

基于上述特点,在训练完成后,选择权重最大的候选即可。

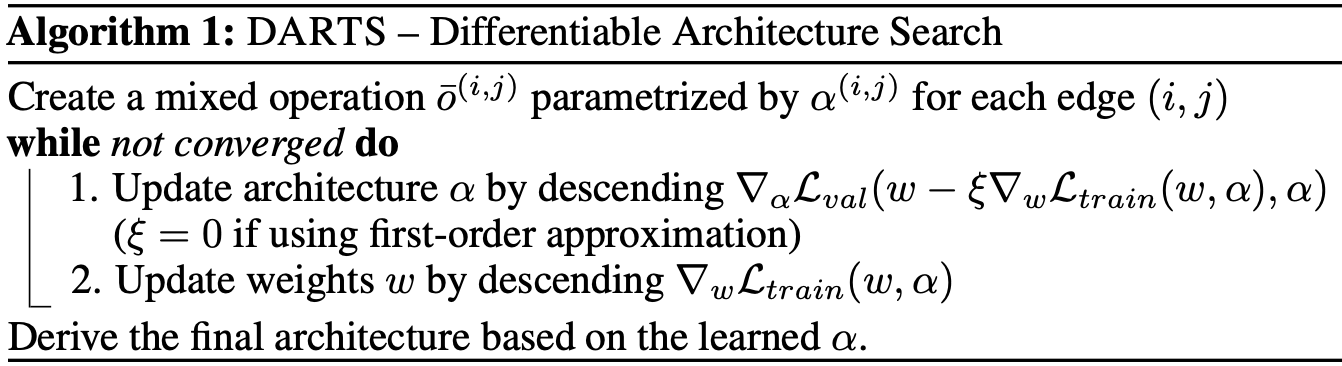

训练算法

在训练的过程中,架构参数与模型参数被视作两组独立的参数交替使用梯度下降进行优化。参数收敛后,根据架构参数的最大值确定每两个featuremap之间的操作,从而生成最终架构。

Incredible insights! Sprunki transforms how we think about musical creativity. Sprunki offers unprecedented creative potential in composition. The way Sprunki empowers creative expression is truly remarkable.

Innovative breakdown! FNAF Games audio design deserves awards – that distant clanging could be Chica or your doom! 2AM pro tip: Headphones on!

I’m really impressed along with your writing skills as smartly as with the structure to your blog. Is this a paid subject or did you modify it your self? Either way keep up the nice quality writing, it’s rare to look a great blog like this one today!

Great breakdown on roulette strategies – it’s fascinating how math shapes outcomes. For those interested in AI-driven productivity, check out the AI Twitter Assistant for smart automation.

SuperPH22 offers a great mix of luck and strategy with its 1024 ways to win. The Jocker Card wilds and free spins really boost the fun. Check out SuperPH for a daily gaming hit!

I love how AI makes Ghibli magic accessible! 지브리 AI lets you turn simple ideas into stunning visuals. It’s like having Hayao Miyazaki in your pocket!

Do you have a spam issue on this blog; I also am a blogger, and I was curious about your situation; we have created some nice methods and we are looking to trade methods with others, be sure to shoot me an e-mail if interested.

George St-Pyer

What’s up i am kavin, its my first time to commenting anyplace, when i read this article i thought i could also make comment due to this good post.

melbet apps

What’s up, the whole thing is going perfectly here and ofcourse every one is sharing data, that’s actually excellent, keep up writing.

hafilat card recharge online

This is the perfect website for anybody who really wants to find out about this topic. You know so much its almost hard to argue with you (not that I actually will need to…HaHa). You certainly put a new spin on a topic that has been discussed for ages. Wonderful stuff, just great!

www zain com kuwait

Do you have a spam issue on this site; I also am a blogger, and I was curious about your situation; we have created some nice procedures and we are looking to swap methods with others, be sure to shoot me an e-mail if interested.

bus travel Abu Dhabi

кайт хургада

Hi there it’s me, I am also visiting this site on a regular basis, this web page is truly good and the users are genuinely sharing good thoughts.

https://hughes-mcgee-4.thoughtlanes.net/henry-uz-com-t-erri-daniel-anri-kh-ak-ik-ii-merosi-zhamlangan-manba

Jili77 stands out with its AI-driven approach, making it a smart pick for serious players. The platform’s variety and security really shine, especially for those diving into slots or live games.

Excellent article. Keep posting such kind of information on your page. Im really impressed by it.

Hi there, You have done an excellent job. I will definitely digg it and personally recommend to my friends. I’m confident they’ll be benefited from this website.

https://www.dermandar.com/user/airbusegg35/

I blog quite often and I genuinely thank you for your information. This great article has truly peaked my interest. I am going to take a note of your site and keep checking for new details about once per week. I opted in for your RSS feed too.

https://ital-parts.com.ua/gde-kupit-nadezhnyy-shoker-dlya-samooborony-luchshie-magaziny-shokeru-com-ua

cialis da 5 mg prezzo : an effective drug containing tadalafil, treats erectile dysfunction and benign prostatic hyperplasia. In Italy, 28 tablets of Cialis 5 mg is priced at approximately €165.26, though prices vary by pharmacy and discounts. Generic alternatives, like Tadalafil DOC Generici, cost €0.8–€2.6 per tablet, offering a budget-friendly option. Always consult a doctor, as a prescription is needed.

Baccarat strategies work best with discipline. I always check out the live dealer games at JLJL PH for a real casino feel-great mix of tech and tradition.

«Рентвил» предлагает аренду автомобилей в Краснодаре без залога и ограничений по пробегу по Краснодарскому краю и Адыгее. Требуется стаж от 3 лет и возраст от 23 лет. Оформление за 5 минут онлайн: нужны только фото паспорта и прав. Подача авто на жд вокзал и аэропорт Краснодар Мин-воды Сочи . Компания работает 10 лет , автомобили проходят своевременное ТО. Доступны детские кресла. Бронируйте через сайт машина в аренду краснодар

What a material of un-ambiguity and preserveness of precious know-how regarding unexpected feelings.

https://ital-parts.com.ua/gde-kupit-nadezhnyy-shoker-dlya-samooborony-luchshie-magaziny-shokeru-com-ua

http://pravo-med.ru/articles/18547/

kitesurfing это

кайт школа хургада

https://oboronspecsplav.ru/

Пассажирские перевозки Караганда – Новосибирск Пассажирские перевозки Новосибирск – Астана Отправляйтесь в комфортное путешествие из Новосибирска в Астану с нашими надежными пассажирскими перевозками. Мы предлагаем регулярные рейсы, обеспечивающие удобство и безопасность в пути. Пассажирские перевозки Астана – Новосибирск Планируете поездку из Астаны в Новосибирск? Наши пассажирские перевозки – это ваш лучший выбор. Наслаждайтесь комфортом и безопасностью в течение всего путешествия. Пассажирские перевозки Новосибирск – Павлодар Совершите увлекательное путешествие из Новосибирска в Павлодар с нашими пассажирскими перевозками. Мы гарантируем приятную поездку и своевременное прибытие. Пассажирские перевозки Павлодар – Новосибирск Наши пассажирские перевозки из Павлодара в Новосибирск – это ваш шанс насладиться комфортным и безопасным путешествием. Доверьте нам свою поездку и оцените высокий уровень сервиса.

Hi friends, its wonderful post on the topic of cultureand fully defined, keep it up all the time.

https://bestpeople.com.ua//krashchi-hermetyky-fary-auto

Пассажирские перевозки Новосибирск – Астана Развитая сеть пассажирских перевозок играет ключевую роль в обеспечении мобильности населения и укреплении экономических связей между регионами. Наша компания специализируется на организации регулярных и безопасных поездок между городами Сибири и Казахстана, предлагая комфортные условия и доступные цены.

Admiring the hard work you put into your blog and in depth information you present. It’s nice to come across a blog every once in a while that isn’t the same outdated rehashed material. Great read! I’ve bookmarked your site and I’m including your RSS feeds to my Google account.

https://forthouse.com.ua/sklo-ta-korpusy-dlya-far-3er-bmw-vse-scho-potribno-znaty

«Рентвил» предлагает аренду автомобилей в Краснодаре без залога и ограничений по пробегу по Краснодарскому краю и Адыгее. Требуется стаж от 3 лет и возраст от 23 лет. Оформление за 5 минут онлайн: нужны только фото паспорта и прав. Подача авто на жд вокзал и аэропорт Краснодар Мин-воды Сочи . Компания работает 10 лет , автомобили проходят своевременное ТО. Доступны детские кресла. Бронируйте через сайт аренда машины в краснодаре

Запчасти для станков Bison Bial Токарные патроны Bison Запчасти для станков Bison Bial В мире металлообработки, где точность и надежность играют ключевую роль, токарные патроны Bison занимают особое место. Эти инструменты, производимые известной польской компанией Bison Bial, зарекомендовали себя как высококачественные и долговечные компоненты для токарных станков. Они обеспечивают надежный зажим заготовок, что напрямую влияет на качество и скорость обработки.

Hi are using WordPress for your site platform? I’m new to the blog world but I’m trying to get started and set up my own. Do you need any coding expertise to make your own blog? Any help would be greatly appreciated!

Myzain

Опт из Китая В эпоху глобализации и стремительного развития мировой экономики, Китай занимает ключевую позицию в качестве крупнейшего производственного центра. Организация эффективных и надежных поставок товаров из Китая становится стратегически важной задачей для предприятий, стремящихся к оптимизации затрат и расширению ассортимента. Наша компания предлагает комплексные решения для вашего бизнеса, обеспечивая бесперебойные и выгодные поставки товаров напрямую из Китая.

Good day! Do you use Twitter? I’d like to follow you if that would be ok. I’m absolutely enjoying your blog and look forward to new updates.

my Zain

Hello! This post could not be written any better! Reading through this post reminds me of my previous room mate! He always kept talking about this. I will forward this post to him. Fairly certain he will have a good read. Thanks for sharing!

my Zain

Nice share!

A unique view on [url=https://winb.lt/vavada-casino-supporting-women-in-stem-through-digital-innovation/]vavada casino[/url] mixed with future-focused design and accessibility.

Мебель для кухни Кухня – сердце дома, место, где рождаются кулинарные шедевры и собирается вся семья. Именно поэтому выбор мебели для кухни – задача ответственная и требующая особого подхода. Мебель на заказ в Краснодаре – это возможность создать уникальное пространство, идеально отвечающее вашим потребностям и предпочтениям.

Understanding gambling psychology is key to responsible play. Platforms like Super PH offer immersive experiences, but balance is essential for long-term enjoyment.

What’s up to every one, the contents existing at this site are in fact awesome for people knowledge, well, keep up the nice work fellows.

hafilat recharge

Hi Dear, are you actually visiting this web site regularly, if so afterward you will without doubt take pleasant experience.

hafilat

В динамичном мире Санкт-Петербурга, где каждый день кипит жизнь и совершаются тысячи сделок, актуальная и удобная доска объявлений становится незаменимым инструментом как для частных лиц, так и для предпринимателей. Наша платформа – это ваш надежный партнер в поиске и предложении товаров и услуг в Северной столице. Подать объявление в СПб

аккаунты варфейс купить В мире онлайн-шутеров Warface занимает особое место, привлекая миллионы игроков своей динамикой, разнообразием режимов и возможностью совершенствования персонажа. Однако, не каждый готов потратить месяцы на прокачку аккаунта, чтобы получить желаемое оружие и экипировку. В этом случае, покупка аккаунта Warface становится привлекательным решением, открывающим двери к новым возможностям и впечатлениям.

Узи беременность В ритме современного мегаполиса, такого как Санкт-Петербург, забота о женском здоровье становится приоритетной задачей. Регулярные консультации с гинекологом, профилактические осмотры и своевременная диагностика – залог долголетия и благополучия каждой женщины.

Heya just wanted to give you a brief heads up and let you know a few of the images aren’t loading properly. I’m not sure why but I think its a linking issue. I’ve tried it in two different web browsers and both show the same results.

hafilat card balance check

Hello there I am so delighted I found your blog page, I really found you by error, while I was searching on Bing for something else, Nonetheless I am here now and would just like to say thanks for a fantastic post and a all round entertaining blog (I also love the theme/design), I don’t have time to browse it all at the moment but I have saved it and also included your RSS feeds, so when I have time I will be back to read much more, Please do keep up the superb work.

hafilat card

Hi there, the whole thing is going well here and ofcourse every one is sharing information, that’s really excellent, keep up writing.

hafilat card

музыкальные новинки Роп – Русский роп – это больше, чем просто музыка. Это зеркало современной российской души, отражающее её надежды, страхи и мечты. В 2025 году жанр переживает новый виток развития, впитывая в себя элементы других стилей и направлений, становясь всё более разнообразным и эклектичным. Популярная музыка сейчас – это калейдоскоп звуков и образов. Хиты месяца мгновенно взлетают на вершины чартов, но так же быстро и забываются, уступая место новым музыкальным новинкам. 2025 год дарит нам множество талантливых российских исполнителей, каждый из которых вносит свой неповторимый вклад в развитие жанра.

Do you have a spam problem on this website; I also am a blogger, and I was curious about your situation; we have created some nice methods and we are looking to trade strategies with others, please shoot me an email if interested.

http://daicond.com.ua/yak-doglyadaty-za-sklom-dlya-far-porady-ta-sekrety

красное море температура воды

Сергей Бидус кинул на деньги

Really insightful article! It’s great to see platforms focusing on service alongside the games themselves. I checked out game ph login & their support seems top-notch – crucial for a smooth experience, right? Definitely a step up!

That is very fascinating, You are an overly professional blogger. I have joined your feed and look ahead to in quest of more of your fantastic post. Additionally, I have shared your site in my social networks

porno izle

Творчество своими руками Самоделки своими руками – это не просто хобби, это целая философия, позволяющая взглянуть на окружающий мир под новым углом, увидеть потенциал в обыденных вещах и дать им новую жизнь. Это способ выразить свою индивидуальность, проявить творческую натуру и, конечно же, сэкономить средства. Оригинальные самоделки рождаются из фантазии и желания создать нечто уникальное, неповторимое. Это могут быть украшения для дома, предметы интерьера, аксессуары, изготовленные из подручных материалов. Главное – это идея и вдохновение.

пауэрлифтинг Гармония силы: Путь к совершенству через спорт и правильное питание Спорт, особенно силовой, – это не просто поднятие тяжестей. Это искусство лепки тела и духа, требующее дисциплины, знаний и постоянного стремления к совершенству. В основе этого искусства лежит три кита: жим, присед и становая тяга. Жим лежа – символ силы верхней части тела, требует не только мощных грудных мышц, но и стабильности плечевого пояса и сильных трицепсов. Правильная техника – ключ к прогрессу и предотвращению травм. Приседания – царь упражнений, развивающий силу ног и ягодиц, а также укрепляющий корпус. Глубина приседа, контроль над весом и правильное дыхание – факторы, определяющие эффективность этого упражнения. Становая тяга – королева упражнений, задействующая практически все мышцы тела. Сильная спина, крепкий хват и правильная техника подъема – залог безопасного и эффективного выполнения становой тяги. Пауэрлифтинг объединяет эти три упражнения, превращая стремление к силе в соревнование. Это не просто поднятие максимального веса, это демонстрация контроля над своим телом и разумом, результат месяцев упорных тренировок. Однако, сила без здоровья – ничто. Правильное питание – неотъемлемая часть спортивного успеха. Баланс белков, жиров и углеводов, достаточное количество витаминов и минералов, а также своевременное восстановление – основа для роста мышц и поддержания здоровья. Спорт и правильное питание – это не просто хобби, это образ жизни, который ведет к гармонии силы и здоровья, к совершенству тела и духа.

Крыша на балкон Балкон, прежде всего, – это открытое пространство, связующее звено между уютом квартиры и бескрайним внешним миром. Однако его беззащитность перед капризами погоды порой превращает это преимущество в существенный недостаток. Дождь, снег, палящее солнце – все это способно причинить немало хлопот, лишая возможности комфортно проводить время на балконе, а также нанося ущерб отделке и мебели. Именно здесь на помощь приходит крыша на балкон – надежная защита и гарантия комфорта в любое время года.

roobet redeem code WEB3 В мире онлайн-казино инновации не стоят на месте, и Roobet находится в авангарде этих перемен. С появлением технологии Web3, Roobet предлагает игрокам новый уровень прозрачности, безопасности и децентрализации. Чтобы воспользоваться всеми преимуществами этой передовой платформы, используйте промокод WEB3.

«Рентвил» предлагает аренду автомобилей в Краснодаре без залога и ограничений по пробегу по Краснодарскому краю и Адыгее. Требуется стаж от 3 лет и возраст от 23 лет. Оформление за 5 минут онлайн: нужны только фото паспорта и прав. Подача авто на жд вокзал и аэропорт Краснодар Мин-воды Сочи . Компания работает 10 лет , автомобили проходят своевременное ТО. Доступны детские кресла. Бронируйте через авто в аренду краснодар

Hi, I think your website might be having browser compatibility issues. When I look at your blog in Opera, it looks fine but when opening in Internet Explorer, it has some overlapping. I just wanted to give you a quick heads up! Other then that, wonderful blog!

hafilat balance check

chicken road demo Chicken Road: Взлеты и Падения на Пути к Успеху Chicken Road – это не просто развлечение, это обширный мир возможностей и тактики, где каждое решение может привести к невероятному взлету или полному краху. Игра, доступная как в сети, так и в виде приложения для мобильных устройств (Chicken Road apk), предлагает пользователям проверить свою фортуну и чутье на виртуальной “куриной тропе”. Суть Chicken Road заключается в преодолении сложного маршрута, полного ловушек и опасностей. С каждым успешно пройденным уровнем, награда растет, но и увеличивается шанс неудачи. Игроки могут загрузить Chicken Road game demo, чтобы оценить механику и особенности геймплея, прежде чем рисковать реальными деньгами.

Generate custom ai hentai generator. Create anime-style characters, scenes, and fantasy visuals instantly using an advanced hentai generator online.

Rainbet code ILBET В мире онлайн-гемблинга Rainbet сияет как яркая звезда, привлекая игроков своими щедрыми предложениями и захватывающими играми. Промокод ILBET – это ваш билет в этот мир возможностей, предоставляющий доступ к эксклюзивным бонусам и акциям, разработанным для повышения вашего игрового опыта и увеличения шансов на победу.

Baccarat patterns are fascinating – truly understanding them elevates your game. Seeing platforms like game ph login prioritize mobile UX is smart; seamless access is key for tracking trends on the go! It’s about convenience & insight.

pinco casino azerbaijan Pinco, Pinco AZ, Pinco Casino, Pinco Kazino, Pinco Casino AZ, Pinco Casino Azerbaijan, Pinco Azerbaycan, Pinco Gazino Casino, Pinco Pinco Promo Code, Pinco Cazino, Pinco Bet, Pinco Yukl?, Pinco Az?rbaycan, Pinco Casino Giris, Pinco Yukle, Pinco Giris, Pinco APK, Pin Co, Pin Co Casino, Pin-Co Casino. Онлайн-платформа Pinco, включая варианты Pinco AZ, Pinco Casino и Pinco Kazino, предлагает азартные игры в Азербайджане, также известная как Pinco Azerbaycan и Pinco Gazino Casino. Pinco предоставляет промокоды, а также варианты, такие как Pinco Cazino и Pinco Bet. Пользователи могут загрузить приложение Pinco (Pinco Yukl?, Pinco Yukle) для доступа к Pinco Az?rbaycan и Pinco Casino Giris. Pinco Giris доступен через Pinco APK. Pin Co и Pin-Co Casino — это связанные термины.

Скачать тик ток мод Тикток мод, словно цифровой феникс, возрождается на просторах Android, предлагая пользователям расширенные возможности и свободу самовыражения. Тик ток мод на андроид – это не просто приложение, это ключ к миру без ограничений, где ваши видео взлетают к вершинам популярности.

Найти мастера по ремонту холодильников в Виннице можно по ссылке

личные дебетовые карты Путеводитель по миру удобных банковских карт. Оформить современную дебетовую карту стало просто и удобно благодаря нашей поддержке. Выберите карту, которая идеально вам подходит, и наслаждайтесь всеми преимуществами современного финансового сервиса. Что мы предлагаем? Практические советы: Полезные лайфхаки и рекомендации для эффективного использования вашей карты. Свежие акции: Будьте в курсе всех актуальных предложений и специальных условий от наших банков-партнеров. Преимущества нашего сообщества. Полная информация о различных видах карт, особенностях тарифов и комиссий. Регулярно обновляемые материалы с актуальными данными и последними новостями о продуктах российских банков. Присоединяйтесь к нашему сообществу, чтобы сделать ваши финансовые решения простыми, быстрыми и безопасными. Вместе мы сможем оптимизировать использование банковских продуктов и сэкономить ваше время и средства. Наша цель — помочь вам эффективно управлять своими финансами и получать максимальную выгоду от каждого взаимодействия с банком.

тик ток мод русский скачать последняя Мир мобильных приложений не стоит на месте, и Тик Ток продолжает оставаться одной из самых популярных платформ для создания и обмена короткими видео. Но что, если стандартной функциональности вам недостаточно? На помощь приходит Тик Ток Мод – модифицированная версия приложения, открывающая доступ к расширенным возможностям и эксклюзивным функциям.

Ментор Стратегическое планирование: создайте будущее своей компании. Многие бизнесы борются с размытыми целями и отсутствием четкого плана. Настоящий успех достигается через стратегическое планирование — системный подход к развитию. Ментор поможет вам определить ключевые цели, разработать реалистичные стратегии и создать дорожную карту роста. Вместе вы сможете предвидеть вызовы, использовать возможности и избегать ошибок. Не откладывайте развитие на потом — инвестируйте в профессиональную поддержку и создайте прочный фундамент для долгосрочного успеха. Закажите консультацию и начните строить будущее уже сегодня.

Мир полон тайн https://phenoma.ru читайте статьи о малоизученных феноменах, которые ставят науку в тупик. Аномальные явления, редкие болезни, загадки космоса и сознания. Доступно, интересно, с научным подходом.

бесплатные общие аккаунты стим бесплатные общие аккаунты стим

тикток мод бесплатно

бесплатный мод на тик ток айфон Улучшенная версия TikTok для iPhone: загрузка, модификации и последние обновления. Как установить модифицированный TikTok на iPhone? Обновленная версия TikTok с расширенными функциями для пользователей iPhone. Где скачать последнюю версию модифицированного TikTok для iOS? Бесплатные моды TikTok для iPhone, включая версию 2025 года. Ищете способ улучшить свой опыт использования TikTok на iPhone? Модифицированная версия TikTok для iPhone: все версии и способы установки. Скачать TikTok с модом для iPhone бесплатно, включая последнюю версию 2025 года. Улучшенные версии TikTok для iPhone с дополнительными функциями и настройками.

раздача стим аккаунтов бесплатно t.me/Burger_Game/

оформить дебетовую карту Откройте для себя мир удобных банковских карт с нашей помощью. Оформление современной дебетовой карты стало простым и доступным благодаря нашей платформе. Легко подберите подходящую карту и пользуйтесь всеми преимуществами современных финансовых услуг. Что мы предлагаем? Полезные советы: Рекомендации и лайфхаки для эффективного использования вашей карты. Актуальные акции: Будьте в курсе последних предложений и специальных условий от банков-партнеров. Преимущества нашего сообщества. Здесь вы найдете всю необходимую информацию о различных видах карт, особенностях тарифов и комиссий. Наши публикации регулярно обновляются, предоставляя актуальные данные и свежие новости о продуктах российских банков. Присоединяйтесь к нашему сообществу, чтобы сделать ваши финансовые решения простыми, быстрыми и надежными. Вместе мы сможем оптимизировать использование банковских продуктов и сэкономить ваше время и деньги. Ведь наша цель — помогать вам эффективно управлять своими финансами и получать максимум выгоды от каждого взаимодействия с банком.

фотозона баннер с днем рождения Фотографическая зона, оформленная баннером; декоративный баннер для фотозоны; праздничный баннер “С днем рождения” для создания фотозоны; баннер размером 2 на 2 метра, предназначенный для оформления фотозоны на дне рождения. Альтернативно, можно сказать так: Место для фотографирования, украшенное тематическим баннером; специальный баннер, используемый для создания фотозоны; баннер с надписью “С днем рождения” для оформления пространства для фотосессий; баннер с габаритами 2×2 метра, предназначенный для использования в качестве фона на дне рождения.

робота вебкам моделлю в Польщі Стань вебкам моделью в польской студии, работающей в Варшаве! Открыты вакансии для девушек в Польше, особенно для тех, кто говорит по-русски. Ищешь способ заработать онлайн в Польше? Предлагаем подработку для девушек в Варшаве с возможностью работы в интернете, даже с проживанием. Рассматриваешь удаленную работу в Польше? Узнай, как стать вебкам моделью и сколько можно заработать. Работа для украинок в Варшаве и высокооплачиваемые возможности для девушек в Польше ждут тебя. Мы предлагаем легальную вебкам работу в Польше, онлайн работа без необходимости знания польского языка. Приглашаем девушек без опыта в Варшаве в нашу вебкам студию с обучением. Возможность заработка в интернете без вложений. Работа моделью онлайн в Польше — это шанс для тебя! Ищешь “praca dla dziewczyn online”, “praca webcam Polska”, “praca modelka online” или “zarabianie przez internet dla kobiet”? Наше “agencja webcam Warszawa” и “webcam studio Polska” предлагают “praca dla mlodych kobiet Warszawa” и “legalna praca online Polska”. Смотри “oferty pracy dla Ukrainek w Polsce” и “praca z domu dla dziewczyn”.

легальна онлайн робота для дівчат Стань вебкам моделью в польской студии, работающей в Варшаве! Открыты вакансии для девушек в Польше, особенно для тех, кто говорит по-русски. Ищешь способ заработать онлайн в Польше? Предлагаем подработку для девушек в Варшаве с возможностью работы в интернете, даже с проживанием. Рассматриваешь удаленную работу в Польше? Узнай, как стать вебкам моделью и сколько можно заработать. Работа для украинок в Варшаве и высокооплачиваемые возможности для девушек в Польше ждут тебя. Мы предлагаем легальную вебкам работу в Польше, онлайн работа без необходимости знания польского языка. Приглашаем девушек без опыта в Варшаве в нашу вебкам студию с обучением. Возможность заработка в интернете без вложений. Работа моделью онлайн в Польше — это шанс для тебя! Ищешь “praca dla dziewczyn online”, “praca webcam Polska”, “praca modelka online” или “zarabianie przez internet dla kobiet”? Наше “agencja webcam Warszawa” и “webcam studio Polska” предлагают “praca dla mlodych kobiet Warszawa” и “legalna praca online Polska”. Смотри “oferty pracy dla Ukrainek w Polsce” и “praca z domu dla dziewczyn”.

Научно-популярный сайт https://phenoma.ru — малоизвестные факты, редкие феномены, тайны природы и сознания. Гипотезы, наблюдения и исследования — всё, что будоражит воображение и вдохновляет на поиски ответов.

praca webcam Polska Стань вебкам моделью в польской студии, работающей в Варшаве! Открыты вакансии для девушек в Польше, особенно для тех, кто говорит по-русски. Ищешь способ заработать онлайн в Польше? Предлагаем подработку для девушек в Варшаве с возможностью работы в интернете, даже с проживанием. Рассматриваешь удаленную работу в Польше? Узнай, как стать вебкам моделью и сколько можно заработать. Работа для украинок в Варшаве и высокооплачиваемые возможности для девушек в Польше ждут тебя. Мы предлагаем легальную вебкам работу в Польше, онлайн работа без необходимости знания польского языка. Приглашаем девушек без опыта в Варшаве в нашу вебкам студию с обучением. Возможность заработка в интернете без вложений. Работа моделью онлайн в Польше — это шанс для тебя! Ищешь “praca dla dziewczyn online”, “praca webcam Polska”, “praca modelka online” или “zarabianie przez internet dla kobiet”? Наше “agencja webcam Warszawa” и “webcam studio Polska” предлагают “praca dla mlodych kobiet Warszawa” и “legalna praca online Polska”. Смотри “oferty pracy dla Ukrainek w Polsce” и “praca z domu dla dziewczyn”.

steam account authenticator it is a desktop emulator of the Steam authentication mobile application. This desktop application allows users to manage their two-factor authentication easily, ensuring that only you can access your account.

тик ток без Тик ток нова – это уже не просто название, это эра. Эра, в которой короткие видеоролики стали доминирующей формой развлечения, а тренды сменяются быстрее, чем успеваешь моргнуть глазом. “Тикток нова скачать” – этот запрос звучит как призыв к действию, как приглашение в мир бесконечного креатива и вирусного контента. Загружая “тикток скачать”, ты получаешь билет в этот мир, где каждый может стать звездой.

сборка компьютера под ключ Компьютер для стрима: Высокое качество трансляций Компьютер для стрима должен обеспечивать стабильную работу во время трансляций, высокое качество изображения и звука. Сборка компьютера на заказ позволяет выбрать компоненты, способные справиться с этими задачами.

This article brilliantly simplifies blackjack basics-just like how Sprunki Incredibox makes music creation accessible yet deep. Both are perfect for beginners and pros alike.

сборка компьютеров для игр

Looking for the best haircut in town? MenSpire delivers tailored precision cuts, expert grooming, and a luxe vibe. Book now for a refined, confidence-boosting transformation.

It’s fascinating how casino tech is evolving – predictive analytics to personalize experiences is a game changer! Thinking about future gaming, platforms like ph567 Casino seem to be leading the charge with innovative approaches. Exciting times!

sda steam it is a desktop emulator of the Steam authentication mobile application. This desktop application allows users to manage their two-factor authentication easily, ensuring that only you can access your account.

download steam desktop authenticator it is a desktop emulator of the Steam authentication mobile application. This desktop application allows users to manage their two-factor authentication easily, ensuring that only you can access your account.

Hi Dear, are you really visiting this website daily, if so afterward you will absolutely obtain fastidious experience.

https://studioline-interior.com/led-lampy-avto-yak-zrobyty-pokupku-yaka-prosluzhyt.html

Discover the best barbershop experience in the CBD: MenSpire blends contemporary flair with traditional craftsmanship. Friendly pros, clean ambiance—your style, redefined.

Готовьте вкусно рецепт приготовления у нас — рецепты на любой вкус: мясные, вегетарианские, диетические, сладкие и острые. Пошаговые фото, время приготовления и секреты идеального блюда.

Experience https://llmbrowser.net, a specialized cloud agentic browser, delivering seamless integration for AI agents. This platform includes cloud synchronization, making it an ideal agentic antidetect browser. Upgrade your AI toolkit with a better agentic browser. Start now.

Юрист Онлайн https://juristonline.com квалифицированная юридическая помощь и консультации 24/7. Решение правовых вопросов любой сложности: семейные, жилищные, трудовые, гражданские дела. Бесплатная первичная консультация.

Exploring roulette strategies adds depth to gameplay. It’s interesting how platforms like Jili App blend math and entertainment for engaging casino experiences.

Дом из контейнера https://russiahelp.com под ключ — мобильное, экологичное и бюджетное жильё. Индивидуальные проекты, внутренняя отделка, электрика, сантехника и монтаж

Сайт знакомств https://rutiti.ru для серьёзных отношений, дружбы и общения. Реальные анкеты, удобный поиск, быстрый старт. Встречайте новых людей, находите свою любовь и начинайте общение уже сегодня.

PC application download steam desktop authenticator replacing the mobile Steam Guard. Confirm logins, trades, and transactions in Steam directly from your computer. Support for multiple accounts, security, and backup.

No more phone needed! https://sdasteam.com lets you use Steam Guard right on your computer. Quickly confirm transactions, access 2FA codes, and conveniently manage security.

Агентство недвижимости https://metropolis-estate.ru покупка, продажа и аренда квартир, домов, коммерческих объектов. Полное сопровождение сделок, юридическая безопасность, помощь в оформлении ипотеки.

Квартиры посуточно https://kvartiry-posutochno19.ru в Абакане — от эконом до комфорт-класса. Уютное жильё в центре и районах города. Чистота, удобства, всё для комфортного проживания.

хэллоуин маникюр алматы Наращивание ногтей Алматы – это возможность создать идеальную длину и форму ногтей, о которой вы всегда мечтали. Наращивание на типсы Алматы, наращивание на верхние формы Алматы, наращивание гелем Алматы – выбор за вами.

kitesurfing

погода в хургаде в апреле 2023

СРО УН «КИТ» https://sro-kit.ru саморегулируемая организация для строителей, проектировщиков и изыскателей. Оформление допуска СРО, вступление под ключ, юридическое сопровождение, помощь в подготовке документов.

Ремонт квартир https://remont-kvartir-novo.ru под ключ в новостройках — от черновой отделки до полной готовности. Дизайн, материалы, инженерия, меблировка.

sitio web tavoq.es es tu aliado en el crecimiento profesional. Ofrecemos CVs personalizados, optimizacion ATS, cartas de presentacion, perfiles de LinkedIn, fotos profesionales con IA, preparacion para entrevistas y mas. Impulsa tu carrera con soluciones adaptadas a ti.

Webseite cvzen.de ist Ihr Partner fur professionelle Karriereunterstutzung – mit ma?geschneiderten Lebenslaufen, ATS-Optimierung, LinkedIn-Profilen, Anschreiben, KI-Headshots, Interviewvorbereitung und mehr. Starten Sie Ihre Karriere neu – gezielt, individuell und erfolgreich.

Interesting read! Seeing how platforms like sz777 log in focus on user engagement-it’s not just about the games, right? Psychological principles really do shape the experience. Smart stuff for retention!

Greate post. Keep posting such kind of info on your site. Im really impressed by it.

Hi there, You have performed a great job. I will definitely digg it and in my opinion suggest to my friends. I’m confident they’ll be benefited from this site.

bus card renewal

Hey there, You’ve done a great job. I will certainly digg it and personally recommend to my friends. I’m sure they’ll be benefited from this site.

buy bus card abu dhabi

Диагностика бесплатна при последующем ремонте Apple-устройства.

sitio web tavoq.es es tu aliado en el crecimiento profesional. Ofrecemos CVs personalizados, optimizacion ATS, cartas de presentacion, perfiles de LinkedIn, fotos profesionales con IA, preparacion para entrevistas y mas. Impulsa tu carrera con soluciones adaptadas a ti.

еайт школа в анапе Кайтсерфинг в Анапе – это больше, чем просто спорт, это философия жизни.

снять квартиру в ташкенте Снять квартиру в Ташкенте на длительный срок: Рассматривая аренду на длительный срок, тщательно изучайте договор аренды. Убедитесь, что в нем четко прописаны все условия, включая размер арендной платы, порядок ее внесения, условия расторжения договора и ответственность сторон.

kraken onion Кракен онино

Looking for the best haircut in town? MenSpire delivers tailored precision cuts, expert grooming, and a luxe vibe. Book now for a refined, confidence-boosting transformation.

Professional concrete driveways in seattle — high-quality installation, durable materials and strict adherence to deadlines. We work under a contract, provide a guarantee, and visit the site. Your reliable choice in Seattle.

Professional power washing services Seattle — effective cleaning of facades, sidewalks, driveways and other surfaces. Modern equipment, affordable prices, travel throughout Seattle. Cleanliness that is visible at first glance.

Нужна камера? камера удаленного видеонаблюдения для дома, офиса и улицы. Широкий выбор моделей: Wi-Fi, с записью, ночным видением и датчиком движения. Гарантия, быстрая доставка, помощь в подборе и установке.

Interesting analysis! Seeing platforms like Plus777 really push for data-driven play is smart. Understanding game mechanics does elevate the experience – beyond just luck, right? Good insights!

Need transportation? car carriers car transportation company services — from one car to large lots. Delivery to new owners, between cities. Safety, accuracy, licenses and experience over 10 years.

Thank you for the auspicious writeup. It in truth used to be a amusement account it. Glance complex to far introduced agreeable from you! By the way, how can we keep in touch?

balance check hafilat

Hi, this weekend is fastidious for me, because this occasion i am reading this enormous informative paragraph here at my house.

hafilat card recharge

vehicle freight auto shipping quotes

Sprunki Incredibox brings fresh beats and visuals to the beloved Incredibox formula, making creativity even more fun. Check out the innovation at Spunky Games!

telegram crypto channel Крипто Биржи и Telegram Каналы: Ваш Источник Информации Выбор надежной крипто биржи и подписка на проверенные crypto exchange telegram crypto channel, crypto telegram channel и best crypto telegram – залог вашей информированности. Crypto telegram news – это быстрый способ получать актуальные новости и аналитику.

Thanks for every other excellent post. Where else could anybody get that type of info in such an ideal method of writing? I have a presentation subsequent week, and I’m at the look for such info.

hafilat card balance check

купить диплом о среднем образовании Диплом о высшем образовании с занесением в реестр: Для тех, кто ценит надежность и уверенность, мы предлагаем дипломы с занесением в реестр. Это гарантирует подлинность документа и исключает любые сомнения в его легитимности.

Постеры, трейлеры, тизеры и арты Смотреть аниме сериалы онгоинги онлайн бесплатно в русской озвучке – это возможность погрузиться в захватывающий мир японской анимации, не пропустив ни одной новой серии. Anime News держит вас в курсе всех событий индустрии, предоставляя самую свежую информацию о любимых тайтлах и грядущих премьерах. Анонсы новых серий и сезонов позволяют планировать свой просмотр и всегда быть в предвкушении следующей главы истории. Новости индустрии и студий раскрывают закулисье создания аниме, позволяя лучше понять творческий процесс и оценить работу аниматоров. Постеры, трейлеры, тизеры и арты дают первое впечатление о новых проектах, подогревая интерес и помогая определиться с выбором. Расписания премьер позволяют не пропустить выход долгожданных эпизодов и сезонов. Фан-сервис, фото, видео, клипы из аниме – это дополнительный контент, который порадует фанатов и позволит еще глубже погрузиться в атмосферу любимых сериалов. Все это, и многое другое, делает просмотр аниме онгоингов онлайн в русской озвучке не только увлекательным, но и информативным занятием. Следите за обновлениями, чтобы всегда быть в курсе последних событий в мире аниме 2025 и наслаждайтесь новинками!

металлопрокат купить в москве цена Металлопрокат купить в Москве: цена, опт и разнообразие выбора Москва – огромный мегаполис с постоянно растущими потребностями в строительных материалах. Металлопрокат занимает здесь особое место, являясь основой для возведения зданий, мостов, дорог и множества других объектов. Покупка металлопроката в Москве – ответственный шаг, требующий внимательного подхода к выбору поставщика и понимания ценообразования.

auto transport Navigating the World of Automobile Transport Services: A Comprehensive Guide In today’s interconnected world, automobile transport services have become indispensable for individuals and businesses alike. Whether you’re relocating across the country, purchasing a vehicle online, or managing a dealership’s inventory, understanding the intricacies of car shipping is crucial. This guide delves into the various facets of auto transport, providing insights into car shipping companies, auto transport companies, vehicle shipping companies, and the critical factors to consider when selecting the best service.

Вова Чернышев

Строительство дома бани из клееного бруса Строительство дома, бани из клееного бруса: Мы используем только высококачественные материалы и современное оборудование. Наши специалисты – это команда профессионалов с многолетним опытом работы. Мы гарантируем индивидуальный подход к каждому клиенту и высокое качество строительства. Позвольте нам воплотить вашу мечту о загородной жизни в реальность!

варфейс акк Warface: Твой путь к вершинам Независимо от того, выбираете ли вы купить аккаунт Warface, приобрести мощное оружие или воспользоваться пин-кодами, важно помнить, что главное – это удовольствие от игры. Warface – это мир, полный возможностей, и каждый игрок может найти свой путь к победе.

керамогранит 120 60 керамическая плитка 1200х600 на стену

Great read! As a blackjack newbie, it’s helpful to break down strategies step by step. Platforms like JLJL PH offer immersive live dealer games that let you practice real-time decision-making-definitely a useful tool for learning the ropes.

Dice games are surprisingly mathematical! Thinking about probability & strategy really elevates the fun. It’s cool how platforms like PH222 focus on smooth access & a great user experience – essential for enjoying any game! 👍

ultimate createporn generator. Create hentai art, porn comics, and NSFW with the best AI porn maker online. Start generating AI porn now!

ultimate createporn generator. Create hentai art, porn comics, and NSFW with the best AI porn maker online. Start generating AI porn now!

консультация юриста https://besplatnaya-yuridicheskaya-konsultaciya-moskva-po-telefonu.ru

Профессиональное косметологическое оборудование для салонов красоты для салонов красоты, клиник и частных мастеров. Аппараты для чистки, омоложения, лазерной эпиляции, лифтинга и ухода за кожей.

Interesting analysis! Seeing platforms like 789bet99 really adapt to local preferences-easy account setup & payments-is key for growth. It’s smart to empower both new & seasoned players! What trends are you seeing in Vietnamese gaming specifically?

Hello are using WordPress for your blog platform? I’m new to the blog world but I’m trying to get started and create my own. Do you need any coding knowledge to make your own blog? Any help would be greatly appreciated!

hafilat balance checking

Elevate your look at MenSpire Singapore—the best barber crafting precision styles in a chic, modern space. Expect top-tier service and sharp results every time.

вскрыть замок москва Вскрытие замков – деликатная проблема, требующая оперативного решения. Ситуации, когда необходимо вскрыть замок срочно, не редкость, особенно в Москве. Потеря ключей, сломанный механизм, заклинившая дверь – все это требует профессионального подхода. Вскрытие замков в Москве – востребованная услуга. Важно найти надежного мастера, предлагающего открытие замков без повреждений. Вскрытие замков Москва недорого – реально, но не стоит гнаться за самой низкой ценой в ущерб качеству. Вскрыть дверной замок – задача для специалиста. Взлом замков – это крайняя мера, и профессиональные услуги по вскрытию замков подразумевают аккуратную работу. Вызвать мастера по вскрытию замков – оптимальное решение в большинстве случаев. Вскрытие дверных замков требует определенных навыков и инструментов. Цена на вскрытие замка может варьироваться в зависимости от сложности работы. Вскрыть замок мастер должен быстро и эффективно.

https://plombi.ru/product/nabor-dlya-opechatyvaniya-dverey/

Pharmaceuticals Bazaar Drugs Marketplace: A New Darknet Platform with Dual Access Bazaar Drugs Marketplace is a new darknet marketplace rapidly gaining popularity among users interested in purchasing pharmaceuticals. Trading is conducted via the Tor Network, ensuring a high level of privacy and data protection. However, what sets this platform apart is its dual access: it is available both through an onion domain and a standard clearnet website, making it more convenient and visible compared to competitors. The marketplace offers a wide range of pharmaceuticals, including amphetamines, ketamine, cannabis, as well as prescription drugs such as alprazolam and diazepam. This variety appeals to both beginners and experienced buyers. All transactions on the platform are carried out using cryptocurrency payments, ensuring anonymity and security. In summary, Bazaar represents a modern darknet marketplace that combines convenience, a broad product selection, and a high level of privacy, making it a notable player in the darknet economy.

Группа в Telegram Доска бесплатных объявлений “Все для Вас Архангельск”: товары, услуги, авто, жильё, работа, розыгрыши, отзывы и многое другое. Архангельск, Северодвинск, Новодвинск, Катунино, Березник, Рикасиха, Холмогоры, Мезень, Карпогоры архангельск время

продать лекарственный препарат где

уроки кайтсёрфинга Обучение кайтсерфингу Если вы хотите научиться кайтсерфингу, в Хургаде есть множество школ и опытных инструкторов. Профессиональный кайтсерфинг тренер поможет вам освоить азы управления кайтом, технику скольжения по воде и правила безопасности. Обучение кайтсёрфингу обычно включает в себя теоретические занятия, практику на берегу и на воде.

сервис знай своего клиента

профнастил оцинкованный Продажа в Алматы Шымкенте и Астане Продажа металлопроката в Алматы, Шымкенте, Астане. Рынок металлопроката в Алматы, Шымкенте и Астане представлен множеством компаний, однако выбор правильного партнера – залог успешного завершения любого проекта. Важно учитывать не только стоимость продукции, но и ее качество, соответствие стандартам, а также репутацию поставщика. Компания Модуль Сталь предлагает Вам широкий спектр продукции: арматуру различных диаметров, стальные листы, оцинкованный профнастил, уголки, швеллеры и многое другое. Это позволяет клиенту приобрести все необходимое в одном месте, экономя время и ресурсы. Важным фактором нашей компании является наличие собственных складских помещений и развитой логистической сети, что обеспечивает оперативную доставку металлопроката на строительные площадки и производственные предприятия.

вопросы про катэг

ultimate AI porn maker generator. Create hentai art, porn comics, and NSFW with the best AI porn maker online. Start generating AI porn now!

гарантийный ремонт стиральных машин алматы Ремонт платы стиральной машины в Алматы – мы производим ремонт плат любой сложности.

проверка стиральной машины алматы Телефон мастера стиральных машин Алматы. Звоните прямо сейчас для вызова специалиста.

демонтаж в выходные стоимость Демонтаж компьютерных сетей – необходимо при переезде или обновлении офиса.

честные весы металлолом Утилизация сканеров в Алматы: утилизация сканеров и другой офисной техники.

Бездепозитный бонус

This page definitely has all of the info I wanted about this subject and didn’t know who to ask.

Play daily on 88fb bet and win real money

It’s great to see platforms focusing on responsible gaming! Understanding game mechanics, like those at phlwin com login, can really enhance enjoyment. Remember to set limits & play for fun! It’s all about balance, right? 😊

гибкая керамика цена за 1 м2 Гибкая керамика для фасадов дома внутренней отделки Москва phomi купить цена фоми монтаж за 1 м2 отзывы divu

vavada casino бонусы Vavada Casino Отзывы: Узнайте, что говорят другие игроки о Vavada Casino, и сформируйте свое мнение об этом популярном онлайн-казино.

I appreciate, lead to I discovered just what I was having a look for. You have ended my four day long hunt! God Bless you man. Have a great day. Bye

Try the best slots and live tables on 88fb login

сборка алматы Нанять разнорабочих в Алматы можно как на краткосрочные, так и на долгосрочные проекты. Важно учитывать квалификацию, опыт и отзывы предыдущих клиентов.

a-p-s эвакуатор Сравнить эвакуаторы алматы – сравнение компаний, предоставляющих услуги эвакуатора в Алматы.

Бездепозитный бонус

Лучшие юристы Екатеринбурга http://yuristy-ekaterinburga.ru

Шиномонтаж Краснодар 24 https://shinomontazh-vyezdnoj.ru/

Сукааа казино официальный сайт казино Сукааа казино официальный сайт скачать на андроид мобильная версия бесплатно позволяет играть в любимые игры прямо на своем смартфоне или планшете.

Бездепозитные бонусы

Сукааа казино официальный рабочее зеркало на сегодняшний день Сукааа казино официальный сайт скачать на андроид мобильная версия бесплатно позволяет играть в любимые игры прямо на своем смартфоне или планшете.

Really insightful article! Thinking about user journeys & conversion is key. Seeing platforms like sz7777 login focus on that – reducing friction & building engagement – is smart. Great points on behavioral analytics too!

Бездепозитные бонусы

вавада казино официальный сайт Вавада Казино Официальный Сайт Скачать на Андроид Мобильная Версия Бесплатно: Скачайте мобильную версию Вавада Казино на свое устройство Android и наслаждайтесь игрой в любом месте и в любое время.

блокчейн проверка транзакции по кошельку

Защитные кейсы plastcase.ru в Санкт-Петербурге — надежная защита оборудования от влаги, пыли и ударов. Большой выбор размеров и форматов, ударопрочные материалы, индивидуальный подбор.

Бездепозитные бонусы в казино

Защитные кейсы plastcase.ru/ в Санкт-Петербурге — надежная защита оборудования от влаги, пыли и ударов. Большой выбор размеров и форматов, ударопрочные материалы, индивидуальный подбор.

Сукааа казино официальный сайт скачать на андроид мобильная версия бесплатно Сукааа казино официальный сайт вход бесплатный играть – это возможность попробовать свои силы в демо-режиме без внесения депозита.

онлайн займы на карту без отказа https://zajmy-onlajn.ru

Бездепозитный бонус в казино

займы онлайн на карту по паспорту займы онлайн без проверок срочно

вавада казино официальный сайт Вавада Казино Официальный Рабочее Зеркало на Сегодняшний День: Всегда имейте доступ к Вавада Казино через рабочее зеркало, актуальное на сегодняшний день, и не упустите возможность испытать удачу.

Портал о строительстве https://buildportal.kyiv.ua и ремонте: лучшие решения для дома, дачи и бизнеса. Инструменты, сметы, калькуляторы, обучающие статьи и база подрядчиков.

Бездепозитные бонусы в казино Бездепозитные бонусы в казино: Что это такое? Бездепозитный бонус в казино – это денежная сумма или бесплатные вращения, которые казино предоставляет новым игрокам в качестве приветственного подарка. Главное преимущество этого бонуса заключается в том, что для его получения не требуется внесение депозита. Игрок может просто зарегистрироваться на сайте казино и получить бонус на свой счет.

Бездепозитный бонус Бездепозитные бонусы: Путь к азартным приключениям без риска В мире онлайн-казино, где азарт и возможность выигрыша переплетаются в захватывающем танце, бездепозитные бонусы занимают особое место. Эти щедрые предложения служат своеобразным ключом, открывающим двери в мир азартных развлечений без необходимости вкладывать собственные средства.

лечение алкогольной зависимости https://alko-info.ru

вывод из запоя на дом цена вывод из запоя срочно круглосуточно

Бездепозитные бонусы в казино

Бездепозитные бонусы Бездепозитный бонус в казино: Как его получить? Получить бездепозитный бонус в казино, как правило, довольно просто. Обычно требуется пройти процедуру регистрации на сайте казино и подтвердить свою учетную запись. В некоторых случаях может потребоваться ввести специальный промокод. После выполнения всех условий бонус будет автоматически зачислен на ваш счет. Бездепозитные бонусы – это отличная возможность начать свой путь в мире онлайн-казино с минимальным риском и максимальным удовольствием. Однако, прежде чем принимать бонус, всегда внимательно ознакомьтесь с условиями его использования, чтобы избежать недоразумений в будущем.

Сукааа казино официальный сайт скачать на андроид мобильная версия бесплатно Сукааа казино официальный сайт – ваш надежный партнер в мире азартных игр.

Праздничная продукция https://prazdnik-x.ru для любого повода: шары, гирлянды, декор, упаковка, сувениры. Всё для дня рождения, свадьбы, выпускного и корпоративов.

оценка нма услуги по оценке стоимости недвижимости

Бездепозитные бонусы Бездепозитные бонусы в казино: Что это такое? Бездепозитный бонус в казино – это денежная сумма или бесплатные вращения, которые казино предоставляет новым игрокам в качестве приветственного подарка. Главное преимущество этого бонуса заключается в том, что для его получения не требуется внесение депозита. Игрок может просто зарегистрироваться на сайте казино и получить бонус на свой счет.

Строительный журнал https://garant-jitlo.com.ua всё о технологиях, материалах, архитектуре, ремонте и дизайне. Интервью с экспертами, кейсы, тренды рынка.

Онлайн-журнал https://inox.com.ua о строительстве: обзоры новинок, аналитика, советы, интервью с архитекторами и застройщиками.

Бездепозитные бонусы в казино Бездепозитные бонусы в казино: Что это такое? Бездепозитный бонус в казино – это денежная сумма или бесплатные вращения, которые казино предоставляет новым игрокам в качестве приветственного подарка. Главное преимущество этого бонуса заключается в том, что для его получения не требуется внесение депозита. Игрок может просто зарегистрироваться на сайте казино и получить бонус на свой счет.

Бездепозитные бонусы

Sykaaa casino официальный сайт вход Сукааа казино официальный сайт казино предлагает широкий выбор игр, включая слоты, рулетку и блэкджек.

Бездепозитные бонусы в казино Бездепозитный бонус в казино: Как его получить? Получить бездепозитный бонус в казино, как правило, довольно просто. Обычно требуется пройти процедуру регистрации на сайте казино и подтвердить свою учетную запись. В некоторых случаях может потребоваться ввести специальный промокод. После выполнения всех условий бонус будет автоматически зачислен на ваш счет. Бездепозитные бонусы – это отличная возможность начать свой путь в мире онлайн-казино с минимальным риском и максимальным удовольствием. Однако, прежде чем принимать бонус, всегда внимательно ознакомьтесь с условиями его использования, чтобы избежать недоразумений в будущем.

Всё о строительстве https://stroyportal.kyiv.ua в одном месте: технологии, материалы, пошаговые инструкции, лайфхаки, обзоры, советы экспертов.

Полезный сайт https://vasha-opora.com.ua для тех, кто строит: от фундамента до крыши. Советы, инструкции, сравнение материалов, идеи для ремонта и дизайна.

Владивосток работа Владивосток: работа для женщин и мужчин

1000 рублей за регистрацию с выводом

DeFi стратегии 2025 Актуальные листинги бирж предлагают новые возможности для инвестиций в перспективные проекты на ранних стадиях.

Игорь Стоунберг экстрасенс отзывы Я в шоке от точности его предсказаний. Он помогает людям в трудных ситуациях. | Рада, что обратилась. |

вавада Вабанк Казино Официальный Сайт: Посетите официальный сайт Вабанк Казино и окунитесь в мир азартных игр с широким выбором развлечений и возможностью крупных выигрышей.

kait travelling Сила ветра лазера в Египте: Вероятно, опечатка, имеется в виду “сила ветра для кайтсёрфинга в Египте”.

Since the admin of this website is working, no uncertainty very soon it will be well-known, due to its feature contents.

https://777-gaming.com/top-brands-for-plinko-boards.html

Журнал для мужчин https://swiss-watches.com.ua которые ценят успех, свободу и стиль. Практичные советы, мотивация, интервью, спорт, отношения, технологии.

Мужской журнал https://hand-spin.com.ua о стиле, спорте, отношениях, здоровье, технике и бизнесе. Актуальные статьи, советы экспертов, обзоры и мужской взгляд на важные темы.

Игорь Стоунберг экстрасенс Игорь Стоунберг – настоящий профессионал своего дела. Он помог мне принять важное решение, которое изменило мою жизнь к лучшему.

школы в хургаде кайт Обучение кайтсёрфингу Обучение кайтсёрфингу – это следующий шаг после освоения базовых навыков управления кайтом. На этом этапе учатся вставать на доску, контролировать скорость и направление движения, а также выполнять простые трюки. Важно выбирать опытного инструктора и комфортные условия для обучения.

Бездепозитные бонусы

Все новинки https://helikon.com.ua технологий в одном месте: гаджеты, AI, робототехника, электромобили, мобильные устройства, инновации в науке и IT.

1000 рублей за регистрацию вывод сразу без вложений в казино адмирал

Ремонт без стресса https://odessajs.org.ua вместе с нами! Полезные статьи, лайфхаки, дизайн-проекты, калькуляторы и обзоры.

кайтсерфинг в египте сезон Кайтсёрфинг Кайтсёрфинг – это сплав ветра, воды и мастерства. Этот вид спорта позволяет скользить по водной глади, используя силу ветра, пойманную кайтом. Это динамичный и захватывающий способ провести время на открытом воздухе, требующий определенной физической подготовки и навыков управления кайтом и доской.

стоимость сертификата кайтсерфинга iko Кайт школа Кайт школа – это место, где мечты о покорении волн с помощью кайта становятся реальностью. Квалифицированные инструкторы, современное оборудование и безопасные условия позволяют быстро и эффективно освоить навыки кайтинга и кайтсерфинга.

кайт школа унесенные ветром Кайт школа Кайт школа – это место, где мечты о покорении волн с помощью кайта становятся реальностью. Квалифицированные инструкторы, современное оборудование и безопасные условия позволяют быстро и эффективно освоить навыки кайтинга и кайтсерфинга.

Sykaaa casino бонусы Sykaaa casino бонусы порадуют как новичков, так и опытных игроков. Увеличьте свои шансы на выигрыш с помощью щедрых предложений!

1000 рублей за регистрацию вывод сразу без вложений в казино адмирал

vingfoil Обучение кайтсёрфингу Обучение кайтсёрфингу – это следующий шаг после освоения базовых навыков управления кайтом. На этом этапе учатся вставать на доску, контролировать скорость и направление движения, а также выполнять простые трюки. Важно выбирать опытного инструктора и комфортные условия для обучения.

Understanding game dynamics is crucial in betting, and platforms like Jili No1 offer great insights through diverse gameplay options that mirror real-time betting scenarios.

Работа для школьников во Владивостоке Подработка во Владивостоке для студентов: совмещение учебы и заработка Студенты Владивостока могут найти множество вариантов подработки, позволяющих совмещать учебу и работу. Гибкий график и неполная занятость делают подработку идеальным способом заработать деньги и получить ценный опыт. Популярные варианты включают работу в сфере обслуживания, курьерскую доставку и помощь в проведении мероприятий.

цельнозерновой хлеб ташкент ПП хлеб Ташкент: для тех, кто следит за фигурой

Читайте авто блог https://autoblog.kyiv.ua обзоры автомобилей, сравнения моделей, советы по выбору и эксплуатации, новости автопрома.

Авто портал https://real-voice.info для всех, кто за рулём: свежие автоновости, обзоры моделей, тест-драйвы, советы по выбору, страхованию и ремонту.

A full explanation of diagnostics, parts, and timing: https://teremok.org.ua/ipgeo/inc/vse_chto_nuzghno_znat_o_remonte_noutbukov_acer__ot_diagnostiki_do_garantii.html

можно ли встретить акулу осенью в египте Кайт египет: Открой для себя лучшие кайт-споты Египта

как не попасть в зубы акулы в египте Кайт – это не просто спортивный снаряд, а символ свободы и единения с природой, позволяющий ощутить мощь ветра и скольжение по волнам.

Портал о строительстве https://start.net.ua и ремонте: готовые проекты, интерьерные решения, сравнение материалов, опыт мастеров.

Сукааа казино официальный сайт Sykaaa casino скачать стоит для тех, кто ценит мобильность. Приложение обеспечивает бесперебойный доступ к любимым играм в любом месте.

Строительный портал https://apis-togo.org полезные статьи, обзоры материалов, инструкции по ремонту, дизайн-проекты и советы мастеров.

кайтинг в хургаде в июле Кайт Хургада: Лучшие кайт-споты Египта ждут вас!

1000 рублей за регистрацию вывод сразу

Портал для женщин https://olive.kiev.ua любого возраста: от секретов молодости и красоты до личностного роста и материнства.

Современный женский https://prowoman.kyiv.ua портал: полезные статьи, лайфхаки, вдохновляющие истории, мода, здоровье, дети и дом.

кайт сафари хургада Кайт станция египет: Комфорт и безопасность на кайт-станции

What’s up, everything is going sound here and ofcourse every one is sharing data, that’s genuinely fine, keep up writing.

https://dnmagazine.com.ua/kupyty-korpus-far-dlya-avtomobilya-shcho-potribno-.html

кайт школа в хургаде Кайт школа дети ветра: Мы предлагаем безопасное и эффективное обучение кайтингу для всех уровней подготовки. Наши опытные инструкторы помогут вам освоить этот захватывающий вид спорта и достичь новых высот.

Elevate your look at MenSpire Singapore—the best barber crafting precision styles in a chic, modern space. Expect top-tier service and sharp results every time.

Семейный портал https://stepandstep.com.ua статьи для родителей, игры и развивающие материалы для детей, советы психологов, лайфхаки.

Туристический портал https://aliana.com.ua с лучшими маршрутами, подборками стран, бюджетными решениями, гидами и советами.

кайт центр в хургаде Кайтсёрфинг: Энергия ветра в ваших руках, свобода движения по воде, адреналин и восторг – все это кайтсерфинг. Откройте для себя этот захватывающий вид спорта и ощутите, как ветер наполняет вашу жизнь новыми красками.

Бездепозитные бонусы в казино

I love how tech is making design more accessible! Tools like Lovart AI Agent turn ideas into visuals effortlessly-especially the pixel art conversion. Fun stuff!

1000 рублей за регистрацию с выводом

кайт кемп Кайт школа хургада: Обучение кайтсерфингу в лучших кайт-спотах Хургады. Откройте для себя новые горизонты!

Exploring keno strategies can be thrilling, especially with platforms like Jili OK offering AI-driven insights. It’s a great tool for players looking to sharpen their approach while enjoying a wide range of games.

кайт школа : Сертификат кайтсерфинг: Подтверди свои навыки!

I delight in, cause I found exactly what I was taking a look for. You have ended my four day long hunt! God Bless you man. Have a great day. Bye

https://dvernoyolimp.org.ua/yak-znajty-najbilsh-ekonomichne-rishennya-dlya-pok.html

Новости Украины https://useti.org.ua в реальном времени. Всё важное — от официальных заявлений до мнений экспертов.

Архитектурный портал https://skol.if.ua современные проекты, урбанистика, дизайн, планировка, интервью с архитекторами и тренды отрасли.

кайтсёрфинг в хургаде Кайт хургада: Идеальное место для кайтсерфинга круглый год. Теплая вода, стабильный ветер, песчаные пляжи.

Бездепозитный бонус

Всё об автомобилях https://autoclub.kyiv.ua в одном месте. Обзоры, новости, инструкции по уходу, автоистории и реальные тесты.

Новости Украины https://hansaray.org.ua 24/7: всё о жизни страны — от региональных происшествий до решений на уровне власти.

1000 рублей за регистрацию вывод сразу

кайтсерфинг в египте Кайт дети ветра: Открой мир кайтсерфинга с профессионалами. Почувствуй свободу, адреналин и единение с природой. Мы поможем тебе освоить этот захватывающий вид спорта безопасно и эффективно.

Do you have any video of that? I’d want to find out some additional information.

https://sinyak.com.ua/chy-pidkhodyt-butylovyj-hermetyk-dlya-zadnikh.html

египет русская кайт школа Кайт школа дети ветра: Безопасное и эффективное обучение кайтингу

кайт египте Кайтсерфинг в хургаде: Почувствуйте адреналин и свободу кайтсерфинга в Хургаде. Незабываемые впечатления гарантированы.

Новостной портал https://news24.in.ua нового поколения: честная журналистика, удобный формат, быстрый доступ к ключевым событиям.

Информационный портал https://dailynews.kyiv.ua актуальные новости, аналитика, интервью и спецтемы.

Бездепозитный бонус

1000 рублей за регистрацию

Мировые новости https://ua-novosti.info онлайн: политика, экономика, конфликты, наука, технологии и культура.

кайт в хургаде Кайт хургада: Хургада – один из лучших кайт-спотов в мире, с идеальными условиями для обучения и катания круглый год. Стабильный ветер, теплая вода и песчаные пляжи делают Хургаду настоящим раем для кайтсерферов.

Elevate your look at MenSpire Singapore—the best barber crafting precision styles in a chic, modern space. Expect top-tier service and sharp results every time.

Офисная мебель https://officepro54.ru в Новосибирске купить недорого от производителя

hawaii riviera aqua park hurghada кайт станция : Кайт школа дети ветра: Открой мир кайтсерфинга вместе с нами!

область туризма Кайтсерфинг в Хургаде — это популярный вид активного отдыха, который привлекает множество туристов. Хургада славится своими пляжами и стабильными ветрами, что делает ее идеальным местом для кайтеров.

Эта статья сочетает познавательный и занимательный контент, что делает ее идеальной для любителей глубоких исследований. Мы рассмотрим увлекательные аспекты различных тем и предоставим вам новые знания, которые могут оказаться полезными в будущем.

Подробнее можно узнать тут – https://nakroklinikatest.ru/

Бездепозитные бонусы

египет кайтинг : detivetra: Одно слово, эхо юности, когда мир казался безграничным, как морской горизонт.

1000 рублей за регистрацию в казино без депозита вывод сразу

кейс защитный 1100 1000 410 http://plastcase.ru

кайт школа windfamily : Сертификат кайтсерфинг: Подтверди свои навыки!

I’m not sure exactly why but this weblog is loading very slow for me. Is anyone else having this issue or is it a problem on my end? I’ll check back later on and see if the problem still exists.

betwinner

защитный кейс купить https://plastcase.ru

кайт станции египет : Кайт школа в хургаде египет: Твой ключ к миру кайтсерфинга!

An outstanding share! I have just forwarded this onto a co-worker who was doing a little homework on this. And he in fact ordered me breakfast because I stumbled upon it for him… lol. So allow me to reword this…. Thank YOU for the meal!! But yeah, thanx for spending some time to talk about this issue here on your internet site.

бетвинер зеркало

Бездепозитные бонусы в казино

1000 рублей за регистрацию с выводом

сертификат кайтсерфинг : Кайт лагерь анапа: Отдых и обучение в одном флаконе!

сертификат кайтсерфинг iko : Кайт школа дети ветра: Открой мир кайтсерфинга вместе с нами!

Keep on writing, great job!

tadalafil aurobindo 5 mg

That’s a fascinating point about game volatility! Seeing how skill & luck blend in titles like Happy Fishing is really interesting – a unique take on the usual slot experience in Vietnam. Definitely worth checking out!

кайт школа спб : Кайт серфинг в египте: Насладись идеальными условиями для кайтсерфинга круглый год!

Бездепозитный бонус

получить 1000 рублей за регистрацию

купить отчет о практике стоимость отчета по практике

есть ли акулы в египте в октябре : Кайт сафари: Приключение, которое запомнится навсегда!

заказать отчет по учебной практике https://otchetbuhgalter.ru

карточка iko это : Кайт кемп: Интенсивное обучение для быстрого прогресса!

кайт школа windfamily Кайт школа в Хургаде: Профессиональное обучение кайтингу в Хургаде.

Бездепозитные бонусы в казино

фонтан казино бездепозитный бонус 1000 рублей за регистрацию без депозита с выводом денег

оформить микрозаем http://zajmy-onlajn.ru

кайт Кайт серфинг в Египте: Насладитесь кайтсерфингом в кристально чистых водах Красного моря.

займ онлайн мгновенно https://zajmy-onlajn.ru

Hi Dear, are you actually visiting this website daily, if so after that you will without doubt take good knowledge.

punta cana airport to hard rock hotel

лучший хлеб ташкент Хлеб на Закваске: Возрождение Традиций Хлеб на закваске – это древний способ приготовления хлеба, который в последние годы переживает возрождение.

газель с пирамидой алматы Грузоперевозки в Алматы – это качественный и оперативный сервис, который предлагает широкий выбор автомобилей, в том числе и газелей, для решения различных задач. Если вам необходимо перевезти мебель, бытовую технику или строительные материалы, наши услуги газели в Алматы помогут вам осуществить это быстро и надежно. Мы предлагаем аренду газелей различной грузоподъемности, включая короткие и длинные модели, а также специальное оборудование, например, термобудки и рефрижераторы для транспортировки чувствительных грузов. Вы можете заказать газель с грузчиками для удобного переезда, будь то офисный или квартирный. Наша команда профессиональных грузчиков обеспечит аккуратную упаковку, разборку и сборку мебели, а также позаботится о безопасной перевозке ваших вещей. В Алматы мы работаем круглосуточно, предоставляя возможность вызвать газель в любое время суток. Цены на грузоперевозки в Алматыvarьируются в зависимости от расстояния и объема работ, но мы всегда готовы предложить конкурентные расценки и специальные скидки для постоянных клиентов. Для срочных заказов мы предоставляем услуги быстрого реагирования, чтобы вы не переживали о задержках. Не упустите возможность воспользоваться самым удобным и экономичным способом перевозки в Алматы. Свяжитесь с нами по телефону или через WhatsApp, чтобы обсудить детали вашего заказа. Обращайтесь за надежной газелью в Алматы и убедитесь сами в качестве наших услуг!

Новинки кино 2025 бесплатно Фильмы без рекламы бесплатно: Способы смотреть любимое кино, не платя за отсутствие рекламы.

уплотнитель двери посудомоечной машины алматы Квалифицированный мастер обладает необходимыми знаниями и опытом для диагностики и устранения любых неисправностей посудомоечных машин. Он оперативно определит причину поломки и предложит оптимальное решение. Сервис посудомоечных машин Алматы

ремонт холодильников самал алматы : Починка морозилки – это быстрое и эффективное устранение поломки, которое позволяет избежать порчи продуктов. ремонт морозильного ларя алматы

Discover the best barbershop experience in the CBD: MenSpire blends contemporary flair with traditional craftsmanship. Friendly pros, clean ambiance—your style, redefined.

Бездепозитный бонус в казино

люкс детская одежда Рынок Садовод является одним из крупнейших оптовых рынков в России, где можно найти широкий ассортимент детской одежды, в том числе и реплики Zara Kids. Однако, при покупке на Садоводе важно быть внимательным и выбирать проверенных поставщиков. Опт Zara

плотник алатауский район Стоимость услуг электрика в Алматы варьируется в зависимости от сложности работ, используемых материалов и квалификации мастера. Перед вызовом специалиста рекомендуется уточнить расценки и сравнить предложения нескольких компаний. Электрик Алматы Недорого

варфейс акк Магазин аккаунтов Warface предлагает широкий выбор аккаунтов различных уровней и с различной экипировкой.

mines game strategy

шторы ночь Карниз для штор – это надежная опора, на которой держится вся шторная композиция. Важно выбрать карниз, который будет соответствовать стилю штор и выдерживать их вес. Римские шторы

Маска для снорклинга Существует множество видов акул, отличающихся по размеру, форме и образу жизни. Нападение акулы на человека

Чек стоп Дайвинг в Москве – это возможность заниматься дайвингом в бассейнах и озерах, не выезжая из города. Дайвер спасатель

Жак Ив Кусто Реестр нападения акул на человека – это база данных, содержащая информацию о зарегистрированных случаях нападения акул на людей. Дайвинг в Москве

For most recent news you have to pay a quick visit world wide web and on web I found this web page as a best web page for most up-to-date updates.

tadalafil pensa 5 mg

заказать отчет по практике срочно сделать отчет по практике на заказ

личный займ онлайн zajmy-onlajn.ru/

Маска для дайвинга Запуск маркерного буя – это навык, позволяющий дайверу обозначить свое местоположение на поверхности воды. Виды маркерных буев дайвера

шторы день ночь Потолочные шторы – это стильное и современное решение, которое визуально увеличивает высоту потолков. Как правильно шторы

warface аккаунт Приобретение нового оружия в Warface – это возможность расширить свой арсенал, улучшить свою статистику и адаптироваться к различным игровым ситуациям. Аккаунты Warface

ссылка на фишинговый сайт Определить, какой сайт фишинговый, можно путем внимательного анализа его URL-адреса, дизайна, контента и других характеристик, указывающих на его поддельность. Признаки фишинговых сайтов

Натяжные потолки Развилка Фото натяжных потолков – это отличный способ выбрать подходящий дизайн и оценить возможности этой технологии. Фотографии демонстрируют разнообразие цветов, фактур и конструкций натяжных потолков, позволяя подобрать оптимальное решение для любого интерьера. Натяжные потолки можно

фонтан казино бездепозитный бонус 1000 рублей за регистрацию без депозита с выводом денег Бездепозитный бонус в размере 1000 рублей с моментальным выводом – это редкая и ценная находка для азартных игроков. Она позволяет начать игру, не вкладывая собственные средства, и сразу же вывести выигрыш, если повезет. 1000 рублей за регистрацию вывод сразу без вложений

рулонные шторы купить Шторы своими руками – это возможность создать уникальный и неповторимый элемент интерьера. Установка штор

Какой натяжной потолок В Развилке натяжные потолки – это популярный выбор для тех, кто ценит качество и стиль. Натяжные потолки Островцы

аренда автомобилей краснодар аренда машины в краснодаре: Забудьте о пробках и общественном транспорте, арендуйте машину! Путешествуйте с комфортом и независимостью.

варфейс Акк Warface – это ваш цифровой идентификатор в мире Warface, отражающий ваш прогресс и достижения. Варфейс

Прокат авто без залога авто в аренду краснодар: Наслаждайтесь комфортом и свободой передвижения по Краснодару. Арендуйте автомобиль у нас и получите незабываемые впечатления от поездки!

Потолки помещений Жители Красково выбирают натяжные потолки за их практичность, долговечность и эстетичный внешний вид. Натяжные потолки Томилино

вавада казино официальный сайт рабочее зеркало на сегодня Вавада Казино Официальный Сайт Вход

Увлажнитель воздуха https://brand-climat.ru оптимальный уровень влажности для здоровья. Различные типы: ультразвуковые, паровые и др., фильтрация и защита. Подбор, доставка по России и официальная гарантия для вашего комфорта.

Ремонт бампера автомобиля — это популярная услуга, которая позволяет вернуть заводской вид транспортного средства после небольших повреждений. Новейшие технологии позволяют исправить сколы, трещины и вмятины без полной замены детали. При выборе между ремонтом или заменой бампера [url=https://telegra.ph/Remont-ili-zamena-bampera-05-22]https://telegra.ph/Remont-ili-zamena-bampera-05-22[/url] важно рассматривать уровень повреждений и экономическую целесообразность. Профессиональное восстановление включает подготовку, грунтовку и покраску.

Установка нового бампера требуется при значительных повреждениях, когда восстановление бамперов невыгоден или невозможен. Стоимость восстановления зависит от типа материала изделия, степени повреждений и марки автомобиля. Полимерные элементы допускают ремонту лучше металлических, а новые композитные материалы требуют специального оборудования. Качественный ремонт расширяет срок службы детали и сохраняет заводскую геометрию кузова.

Я с готовностью быть на подхвате по вопросам Ремонт бамперов в магнитогорске адреса и цены – обращайтесь в Телеграм sgf81

Hey I know this is off topic but I was wondering if you knew of any widgets I could add to my blog that automatically tweet my newest twitter updates. I’ve been looking for a plug-in like this for quite some time and was hoping maybe you would have some experience with something like this. Please let me know if you run into anything. I truly enjoy reading your blog and I look forward to your new updates.

tadalafil pensa pharma 5 mg

Interesting read! The focus on culturally relevant tech, like what 68wim.tech is doing, is key for long-term player engagement. Seamless logins & a great 68win app download are huge wins for user experience, too. Solid platform!

Каждая выездная бригада укомплектована портативным лабораторным оборудованием для экспресс-анализов крови и мочи, современными инфузионными насосами и средствами телеметрии. Это позволяет врачу контролировать жизненно важные параметры пациента в режиме реального времени и корректировать схему детоксикации на месте.

Детальнее – [url=https://narkologicheskaya-klinika-tyumen10.ru/]частная наркологическая клиника в тюмени[/url]

Школа Саморазвития https://bznaniy.ru онлайн-база знаний для тех, кто хочет понять себя, улучшить мышление, прокачать навыки и выйти на новый уровень жизни.

Бездепозитный бонус Казино, предлагающие бездепозитные бонусы, как гостеприимные хозяева, распахивают двери перед новичками и предлагают им оценить все прелести своего заведения. Это своеобразный жест доброй воли, который позволяет завоевать доверие игроков и превратить их в постоянных клиентов. Это умный маркетинговый ход, который работает в пользу обеих сторон. Бездепозитный бонус

На дом выезжает квалифицированный врач, который проводит процедуру детоксикации в комфортных условиях, позволяя пациенту избежать стресса и огласки. С помощью капельницы и медикаментов нормализуется состояние, восстанавливаются основные функции организма. Процедура длится несколько часов, после чего врач оставляет рекомендации по поддерживающему лечению.

Узнать больше – https://vyvod-iz-zapoya-lyubertsy2.ru

Для детоксикации и восстановления организма после запоя используются только сертифицированные лекарственные препараты с доказанной эффективностью и безопасностью:

Ознакомиться с деталями – http://narcolog-na-dom-sochi0.ru

Все вызовы фиксируются под кодовым номером без указания ФИО, что обеспечивает полную конфиденциальность каждого пациента.