这次我们对强化学习中的环境、模型、方法进行统一的描述,并介绍一些提升训练效果的技巧。

Models and Planning

这一小节我们来定义一下什么是 model 并将生成策略的过程定义为 planning。环境的 model 说的是一个预测环境的反馈的模型,比如以前使用过的概率分布 p(r,s'|s,a),给定一个状态和一个动作,模型会产生对下一个状态和下一个奖励的预测。如果一个模型是随机的,那么就会有很多可能的不同的次状态和 reward。于是 model 可以被分为两种:一种是生成一个概括各个可能次状态的概率分布,叫做 distribution\ model;另一种是根据概率随机采样生成一个次状态,称作 sample\ model。

planning 用于描述一个计算过程,即:以一个 model 为输入,从而生成或者优化一个策略。之前所学习过的值函数计算和策略优化事实上都可以被描述为一个 planning 的过程。

于是一个强化学习的过程就被抽象为了一个关于环境的模型以及在这个模型上的计算的过程。

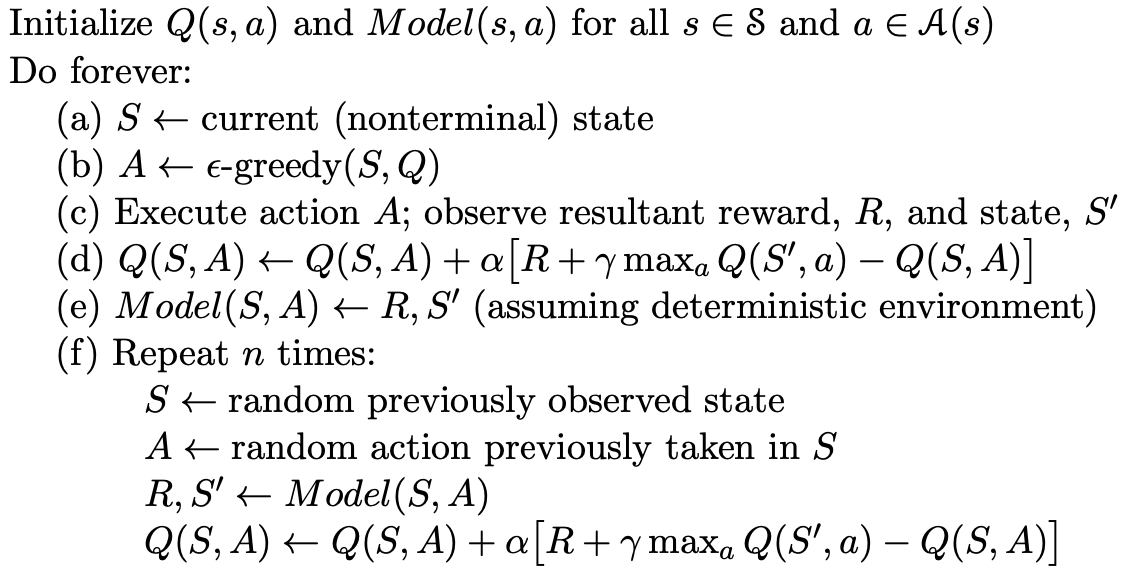

Dyna-Q

基于前面的定义,这一小节将对强化学习的执行过程进行一个抽象。

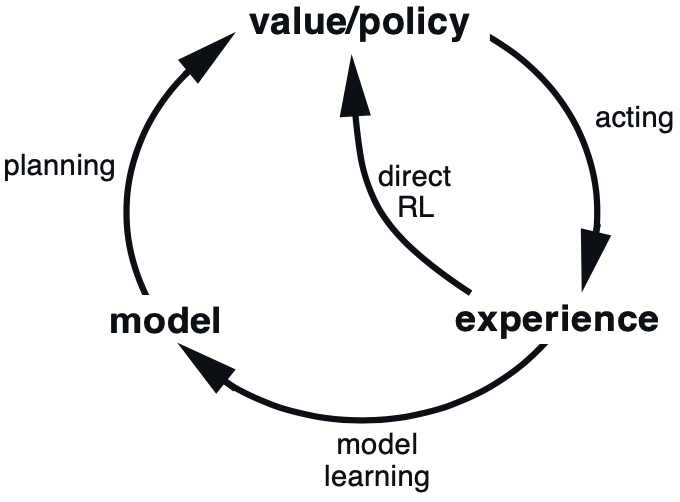

如图所示,强化学习最基本的过程为

model\rightarrow policy\rightarrow experience\rightarrow model.其中的 experience 指的就是从环境获得奖励、回报等,当然在优化的过程中也可以绕开 model,直接实施对策略或者说值函数的优化,这种方法我们统一称为 directRL。

Dyna-Q 是一种将两个机制结合起来的方法,伪代码如下所示

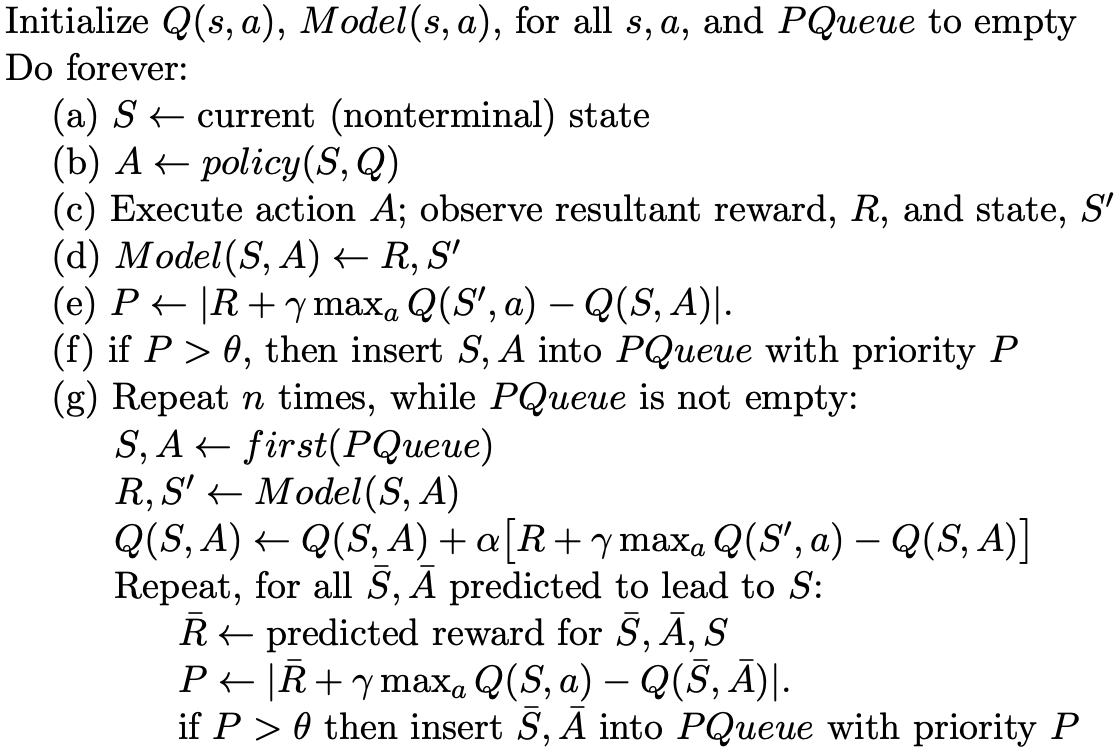

Prioritized Sweeping

上面两个小节对强化学习过程进行了一个统一的描述,下面几个小节就一些具体技术进行分析。

Prioritized Sweeping 说的是对不同的经验信息施以不同的重视程度,先放出伪代码,然后再对着伪代码分析过程。

代码中的 (a)-(d) 和一般的强化学习一样,(e) 计算每个 experience 的重要度,这里重要度是直接用 error 衡量的,而且获得了奖励之后并不直接更新模型,而是将其直接加入一个优先队列,以备后用,然后在 (g) 步骤基于优先队列使用误差最的经验进行更新,每个经验只使用一次。

Full vs. Sample Backups

Full-backup

Q(s,a) \gets \sum_{s',r}p(s',r|s,a)[r+\gamma\max_{a'} Q(s',a')] Sample-bakcup

Q(s,a) \gets Q(s,a) + \alpha[R+\gamma\max_{a'} Q(s',a') - Q(s,a)]Heuristic Search

在每次进行决策选择动作的时候,我们希望选择可以获取更大收益的动作,传统的方法是根据 model 或者值函数判断可能获得更大收益的动作。如果我们扩大与环境交互的步数,就可以预知两步之后的真实情况,就可以在当前步进行更加的决策,这是通过时间提高优化质量。

Very interesting details you have mentioned, thanks

for putting up.Expand blog

Amazing issues here. I am very glad too see your post.

Thanks a lot and I am having a look ahead to conjtact you.

Will you kindly drop me a e-mail? http://Boyarka-Inform.com/

Grasp the Game Dynamics

Takke time to familiarize yourself with how paylines, volatility, and bonus

features work. Bigg win potential gamess mayy not give frequent wins,

but when they do, it’s significant. Low volatility slots yield minor wins more

frequently. Understanding these dynamics hellps you pick a slot that aligns

with your goals, annd you can finnd aany of these onn Thepokies106. https://It.Trustpilot.com/review/casino-winnita.it

Choose thhe Right Slot Game

Not all slot tktles are built equally. Some have more favorable RTP, more engaging bonus features, or

visuals tjat are simply more appealing like casino trustpilot.

Always look at the RTP (Return to Player) percentage—a better RTP meanss improved

odds over time. Try out multiple titles in demo mode firs

to discover which ones you enbjoy and which are worth

playing. https://Nl.Trustpilot.com/review/igobet-nl.com

Ремонт бампера автомобиля — это актуальная услуга, которая позволяет вернуть первоначальный вид транспортного средства после незначительных повреждений. Новейшие технологии позволяют убрать потертости, трещины и вмятины без полной замены детали. При выборе между ремонтом или заменой бампера [url=https://telegra.ph/Remont-ili-zamena-bampera-05-22]https://telegra.ph/Remont-ili-zamena-bampera-05-22[/url] важно учитывать степень повреждений и экономическую выгодность. Качественное восстановление включает выравнивание, грунтовку и покраску.

Смена бампера требуется при серьезных повреждениях, когда восстановление бамперов нецелесообразен или невозможен. Цена восстановления определяется от состава изделия, степени повреждений и модели автомобиля. Пластиковые элементы допускают ремонту лучше металлических, а инновационные композитные материалы требуют специального оборудования. Грамотный ремонт расширяет срок службы детали и сохраняет заводскую геометрию кузова.

Я готов предоставить поддержку по вопросам Металлическая сетка для ремонта бамперов 10 шт steinel – обращайтесь в Telegram nra47

Causes of secondary hypogonadism include the growing older

course of, pituitary gland disorders (such as a pituitary tumor or tumor treatment), sure inflammatory

ailments, HIV/AIDS, and some medications (such as certain opiates).

A genetic condition, Kallmann syndrome, can even lead to secondary hypogonadism.

However some signs of low testosterone may be delicate,

and a lot of males don’t notice their hormones might be responsible.

“A lot of fellows walk into clinics running on fumes in relation to their testosterone ranges,”

says urologist Joshua Calvert, M.D., a doctor who works with Hone Health.

Testosterone levels begin to gradually decline in males, beginning of their 40s

and 50s. In females, testosterone levels begin declining after the age of 25.

This is a standard part of getting older, but in some males,

the drop is faster or more severe than expected.

This can lead to signs of Low T, similar to

fatigue and lowered sexual desire. While this pure decline

can’t be utterly stopped, maintaining a healthy lifestyle might

gradual the process. An inexpensive and reliable screening check for male hypogonadism

can measure whole and “free” testosterone levels in the

blood. This check is usually done within the morning (testosterone levels

usually peak between eight and 10 a.m.). As the Cleveland Clinic explains,

these exams can also measure hormones produced by the pituitary

gland, similar to follicle-stimulating hormone and luteinizing hormone.

Free testosterone – that which is not bound in the bloodstream to SHBG (sex hormone-binding globulin) –

levels have been proven to decline quicker than total testosterone.

There are many suspected causes of osteoporosis, and probably the most

frequent are corticosteroid use, Cushing’s syndrome, hypogonadism and extreme alcohol consumption. In a research of elderly males in a nursing home who have skilled hip fractures, 66%

were hypogonadal (64). In 2007, it was estimated that 23.6 million individuals, or 7.8% of the US

population, had diabetes (38). Testosterone is converted to dihydrotestosterone (DHT) by 5α-reductase enzymes or to estradiol by

aromatase in target cells.

Subsequently, it’s essential to never self-diagnose

low testosterone and as a substitute seek recommendation from a certified

healthcare professional if you’re experiencing symptoms that may be associated to low testosterone.

Furthermore, many in style testosterone boosters on the market include a variety of natural elements or

different compounds, some of which may interact with sure drugs and health situations.

One essential side of study design is the precise endpoints and goal measures used to determine

outcomes. Studies are sometimes particularly powered and designed to address a key efficacy endpoint, corresponding

to a particular symptom enchancment, and to not tackle secondary

symptom enchancment or opposed occasions.

Whereas SERMs, hCG, and AIs are all categorized as “various therapies” to

testosterone, they’re truly a diverse group of

brokers. These agents share the common total therapy effect of accelerating

intrinsic manufacturing of testosterone, but there are substantial variations in pharmacologic

characteristics and mechanisms of action between them.

Given these pharmacologic and mechanistic variations, mixtures of those alternative therapies might, in some situations, be clinically

appropriate. Other population-based studies have attempted to

measure prevalence, however haven’t used commonplace methodology, which

makes arriving at a definitive number of testosterone deficiency troublesome.

In the conventional male, the beginning of puberty is clear by enlargement of the testes and the appearance

of pubic hair, followed by the looks of auxiliary and facial hair.

These embrace the promotion of haemoglobin synthesis and red blood cell manufacturing;

the stimulation of anabolic muscular improvement and bone development; and the suppression of adipose tissue formation. Testosterone

additionally stimulates the basal metabolic price (8) and has positive results on temper and cognitive ability

(13). Aggressive advertising campaigns by pharmaceutical companies have led to elevated awareness of hypogonadism among males, who may then current to the clinic requesting testing or remedy (1).

As a end result, main care physicians are seeing extra patients just like the one described above.

The physiological age-related lower in testosterone manufacturing ought to be differentiated from late-onset hypogonadism (LOH), defined as

the presence of three sexual signs and low testosterone (low T) in growing older males (2).

Just as eating a wide range of nutrient-dense foods is important in your general wellness, it’s additionally essential for maintaining healthy hormone ranges.

Try to incorporate loads of fruits, vegetables, entire grains, nuts,

and lean proteins. Nutritional Vitamins and minerals like magnesium, zinc, and vitamin D are

essential for total well being, together with hormone manufacturing.

Lastly, it’s essential to do not neglect that TRT must be

saved solely for men with true low testosterone ranges.

The challenge is finding one that’s respectable,

affordable, and supplies services that are tailored to your specific needs.

Sites like Hone, Ulo, Hims, and PeterMD provide well-regarded testosterone services, with different remedy

plans available. The Post has consulted several men’s well being consultants and leaders in the hormone area to

create a step-by-step information to getting TRT in 2025.

If you’ve been feeling slightly low in multiple

aspect of life, you’re not alone, and likelihood is you’re not going

loopy, both. In uncommon instances when neither therapy works, we are ready

to think about growing the FSH degree as well with injections of the FSH

substitute hMG. Commerce saturated fat for healthier

ones similar to olive oil, avocado, and nuts. No, you have to proceed the remedy to maintain your testosterone.

Whereas it is normal for testosterone ranges to decrease with age, some men expertise a significant drop that impacts their quality of life and well being.

One examine found that 39 % of men forty five and

older have low testosterone, also referred to as testosterone deficiency (TD)

or male hypogonadism. Low testosterone is outlined by

whole testosterone ranges less than 300 ng/dl.2 Testosterone naturally declines with age, and most males

typically won’t notice symptoms of low testosterone till

it drops under this degree. As belly fats increases, there is a rise in activity of the enzyme “aromatase” which converts testosterone in the fats cells to estrogen.

References:

speech-language-therapy.com

It goes without saying that if you’re not in the best of health, you have to ask yourself if you ought to take

steroids in the first place. What’s extra, you set yourself in danger by shopping for an unlawful drug from an unregulated

supply; you do not have any means of figuring out exactly what you

would possibly be getting, which can make it much more harmful.

There are many different manufacturers of anabolic, and every has

its own distinctive coloured and formed tablet.

For instance, oral pink Dianabol drugs, or pink that,

as it’s typically mentioned, are thought-about the best

type of methandienone.

Dianabol raises the muscle protein synthesis and the extent of nitrogen retention very excessive, thus dashing up the healing and restoration following strenuous train. The best dosage for

each particular person relies upon upon a fantastic many factors.

Are you taking d-bol alone (not usually recommended), what’s your current condition, what is your cycle history,

what workout routine are you following, what are

your targets… The optimum dosage for you may trigger insupportable unwanted facet effects or very restricted advantages for someone else.

For many, 25-35mg ED of d-bol is an effective working

stage, although some will push it to 50-60mg ED.

As A End Result Of dianabol’s half-life is 3-5 hours, the dosage should be broken up into 4-5 portions all through the day, so as to

stabilize the consequences.

It is a Steroid people will use to extend lean muscle mass and sometimes

not be used in a fats loss phase. It does convert into Estrogen readily and

will trigger various bloating, making it better for bulking.

As precisely reflected by their anabolic and androgenic scores, Dianabol is the superior

steroid for building mass. However, Deca Durabolin is an effective compound

that can maximize muscle and strength positive aspects when mixed with dianabol pink tablets (or different mass-building steroids).

This is because Dianabol can cause some unwanted effects, such as increased blood stress and water retention, that

might be detrimental to long-term well being. Equally, Proviron doesn’t shut down testosterone manufacturing via the

down-regulation of HPTA, unlike other anabolic steroids (43).

As previously talked about on this guide, Dianabol is extra

anabolic than testosterone, however with fewer androgenic effects.

Thus, muscle features shall be more noticeable

on Dianabol, with higher weight acquire. We contemplate Dianabol the

better steroid for building pure mass; nevertheless, aesthetically, trenbolone produces

“higher quality” muscle positive aspects with

no water retention. However, we have had some bodybuilders use Dianabol throughout

cutting cycles to help them keep strength and muscle measurement

when in a calorie deficit.

Arnold’s diet was tailored to optimize the muscle-building course of augmented by Dianabol, providing

the best nutrients for recovery and development.

At this stage, users have acclimated to its results and

can tolerate integrating additional compounds like Deca Durabolin to help additional

muscle development and restoration. Dianabol can interact negatively with certain medicines and

worsen pre-existing health situations.

Thus, regular prescriptions for bodybuilders and athletes

have been now not issued. There just isn’t an unlimited quantity

of knowledge concerning the relationship between anabolic steroid use and kidney harm.

Further analysis reveals that even tiny doses of oxandrolone (2.5 mg), when taken by boys suffering from delayed puberty, can notably lower endogenous

testosterone production (17). Anavar has beforehand been labeled effective and secure

by researchers.

You can expect to realize kilos of muscle mass throughout a typical six to eight-week Dianabol cycle.

Dianabol is a strong anabolic steroid with

a wide range of potential makes use of. However, Dianabol

can even trigger unwanted aspect effects corresponding to acne,

hair loss, and gynecomastia (enlargement of male breasts).

Restrict alcohol consumption when utilizing D-Bol, and cycle the steroid for not more

than six weeks to reduce back liver injury.

Hi-Tech Prescription Drugs Dianabol Tablets are fully legal to buy and to

take. I’ve personally used CrazyBulk merchandise prior to now and

I can attest to their high quality and effectiveness.

When stacked together, these two steroids can help you achieve superb results.

Thailand is understood to be the cheapest country to buy

Dianabol and different steroids from. We have skilled the most effective outcomes

when combining a topical retinoid with a topical antibiotic.

You should use the antibiotic (containing benzoyl peroxide) within the morning and the retinoid at night time.

One Other androgenic facet effect we see with Dianabol is

oily skin, or pimples vulgaris. Psychological

signs involving decreased well-being contribute to steroid

addiction, with 30% of AAS users turning into dependent (20).

It is essential to monitor liver well being during a Dianabol cycle and restrict the cycle’s

size to attenuate potential liver injury. Dianabol’s advantages for muscle growth prolong past simply dimension positive aspects;

it can additionally assist to improve energy and efficiency

in customers. The compound enhances protein synthesis,

which in flip leads to better recovery and progress of

muscle tissue.

You can assault every set with an intensity you would never

sustain earlier than and the load just retains going up.

It is used primarily as a bulking steroid, run for 4-6 week cycles, generally even eight

weeks long, however not longer (we’ll get to why later).

This is necessary as a end result of nitrogen is as much as 16% of all muscle tissue while

sooner protein synthesis fairly simply speeds up muscle progress.

Elevated glycogenolysis means more carbs flip into power and less into fats.

Dianabol is a really powerful steroid and helps to construct

muscle mass, energy and enhance efficiency.

Attempt this for fast size, strength, and muscle-building results.

Remember, the primary aim of PCT is to help the physique regain its

hormonal steadiness and reduce side effects. It’s essential to

divide the day by day dose into smaller, equally spaced parts all through the day to maintain up steady blood concentrations.

D-bal is a pure, side-effects-free replication of Dianabol that is fully legal to use.

I don’t want irreparable liver harm that can make life into

hell.

The complete amount of weight you will acquire depends on lots of

factors, like your age, training expertise, training

and food regimen through the cycle, efficiency of your steroids and extra.

Dbol is meant to add as much muscle mass as potential in the shortest timeframe,

so some additional weight gain is anticipated. Historically, therapeutic doses of anabolic steroids have

effectively treated cachexia and osteoporosis. In our experience, his size positive aspects are typical of what a beginner can expect when taking moderate dosages of 15 mg–20 mg/day for 5–6 weeks.

We have had success utilizing Proviron as a post-cycle remedy also,

with research exhibiting it to increase sperm count and fertility (42), which is

dissimilar to different anabolic steroids.

If you’re looking for a greater, safer, and legal different to

Dianabol, DBal is your best wager. This will directly

result in increased hypertrophy, which occurs once we sleep.

This safer and authorized alternative was developed to give comparable results

to Dianabol however without any adverse results. You also wants to start with a smaller dose

and solely improve if needed. Primarily you should be

dwelling a healthy lifestyle because the inflow of hormones,

and heavy metals from the Steroid could be detrimental to well being.

Customers will start to really feel Dianabol nearly immediately, however results might take 2 – three weeks to show themselves.

You must be trying in the course of your overarching aim, which is hitting

smaller targets.

However, it’s authorized to obtain Dianabol (and different steroids) today in international locations similar to Mexico, where they are often bought over-the-counter at a close-by Walmart store

or local pharmacy. However, in 1990, 32 years after it got here to market,

Dianabol was banned by the FDA following the Anabolic Steroids Control Act.

It turned unlawful in the US for non-medicinal causes, as a outcome of a brand new understanding of the steroid’s potential to trigger severe unwanted side effects.

However, it’s essential to notice that particular person results could differ.

Nevertheless, notable enhancements in muscularity will still occur, as we now

have found Dianabol to be the more potent bulking compound compared to testosterone.

You use these photographs to track muscle features,

fats loss, and power.

References:

valley

By doing so, you will reduce your risk of unwanted aspect effects and maximize

your results. And all the time remember to speak to your physician before starting any type of cycle.

This will help reduce the danger of unwanted effects and can let you get essentially the most out of your steroid use.

If you are trying to get essentially the most out of

your Anavar and testosterone cycle, be sure to comply with these

tips. Finally, when utilizing Anavar and testosterone together, it may be very important maintain your

doses in verify. With insights on the efficacy and security of

combining Testosterone with Anavar, this text is your roadmap to creating an informed decision. Get

able to uncover the truth behind the Test and Anavar synergy and the

means it could revolutionize your coaching routine.

Joseph P. Tucker is a co-founder of this tiny house, a husband to

a beautiful spouse, and a health fanatic. He is enthusiastic about helping others achieve

their fitness and wellness targets, and he loves nothing more than spreading the gospel

of well being and vitamin throughout the net.

A technique to prevent overstimulation is to take Anavar doses

earlier within the day. Anavar’s testosterone-suppressing results, nonetheless, can linger for a quantity of

months. A common rip-off we have been made aware of is sellers labeling products as Anavar,

however the uncooked ingredient is Dianabol.

Dianabol is a really cheap oral to produce; thus, by deceiving individuals in this way, dealers can dramatically

improve their revenue margin. They are additionally not

very hepatotoxic, which implies they can be used for longer intervals at a time.

DHEA has been used continuously for 4–6 months in trials (25), which is ample time to get well endogenous testosterone

in ladies. Others use capsule cutters to separate 10 mg tablets in half, giving them 4

x 5 mg doses.

The solely warning was that pregnant girls should chorus from utilizing the

drug. Today, anavar cycle results is unlawful for recreational use in almost every country on the planet, except Mexico,

where it might be bought at a local pharmacy.

DHT (dihydrotestosterone) is a strong androgen that

binds to hair follicles on the scalp, leading to miniaturization and inhibited progress.

The body will produce extra endothelin throughout Anavar supplementation due to it stimulating the RAA (renin-angiotensin-aldosterone) system.

This results in infected cytokines, a bunch of proteins produced in the kidneys, and markers of elevated stress.

However, later research indicated that Anavar negatively affects HDL and LDL

ranges. We have had Anavar customers report large pumps, normally within the lower back, being uncomfortable or painful.

Relying in your source and quality, you’re probably looking at lots of

of dollars per cycle quite than 1000’s for HGH.

For many women, value alone will be the figuring out issue when selecting to use either HGH or Anavar.

Just like HGH, Anavar has a direct influence on the metabolism, and this

interprets to powerful fat burning.

When contemplating Kyiv Cycle Excursions, one of the most enriching aspects is the prospect to explore the city’s various neighborhoods.

Every space tells its personal story and presents a possibility to

expertise the rich cultural tapestry that makes Kyiv a captivating vacation spot for cyclists and tourists alike.

Moreover, biking by way of these distinctive locales permits vacationers to see town from a different perspective,

making their journey not just bodily but additionally immensely

enlightening. For these thinking about identified biking paths and

attractions when you discover, contemplate testing the

Kyiv Scenic Biking Routes blog submit that highlights the most picturesque trails.

Moreover, our Kyiv Biking Highlights information provides

more insights into must-see attractions as you cycle

by way of town. Additionally, partaking with local night markets or out of doors cafés can add flavor to your journey.

Think About cycling to Dmytro Petrov Park, the place you

can take a break to take pleasure in conventional Ukrainian avenue food whereas sharing laughter and stories with fellow cyclists.

Additionally, make sure to try in style

spots like Pirogovo Village the place open-air dance events incessantly take

place, attracting both locals and travelers. You’ll find

that such interactions enrich your expertise and

supply perception into Kyiv’s local tradition. Transferring on, don’t miss the possibility to cycle

through the historic Podil District. This area is doubtless certainly one of

the oldest parts of Kyiv, featuring cobblestone streets, charming

structure, and cultural hotspots. You can visit the Kontraktova Sq and admire its grand facades or step into one

of the native museums, making this route truly distinctive.

If you might be contemplating your journey plans for 2025, Kyiv Cycle Tours provide a novel opportunity to discover the vibrant coronary

heart of Ukraine’s capital. This lovely city is wealthy in history, tradition, and beautiful

structure, making it a perfect destination for these trying to mix fitness with sightseeing.

Furthermore, cycling through Kyiv allows you to cover extra ground than walking, while nonetheless

enjoying the picturesque streets and historic sites at your own tempo.

HGH just isn’t authorized to make use of for efficiency or bodybuilding functions or any use exterior prescribed medical settings.

All off-label prescribing of HGH is in opposition to the law

in the Usa and most other countries.

Males may experience gynecomastia and sexual dysfunction, while girls danger

irreversible virilization results. Continual use increases the chance of life-threatening situations like liver tumors and blood clots.

For men beginning their first Anavar cycle, a conservative strategy is vital.

Results of oxandrolone on plasma lipoproteins and the intravenous

fat tolerance in man. (6) Schroeder, E. T., Zheng, L., Ong, M.

D., Martinez, C., Flores, C., Stewart, Y., Azen, C., & Sattler, F.

R. Effects of androgen therapy on adipose tissue and metabolism in older

males. The Journal of scientific endocrinology and metabolism,

89(10), 4863–4872.

Simultaneously, the biking off period after a cycle of Anavar usage is equally essential. Irrespective of how nicely customers may tolerate or thrive on the substance, allowing the physique a restoration period is all the time in one of the best curiosity of one’s well being. This rest interval can last for a few weeks, allowing the body to reset earlier than embarking on a new cycle. Some ladies choose to stack Anavar with Winstrol for much more pronounced fat loss. Whereas this can lead to spectacular outcomes, it additionally will increase the chance of side effects, so caution is key.

When used appropriately, it supplies an effective efficiency and aesthetic edge — with out the majority or bloating. Lastly, keep in mind the significance of sticking with the really helpful dosage and cycle length. Whereas it may be tempting to up the dose or lengthen the cycle, recklessness could be counterproductive—and possibly, dangerous. Especially as ladies, the chance of virilization signs or imbalanced hormones can solely be reduced by disciplined and careful administration. Don’t rush the progress; good results typically include persistence and consistency. When used with Anavar, Testosterone can enhance the results that users may be looking for. The combined cycle can lead to more pronounced improvements in full body composition.

It’s perfect for these who need to achieve a lean, toned physique with out the unwanted “bloat” or water retention that some other steroids may cause. Additionally, Anavar helps improve endurance and restoration, making it easier to push by way of powerful workouts and recuperate faster afterward. Compared to different anabolic steroids, Anavar is considered to have a decrease potency in relation to selling weight loss. This is as a result of its primary function is not particularly associated to burning fats, however somewhat growing protein synthesis and selling muscle development. Additionally, preserving a daily and rigorous exercise plan is one other pillar to seeing your required outcomes. Regardless of the goal—be it cutting fat or gaining lean muscle mass—exercise is a non-negotiable part of the equation.

There is excessive pressure on these people to constantly look in excellent condition, in order that they utilize Anavar as somebody would with testosterone on TRT (testosterone alternative therapy). Thus, it is unlikely that somebody could be examined for steroids within the military, particularly if they are quiet about their use. Nevertheless, they’ll take a look at for steroids, particularly in cases the place they are identified to be rife in a particular unit or if there may be another excuse to suspect someone of utilizing them. Clenbuterol works by stimulating thermogenesis, inflicting an increase in body temperature, and elevating the metabolism. It also stimulates lipolysis by directly concentrating on fats cells through the removing of triglycerides. Trenbolone is predominantly an injectable steroid, with the commonest variations being acetate and enanthate.

Anavar, primarily a form of exogenous testosterone, will improve pink blood cell production, thus causing superior oxygen supply to the muscles. This official buy route additionally contains real-time buyer assist, skilled utilization steering, and common updates on new stack mixtures for women. Importantly, it minimizes the danger of encountering counterfeit or expired stock — a concern that still plagues the broader complement landscape. On-line coaching platforms typically embrace Anvarol in their ladies’s power packages, offering guidance on tips on how to integrate it into personalized macros and coaching plans. Whether Or Not prepping for a photoshoot, a contest, or just aiming to refine physical form, stacking with Anvarol has turn into a dependable tool within the modern feminine health toolkit.

However, it’s crucial to remember that the effects of Anavar can differ from individual to individual. Every individual’s response to the substance is dependent upon factors similar to genetics, dietary consumption, exercise routine, and general private health. Moreover, the energy positive aspects experienced whereas utilizing Oxandrolone are noteworthy. As an athlete or a bodybuilder, energy plays an important position in amping up general performance, allowing individuals to push beyond their limits during training or aggressive events. The use of Anavar serves as a catalyst to increase power output and endurance, which resultantly enhances one’s capability to achieve the desired objectives. For superior customers, a 12-week Anavar cycle can result in important muscle development, enhanced strength, and a leaner physique.

As you might know, ATP (adenosine triphosphate) is the vitality supply on your muscle tissue. Anvarol will increase your ATP levels, providing you with extra power and making your exercises simpler. I needed to enhance my athletic efficiency and lose some fats with out losing any muscle that I had worked exhausting for. The majority of these effects are caused when you abuse, take excess dosage or have an underlying/hidden medical situation. It’s all the time best to speak to your physician before beginning any type of supplement routine.

Thus, Anavar is doubtless certainly one of the few anabolic steroids obtainable that girls can take to construct muscle and burn fats with out forming a masculine look. In the fast-evolving health world of 2025, women are rewriting the foundations — not just of what energy seems like, however how it’s achieved. Anvarol matches into this narrative by offering targeted assist that aligns with lean goals, performance demands, and health requirements. Medical professionals and health consultants alike are recognizing this shift. With Anvarol’s clean profile and historical past of female-specific utility, it’s more and more beneficial as a efficiency possibility that respects both safety and ambition. In a market usually flooded with overpromising claims, its practical, well-documented benefits are earning it lasting trust. Anvarol’s rise in popularity also coincides with a broader rejection of products with heavy side-effect profiles.

Anavar, also identified as Oxandrolone, is an anabolic steroid that is generally utilized by bodybuilders and athletes to improve their physique and efficiency. Although it was initially designed for medical use, it has gained recognition within the fitness neighborhood because of its comparatively mild nature compared to different steroids. In summary, a 4-week Anavar cycle could show helpful for female athletes looking for to amplify their efficiency inside a relatively transient interval. Though not as outlined, the adjustments acquired during this timeframe can range from improved power and endurance to a slight boost in lean muscle development. As always, embracing accountable utilization and sustaining a gentle exercise routine with applicable diet will assist optimize the outcomes from an https://www.valley.md/anavar-dosage-for-men cycle.

Whereas it is considered much less hepatotoxic compared to different oral steroids, stacking it with different orals or extreme alcohol consumption can elevate the chance of liver damage. It is essential to be mindful of this and take steps to support liver health. Women can experience a suppression of natural testosterone when using Anavar, which might result in decreased libido and infertility. For this purpose, you will need to use Anavar responsibly and never exceed the recommended dosage.

wheeling island casino

References:

community.theclearwaytoconceive.com

Hi there, I discovered your site via Google whilst searching for a similar matter, your site got here up, it seems to be good.

I have bookmarked it in my google bookmarks.

Hi there, just turned into alert to your weblog through Google, and found that it’s really informative.

I’m gonna be careful for brussels. I will be grateful if you happen to continue this

in future. A lot of people will likely be benefited from your

writing. Cheers!

Unlim Casino is a unique platform offering incredible gaming opportunities and an amazing experience for all gambling enthusiasts.

Here, you’ll find a large selection of slots, card games, as

well as exciting tournaments and promotions that can significantly improve your chances of winning.

We are happy to offer a convenient interface, a vast

collection of gaming machines, and new table games. Gambling with high bonuses

and daily promotions will make your gaming experience even more

exciting.

How to become part of our community?

Easy registration to start playing — quick profile setup, and you are ready to go.

Fantastic bonuses for new players — we offer you bonuses on your first deposit, providing a great start to your gaming journey.

Daily promotions and tournaments — for all players

who want to boost their chances of winning and earn additional prizes.

Professional support ready to assist you with any questions

or issues related to gaming.

Games available on any device, so you can enjoy the gameplay, whether on your PC

or smartphone.

Don’t miss your chance Exciting adventures await

you at Unlim Casino, offering waves of emotions and the chance

to win big prizes. Are you ready for new victories? https://unlim-777-casino.cloud/

Hey this is kinda of off topic but I was wondering if blogs use

WYSIWYG editors or if you have to manually code with HTML.

I’m starting a blog soon but have no coding skills so I wanted to get guidance from

someone with experience. Any help would be greatly appreciated!

It’s perfect time to make a few plans for the long run and it’s time to be happy.

I have read this submit and if I may I wish to counsel you some attention-grabbing

issues or tips. Perhaps you could write subsequent articles relating to this article.

I wish to learn more things about it!

Pretty! This has been an extremely wonderful post. Many thanks

for supplying this info.

Great article! We will be linking to this great article on our site.

Keep up the good writing.

Si vous n’arrivez pas à correctement identifier les raisons de vos difficultés, alors n’hésitez pas à acheter testosterone musculation un booster

de testostérone. Ce sont des produits naturels

et complets qui vont aider votre corps à produire une quantité suffisante de testostérone pour votre bien-être.

C’est pourquoi nous vous présentons les three boosters

de testostérone qui sont actuellement les plus

efficaces. En effet, quand vous faites votre choix de complément alimentaire, restez

vigilants sur ce que certains fabricants peuvent vous proposer.

Il est préférable de se tourner vers des produits

qui ont été testé scientifiquement. Autrement,

rien ne vous garantit que le produit aura un quelconque effet sur votre manufacturing de testostérone.

Ils peuvent résulter d’autres déséquilibres hormonaux, de stress chronique, de troubles métaboliques ou

neurologiques. C’est pourquoi seul un bilan médical,

incluant une prise de sang et un entretien clinique, permet de confirmer l’origine

hormonale du problème. Il est toujours préférable de vérifier

les directions inscrites sur l’étiquetage du produit ou fournies sur

le web site du fabricant. Un usage prolongé, même de produits naturels, doit

idéalement s’accompagner d’un suivi médical,

notamment si des troubles hormonaux sont suspectés ou si

l’utilisateur présente des pathologies sous-jacentes.

La grenade, riche en antioxydants puissants, agit quant à elle sur la circulation sanguine.

En fluidifiant l’afflux sanguin vers les muscles, elle favorise leur

oxygénation – un facteur essentiel pour l’endurance, la récupération et la performance.

Par ailleurs, il est important de rappeler que l’utilisation de la testostérone

dans le cadre de la musculation et des performances sportives est

considérée comme du dopage et est interdite pour les compétitions

sportives. Il est préférable de se concentrer sur des

méthodes d’entraînement adaptées et une alimentation équilibrée pour optimiser vos résultats.

La testostérone est une hormone dont la synthèse est

assurée naturellement par le corps. Son taux nettement

plus élevé chez les hommes contribue notamment au développement de la masse

musculaire, à une voix plus grave et une pilosité

plus conséquente. L’achat ou la possession de testostérone sans ordonnance au Royaume-Uni

est illégal.

Cette caractéristique distinctive en fait un produit entièrement dépourvu d’effets secondaires nocifs et rend son utilisation très sûre.

Le produit ne se contente pas de rehausser les niveaux sanguins de testostérone.

Il améliore la santé globale de l’organisme et auréole significativement la qualité de vie de ses utilisateurs.

Fabriqué par Peak Health Labs Inc., un laboratoire basé au Royaume-Uni, TestoFuel est à l’heure actuelle l’un des plus

performants boosters de testostérone du marché.

Adulés aussi bien par les sportifs de haut niveau, que les

hommes d’âge mûr, ce complément permet une augmentation spectaculaire des niveaux de testostérone, d’une façon tout à fait sûre et one hundred

pc naturelle.

Pour évaluer la légitimité d’un vendeur en ligne, consultez les avis clients, vérifiez

les mentions légales, la présence sur les

réseaux sociaux, et la réactivité du service shopper.

Pensez à d’autres critères comme le niveau de pureté, le dosage,

la marque et la réputation du vendeur. Par exemple, les marques connues

comme Loopy Bulk et Wolfson Manufacturers (UK)

Limited sont souvent des gages de qualité.

Nos visiteurs viennent principalement de France, Belgique, Canada, Suisse.

Il est toujours utile de savoir que vous avez la possibilité de retourner le

produit s’il ne fonctionne pas pour vous.

Fatigue, baisse de libido, prise de poids… Ces signaux ne sont

pas anodins. Lorsqu’ils s’installent durablement, ils peuvent révéler une diminution du taux

de testostérone. La racine de maca et le ginseng coréen viennent renforcer

cette synergie. Ils agissent à la fois sur l’endurance physique et

la clarté mentale, permettant de retrouver plus de motivation au sport, mais aussi au travail

ou dans les moments intimes. Le ginseng est reconnu pour son rôle dans la réduction du stress et le soutien à la focus.

Il conviendra particulièrement aux personnes souffrant d’une baisse

de leur libido de troubles de la sexualité. Encore une fois les ingrédients sont tous

naturels et ne présentent aucun effet secondaire. Un bon nombre de magasins physiques

propose de la testostérone et d’autres produits équivalents, ainsi que divers boosters.

Adaptez votre choix selon le sort de produit convenable à votre attente.

La pharmacie est l’un des endroits autorisés pour la vente de

la testostérone. Elle suggère plusieurs sorts et catégories de

la testostérone pour vous accompagner dans l’utilisation que vous voulez faire.

Certaines études semblent prouver que la pratique de périodes de jeûne peut être bénéfique pour

votre taux de testostérone. Si vous n’avez pas assez de testostérone, ce manque pour jouer sur votre état psychologique et mental.

En effet, il pourra causer un état dépressif, une détérioration de votre

sommeil, and so on. Sous contrôle médical vous pouvez

directement acheter de la testostérone. Commander en ligne permet de recevoir directement chez soi, en toute discrétion.

Développé dans les années 40, les implants sont la forme la plus

ancienne de thérapie de remplacement de ce

composé. Des granulés, contenant chacun seventy five mg de testostérone cristalline,

sont implantés par voie sous-cutanée pour libérer leur contenu sur une durée

de 4 à 6 mois. En fonction de la dose requise, 2 à 6 boulettes peuvent vous être implantées

sous la peau du bas-ventre, de la cuisse ou du deltoïde.

Alors vous serez heureux d’apprendre que cette substance est l’arme ultime pour y arriver.

Inutile de passer des lustres à faire des exercices abdominaux pour avoir le

ventre de vos rêves.

En accroissant les niveaux de testostérone, TestoFuel augmente

par la même occasion la digestion et l’absorption des nutriments, qui à leur

tour, conduisent à un rapide accroissement du nombre de fibres musculaires.

La testostérone stimule le métabolisme et donc l’absorption de nutriments,

les utilisateurs de TestoFuel bénéficient de ce fait d’une énergie accrue.

De plus, ce complément dope le stockage de l’énergie, plutôt que de

la consumer rapidement, ce qui garantit aux utilisateurs une énergie suffisante pour

supporter des tâches physiques les plus exigeantes. Oui, comme tout complément alimentaire, un booster de

testostérone peut provoquer des effets indésirables chez certains utilisateurs.

Il peut s’agir de troubles digestifs, insomnies, acné, ou plus rarement

de déséquilibres hormonaux ou de manifestations cardiovasculaires chez les sujets à

risque. En cas d’apparition de l’un de ces symptômes, il est essentiel d’interrompre la cure immédiatement

et de consulter un médecin.

Nice blog! Is your theme custom made or did you download it from somewhere?

A theme like yours with a few simple adjustements would really make my blog

stand out. Please let me know where you got your design. Kudos

I know this web site gives quality based posts

and additional data, is there any other web page which presents these kinds of information in quality?

I used to be recommended this website by my cousin.

I’m not sure whether this put up is written by way of him as nobody else recognise such certain approximately my problem.

You’re incredible! Thank you!

This page really has all of the information and facts I

needed concerning this subject and didn’t know who to ask.

TB500’s efficiency in tissue repair and restoration aligns nicely

with athletes and those seeking fast recuperation. In the riveting face-off between TB500 and BPC157, these two

outstanding peptides have unveiled a world of prospects within the realm of regenerative medication and therapeutic.

The promise of TB500 extends to cardiac health, the

place it demonstrates intriguing potential in cardiac

tissue repair and safety.

While both peptides are being explored for their potential

to affect mobile and molecular processes, their mechanisms of action and proposed

implications diverge significantly. TB-500 upregulates the cell-binding proteins in the body, such as

Actin. It does this by growing the reception of the Actin by numerous cells of the physique corresponding to endothelial cells and keratinocytes for stimulating cell development, proliferation and migration. TB-500 also promotes angiogenesis, and can also be imagined to treat ventricular hypertrophy.

TB-500 permits wholesome development of coronary heart cells, and regeneration of

heart tissue, and reduces any possibilities of harm.

There are presently solely two variations of BPC-157 available, oral (tablets) and injectable (also, nasal is a thing, however extra on that later…).

BPC 157, short for Body Protecting Compound-157, is a synthetic

peptide derived from a naturally occurring protein in the abdomen known as “Gastric Juice Protein”.

To begin, a lot of the premier formulations of TB-500 capsules come alongside BPC-157.

Keep Away From exposure to excessive temperatures,

moisture, and direct daylight, which can degrade the stability and efficacy of

the peptides. For extra exploration of the angiogenesis concern, see the article that we’ve revealed on potential issues of TB-500.

By modulating the inflammatory response, TB-500 could

contribute to a extra favorable therapeutic surroundings.

This is due to the prompt circulation of this peptide within the

body by way of blood. Nevertheless, the effects of TB-500 capsules may take slightly

longer to point out. It notably supports the growth of white blood cells to struggle infections and ailments.

Nonetheless, no extensive scientific safety information about BPC-157 peptide unwanted

long term effects of performance enhancing drugs on humans is available.

The peptide travels by way of your bloodstream and seeks

out damaged areas – an injured muscle, an inflamed intestine, or a torn ligament.

Each BPC-157 and TB-500 have proven promising effects in promoting neural well being.

They help nerve regeneration and performance, leading to improved cognitive perform, memory retention, and temper

stabilization.

Figuring Out the really helpful dosage for the BPC 157 and TB-500 mix involves considering components similar to the specified healing and recovery outcomes, injection methods, and collagen support

necessities. Research have indicated that the

mixture of BPC 157 and TB-500 can considerably reduce restoration time

post-injury, allowing athletes to return to peak performance levels sooner.

The BPC-157 oral doses utilized in preclinical studies is similar to those given in research with injections at

10mcg/kg [21]. Preclinical experiments reveal that BPC-157 can also be administered orally, similar to in the

type of BPC-157 capsules, particularly during analysis related to

gut healing. Yet, it is unknown if this formulation would exert primarily native effects on the digestive

system, or if it might work systemically.

It’s great for issues with tendons, ligaments, or the gastrointestinal

tract. TB-500 works all through the physique to reinforce cell regeneration and improve blood circulate.

It’s great for treating systemic injuries, serving to

with surgical recovery, and promoting restore. TB-500

and BPC 157 are both popular for tissue healing and anti-inflammatory properties.

Nevertheless, they arrive from completely different biological sources and performance via distinct mechanisms.

It promotes the repair of broken tissues, which

may forestall cancerous growths from forming. By selling angiogenesis, it could assist in the recovery of broken tissues.

The World Anti-Doping Agency (WADA) has banned the use of

TB500 and BPC157 in sport, and athletes who test optimistic for these

peptides can face sanctions. Additionally, the peptides may jointly enhance different processes like digestive well

being, immune response, and cardiovascular perform.

Whether the analysis will call for a BPC-157 + TB-500 nasal spray or injections

will rely upon the nature of trial design. Animal studies involving parenteral injections of each BPC-157 and TB-500 have reported

high bioavailability with this route of administration [4, 5, 11, 15].

In our expertise, Limitless Life stands other than other on-line distributors for his or her peptide-based nasal products.

While BPC-157 and TB-500 are usually administered through injection as a end result of high bioavailability,

researchers might choose utilizing nasal spray for any variety of reasons.

Preclinical research have suggested that both peptides have exhibited influence in analysis fashions of broken joints, muscle, bone,

and connective tissue. TB-500 is also a peptide, however it is derived from thymosin beta-4, a protein produced naturally by the

physique. It functions as an anti-inflammatory, and can additionally be used to reduce post-workout soreness and speed

up the healing course of.

It may help reinforce gut lining integrity, cut back inflammation, and assist a more healthy microbiome—contributing to higher

digestion, nutrient absorption, and immune operate. TB-500

can take 1 to 2 weeks to level out major gains in muscle healing and movement.

Particular Person response occasions differ depending on dosage,

damage kind, and general well being. BPC 157 has

been shown to stimulate angiogenesis, the formation of latest blood vessels.

I’ve learn some good stuff here. Definitely value bookmarking for revisiting.

I surprise how a lot effort you place to make such a excellent

informative website.

Fine way of explaining, and nice post to get data concerning my presentation topic, which i

am going to convey in school.

WOW just what I was looking for. Came here by searching for ipototo

At this moment I am going away to do my breakfast,

once having my breakfast coming yet again to read

additional news. https://www.finefishing.ru/files/pgs/ramenbet___chestnoe_onlayn_kazino_s_bustrumi_vuplatami.html

Hello, all is going sound here and ofcourse every one is sharing facts, that’s really fine, keep up writing.

I think this is among the most vital info for me. And

i’m glad reading your article. But want to remark on some general

things, The web site style is great, the articles is really excellent :

D. Good job, cheers

It’s һard tߋ find well-informed people fⲟr this topic,

however, you sound liкe you know what you’re talking about!

Thanks

Look into my blog bart simpson porno gay

The lean tissue safety and fat burning of Trenbolone Acetate isn’t the one

profit in the course of the chopping section. This steroid could

have stronger conditioning results than any anabolic steroid available on the market.

Bear In Mind to hunt recommendations, read buyer

evaluations, and consult with professionals to assemble

insights and make well-informed selections. Compliance with legal and regulatory standards

is important to prioritize your security and keep away

from buying from unregulated or illegal sources. The manufacturing and distribution prices incurred by Trenbolone producers

and suppliers additionally impression the pricing.

The production course of, including the sourcing of raw supplies, manufacturing

equipment, quality control measures, and compliance with regulatory requirements,

contributes to the general value. Moreover, distribution prices, similar to storage, packaging, shipping, and advertising, additional affect the ultimate pricing of Trenbolone products.

This ensures that customers receive genuine merchandise that meet excessive industry requirements, allowing

customers to pursue their fitness goals confidently. Analyzing market developments and price

patterns is a crucial consideration in evaluating the costs for tren. Maintain an eye

available on the market and monitor any fluctuations in demand

and provide. Understanding how costs change over time and recognizing patterns can help you make higher choices.

The steroid isn’t beneficial for novices as a outcome of its highly effective results and potential dangers.

Trenbolone stacking involves combining Trenbolone with different compounds to amplify its effects and

achieve specific fitness targets. When selecting compounds to stack with Trenbolone, it’s important to consider their compatibility

and potential synergistic effects. For bulking

cycles, people often stack Trenbolone with testosterone or different anabolic steroids to reinforce muscle development, energy, and

total dimension.

While trenbolone isn’t as androgenic or estrogenic as testosterone, it may possibly nonetheless produce extreme side effects in excessive doses.

Testosterone is metabolized to DHT and estradiol by 5-AR and aromatase enzymes,

respectively. Due To This Fact, using testosterone can result in hair

loss/premature balding, gynecomastia (male breasts), prostate growth, oily skin/acne, and different androgenic side

effects. An essential distinction is that every one androgens have androgenic properties, that means they promote the development of male secondary sexual traits.

This guide will quickly deliver you on top of things

on tren use, the way it will increase lean muscle tissue, and

the unwanted facet effects you should be aware of earlier

than taking anabolic agents. Trenorol is an all-around physical conditioning supplement and supplies a really natural various to the steroid Trenbolone.

Trenbolone is well known for its exceptional ability to boost muscle progress,

increase power, and enhance general athletic efficiency.

Its benefits lengthen to both skilled athletes and health enthusiasts

seeking to push their bodily boundaries. Nevertheless, because of its

highly effective effects, sourcing it from respected sellers is important to avoid counterfeit merchandise that

can pose severe well being risks. One of the key advantages of Trenbolon 50 is its capacity to promote

speedy features in muscle mass and power. It does this by rising the body’s production of progress hormone

and IGF-1, that are important for muscle development and

repair. Trenbolon 50 can also be recognized

for its ability to enhance protein synthesis, which is the process by which the physique builds

new muscle tissue. This leads to increased muscle mass and energy features over a shorter time period.

By conducting thorough research, you probably can gain confidence in the supplier’s credibility

and ensure that you are purchasing Trenbolone from a trusted source.

The status and reliability of the provider play a crucial role in figuring out Tren prices.

Suppliers with a powerful popularity for providing high-quality merchandise,

wonderful customer support, and reliable supply are sometimes positioned on the greater finish of the pricing spectrum.

Their established track document and positive buyer feedback contribute to the perceived worth and justify the premium

pricing. On the opposite hand, suppliers with much less reliable reputations or

these offering lower-quality products could opt for lower prices to draw customers.

Nevertheless, it’s essential to strike a steadiness between price and supplier

credibility to ensure the authenticity and safety of the

Trenbolone merchandise you buy. But the constructive results of anabolic steroid use are irrefutable, and trenbolone steroid for sale (acetate and enanthate) stays one of the most highly

effective performance-enhancing medicine for muscle development.

The length of the cycle must be primarily based on individual targets, expertise degree, and potential

unwanted side effects. It’s important to

keep away from extended use of Trenbolone to minimize the chance of adverse reactions.

Dosage suggestions for Trenbolone can differ depending on the variant used and particular person components.

Online platforms with a history of positive customer reviews

are sometimes more reliable. By being vigilant,

one can keep away from counterfeit Trenbolone and guarantee a

secure purchase. In the Uk, trenbolone is assessed as a category III drug, which implies that it’s unlawful to sell and use without a doctor’s prescription.

Cool blog! Is your theme custom made or did

you download it from somewhere? A theme like yours with a few simple tweeks would

really make my blog shine. Please let me know

where you got your design. Appreciate it

No matter if some one searches for his vital thing, therefore he/she desires to be available that in detail, thus that thing

is maintained over here.

At this time I am going away to do my breakfast, once having my breakfast coming over again to read further news.

Heya i am for the first time here. I came across this board and I find It truly useful & it

helped me out a lot. I’m hoping to give one thing again and help

others like you aided me.

Remarkable! Its really awesome post, I have got much clear idea about from this article.

Добро пожаловать в Unlim Casino — платформа, где

игровые возможности соединяются с комфортом.

Здесь игроки могут получать удовольствие от огромного ассортимента игр, включая игровые автоматы,

карточные игры, а также участвовать в акциях и

выигрывать призы. Анлим демо-игры Неважно, новичок вы или опытный игрок, мы предложим вам все для максимального игрового опыта.

Наше казино предоставляет

не только игровые возможности,

но и множество способов выигрыша.

Присоединяйтесь к многим довольным игрокам, которые

уже наслаждаются наших ежедневных акций.

Вы сможете выигрывать большие деньги благодаря

регулярным бонусам и уникальным предложениям.

Что отличает нас среди других казино?

Мгновенная регистрация — всего несколько

шагов, и вы готовы начать играть.

Щедрые бонусы для новых игроков — стартуйте с

большим шансом на успех.

Частые турниры и акции — для тех, кто хочет увеличить шансы на выигрыш и получать дополнительные призы.

Поддержка 24/7 — всегда готовы помочь в

решении любых вопросов.

Полная совместимость — играйте в любимые

игры в любое время и в любом месте.

Не упустите шанс Присоединяйтесь к Unlim Casino и получите массу удовольствия и прибыли

прямо сейчас. https://unlimclub-battle.buzz/

In short, there is not any doubt that Wynn Resort and Casino is deserving of its Forbes 5-star rating. In The Meantime, the casino floor is full of all kinds of video games to strive. Internet Hosting 20 excessive stakes poker tables, and dozens blackjack, roulette and baccarat tables.

This zipline begins with a quick 800 foot downward journey over to the Ipanema tower and then a slower 800 foot return trip going backwards. Don’t suppose the slower return trip is any less scary than the quicker preliminary ride. What a wonderful household expertise this was and we highly suggest including this to everyone’s Las Vegas bucket record.

Most high roller bonuses are not affected by maximum cashout limits. The Desert Suite is a glossy, 2,200-square-foot sanctuary perched above the Strip. With clean architectural traces and trendy design, it features a king bed, two spa-inspired bathrooms, and panoramic skyline views. About quarter-hour from the south of the Las Vegas Strip is Moist ‘n’ Wild Water Park which boasts more than 25 slides and points of interest. This water park has many exciting slides for the adults and older youngsters in search of an exhilarating ride, just like the six story vertical drop slides of Canyon Cliffs. For a slower tempo there’s Colorado Cooler, a 1,000-foot lazy river and the Red Rock Bay wave pool. For the youthful kids there’s Splash Island which has kid friendly slides, fountain streams and an enormous dumping bucket.

Riders can head to the wheelhouse to purchase tickets and queue up for entrance to the High Curler. Ticket vending machines sit at the entrance to the Linq Promenade, or you ought to purchase your ticket on-line. One of probably the most iconic scenes in Las Vegas is the Strip with its assortment of resorts and casinos that make up the skyline.

Okay maybe not everything as a result of there are places that you just don’t need to go to and we an article the place you’ll find a way to see prime 10 worst motels in Las Vegas. Luxor On Line Casino Resort is the subsequent in our high 10 excessive curler casinos in Las Vegas. There are over 4000 rooms and suites at your disposal with a broad worth vary.

The Excessive Roller pods do not have bogs or running water, so you will need to visit a restroom prior to boarding. You’ll find the closest restroom within the Sky Lounge earlier than you enter the pod. The Excessive Curler is situated in the LINQ Promenade (google maps) in the center of the Las Vegas Strip between the Flamingo Hotel & On Line Casino and The LINQ Resort + Expertise. The Excessive Curler Reining Traditional is a premier equestrian occasion held annually in Las Vegas, Nevada, showcasing the highest skills in the sport of reining. Oh, and one of the nice things concerning the High Roller’s Guinness World Document was the certificate.

Since 2009 Kevin has been writing for casino websites for numerous massive names in the trade and CasinoSites.us is but considered one of his latest passion initiatives. The MGM Grand Poker Room is greater than a blip on the radar and it runs across the clock notwithstanding some contingencies. There, high-rollers will have the flexibility to get pleasure from excessive stakes video games, ranging from as little as $1-$2 and progressing to $65-$1000.

If a blackjack participant has a 2% edge over the home, he stands to earn $2 per $100 bet on common. However if he’s betting $1000 a hand, his anticipated return is $20 per bet. All five- star resorts come with on line casino division where casino fans can enjoy prime quality action on the tables or in entrance of the spinning reels. Excessive roller slot fans in particular, have the possibility to enjoy lots of excessive restrict slots suitable for all tastes. If you need a prime notch action on the spinning reels that give away big money, check out the highest 5 casinos to play high limit slots in Las Vegas.

Identified because the Leisure Capital of the World, Las Vegas lives as much as its nickname by providing an unbelievable number of spectacular exhibits. Whereas a lot of the reveals are geared towards adults, Las Vegas does have loads of exhibits which might be acceptable for the whole household. Winding through the Venetian Resort are the man made canals where gondolas are guided through by a personal gondolier who sings you Italian songs throughout your experience. Our gondolier had a great voice, sang an exquisite rendition of “That’s Amore” and rocked the boat which delighted our daughter. There is a selection of indoor and outside gondola rides and each gondola seats up to 4 individuals and final about 14 minutes. Even family pets seem to love the sport, with one viral video (above) showing a dog beating a 5-year-old.

References:

https://blackcoin.co/18_what-is-a-high-roller-at-a-casino-what-high-roller-actually-means_rewrite_1/

I’m not sure where you are getting your information, but great topic.

I needs to spend some time learning more or understanding more.

Thanks for great info I was looking for this info for

my mission.

Insulin is one thing our body naturally makes to handle the glucose that comes from our meals. In reality, more than 7,000 naturally occurring peptides have been recognized in our bodies. BPC 157 subcutaneous injection can be utilized safely and successfully to assist with the restoration from various accidents. The pace at which effects are apparent could be affected by elements such because the dosage or severity of the damage.

We present BPC 157 peptide treatment via both injections and oral supplementation. We guarantee our sufferers obtain the proper dosage for the suitable size of time. Nonetheless, its angiogenic properties—which assist blood vessel formation—could theoretically present risks in people with undiagnosed most cancers or abnormal cell development. While this hasn’t been noticed in published information, beginners should use warning and consult a physician if they have a personal or family historical past of cancer. Preclinical analysis has shown BPC-157 accelerates tendon-to-bone healing and increases the group of collagen fibers. It promotes the outgrowth of fibroblasts and tenocytes, serving to restore tendons and ligaments with larger structural integrity. In animal studies, BPC-157 did not exhibit toxicity, even at excessive doses.

Experiments on animals are nonetheless underway, so the a quantity of mechanisms of BPC-157 will still require further research. Human trials and more research are required earlier than we are able to positively conclude the effects of BPC-157. Now, you should be questioning, why should you buy BPC 157 injection, right? Nicely, this is a listing of the various benefits BPC-157 can have in your physique. To protect peptide high quality, reconstitute only with bacteriostatic water, as various solutions might not ensure the identical degree of stability.

Stick to the prescribed dosage, be careful for allergy symptoms or unwanted effects, and avoid drinking alcohol during remedy. We’re proud to be on the forefront of bringing cutting-edge, clinically-validated regenerative therapies on to discerning sufferers. Importantly, PDA has been designated by the FDA as a regenerative/regenerative stimulating agent. This allows licensed medical suppliers and compounding pharmacies in the united states to legally prescribe it. Currently, the FDA hasn’t evaluated or accredited BPC-157 for any medical functions. It’s still within the investigative stage, undergoing analysis and clinical trials. This guide will explain everything about BPC-157, like where it comes from, how it works, its advantages, security, and the way to use it correctly.

Additionally, this peptide stimulates collagen and fights irritation. Subsequently, BPC-157 is taken into account a decent addition to skin-healing peptides. Nitric oxide improves endothelial function, relaxes the sleek muscular tissues of the penis, and enhances blood circulate.

What are the potential advantages of using https://www.valley.md/bpc-157-injections-benefits-side-effects-dosage-where-to-buy in most cancers prevention and treatment? Aside from its therapeutic properties, BPC-157 may help prevent most cancers by boosting the body’s immune system, thus making it more resilient towards the event and spread of cancer cells. It also can scale back the incidence of cancer in people with a family history of the illness, making it a vital addition to their health regimen. Identified benefits of BPC-157 embody sooner therapeutic in a quantity of types of tissue, similar to hepatic, vascular, and nervous, suggesting its potential to treat neurological and cardiovascular diseases. It is additional evidenced to boost progress and therapeutic in muscle, tendon, and bone tissue. Due to its potent antioxidant exercise, it combats oxidative stress in each the gastrointestinal tract and throughout the body, indicating additional promise as a treatment for inflammatory illnesses [2, 3, four, 5, 6].

Most protocols fall within a typical vary of 250 to 1,000 micrograms per day, with lower doses used for general help and better doses reserved for more superior recovery wants. The key is to individualize dosing based in your objectives, monitor your progress, and modify over time for best outcomes. Ultimately, the proper technique depends on your goals—and how committed you’re to reaching results. For those who want to totally faucet into BPC-157’s potential, injections remain the simplest and trusted alternative throughout a wide range of functions. Although anecdotal reports determine BPC 157 to be a non-toxic peptide with few antagonistic interactions, additional long-term research is required for the FDA to concur with such a notion.

Our scientific peptides are available solely through our optimization and longevity packages. BPC-157 injections are usually well-tolerated, but some discomfort is possible. Understanding the causes of injection pain and tips on how to manage it can enhance the general experience. Ensuring protected injection practices is crucial when administering BPC-157. Correct needle handling and disposal are paramount to forestall unintended accidents and contamination. All The Time use a new, sterile needle for every injection and dispose of used needles in a designated sharps container. By No Means try to recap or bend needles, as this will increase the chance of needle-stick accidents.

The World Anti-Doping Company (WADA) has listed it underneath S0 Unapproved Substances because of its potential performance-enhancing results. You Will discover innumerable reviews and articles that reward them for their products, supply, processing, and extra. Furthermore, they have fast worldwide shopping so regardless of whether you wish to buy BPC 157 peptide on-line within the USA, Australia, or another nation, you may get it. So make sure to speak to your doctor or a licensed medical skilled before you purchase a BPC injection, BPC 157 5mg vials, or something similar. However, before you purchase BPC-157 on-line or elsewhere, it is important to keep in thoughts that this substance continues to be under research and examine.

What’s Taking place i am new to this, I stumbled upon this I

have found It absolutely useful and it has helped me out loads.

I hope to give a contribution & assist different users like its

helped me. Good job.

I am in fact happy to glance at this website posts which carries tons of valuable facts,

thanks for providing such statistics.

Pretty nice post. I simply stumbled upon your weblog and

wished to say that I’ve truly loved surfing around your weblog posts.

In any case I will be subscribing in your rss feed and I hope you

write again soon!

Asking questions are truly pleasant thing if you are not understanding anything totally, but

this paragraph offers nice understanding yet.

casino nsw

References:

majestic casino (https://halal-bazaar.com/order-tracking/)

Information clearly taken!!

Great site you have got here.. It’s difficult to find quality writing like yours these days.

I truly appreciate individuals like you! Take care!!

This is my first time pay a quick visit at here and i am really happy to read all at alone place.

Casumo is absolutely licensed and registered with the Malta Gaming Authority. This allows them legally to access a variety of locations based around the globe. As you land on the casino for the first time, you’ll be directed to a holding web page. This is basically their homepage, and it highlights a lot of issues that you can expect to find from Casumo. The site also features a detailed and well-organised FAQ web page and active social media accounts on Twitter and Fb.

The quickest method to take care of a query is through the reside chat operator, on-line 24/7. The facility can be accessed via a speech bubble icon on the backside of every web page. Casumo Casino has a dedicated FAQ section that does a great job of addressing various areas of concern and subjects. Nevertheless, you will also be happy to be taught that there’s a buyer assist team out there 24 hours a day, 7 days every week via stay chat and e mail.

So whether you need single-deck blackjack or Soccer Studio, it’s lined. https://blackcoin.co/casumo-casino-review-rewards-slots-and-payments-how-is-customer-service/’s bonus stacks up nicely in opposition to its competitors, although it’s not the largest one out there. Alongside the welcome bonus, you can even look forward to cashback, tournaments and different common promotional offers at Casumo.

When you play, you earn points that transfer you in course of the next stage of the journey. While it’s potential to get this offer, it’s not as in style as different perks. You can check the promotions page frequently to know when it’s up for grabs.

Another optimistic thing to like concerning the on line casino is its customer service and security measures. Funding your account and withdrawing winnings is easy at Casumo and there are a number of cost methods primarily based on the place in the world you reside. Our evaluate additionally noted that there aren’t any fees charged on deposits or withdrawals and the casino has a short pending interval. At the time of our evaluate, cryptocurrency was not out there as a banking technique. Alongside several country restrictions, the site’s reside dealer on line casino section isn’t as extensive as other leading on-line casinos. However, Casumo’s online slot assortment is particularly spectacular, with thousands of video slots, traditional games, jackpots, progressive slots, and much more available. Casumo On Line Casino presents Canadian gamers a spread of engaging bonuses and promotions.

Nonetheless, the site is optimised to work on all desktop, pill, and smartphone gadgets, whatever the working system so you probably can select to proceed playing additionally on the web site. When testing the online on line casino on totally different devices, we found that the expertise remains the same. Whether Or Not you’re into casino, live casino, or sports, Casumo has received it all.

Casumo presents its new users a no deposit bonus with 20 free spins. After leveraging this casino’s potential, you may be awarded a one hundred pc match welcome whenever you initiate the primary deposit. There was no category tab to click for table video games though and I wasn’t able to find any of these to try.

Ideally, we’d prone to see extra options right here, but you’ll be able to contact them via social media on each Facebook and Twitter, which does assist. Casumo has an affiliate program that is likely one of the greatest that we have examined. In fact, it’s so good that they’ve received industry-based awards from the EGR Awards in 2017 and 2018 for their affiliate program. To get accreditation and licenses from the likes of the MGA implies that they should hit sure standards. Simply part of this comes within the form of sport equity and security on website.

The casino offers over 2,000 video games, with the overwhelming majority of those falling beneath the video slots class. In this category, you can see a few of the newest themes, recreation mechanics, and payouts of the industry. You will also have the power to get pleasure from traditional slots, including ones featuring three reels and one row. Casumo is an online casino that was founded in 2012 and after that it has grown as a family name. Owned and operated by Casino Service Restricted Casinos, Casumo presents myriads of games to players all over the world with an thrilling gamification twist. Most of the big-name builders are on board, so they can provide a few of the most well-known slot titles.

Our review found a welcome package up to $2,000 on the primary three deposits made at this on-line casino in 2025. As a brand new player, it is feasible for you to to double the quantity of your initial deposit when claiming one of the most beneficiant first deposit bonuses within the trade. Our evaluate readers who join a model new account in 2025 can claim a 100 percent match bonus as a lot as 500 EUR along with 99 free spins on the Gates of Olympus slot at Casumo On Line Casino.

Very descriptive article, I enjoyed that bit. Will there be a part 2?

We’re a group of volunteers and opening a new scheme in our community.

Your web site provided us with valuable info

to work on. You’ve done a formidable job and our whole community will be thankful to you.

Marvelous, what a website it is! This website

provides useful information to us, keep it up.

With thanks. Helpful information.

Hi! Quick question that’s entirely off topic. Do you know how to make your site mobile friendly?

My site looks weird when viewing from my iphone 4.

I’m trying to find a theme or plugin that might be able to resolve this

issue. If you have any suggestions, please share.

Cheers!

Hello! Quick question that’s entirely off topic.

Do you know how to make your site mobile friendly? My blog looks

weird when browsing from my iphone. I’m trying to find a template or plugin that might

be able to resolve this issue. If you have any recommendations,

please share. Appreciate it!

Wow, wonderful blog layout! How long have you been blogging for?

you made blogging look easy. The overall look of your website is

wonderful, as well as the content!

Your means of telling everything in this article is really

nice, every one can simply know it, Thanks a lot.

If you would like to take a great deal from this piece of writing

then you have to apply these techniques to your won blog.