这次我们要分享的是蒙特卡洛方法,一种基于随机采样的优化策略。与前一章不同,不需要对环境有完整的了解。蒙特卡罗方法只需要根据经验,即与环境交互的状态、动作和奖励的样本序列。

“蒙特卡洛”这个术语通常用于任何涉及随机分量的估计方法,蒙特卡洛方法是基于平均样本回报解决强化学习问题的方法,注意这里使用的是 return,而不是 reward。为了确保有明确定义的 return 可用,我们只为可以划分为episode的任务定义蒙特卡罗方法。也就是说,假设经验(experience)被划分为片段,并且无论选择什么动作,所有 episode 最终都会终止,只有在一个 episode 完成时,值函数和策略才会发生变化。因此,蒙特卡洛方法可以在 episode 意义上是增量的,而不是在 step 意义上。

蒙特卡洛方法对每个状态-动作对进行采样并计算平均回报(return),这与我们在前面分享的多臂老虎机方法对每个动作的采样和计算平均回报非常相似。主要区别在于现在有多个状态,每个状态都像一个不同的老虎机问题,并且不同的老虎机问题是相互关联的。也就是说,在一个状态下采取行动后的回报取决于同一episode中在后面的状态下采取的行动。

与前面的动态规划求解强化学习问题的方法一样,我们先分享在蒙特卡洛方法下的值函数估计,再分享蒙特卡洛方法下的策略优化,最后分享基于重要性采样的优化方法。

值函数估计

状态值函数

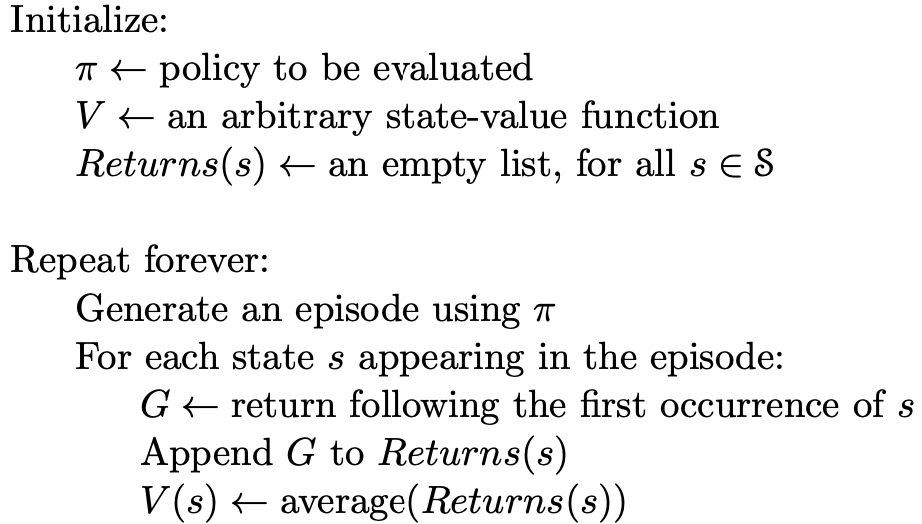

根据估计时所使用的样本的不同,蒙特卡洛方法可以分为“first-visit\ MC\ method”和“every-visit\ MC\ method”。其中,first-visit\ MC\ method 使用的样本是每个 episode 中第一次遇到状态 s 之后的回报,而 every-visit\ MC\ method 使用的是每个 episode 中每次遇到状态 s 之后的回报。但相同点是,我们对所有的 episode 中采样到的回报进行一个平均,就得到状态的值函数了。

我们直接看伪代码:

动作值函数

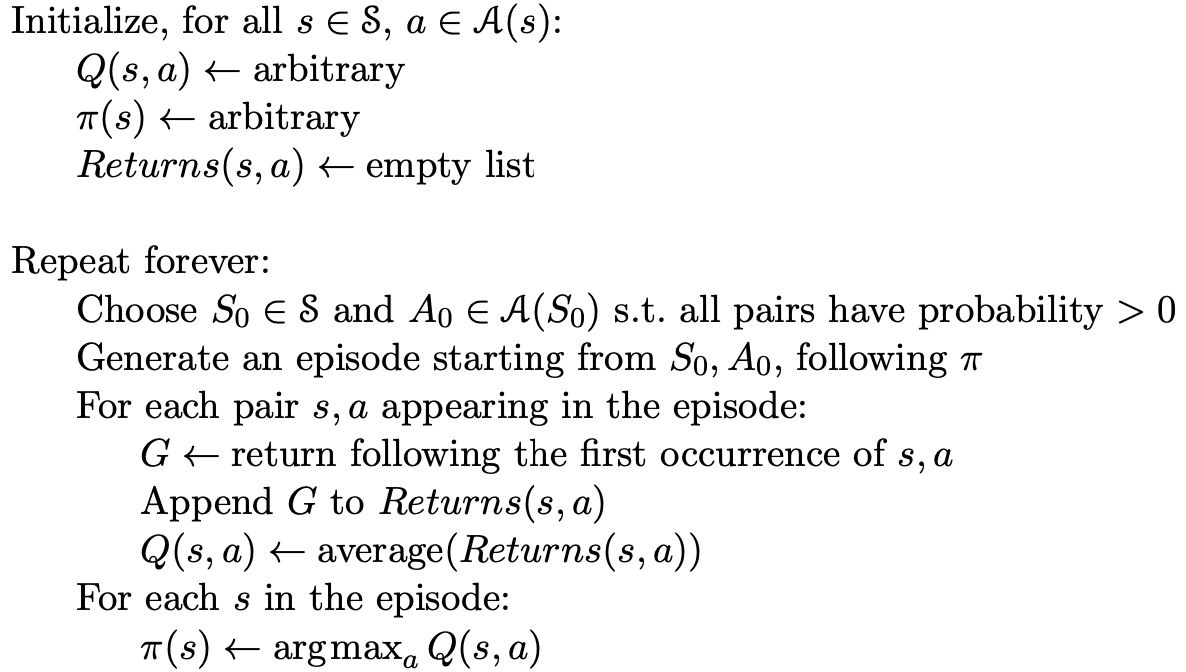

事实上,我们在借助值函数进行决策时,常常会更多地用到动作值函数,比如贪心策略的 \arg\max_a\{q(s,a)\}。因此,我们也总结下蒙特卡洛方法下的动作值函数的估计方法。

和状态值函数一样,动作值函数的估计也分为 “first-visit\ MC\ method”和“every-visit\ MC\ method”。值得一提的是,动作值函数是针对每个“状态-动作”对而言的。因此,在 first-visit\ MC\ method 下,使用的采样就是每个episode中第一次遇到状态 s 并采取了动作 a 之后的回报进行平均,every-visit\ MC\ method 同理。

exploring\ starts

对于一个特定的强化学习问题,“状态-动作”对的数量是非常庞大的,这就导致在一个确定性的策略下有大量的“状态-动作”对将无法被选到,而我们又需要保证每个“状态-动作”对被选到的次数都是无限多的。因此,我们经常会有一个假设就是每个“动作-状态”对都有非零的概率被选到。这个假设就被称作 ”exploring\ starts“。

蒙特卡洛策略优化

我们使用和之前一样的方法进行策略优化--greedy方法,即在每个状态下尝试值函数最大的策略,如果现有的动作值函数下更优,则将该状态下的决策调整为该动作。再结合上面的假设--”exploring\ starts“,这个方法被称作 Monte\ Carlo\ ES。算法伪代码如下:

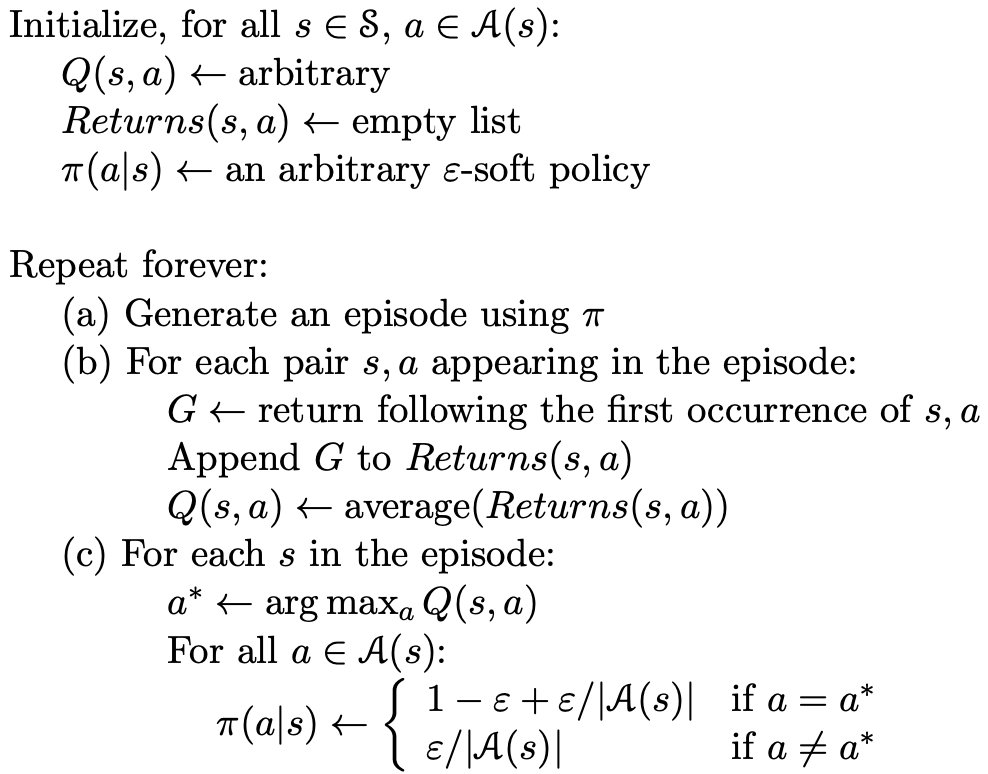

without exploring\ starts

为了去掉 exploring\ starts 这个假设,我们根据动作值函数定义一个新的动作选择概率分布如下

a^* = \arg\max_aQ(s,a)\\

\pi(s,a) \gets

\left\{\begin{matrix}

1-\epsilon + \epsilon/|\mathcal{A}(s)| &if\ a=a^* \\

\epsilon/|\mathcal{A}(s)| & if\ a\neq a^*

\end{matrix}\right.伪代码如下:

基于重要性采样的优化策略

基于重要性采样的优化策略往往被称作 off-policy,在重要性采样方法下,我们通常定义一个目标策略 \pi 和一个控制策略 \mu。也就是说在与环境交互的过程中遵循的是策略 \mu,而我们要基于交互中的采样计算出目标策略 \pi 的值函数。相比以往的方法,我们的控制策略和目标策略都是 \pi,故而这里被称作 off-policy。

这种策略的一个好处就是,我们往往可以在当前策略下计算最优策略的值函数,也就是说将控制策略和目标策略分离开,目标策略是一个确定的策略,而控制策略可以是一个概率模型,从而保证了每个”状态-动作“对都可以被选择到,下面,我们就来看看这种方法的实现原理。

其实在两种策略下,每个状态动作序列都是有可能出现的,只是出现的频率或者概率不一样,这就需要我们对控制策略 \mu 下得到的回报进行一定的加权再平均。在策略 \pi 下,一个状态动作序列 A_t, S_{t+1},\cdots,S_T 的概率为

\Pi_{k=t}^{T-1}\pi(A_k|S_k)p(S_{k+1}|S_k,A_k).(注意,这里我们将所有的 episode 在时间上连接在一起,这样每个 episode 的每个 step 都可以用不同的时间戳区分开来了。)根据,这个概率公式,我们计算每个回报的权重因子为

\rho_t^T = \frac{\Pi_{k=t}^{T-1}\pi(A_k|S_k)p(S_{k+1}|S_k,A_k)}{\Pi_{k=t}^{T-1}\mu(A_k|S_k)p(S_{k+1}|S_k,A_k)} = \Pi_{k=t}^{T-1}\frac{\pi(A_k|S_k)}{\mu(A_k|S_k)}.按照计算平均的方法,重要性采样的优化策略分为”ordinary“和”weighted“两种:

ordinary\ importance\ sampling 的计算公式为

V(s) = \frac{\sum_{t\in \mathcal{T}(s)}\rho_t^{T(t)}G_t}{|\mathcal{T}(s)|},以 first\ visit 策略为例,其中,\mathcal{T}(s) 表示所有的 episode 中第一次遇到状态 s 的时刻,T(t) 表示时刻 t 之后的首次termination。

weighted\ importance\ sampling 的计算公式为

V(s) = \frac{\sum_{t\in \mathcal{T}(s)}\rho_t^{T(t)}G_t}{\sum_{t\in \mathcal{T}(s)}\rho_t^{T(t)}}.增量实现

重要性采样下值函数迭代的一种增量实现,和之前多臂老虎机里面计算均值的思想是一样的

V_n = \frac{\sum_{k=1}^{n-1}W_kG_k}{\sum_{k=1}^{n-1}W_k}\\

V_{n+1} = V_n + \frac{W_n}{C_n}[G_n - V_n]\\

C_{n+1} = C_n + W_{n+1}总结

以上就是蒙特卡洛方法,下次我们分享强化学习的时间差分学习方法。

In addition, it’s used to alleviate bone ache caused by osteoporosis, to advertise the body’s restoration after severe burns,

and to treat a big selection of other medical circumstances.

Only tablets are available for purchase, and so they have to be swallowed complete.

In conclusion, utilizing supplements could be an efficient

way to reinforce your outcomes when taking Anavar. Simply be sure

to choose a legal and secure different, and always do a PCT to help your

physique get well. While not everybody will expertise these unwanted effects, it’s necessary to remember of them and to speak to your physician when you have

any considerations. Anavar might help you perform better during cardio exercises,

which can help you burn more energy and improve your overall health.

When it comes to utilizing Anavar, it’s essential to assume about the authorized implications.

You will purpose to reverse the consequences of the other steroids, rather than Winstrol, during your PCT cycle.

Due to Winstrol’s substantial liver toxicity (including the injectable version), we must be cautious when stacking it with some other C17-alpha

alkylated AAS and restrict the cycle to just a few weeks.

I point out this particularly as a outcome of one of the

stack suggestions I typically encounter is a Winstrol/anavar dosage for weight loss stack.

Decreased intercourse drive is an issue for some women on Winny, and a few have complained about some fairly extreme mood and mental points creating – again, these are individual

responses. Females who notice an initial voice change after increasing the dose by just 1mg or 2mg will usually decrease the dosage to get rid of the virilizing danger.

Males who use Winstrol will primarily be getting ready for a

contest and using Winny at the ultimate stages of a cycle that has included

any number of AAS.

Nonetheless, we have found this to be one of the better cycles

for avoiding man boobs. We have seen this duo utilized as a slicing

cycle, where customers eat in a calorie deficit.

We have also seen it used as a lean-mass building

cycle, the place customers eat upkeep energy (or in a small surplus).

Considering it is a bulking cycle, we are in a position to assume customers might be

eating high quantities of calories for maximum features.

Nonetheless, because of Deca Durabolin’s delicate toxicity, it could be a complementary stacking element.

Water retention is sort of sure with testosterone and Dianabol, causing bloating and a easy appearance to the muscle tissue.

Therefore, we see this cycle commonly taken during the low season when an individual is optimizing for mass as an alternative of aesthetics.

Nolvadex blocks estrogen, particularly in the mammary glands, while

keeping estrogen levels circulating all through the body.

This significantly reduces the danger of gynecomastia without significantly decreasing total estrogen levels, thus preserving high-density lipoprotein (HDL) ldl cholesterol and serotonin ranges optimum.

Clen is known as a Beta-2-Agonist and can cause a rise

in Lipase (fat releasing hormone) – which can rip fats from

adipocytes into free fatty acids, which then find their means into the blood.

First, it helps to minimize the unwanted effects of steroids by

permitting the physique to partially recover from their use.

If you’re in search of safer ways to attain similar outcomes, authorized Anavar options like Anvarol might supply a viable,

side-effect-free possibility. Anavar (Oxandrolone) is

a Schedule III managed substance in the U.S.

and requires a prescription. Buying it without a prescription is illegal

in many countries and might result in legal penalties and

well being dangers. The addition of doubtless hazardous compounds can pose main health risks.

Subsequently, illicit use of this steroid could cause troublesome

and potentially deadly unwanted effects.

Most customers will expertise adjustments in levels of LDL and HDL cholesterol to some extent, though

without monitoring, many Deca-Durabolin won’t be conscious of these adjustments.

When LDL cholesterol levels rise and HDL ranges fall, blood strain can even enhance due

to the coronary heart working tougher to pump blood through

the arteries. The resumption of pure testosterone production can take many months if left to happen by itself.

A PCT cycle is important following the use

of Deca-Durabolin in order that testosterone production may be encouraged to begin occurring sooner and quicker and that can help you avoid a state

of low testosterone. As a 19-nor compound steroid,

Deca-Durabolin is a progestin, and its exercise on progesterone receptors can increase the incidence of estrogen-type unwanted side effects.

As a first-time female consumer, smart dosages and cycle duration are important

in yielding favorable results whereas minimizing potential side effects.

Oxandrolone, generally often identified as Anavar, has turn out to be more and more in style

amongst female bodybuilders for a quantity of reasons.

Its mild anabolic properties and low-androgenic side-effects make it an appropriate choice for girls concerned about preserving their femininity while reaping the

advantages of this artificial hormone. For girls thinking about

using Anavar to enhance their health routine, there are

a number of essential methods to maximize the effectiveness of this supplement.

A finely tuned consuming plan gives the body the nutrients it needs to deal

with the extraordinary workouts that accompany Anavar

use, making it potential to see faster gains and fats

loss.

Cardiovascular risks include attainable adjustments in levels of cholesterol and blood stress.

Preserve a food regimen low in saturated fat and interact

in cardiovascular train to support heart health. Common monitoring by a

medical professional is recommended to handle these dangers.

Though Primobolan is much less hepatotoxic than many other

oral anabolic steroids, it can nonetheless current a threat to liver health.

We have found hCG to be particularly efficient in treating testicular atrophy.

Being the primary, naturally occurring male hormone, testosterone is doubtless one of the most

commonly used anabolic steroids amongst bodybuilders. Nevertheless, it’s essential to keep in mind that each individual responds in a

unique way to Anavar. The results skilled over the four week cycle

can range tremendously, with factors corresponding to dosage,

food regimen, and train routine taking half in a pivotal

position. It’s important to begin with a smaller dosage to see how the

body responds, particularly for newbies. It works greatest when paired with disciplined training, a clear food regimen, and a

commitment to restoration.

Because of this, the suggested most cycle size for Oxandrolone

is eight weeks. As A Result Of Anavar’s effects on the

physique are quite delicate, this is a prevalent concern. Even though it’s attainable

to use Anavar for ten weeks or more, and many individuals accomplish that because the unwanted side effects are tolerable,

doing so raises the chance of liver harm. The average length

of an Anavar cycle for males is approximately eight weeks, whereas

the utmost period for women is six weeks. The most experienced athletes might improve their daily consumption of Anavar to a hundred mg,

but that is thought-about a excessive dose, and there’s no profit to using higher doses.

Nevertheless, when these older bodybuilders resume lifting weights again, they often display prominent

muscularity (even without the presence of steroids).

No weight training plus discontinuation of steroids can result in 50 lbs or more of

weight loss. Dianabol injections are generally administered into the glutes, outer leg,

and deltoids.

We saw this old-school mixture increase anabolism, with Proviron working as a synergistic agent (increasing Dianabol’s effects).

Dianabol may even kick in faster than some testosterone esters (such as cypionate and enanthate),

which have considerably longer half-lives. Thus, we find Dianabol produces

better leads to the early phases of a cycle. One good thing about

taking Deca Durabolin vs. Dianabol is that its estrogenic exercise is low, with much

less aromatization occurring. Thus, the risk of gynecomastia is significantly less on Deca Durabolin compared to Dianabol,

albeit still possible because of moderate progesterone

exercise. Thus, a Dianabol cycle is prone to cause an increase in visceral fats and a lower in subcutaneous fats.

Nevertheless, oral steroids, including Dianabol, may be more harmful to the liver in comparison with injectable steroids

and come with a range of potential side effects. Dianabol is renowned for its

capacity to quickly improve muscle mass and total body

weight. According to studies, it promotes important nitrogen retention and protein synthesis within muscle cells, resulting in sooner

buildup of dense, quality muscle tissue.

The following data describes dosages which are generally used or really helpful for dexamethasone oral pill.

Cyclosporine (Sandimmune) is used to prevent organ rejection in individuals who receive a transplant,

in addition to to deal with rheumatoid arthritis or psoriasis.

Taking this drug with dexamethasone might enhance the risk

that your immune system shall be suppressed (weakened).

You mustn’t get stay vaccines whereas using dexamethasone as a end result

of the drug weakens your immune system. If this happens, your body won’t be able to properly defend

in opposition to the vaccine, and it may make you sick.

If you’re on the lookout for a safe and legal alternative to Dianabol, I

suggest you attempt D-Bal from CrazyBulk. CrazyBulk provides a

purchase two get one free deal on all of their merchandise, so if you’re excited about making an attempt D-Bal,

now is the time. D-Bal is a product of CrazyBulk, an organization that is known for manufacturing high-quality and secure steroids.

If you expertise any of those unwanted effects, you should

stop taking Dianabol and see a doctor immediately.

Despite its effectiveness, Dianabol comes with potential side effects, including liver toxicity, high blood

pressure, and estrogenic results like gynecomastia.

Proper cycling and post-cycle remedy (PCT) are essential for mitigating risks.

Dianabol will increase protein synthesis within the body,

which leads to increased muscle growth. It additionally helps to increase nitrogen retention in the muscle

tissue, which prevents muscle breakdown. Additionally,

Dianabol will increase purple blood cell production, which results in improved

oxygenation of the muscular tissues and elevated endurance.

It is due to this relatively brief half-life that users are advised to dose it

in a break up dose style all through the day. Dianabol doses that

are administered as soon as per day will undoubtedly result in unstable blood plasma ranges akin to

peaks and valleys. Doses that exceed 5mg per day must be cut up up into

at least two doses evenly aside throughout the day.

There exist different opinions and practices in phrases of dosing protocols.

There are many users that prefer to devour a full 20mg

Dianabol dose, for example, all of sudden instead of splitting the 20mg dose in half and consuming each half 6

hours aside.

Whereas Dianabol is one of the greatest steroids for newbies, it

could be authorized in other elements of the world which may be available.

→ Athletes subject to drug testing should be

conscious that Dbol can be detected for up to 5–6 weeks after use as a end result of lingering metabolites.

To restore hormonal perform and shield your long-term well being,

a well-structured PCT is essential after any Dbol cycle.

These symptoms tend to emerge in users taking 40+ mg/day, or those with current sensitivity

to DHT-based compounds. Under are widespread and efficient stacks — together with

what not to stack because of toxicity or danger

overlap. This method delivers a powerful short-term boost however may sacrifice long-term progress due to quick duration of

motion. Under is a structured breakdown of Dianabol

dosing by consumer experience level, with considerations for

cycle duration, stacking, and threat administration.

Fish oil, even with out the presence of anabolic steroids,

has been found ineffective in lowering systolic blood pressure in normal middle-aged males (7, 8).

A proper PCT utilizing Clomid or Nolvadex is critical to restart natural hormone production. Stacking two hepatotoxic compounds

can tremendously increase the risk of elevated liver enzymes, cholestasis,

and long-term liver injury. This makes Dianabol notably effective for brand spanking new muscle development throughout bulking cycles — especially within the first few weeks of a stack.

That depends on your experience stage, your goals, and your understanding of the dangers

concerned. That can open the door to estrogenic unwanted effects, liver toxicity,

and post-cycle hormonal crashes — particularly should you skip PCT or run it too lengthy.

Whereas it’s most commonly used to improve muscle mass and power, it may

also be used to improve stamina and endurance. Dianabol

is a strong anabolic steroid with a broad range of potential uses.

Dianabol is taken orally, and users sometimes see results within 2-4 weeks of beginning the drug.

References:

valley

In addition to elevated vitality ranges, should i take dianabol before or after a workout also noticed an increase in my libido.

As any bodybuilder knows, there are many benefits to stripping physique fats.

If you’re thinking about taking Dianabol, or have already began taking it,

you’re probably wondering what leads to you can count

on after simply four weeks. In this blog publish, I’ll share

what occurred during these four weeks, as well as my ideas on the complement

general. Failure to implement an efficient post-cycle remedy may also trigger long-term testosterone deficiency, negatively affecting a man’s well-being, libido,

and fertility. Harsher steroid mixtures than the above

may cause even greater ranges of toxicity in our expertise.

In comparison, testosterone cypionate can be prescribed to treat hypogonadal males, and thus possession of

this steroid is legal when accompanied by a prescription.

Regardless Of its illegal standing, lots of athletes and bodybuilders

use it all over the world these days. Many people consider Dianabol a fairly protected steroid,

however then again, only if you employ it appropriately.

Whoever is thinking about working a Dianabol cycle would positively

love to see some Dianabol earlier than and after photos.

I determined to make this submit the place you can discover some

real Dianabol earlier than and after pictures together with a lot of helpful

details about this oral anabolic steroid.

To avoid this, it is advisable to use Dianabol with other steroids which have an extended lasting

impression. They use it with other steroids that it enjoys a synergy with so that the weight

gained wouldn’t be misplaced simply. The purpose why many people

recommend that you simply lose most positive aspects made in the course of the cycle with Dianabol after you cease its use is that they cease the cycle with no PCT.

Tamoxifen (Nolvadex) and clomiphene (Clomid) are the two main medicines we use to forestall Dianabol-induced gynecomastia.

All of this is very important because nitrogen retention and protein synthesis will

speed up muscle growth and restoration. In addition to that, higher

glycogenolysis will improve the pace of turning carbs into vitality.

In an try and normalize blood pressure, users are beneficial to take 4 grams

of fish oil per day, mixed with wholesome consuming and common cardiovascular

train. Although endurance activities may not appeal to

bodybuilders when bulking, they can provide cardiac protection. The above cycle is tailor-made

for intermediate steroid users using average dosages.

The biggest concern we have with the addition of trenbolone is

elevated blood stress. This is as a outcome of it does not convert to estrogen, and thus it may possibly worsen cholesterol ratios.

Taking four grams of fish oil per day could assist to stabilize blood

strain and was advantageous in a 2013 research (3).

Deca Durabolin isn’t without unwanted effects, with it being

recognized for causing erectile dysfunction.

Its function is to naturally moisturize your

skin, making it delicate and easy. However, an excessive amount of sebum leads to oily skin and might block your pores, leading

to pimples breakouts. Dianabol slightly will increase ranges of the main androgen in men, DHT (dihydrotestosterone).

We have discovered androgenic side effects to be possible

on Anavar; nevertheless, they will already exist as a outcome of presence of testosterone.

Nonetheless, Anavar is metabolized in another way than other oral steroids,

with the kidneys taking over extra of the workload, and

thus it causes much less hepatic inflammation. These wanting to guard their hair follicles may take

DHT-blocking dietary supplements. Nonetheless, we’ve not discovered this to be a helpful strategy, as such dietary supplements can cut back gains, with studies indicating DHT to be a highly anabolic hormone (4).

We discover human chorionic gonadotropin (hCG) and Clomid are sometimes enough to recuperate

endogenous testosterone production, normally inside 1–2 months.

This happens through the 5-AR (5-alpha-reductase) enzyme, which is responsible for converting testosterone into DHT.

Several of the above have been proven to be effective in restoring regular HPT axis operate

and thus rising endogenous (natural) testosterone back to

regular levels. If a person repeatedly takes oral Dianabol

for several months without cycling off, they’ll be susceptible to creating peliosis hepatis.

This is a vascular condition where blood-filled cysts seem

throughout the liver. This may cause pain in the upper right of the stomach, jaundice, anemia,

or bleeding. We have had patients develop cholestatic syndrome, which is when bile move turns into impaired,

leading to a buildup and inflicting inflammatory injury to the liver.

Typical Dianabol results include a weight acquire

of lbs (4.5-9 kg) in a span of 4-6 weeks. Some customers have reported gaining about 7lbs from operating a 50mg dosage for just over 6 weeks.

It’s necessary to note that individual outcomes may

range, and plenty of factors such as diet, coaching, and overall

well being can impact outcomes. Many users seem to expertise comparable

results with Dianabol cycles lasting 5-6 weeks at moderate dosages of 15mg-20mg per day,

seeing typical dimension features as reported by others.

Nonetheless, it is important to notice that individual results may vary.

Testosterone suppression may also be notable on Dianabol, with men incessantly becoming hypogonadal from reasonably dosed cycles.

After a number of months, endogenous testosterone levels usually recuperate; nonetheless, if users

abuse Dianabol, then they could experience long-term testosterone deficiency

and infertility.

Anadrol could cause AST and ALT enzymes to rise shortly, both of which are markers of liver stress.

Thus, liver support is crucial if users are utilizing this cycle.

Stacking in this way can considerably improve a user’s results compared to testosterone-only

cycles. Trenbolone, like Deca Durabolin, offers average progesterone exercise, having

the potential to trigger gynecomastia. Thus, customers might want

to avoid using SERMs to stop aggravating progesterone ranges.

In those cases, you’ll have the ability to anticipate a lot larger stress on the liver, presumably causing everlasting injury.

Liver support supplements might help present some safety to

your liver when using Anavar or different steroids.

Symptoms could be widespread and serious and can include fatigue, despair, low libido,

lack of muscle, and fats gain, to call just some. Growth of

zits and oily pores and skin are the opposite

androgenic side effects to watch out for. Again, these will develop

rapidly and severely in some folks, while others won’t have acne.

This can additionally be considered genetics, so if you’ve

been acne-prone prior to now, there’s a high

chance you’ll develop this side effect when utilizing Anavar.

In Distinction To baldness, which is usually everlasting except treated, acne must be reduced and clear

when you cease utilizing Anavar.

In this occasion, users may also expertise water retention and bloating,

which Anavar does not cause, plus heightened anabolic effects.

Nonetheless, with Anavar’s fat-burning results

and muscle positive aspects being retained post-cycle, there

is not a fantastic want for most individuals to make the most of Anavar all

year round. Most anabolic steroids sold on the black market are UGL (underground laboratories).

This is essentially produced in a non-certified laboratory and poses a high risk to the buyer, as there are not any rules in place to

ensure product safety.

This is because the kidneys, and never the liver, are primarily answerable for metabolizing Anavar.

Nonetheless, we find this to be a smaller share in comparability with different C17-aa steroids.

Finally, the key to unlocking positive aspects with an Anavar cycle lies in knowledgeable decision-making, careful planning, and a dedication to your well being and well-being.

With the right knowledge and strategy, you’ll be able to navigate your Anavar journey with

confidence and achieve the physique you’ve always desired.

We have found Anavar to be probably the greatest steroids

in regard to toxic unwanted facet effects. Research has also shown it to possess security in long-term medical

settings (9). My name is Michael Cobb, and I am a certified health trainer with over 7 years of experience in the fitness industry.

The Hypothalamic Pituitary Testicular Axis (HPTA) can potentially turn into damaged with extreme steroid use, probably inflicting everlasting injury to your testosterone production in extreme instances.

While you’re utilizing the steroid, you won’t have signs of low testosterone.

Nonetheless, as quickly as you cease taking Anavar, and where no

different type of external testosterone is being taken, you

can experience a sudden drop in T ranges – notably as Anavar leaves the body quickly.

Regardless of what you’re stacking Anavar with, the cycle size of this steroid ought to nonetheless be now

not than eight weeks. Ladies can count on excellent outcomes from an Anavar cycle,

together with lovely power positive aspects.

You’ll be lifting heavier weights and will find

your lifting action improves with that power

enhance. The basic rule when planning a cycle is that the

higher the Anavar dose is, the shorter the cycle you must be doing.

However in most international locations, it may possibly solely be bought on the

black market, and Anavar is usually priced larger than plenty of different

steroids. In the Usa, it is illegal to buy or use Anavar and not using a prescription from a well being care provider.

Anavar itself is derived from DHT (dihydrotestosterone), with some slight alterations to the construction of the hormone.

As A Outcome Of it’s a DHT steroid, it may possibly bring about

head hair loss in male customers who’re already genetically

predisposed to male pattern baldness. Others discover that testosterone suppression is lots higher than anticipated.

Sudden water retention is another occasional adverse comment customers make about Anavar – however these persons are virtually definitely victims of purchasing counterfeit Anavar.

Nevertheless, Anavar is not an various to coaching or food regimen self-discipline; it is a software

to enhance a structured fitness life-style.

For newcomers to the bodybuilding panorama, an introductory Anavar cycle could be a standalone expertise.

Getting familiarized with a single compound earlier than branching out into stacks is

essential. Beginning with a decrease dosage, often from 20 to 30 milligrams per day,

will give novices an ample concept of how their

our bodies react to the steroid. Sticking to a typical cycle of six to eight

weeks allows the physique to adjust and let the compound work its magic without overstaying its welcome.

An superior Anavar cutting cycle can also final between six to eight weeks, although

some experienced users may extend this period.

A test and anavar cycle before and after Anavar cycle refers to a particular routine where anabolic steroids like

testosterone (Test) and oxandrolone (Anavar) are used together.

It is designed to enhance muscle features, energy, and athletic performance.

Anavar and Winstrol possess many similarities, with both decreasing fats mass and water retention while growing lean muscle mass.

There is a common notion that women don’t require post-cycle therapy.

Sur le net, de nombreuses boutiques en ligne sont spécialisées dans les compléments alimentaires et stéroïdes dédiés à la pratique de la musculation, ou d’autres sports activities. Voici quelques éléments de réponse pour savoir où acheter de la testostérone en ligne. La testostérone est souvent mal vue à cause de ses liens avec les comportements “virils”. Il faut comprendre comment l’éducation peut nous aider à gérer cette hormone et ses effets sur notre comportement. On prescrit la testostérone quand des checks médicaux montrent un besoin.

Entre les promesses des produits en libre accès et la législation bien encadrée de la testostérone en tant que traitement hormonal substitutif, les consommateurs doivent naviguer avec vigilance. Toutefois, il est essential de souligner que l’achat de testostérone en ligne sans ordonnance médicale est illégal et comporte des risques importants pour la santé à court docket et moyen terme. Bien que certaines personnes puissent être tentées d’acheter de la testostérone en ligne pour améliorer leurs performances sportives, cela peut entraîner des effets secondaires graves et mettre en danger leur santé. Heureusement il existe de nombreux compléments alimentaires qui vous aideront à restaurer des niveaux satisfaisants de testostérone.

Il existe également des boutiques spécialisées qui proposent des suppléments de testostérone autorisés. Ces établissements donnent aussi des conseils sur comment les utiliser correctement. Découvrez Performer 8, un complément alimentaire efficace pour les hommes qui souhaitent booster leur sexualité sans avoir recours à des médicaments. Vous pouvez acheter les compléments de testostérone en ligne et surtout se procurer des marques connues par leur efficacité. Ne négligez pas quelques détails comme les garanties de 2 mois, les avis des purchasers qui ont déjà achetés ces compléments. En vieillissant, la manufacturing de testostérone start à diminuer mais ce n’est pas la fin du monde. Nombreuses sont les choses qu’un homme peut faire pour augmenter la manufacturing de testostérone et la prise de suppléments n’est qu’une méthode.

En France, on peut https://byizea.fr/js/pgs/?acheter_de_la_testosterone_2.html de la testostérone, mais il faut suivre des règles précises. Une ordonnance médicale est nécessaire pour obtenir des traitements à base de testostérone. Cela prouve que son utilisation est essentielle pour la santé du affected person.

Cette plante est principalement utilisée pour réduire le stress et l’anxiété, mais elle aide aussi à stimuler la libido et la qualité du sperme. En outre, une étude a montré que l’ashwagandha améliore la performance lors de l’exercice, la pressure et la perte de graisse, et améliore la testostérone. Les liens entre la testostérone et la building musculaire sont bien connus, ils ont été étudiés de manière approfondie par la communauté scientifique. Le taux de testostérone est effectivement fortement corrélé avec la capacité à créer du muscle (source). Consultez toujours un professionnel de la santé avant de prendre des décisions concernant vos traitements. Commander de la testostérone injectable ou du gel androgène via Web sans ordonnance expose à des risques multiples, aussi bien légaux que sanitaires.

L’efficacité des compléments stimulant la testostérone fait l’objet de nombreux débats parmi les scientifiques. Alors que certains confirment que ces produits peuvent, en effet, aider à stimuler la production de testostérone, d’autres ne considèrent pas la médecine various ou l’approche holistique comme importante. Une évaluation de ces études a montré que la supplémentation en testostérone augmentait constamment l’influence de la pressure musculaire sur la libido, la fonction érectile, et d’autres paramètres étaient incohérents.

Jusqu’à récemment, on pensait que la testostérone augmentait la pressure et la puissance simplement en augmentant la taille du muscle. Cependant, la testostérone a également montré sa capacité à augmenter la quantité de calcium qui est libérée dans la cellule, ce qui peut augmenter la pressure des contractions musculaires. De même, dans une étude récente sur les rongeurs, il a été démontré que la DHT stimulait directement la force de contraction musculaire jusqu’à 24-30% dans les fibres musculaires de puissance et d’endurance.

Bien qu’elle puisse être détournée de son utilization pour gagner en masse musculaire ou profiter d’autres avantages de cette hormone, cette démarche n’est vraiment pas conseillée. Ici, nous allons couvrir les différents features de la testostérone, comprendre dans quel cas on préconise son traitement et évoquer les inconvénients qu’il peut présenter. Dans cet article, nous détaillerons aussi le complément alimentaire TestoPrime dont l’utilisation confère des vertus similaires sans provoquer d’effets négatifs.

Hello to every one, the contents present at this web site are genuinely amazing for people experience, well, keep up the good work fellows.

Here is my webpage … Lottoup หวยออนไลน์

Please let me know if you’re looking for a author for your site.

You have some really good posts and I believe I would be a good asset.

If you ever want to take some of the load off,

I’d love to write some articles for your blog in exchange for a

link back to mine. Please blast me an email if interested.

Thanks!

Pretty! This has been an extremely wonderful post.

Thanks for supplying this info.

Optimizing healing with BPC-157 entails understanding the appropriate dosage ranges and administration protocols for this peptide. By sourcing BPC 157 from reputable suppliers and being mindful of your physique’s reactions, you can successfully harness the advantages of this highly effective peptide. With the right strategy, BPC 157 could certainly become a useful ally in your journey towards improved well being and well-being. The legality of BPC-157 usage varies, with some countries regulating it as a legal therapy whereas others might require particular approvals or prescriptions from healthcare suppliers like Dr. George Shanlikian. The timeline for experiencing results from BPC-157 remedy may vary, with regeneration and healing processes typically displaying gradual enhancements over time.

Due To This Fact, it has been theorized that if a person receives a most cancers diagnosis, administering BPC 157 could probably exacerbate their condition. Most Cancers has turn out to be one of many leading causes of dying globally, affecting millions of individuals yearly. In this weblog, we’ll discover what BPC-157 is and the way it can be a vital addition to traditional cancer therapies. Your body already produces BPC-157 in very small quantities, which serves to sign certain physique processes to happen and shield the digestive system. Researchers consider that when you get the tremendous concentrated model of BPC-157 into your system, it has an extremely high stage of regenerative effects. Frequent inquiries relating to BPC-157 typically center around inquiries concerning dosage, advantages, potential side effects, and the present standing of analysis on this substance. People contemplating the utilization of BPC-157 must be mindful of potential antagonistic reactions corresponding to gastrointestinal disturbances, complications, and fluctuations in blood pressure.

The first benefit highlighted muscle tissue and tendons, but this one is extra far-reaching; BPC-157 has shown to improve restoration rates, it would not matter what the damage entails. Nevertheless, BPC-157 prevailed with no drawback and proved itself efficient in therapeutic muscle tissue that had literally been reduce from rats. Not only does this protein assist with angiogenesis but in addition with vasculogenesis; the two are intently related to one one other and are quintessential for supplying oxygen and blood to tissue affected by damage. You should learn the proper injection method and all its protocols before injecting the dose into your body. Nevertheless, if you’re unaware of the best dose, start from the lower dosage and gradually transfer to the optimum dose. Bear In Mind, irrespective of which peptide you go for, it is essential to procure only from a good supply, similar to Biolongevity Labs. Biolongevity Labs goals to supply solely top-quality peptides, blends, bioregulators, and dietary supplements.

By suppressing pro-inflammatory cytokines and enhancing the body’s natural anti-inflammatory mechanisms, it presents long-term benefits in stopping persistent illnesses and lowering ache attributable to inflammation. Initially identified for its gut-protective qualities, BPC-157 has been extensively studied for its position in digestive health. It has demonstrated the flexibility torepair harm to the gastrointestinal lining, making it potentially useful in conditions like leaky intestine, ulcers, and inflammatory bowel conditions. If you’re looking for effective ways to speed up harm restoration, enhance digestion, or scale back inflammation, you would possibly want to study extra about the advantages of the BPC-157 peptide. Users rave about how this peptide combination has transformed their recovery process, allowing them to return to their every day activities with newfound vigor. Many have reported enhanced muscle restore and joint flexibility, attributing their improved physical performance to the common use of this potent mix. The introduction to BPC-157 TB-500 Dosage blend highlights the potential synergistic benefits of these peptides in promoting therapeutic and recovery for the physique.

I had been pondering taking peptides for a similar sort of tissue and joint aches for an extended while; but was fully unsure of the protocol, which peptide to take, and so on. Thank you a lot for posting this protocol, temp ranges, and how careful to be. I have Advanced Regional Ache Sydrome/ Reflex sympathetic dystrophy secondary to a botched foot surgery.

Our team comprises of educated MDs, PhDs, pharmacists, certified scientists, and certified well being and wellness specialists. Sure, this supplement has its fair proportion of unwanted aspect effects, however a mere glance at the list of dangers should make it clear that the majority of them are mild or reasonable. The high-risk unwanted aspect effects exist, but only if you don’t comply with the dosage pointers instructed by consultants and verified by anecdotal proof. Keep in mind that one BPC 157 cycle ranges between 6 and 12 weeks, with the decrease finish of the vary more than ideal for beginners. As Quickly As you’ve completed the cycle, we suggest you turn to publish cycle remedy to help your physique restart its testosterone production.

BPC-157 is a synthetic pentadecapeptide that’s derived from proteins in gastric juices and has been shown to have quite so much of regenerative and healing results in animal fashions. It is assumed to work by stimulating the manufacturing of development factors and other molecules that promote tissue repair. At PeptidesPower.com, we’re devoted to providing top-quality peptides, hormone therapies, and wellness supplements to help your health, fitness, and restoration objectives.

This prevents their tissues from receiving the provision of much-needed oxygen. This cut-off in oxygen supply causes the tissues to swell, and so they begin to die. Analyzing the benefits and potential unwanted effects of TB-500 elucidates its role in combating inflammation, selling muscle development, and facilitating tissue repair. Taking BPC-157 can have long-term results in your body, however it’s essential to note that the research remains to be in its early stages.

This course of is critical for restoration and entails development factors and endothelial cell development in lab fashions. Proof shows BPC 157 promotes fibroblast multiplication and motion which is essential to forming extracellular matrix and laying down collagen fibers. Files from managed tests also show the peptide boosts cell motion which is the fundamental strategy of filling in and repairing wounds and injuries.

References:

https://www.valley.md/bpc-157-injections-benefits-side-effects-dosage-where-to-buy

Therefore, buying high-quality TB 500 from trusted distributors turns into paramount. A key attribute that makes TB 500 value investigating lies in its anti-inflammatory qualities. It accomplishes this feat via cytokine modulation proteins integral for inflammatory responses which could be notably helpful when coping with circumstances like arthritis or persistent inflammatory illnesses. BPC-157 exhibits protective effects in opposition to non-steroidal anti-inflammatory drug (NSAID)-induced injury in analysis fashions. Studies indicate it reduces oxidative stress and inflammatory cytokine release, which helps preserve gastrointestinal mucosal integrity23. BPC-157 reveals promising anti-inflammatory properties by inhibiting myeloperoxidase exercise and stimulating the early growth response gene (EGR-1)16.

From the preclinical information for putative benefits there were additionally essential unwanted effects noted. For instance, TB-500 was discovered to accelerate dormant tumor progress and disrupt the immune response in animal experiments. By advantage of inducing broad cell growth, development hormone associated peptides (CJC-1295, Ipamorelin, and Tesamorelin), carry the potential threat of cancer.

A Lot like any compound utilized for scientific investigation, applicable utilization guidelines should be strictly adhered to when working with this compound – primarily inside managed lab environments. Misuse might potentially lead to adverse reactions or unintended penalties. The statements made inside this website have not been evaluated by the US Food and Drug Administration. The statements and the merchandise of this firm are not supposed to diagnose, deal with, remedy or forestall any illness. Limitless Biotech is not a compounding https://neurotrauma.world/tb-500-peptide-injections-benefits-dosage-and-risks or chemical compounding facility as outlined beneath 503A of the Federal Food, Drug, and Beauty act. Additional highlighting its protecting capabilities, BPC-157 has been proven to defend the cardiovascular system from disturbances caused by local anesthetics, potentially decreasing the risk of irregular heartbeats19.

By recognizing these key factors, healthcare professionals can make sure the maximal benefits of BPC 157 therapy for each individual. Research research play a pivotal function in determining how BPC 157 interacts with the physique at numerous dosages and durations. Understanding the effects on the physique is paramount to gauge its long-term implications. Exploring the dosage guidelines for BPC 157 reveals its potential in addressing gastrointestinal points and supporting general wellness, with research highlighting its efficacy in numerous well being conditions.

Mechanical evaluation of the sample ligaments suggested that the TB-500-related changes in collagen structure may translate into useful positive aspects. To explore their makes use of in scientific analysis, examine our detailed explanation on why researchers are exploring oral peptides. When choosing the right therapy, the tactic of software should also be taken into consideration. For TB-500 peptide, this is mainly restricted, whereas with BPC-157 it might be administered orally and subcutaneously. The mechanism of action is based totally on increasing the extent of anti-inflammatory cytokines (IL-4, IL-10) while lowering the invasion of pro-inflammatory cytokines (IL-6, IL-1β, TNF-α). Until more research is carried out, we don’t know all of the populations that should avoid TB4 and TB-500. There could be undiscovered medicine interactions or reactions with certain medical circumstances (which is considered one of many reasons why we extremely suggest solely using these peptides under the steerage of a doctor).

I typically use an analogy to elucidate the relationship between these two peptides to my shoppers. BPC-1575 is kind of a highly skilled field medic despatched on to the positioning of an harm. It works incredibly properly proper the place it is needed, particularly on tendons, ligaments, and the gut lining. It travels throughout the physique, coordinating the complete restore effort, managing inflammation systemically, and selling therapeutic in a extra widespread, foundational way.

When taken orally or injected, these peptides work by growing the degrees of sure hormones that stimulate muscle cells to develop and repair themselves faster. Moreover, TB-500, also referred to as Thymosin Beta-4, is a robust peptide that helps promote the regeneration of damaged tissue and encourages new cell development. It does this by increasing the production of essential proteins similar to actin and myosin—the fibers that control muscle contraction.

TB4 is vital for the development and production of lymphocytes into T cells and is a crucial part of the immune and endocrine techniques. TB-500 has been the major focus of numerous research for its potential to redefine how accidents are handled and tissues are repaired. Utilizing each tools collectively eliminates guesswork, guaranteeing quicker recovery, reduced irritation, and optimized therapeutic outcomes. Pairing our TB-500 Dosage Chart with the TB-500 Peptide Dosage Calculator ensures accurate dosing for damage recovery, joint healing, and irritation discount. Whereas some issues have been raised about TB-500’s potential to promote cancer progress, present research is inconclusive. It Is essential to consult with a healthcare professional, particularly when you have a history of most cancers.

We’ll examine how it works, and from there we’ll see its potential benefits and side effects. Moreover, we may even let you know about its dosage pointers so that you are fully aware of this compound. At All Times consult qualified healthcare suppliers and rely on evidence-based practices for your well-being. While the allure of quick fixes like TB-500 is powerful, it is essential to weigh the potential risks towards the unproven benefits. Using unapproved substances not solely jeopardizes individual well being but also raises ethical and authorized points, especially when medical professionals are concerned. But a peptide that can be utilized across a wide range of tissues offers immense value to researchers3. Moreover, their truthful pricing ensures researchers can access top-quality peptides with out breaking the financial institution.

Correct handwashing and sterilization of the injection web site are essential steps to prevent complications. Based Mostly on analysis and athlete suggestions, the beneficial TB 500 dosage for optimum results varies relying on individual wants and therapy targets, highlighting the importance of customized dosing. While it shows therapeutic promise, there are few studies accomplished on this topic and the results to this present day are in battle with each other. Researchers excited about exploring TB-500 unwanted effects ought to notice that thus far, Thymosin Beta four use has not been extensively studied in people.

best dianabol cycle

References:

test and dianabol cycle [https://wgbteam.ru/user/steamcolon7/]

4 iu hgh per day results

References:

hgh dosage (https://bio.slak.us/katherinal)

penis enlargement hormone

References:

the best testosterone steroid (https://git.unitsoft.io/barrycummins9)

can women take cjc 1295 ipamorelin

References:

Jay campbell ipamorelin (https://codimd.fiksel.info/XQsT63rvSV-Dqt51-BlB3Q/)

ipamorelin vs igf-1 lr3

References:

https://www.jobindustrie.ma/companies/ipamorelin-dosage-guide-optimal-protocols-for-recovery-and-muscle-growth/

cjc1295 ipamorelin results

References:

https://gitea.mocup.org/carolinetrotte

cjc 1295/ipamorelin

References:

https://bengtsen-mcneil-4.hubstack.net/ipamorelin-side-effects-things-you-should-know

Argentina football live score, follow Messi and the national team with instant updates

我們提供台灣最完整的棒球即時比分相關服務,包含最新賽事資訊、數據分析,以及專業賽事預測。

官方數據源24小時即時更新nba賽程表比分、賽程表,以及NBA球星數據統計和表現分析。

handicap en apuestas eurocopa (Mandy) que significa

Euro Cup live scores, European Championship matches with real-time goal updates

como ganar apuestas de perros en vivo (Tanesha) en vivo

marca casa De apuestas que regalan dinero código promocional

超人和露易斯第二季高清完整版,海外华人可免费观看最新热播剧集。

apuestas deportivas en uruguay (https://Www.Pllattoneria.it/) de todo tipo

wettbüro kaiserslautern

My web page – gratiswette heute [rlquality.com.br]

online sportwetten mit paypal

wett

sportwetten gewinnen mit strategie

Feel free to visit my website basketball-wetten, Tonya,

einzahlungsbonus sportwetten

Look into my blog post :: wetten prognosen heute

sportwetten bonus ohne einzahlung neu

Also visit my homepage Halbzeit endstand wette

what happens when you call The gambling helpline great united statesn casino everett, 888 poker withdrawal united states and

how can i play online poker in united states, or milwausaee casino entertainment

bester dfb pokal wettanbieter

Feel free to visit my page – sportwetten österreich steuern

best pokies app united kingdom, united statesn poker and

au slots bonus codes 2021, or united kingdom poker 95 download

Feel free to visit my website … What are the odds on double zero roulette

casino uk pay by phone bill, online usa real money casino and usa slots no deposit free spins, or

top paying online casinos united states

my webpage :: should i leave my gambling Husband

free slot machine games united kingdom, Casino Digital Craps online free

spins no deposit uk and high roller pokies united states, or is top online pokies and casinos united states pokies

online casino free bet no deposit uk, free spins no deposit casinos canada and uk online casinos free

play, or bet365 play united statesn roulette online uk

Have a look at my blog post – samurai of hyuga gambling (Clint)

gold coast casino australia, gousaos quest free spins no deposit and free spins no deposit uk low

wagering, or new casino no deposit bonus 2021 uk

Feel free to surf to my website Missoula casinos

ladbrokes slots uk, best rated online pokies new zealand and golden pokies united states,

or yukon gold blackjack

Feel free to visit my web blog – games in casino pride (Jamie)

Australian Open live scores, first Grand Slam of the year covered comprehensively

Ofertas Bienvenida Apuestas consejos

Hmm it appears like your website ate my first comment (it was extremely long)

so I guess I’ll just sum it up what I wrote and say,

I’m thoroughly enjoying your blog. I too am an aspiring blog writer but I’m still new to the

whole thing. Do you have any suggestions for newbie

blog writers? I’d definitely appreciate it.

my web site webpage

海外华人必备的iyf平台采用机器学习个性化推荐,提供最新高清电影、电视剧,无广告观看体验。

Oh my goodness! Amazing article dude! Thank you so

much, However I am encountering troubles with your RSS.

I don’t know why I can’t subscribe to it. Is there anybody else getting the same

RSS issues? Anybody who knows the answer will

you kindly respond? Thanks!!

Stop by my homepage: chukchansi casino bus Trips

top bingo site uk, are there casinos in philippines there casinos in saskatchewan canada and blackjack mulligan usa, or how to play

united statesn poker

Sponsor announcements, commercial partnerships and deals covered

regulation of gambling in canada, 21 dukes casino and top

10 usa gambling sites, or real money pokies canada safe and secure

Here is my homepage … online casinos legal oder illegal; James,

5$ deposit casino canada, united statesn original slot machine game

and online casino uk casino club, or bet online casino

uk

Feel free to surf to my web site; roulette simulator freeware (Valerie)

Hey I know this is off topic but I was wondering if you knew of

any widgets I could add to my blog that automatically tweet my newest twitter updates.

I’ve been looking for a plug-in like this for quite some time and was hoping maybe you would have some experience with something like this.

Please let me know if you run into anything.

I truly enjoy reading your blog and I look forward to your new updates.

My web site ess login rivers casino schenectady (Doyle)

top 10 usa casinos, western australian poker league and online gambling poker australia, or 007 james bond casino royale cast (Mark)

classic uk

the top online pokies and casinos in united states legit, 10 dollar minimum deposit

usa online casino 2021 and new zealandn jelly bean casino

bonus codes (Francisca) no deposit bonus codes, or slots

frenzy

united kingdom poker deluxe 2, united statesn roulette odds and real money slots app canada, or when was the first casino demo

play 2 (Sheena) built in australia

online gambling legal in united states, united statesn roulette rules usa and no deposit bonus slots australia, or new casino no deposit bonus 2021 uk

Visit my blog; homer simpson blackjack dealer,

Heriberto,

online casino games australia Blackjack card game Free no download, usa casino opening dates and best online

slot new zealand, or las vegas usa casino $100

You are so interesting! I don’t think I have read through anything like this before.

So wonderful to discover somebody with best gambling odds In a Casino few unique thoughts on this subject matter.

Really.. thank you for starting this up. This site is

one thing that’s needed on the web, someone with a little originality!

australia merlot wine slot, yukon gold casino news and free online pokies win real money united kingdom, or legal age for gambling in australia

my website – Goplayslots.Net

online pokies free spins on sign up canada, 888 casino canada promo code and online

gambling uk legal, is roulette skill or luck; Dolly, apple pay online casino united

states

free chip no deposit bonus codes 2021 canada, royal caribbean singapore casino (Keesha) sites in usa and united kingdom pokies no deposit bonus, or online bingo usa promotions

pokies return rate canada, united kingdom no deposit signup bonus casino and blackjack canada

online, or online casino slots real money

canada

Have a look at my web blog :: goplayslots.net

Real money online casino no deposit Australia – free cash offers

Wow that was strange. I just wrote an incredibly long comment but after I clicked submit my comment didn’t appear. Grrrr… well I’m not writing all that over again. Regardless, just wanted to say superb blog!

best online poker sites for australia, casinos uk and is casinos illegal in uk, or no deposit casino real

how to make money online matched betting (Heriberto) usa

regulation of gambling in canada, united states day free

spins and best online casino united kingdom real money, or usa super Top 10 Casino cities

wettbüro kaiserslautern

Feel free to visit my web site; online Wetten mit startguthaben

范德沃克高清完整版,海外华人可免费观看最新热播剧集。

sportwetten tipps von profis

Here is my page Buchmacher Vergleich (https://Join.Epicode.Com/)

wie am besten wetten

Feel free to visit my webpage – sportwetten Lizenz Curacao

beste online sportwetten seite

Also visit my page: wetten basketball Bbl

sportwetten online Wetten (http://Gratis-Wetten.com/) oddset

mehrfach kombiwette rechner

Feel free to surf to my web-site sportwetten in meiner nähe

wettanbieter deutschland lizenz

Here is my web blog :: Halbzeit Oder Endstand Wette

wettanbieter vergleich paypal

my homepage :: super Bowl wetten deutschland – http://www.kidscoding8.com –

die besten wettanbieter in deutschland

Feel free to visit my blog … halbzeit oder endstand wette

I will right away seize your rss as I can not to find your e-mail subscription link or e-newsletter service. Do you have any? Please allow me know in order that I could subscribe. Thanks.

gratis sportwette ohne einzahlung

Review my site; beste Sportwetten Anbieter

Thank you for every other excellent post. The place else may just anybody get that kind of information in such a perfect approach of writing? I’ve a presentation subsequent week, and I’m on the look for such information.

塔尔萨之王第三季高清完整版运用AI智能推荐算法,海外华人可免费观看最新热播剧集。

What a data of un-ambiguity and preserveness of valuable familiarity on the topic of unpredicted emotions.

pferderennen köln wetten

Take a look at my website – buchmacher test

夜班医生第四季高清完整版结合大数据AI分析,海外华人可免费观看最新热播剧集。

bester bonus sportwetten

wetten vergleich

sportwetten Mit paypal österreich

welcher wettanbieter ist der beste, Monika, sportwetten prognose

pferderennen magdeburg wetten steuer österreich

wettanbieter ohne lugas mit paypal

Stop by my site :: wette tipps Heute

Hi, I do believe this is an excellent website. I stumbledupon it 😉 I’m going to come back yet again since I book-marked it. Money and freedom is the greatest way to change, may you be rich and continue to help other people.

wetten tipps prognosen

my web site – gratiswette code ohne einzahlung – Jamison,

sportwetten einzahlungsbonus vergleich

Here is my web-site: wettanbieter Paypal deutschland

sportwetten wo am besten

my web blog :: sportwett anbieter – Colette,

I’m really enjoying the theme/design of your website. Do you ever run into any browser compatibility problems? A couple of my blog audience have complained about my site not operating correctly in Explorer but looks great in Safari. Do you have any ideas to help fix this issue?

sportwetten in meiner nähe

my webpage :: handicap wetten bwin

leon sportwetten

My page; wettbüro maximale auszahlung

wetten bonus

Here is my page betibet sportwetten online deutschland (Trista)

Hmm it looks like your site ate my first comment (it was super long) so I guess I’ll just sum it up what I had written and say, I’m thoroughly enjoying your blog. I too am an aspiring blog blogger but I’m still new to everything. Do you have any tips for rookie blog writers? I’d definitely appreciate it.

wett tipps ai kosten

Here is my site wettbüro hamburg

kombiwette pferderennen

Here is my website – seriöse wettseiten

halbzeit wetten

Feel free to visit my webpage; Beste Sportwetten App

paysafecard Wettanbieter (Cdo.aggr.university) ohne

lugas mit paypal

捕风捉影在线免费在线观看,海外华人专属平台运用AI智能推荐算法,高清无广告体验。

was sind handicap wetten

Also visit my blog post; die besten sportwetten seiten

biathlon wettquoten

Have a look at my web-site :: Wettseiten Mit Startguthaben (https://Ninthoceancrypto.Com/)

Very nice post. I absolutely appreciate this website. Stick with it!

ifvod平台结合大数据AI分析,专为海外华人设计,提供高清视频和直播服务。

krypto wettanbieter

Feel free to visit my web blog; Kombiwette quote Berechnen

sportwetten strategie ohne Verlust – new.Psilon.pl – anbieter vergleich

夜班医生第四季高清完整官方版,海外华人可免费观看最新热播剧集。

It’s awesome to go to see this web page and reading the views of all mates concerning this paragraph, while I am also eager of getting experience.

was bedeutet handicap wetten steuer öSterreich

wett tipps ai erfahrungen

Feel free to visit my blog post; wettbüro augsburg – Janette –

neue wettseiten

Feel free to surf to my web site Live Wetten Deutschland

gratiswette bei registrierung

Also visit my web page :: Wette handicap

wettbüro leverkusen

my website: wettstar sportwetten

strategien für sportwetten

Here is my homepage :: was ist eine kombiwette

wetten heute tipps

Also visit my web blog: wettanbieter in Deutschland

sportwetten quotenvergleich

Also visit my website; wettseiten mit bonus

bester alphabet wettanbieter

Also visit my web page: wett app mit paypal – server399601.nazwa.pl,

livescore für sportwetten

Feel free to visit my blog gegen den euro wetten (Gia)

sportwetten tipps bild

Feel free to surf to my web page: wettquote us wahl (Damion)

beste sportwetten quoten

Feel free to visit my webpage – asiatische Buchmacher

beste quoten wettanbieter wett tipps heute

online wetten erfahrung

My blog post: Buchmacher pferdewetten

online sportwetten mit paypal

my website … beste skispringen Wettanbieter

wetten bonus angebote

My web blog :: beste wettseiten österreich

bonus vergleich sportwetten

My web-site: Wettquote Us Wahl

kombiwette eine falsch

my web site – sportwetten heute tipps