评估运动员在比赛中的表现对于实现有效的体育教练至关重要。然而,对球拍类运动中运动员的定量评估是困难的,因为这需要从复杂的战术和技术表现的综合中得出。作者提出了一种基于深度强化学习的球拍类运动评估的新方法,它可以更详细地分析球员的动作,而不仅仅是考虑得分情况。该方法使用历史数据来学习下一个球运动员得分的概率,并把它作为 Q 函数用于评估球员的表现。我们利用 LSTM 模型来学习 Q 函数,其中球员的姿势和球的位置作为输入,分别由 AlphaPose 和 TrackNet 算法识别。作者通过比较各种基线来验证他们的方法,并通过分析顶级羽毛球运动员在世界级赛事中的表现的用例证明了该方法的有效性。

方法

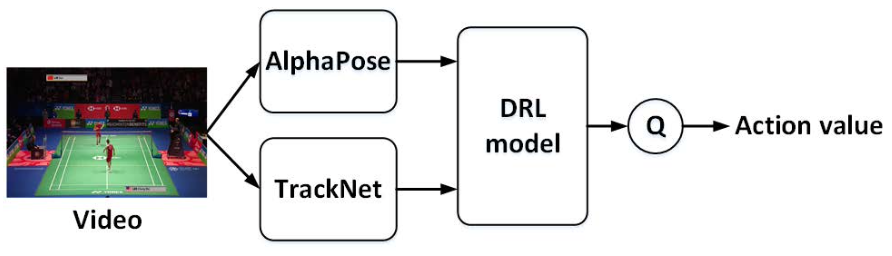

如图所示,是对论文中提出的方法的概述。使用 AlphaPose 和 TrackNet 对球员的姿势估计和羽毛球位置检测,然后是用于估计 Q 函数的 Deep Reinforcement Learning 模型。给定一个 Q 函数后,action的value就被定义为动作引起的 Q 值的变化。

羽毛球是一项竞技运动,比赛采用三局两胜制,每局21分。一颗球从发球开始,在某方得分时结束。为了描述一场羽毛球比赛,我们将一颗球作为分析的基本单元。每一颗球包含一系列的击球动作,其过程可以描述为不同状态之间的相互转换。

通过使用羽毛球比赛的视频数据,我们首先将一场比赛中的每局切分成基本单元。对于每颗球,作者使用 AlphaPose 估计了鼻子、眼睛、耳朵、肩膀、肘部、手腕、臀部、膝盖和脚踝关节位置的坐标,并使用 TrackNet 检测羽毛球位置。AlphaPose 是一种流行的高精度多人身体姿势估计系统,TrackNet 是一种对象跟踪网络,已被证明在高速球类游戏中表现出不错的跟踪能力。

关于处理数据时的特殊情况,主要有两个:一个是通过 COCO 注释器对由于重叠而未正确估计的关节位置进行标注,COCO是一个监督学习的数据集。另一个,假设两个脚踝的中点表示玩家的位置,姿势表示为相对于玩家位置的一系列坐标,对于左手持拍的运动员,作者颠倒了相应的相对坐标。

将动作的坐标和球的坐标组合为 DRL 模型的输入特征向量,应用 DRL 方法估计 Q 值,最后从 Q 值中获得动作值,用于评估运动员的表现。根据运动员相对于摄像机的位置,我们将比赛中的两名运动员分为前和后。离镜头更近的是前面;相反,离相机更远的是后面的。

建模

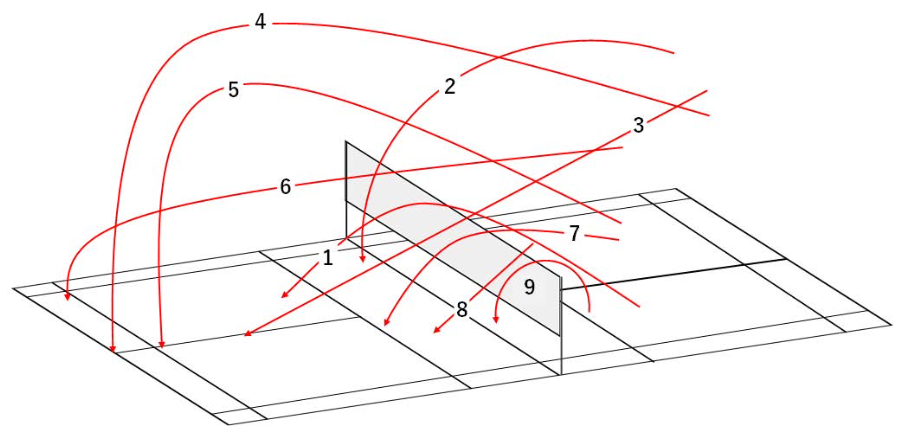

奖励 R 表示赢下了当前这颗球的一方。动作 a_t 被划分成9种情况,如图所示,(1) 表示发球,(2) 表示劈吊球,(3) 表示杀球,(4) 表示高远球,(5) 表示挑球,(6) 表示平抽,(7) 表示挡网,(8) 表示封网,(9) 表示放网。状态 s 表示为每次击球瞬间的特征向量,包括球的位置,球员的位置等。

Q函数 Q(s,a) 表示运动员赢下当前这一分的条件概率

Q_{front/back}(s,a) = P(point=1|s_t=s,a_t=a).事实上,Q函数计算了给定状态下选择一个动作的期望奖励。

学习Q函数

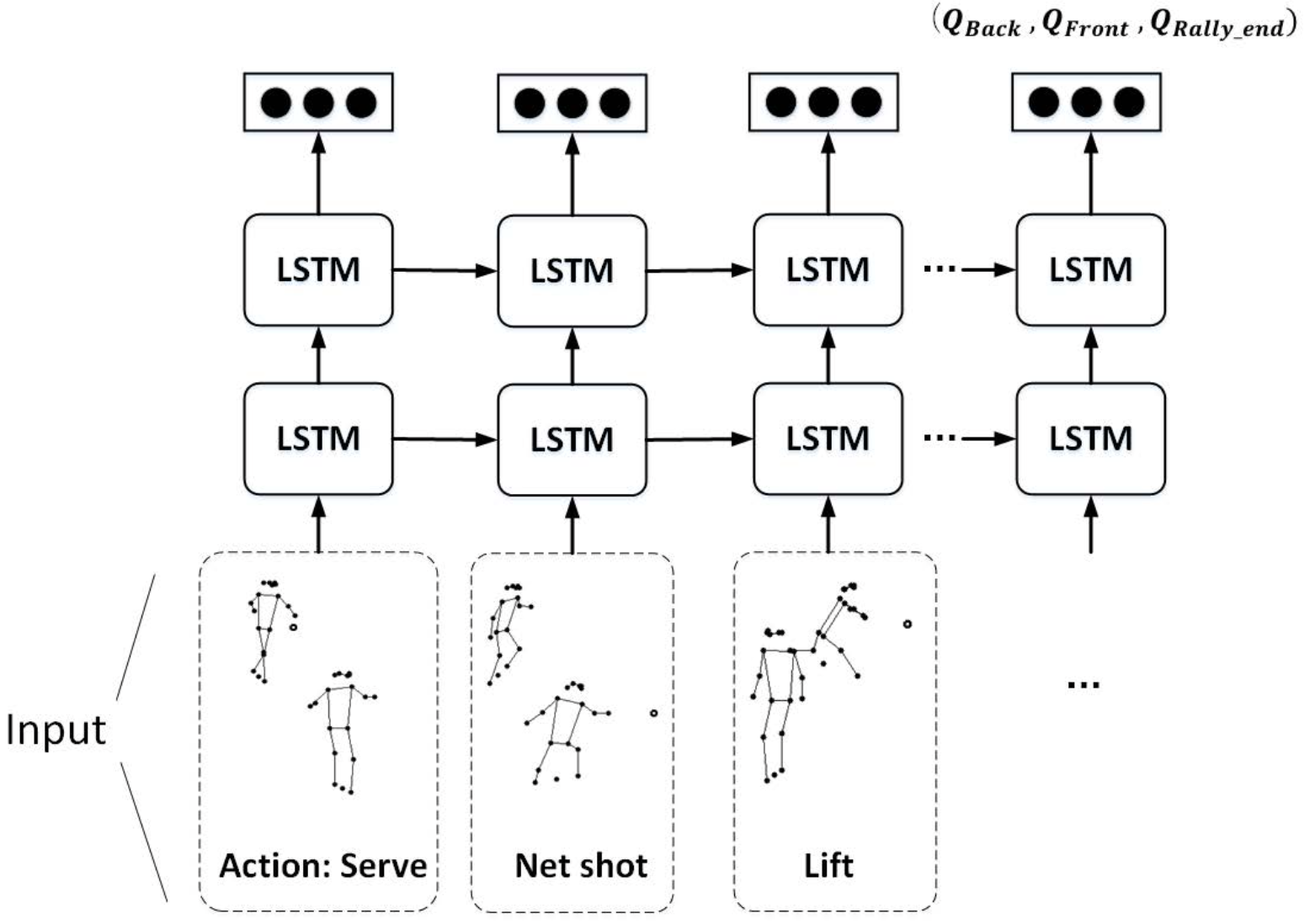

如图所示,展示了论文中使用的DRL的框架。使用的网络模型是两层的LSTM,网络模型的输入是在每个关键帧(击球帧)状态和动作的序列。一个完整的序列对应一分球,或者说一颗球从发球到得分的整个过程。LSTM的输出有三个值,Q_{Back}(s,a),Q_{Front}(s,a) 和 Q_{Rally_end}(s,a),分别表示两个运动员各自赢下这一分的条件概率以及这一分球在下一个时刻结束的概率。

这里学习出来的Q函数是动作值函数的近似,并且使用on-policy算法来估计Q值

Q(s_t,a_t) \gets Q(s_t,a_t) + \alpha[R+\gamma Q(s_{t+1},a_{t+1})-Q(s_t,a_t)].当然,这是tabular方法,相同的思想迁移到网络上,只需要定义如下的损失函数即可

\mathcal{L} = \frac{1}{n}\sum_{t=1}^{n}\left(R+\gamma Q(s_{t+1},a_{t+1})-Q(s_t,a_t)\right)^2.实验

实验所需数据非常简单,只需要一些比赛视频即可。作者从世界羽联官网上下载了从半决赛到决赛的男单视频进行分析。

关于实验的设计和分析,是比较粗糙的。首先,作者尝试使用不同的网络模型和不同的输入特征来判断是否能够获得更优的损失函数最小化效果。然后,作者汇总了每个运动员在每种不同类别的动作下的平均值函数,从而区分出同一场比赛中发挥较好的一方。最后,作者将模型的输出与真实的比赛结果以及世界排名做了对比,发现论文提出的模型具有较高的代表性。

总结

这篇论文汇总了羽毛球运动建模所需的各种技术手段,对后续的工作起到了很好的铺垫作用。

Some bodybuilders make the most of Anavar all yr round,

just like testosterone replacement remedy (TRT).

Nevertheless, this isn’t beneficial due to extreme hepatic and renal toxicity.

It Is especially good for chopping cycles, aiming for lean muscle while shedding fats.

While it might possibly help burn fat when combined with a calorie-deficit food plan and training,

Oxandrolone doesn’t instantly trigger fat loss itself.

The duration of an Anavar cycle remains typically consistent from the beginner

to intermediate degree, extending from six to eight weeks. It offers

enough time to experience notable gains without overworking the physique or inviting pointless unwanted effects.

As an intermediate Anavar person, the dosage could be slightly greater than the beginners’ dose.

A typical vary lies between 50 to 100 milligrams per day, again relying

on an individual’s particular wants and tolerance ranges.

When stepping up the dosage, one should listen fastidiously to their body’s

feedback. Making this adjustment cautiously and attentively

paves the method in which for optimal results.

When stacking Anavar, you will want to select the right

dose. Anavar is usually used at a dosage of 20-30mg per day, however some users might use

up to 80mg per day. It is necessary to begin out with a decrease dose

and progressively improve it as your body adjusts. If you are new to Anavar, it is recommended that you

just begin with a low dose. For men, a dosage of 20-30mg per day

for 6-8 weeks is an effective place to begin.

For girls, a dosage of 10-15mg per day for 6-8 weeks is really helpful.

Anavar is considered a gentle steroid, with low androgenic effects and

high anabolic results. It is not as potent as different

anabolic steroids, but it’s nonetheless effective

in promoting muscle growth and power positive aspects.

It can be less likely to cause side effects corresponding to gynecomastia (male breast enlargement) and water retention. Like the gents, female Anavar users’ cycles sometimes span six to eight weeks.

This time-frame allows for vital enhancements in muscle tone, vascularity, or strength without pushing the

physique right into a danger zone of extended publicity

to the compound. In case of stacking, women can take into consideration teaming up Anavar with other gentle steroids, maintaining the dosage low.

This method ensures concord between compounds and maximizes the potential of their bodybuilding quest.

The only way to safeguard against any danger is to have

a prescription for any anabolic steroids taken. Subsequently, if a soldier has low testosterone and is prescribed TRT,

if he checks constructive for testosterone, it will come again as

negative to the commander. Clenbuterol is sometimes referred to as a cutting steroid like Anavar.

Nonetheless, clenbuterol is not an anabolic steroid; therefore, we do not see it affecting natural testosterone ranges to any vital degree.

The main function of post-cycle remedy is to restart endogenous testosterone

manufacturing. This aids in normalizing hormone levels for optimal physiological and psychological health, in addition to retaining

outcomes from a cycle. Anavar’s benefits usually are

not overly powerful, at least compared to different anabolic steroids;

due to this fact, the unwanted effects are more tolerable for many customers.

The follow-up cycle to this generally begins with a dose

of 20 mg instead of 15 mg and is prolonged up to 8 weeks.

Click right here now to get one of the best deal on Anvarol and

start your journey towards reaching your physique objectives safely.

By submitting this kind, you comply with Asana Recovery’s Privacy Policy.

You additionally consent to Asana Restoration contacting you by telephone,

text message, and e-mail concerning your insurance advantages and remedy

services. At Asana, we offer efficient, insurance-covered remedy for

addiction and psychological well being, guided by consultants who understand because they’ve been there.

Depending in your bodybuilding level, whether you’re beginning, sustaining, or mastering, the

usage and cycle of Anavar will differ. It’s important to grasp its specifics to ensure you’re not solely getting the desired outcomes, but

you’re also maintaining your health in check. It’s advisable to begin on the decrease end of the dose range,

particularly for first-time customers, and steadily enhance if wanted based on effects and tolerance

ranges. Exceeding really helpful doses considerably increases the danger of unfavorable side

effects.

Phosphocreatine is necessary for producing vitality

during quick, intense bursts of activity, corresponding to

lifting weights. Anvarol can help you to train tougher and longer

than earlier than, resulting in amplified muscle progress and quicker gains in strength and measurement.

However, there are studies suggesting clenbuterol has muscle-building results

in animals (32).

Experienced users of steroids may have the ability to tolerate greater doses of

Anavar, however it’s nonetheless necessary to be cautious and begin with a lower dose to see

how your physique reacts. If you’re new to using steroids, it’s essential to start with a decrease dose of Anavar to see how your body reacts.

Newbies should begin with a dose of round 20-30mg per day and

gradually improve it if needed. Anavar is a popular steroid for girls as a result of it’s relatively mild and has fewer side effects than some other

steroids. While Anavar just isn’t as potent as another steroids in terms of constructing muscle mass, it

could still help you gain energy and enhance your physique.

This is very true when mixed with a nutritious diet and common exercise routine.

In summary, when planning an Anavar cycle, it could be very important consider the size of the cycle, the dosage, and the stack used.

The beneficial dosage of Anavar for athletes is 25-50mg per

day. Anavar is a mild steroid, so even if you are new to utilizing steroids – you need to be

fine starting at the higher end of the dosage range.

The value of Anavar can differ depending on where

you buy it and the standard of the product.

References:

https://www.valley.md

Due to high demand, Dianabol is a comparatively low-cost steroid and widely

out there, making it very affordable, which makes it

an attractive option to those who are new to utilizing steroids.

5mg and 10mg energy tablets are the commonest, but some makers have created single capsules at 25mg or even 50mg in one dose.

Increased energy will power your muscle positive

aspects, and users will not often complain in regards to

the energy enhancement that Dianabol produces. If we are talking about whole

weight, you must include water as a outcome of there’s no

escaping the fluid retention that Dianabol causes (but you’ll have the ability to actually mitigate it as a

lot as possible). If you have current ldl cholesterol issues,

you must keep away from utilizing Dianabol completely.

This is the place a post-cycle remedy plan is critical, with SERM medicine

like Nolvadex and Clomid being important to have on hand, able

to go. These medication accelerate your testosterone recovery and effectivity while ranges are beginning to get again to

regular naturally.

Correct on-cycle support, post-cycle therapy (PCT), and monitoring

are essential. His exercises not left him feeling exhausted,

and this renewed energy led to considerable enhancements in his

lifting efficiency. John balanced intervals of Dbol intake

with enough breaks, thereby permitting his body to get the desired benefits whereas additionally having time to recover.

Crucially, Dianabol excels in synergy with other steroids quite than serving as

a standalone base. When combined with different steroids, Dianabol

enhances their effects significantly. For

occasion, stacking Dianabol with steroids like Trenbolone, Masteron, or Equipoise amplifies

outcomes far beyond their particular person capacities.

This is as a end result of estrogen (the girly hormone) also rises when testosterone goes too excessive.

However, your genetics will determine if you kind gyno or not from taking dianabol.

Proper rest and restoration are also essential for preventing overtraining and harm.

For those trying to pack on critical dimension, the mix of Dianabol, Deca-Durabolin, and testosterone could be an effective possibility.

This stack offers a potent anabolic environment while additionally promoting joint support and restoration. This mental and emotional influence could be highly beneficial for benefiting from the physical features

the steroid provides. The undeniable fact remains – no quantity of

Dianabol tablets for bodybuilding or hours spent at the fitness center will get

you the specified consequence in case your dietary habits are off track.

Even Dbol, with all of its muscle-gain reputation, necessitates

the backing of a properly aligned food regimen.

Using the best dosage of Dianabol is crucial as a result of it impacts the results and

unwanted effects you may expertise. Dianabol offers you complications due to the increased blood move to

your mind. It has been used to treat folks with muscle-wasting ailments as a outcome of HIV or other medical situations ensuing from malnutrition and poor development or lack thereof.

Dianabol half-life in the body could be between a mere hour and a full day, depending

on how a lot you’re taking and what sort of Dianabol you could have been taking for the

Dianabol cycle. Dianabol just isn’t a miracle drug and will solely

work if you’re training hard in the health club every day, it won’t do all of the work for you.

If you’re trying to lose weight/fat Dianabol might very properly be value contemplating.

This helps you recover sooner and train harder, which may trigger increased vitality

ranges throughout exercises (and after).

Dr. Scally has efficiently treated 100 males for hypogonadism with efficient PCT protocols such as

this one. Thus, for max effectiveness, Dianabol ought to be taken on an empty abdomen, without food.

Salicylic acid is another widespread zits treatment; nevertheless,

that is much less effective compared to retinoids. Topical antibiotics are also an advantageous remedy for acne, lowering inflamed lesions by 46-70% (27).

To avoid such resistance, antibiotics ought to contain benzoyl peroxide, which will additional cut back inflammation.

This signifies that delicate people, taking higher doses of D-Bol can develop gynecomastia (gyno).

There’s additionally evidence to suggest that steroids have a everlasting impact on the myonuclei inside your muscle

cells (34). In one study, mice have been briefly uncovered to anabolic steroids, which led to important muscle growth that

returned to normal levels when steroid use

was discontinued. DHT is answerable for the event of body hair, prostate,

penis measurement (during puberty), and libido.

Some of us find back pumps turn into a problem, principally at larger doses.

Once you start feeling these pumps in the fitness center (and outdoors of it), it’s a

great sign that your Dbol is working as it ought to be – and it feels unbelievable.

Used intelligently, Dianabol is often a potent software for critical athletes — however it is not a shortcut or a substitute for correct coaching,

nutrition, or long-term planning.

At the opposite finish of the spectrum are labs

that pay little to no consideration to quality or hygiene, and it’s these steroid providers that can put your health

at important risk. Dianabol is a steroid all the time in excessive demand, so

nearly each underground lab will manufacture it, and this retains

the value of Dbol down as one of many cheaper steroids we are able to buy.

Rather than order from pharmacies abroad, many individuals will journey

to the international locations the place Dbol is bought overtly in pharmacy stores and purchase and

use it there. This can go some approach to clearing up

the legal dangers in your personal nation, however it may

possibly doubtlessly put you at authorized danger abroad.

Shopping For Dianabol requires working outdoors the legislation, so that you should be prepared for all the dangers.

References:

https://www.valley.md/dianabol-tablets-what-brands-and-prices-are-available

The tren trade extends past fundamental channels, and it contains “tren”

impostors sold to capitalize on the hype around the real factor.

Earlier this 12 months, Mackey demonstrated how one might discover tren purportedly supplied

for sale on the web music-community platform SoundCloud.

I work out at my residence gym so I don’t have connections with anyone at a giant globo health club.

Customers can navigate product classes and find the necessary info

quickly. With a secure checkout course of and dedicated customer help, prospects can confidently find the most effective product.

Each kind of Tren offers distinctive benefits, and selecting the

proper form depends on expertise level, objectives,

and personal preferences. Solely logged in customers

who’ve purchased this product may leave a evaluate.

❸Our CSR will offer you the quotation, payment term, tracking number, supply ways,

and estimated arrival date(ETA).

As always, remember to use it responsibly to maximise these advantages

and reduce potential dangers. Its lipolytic properties enable environment friendly fats burning whereas

retaining lean muscle mass. This helps you attain a toned and sculpted appearance as

a substitute of merely shedding weight. Boosting muscle development, environment

friendly fat loss, and growing red blood cell count for better oxygen transportation are some Tren Ace hallmarks.

Remember to seek suggestions, learn buyer reviews, and consult with professionals to gather

insights and make well-informed selections. Compliance with legal

and regulatory standards is crucial to prioritize your security and avoid purchasing

from unregulated or unlawful sources. The manufacturing and distribution costs incurred by Trenbolone producers and suppliers also influence the pricing.

Moreover, it promotes protein synthesis and nitrogen retention,

essential elements in muscle growth. It Is additionally recognized for enhancing muscular definition and hardness,

making it a favourite for pre-contest preparation. Trenbolone is a synthetic anabolic steroid that was first developed within the 1960s.

Initially created for veterinary use to advertise muscle growth and enhance feed effectivity in livestock, it

quickly gained attention for its highly effective anabolic properties.

Over time, its utilization expanded beyond

veterinary functions and have become popular amongst

bodybuilders and athletes seeking important gains in muscle mass, energy,

and performance.

Some nations have stringent laws against the sale and possession of steroids, whereas others are extra lenient.

Subsequently, it is crucial for potential buyers to familiarize themselves

with their local legal guidelines earlier than deciding to buy Trenbolone online.

The effects of Trenbolone Acetate have brought on many to deem it the ultimate bodybuilding steroid.

It often happens shortly after a tren injection, probably

as a result of a part of it was by accident launched into the circulatory system, making its means

into your lungs. He typed “trenbolone buy” into the search bar and various

other playlists appeared. Amongst these playlists was one 13-second clip titled “Where to Get Tren – The Place to Purchase Trenbolone Online.” The

corresponding picture was a shirtless muscular man, along with text

about tren. After the consumer selected the playlist, the following page revealed an outline that included an official-looking

link, naspcenter.org/Get-Trenbolone.

In a nutshell, Tren Ace is an important part of any cycle

the place the purpose is to get muscular and ripped.

Just keep in mind, harnessing its full potential is all about understanding the means it works and using it

responsibly. Whether you are a newbie or a professional bodybuilder, understanding Tren Ace is crucial.

Tren Ace is your ticket to huge transformations in strong muscle progress

and crazy definition. It is crucial to note that Trenbolone has turn out

to be a managed substance in many countries such as these within the Usa and Canada as well as numerous international locations in Europe.

This classification makes the use of Trenbolone in any capacity; possession, purchasing or selling of the

substance without the prescription as unlawful and attracts severe authorized consequences.

Sure, Trenbolone is a controlled substance in many countries and requires a legitimate prescription for

legal use.

It also promotes quicker recovery of the

torn muscle, which is where the actual benefits are. In some individuals,

it’d affect cardiovascular well being, but in all, it increases muscle

power and endurance. Trenbolone cycles are very effective as either fat

loss or muscle constructing mass cycles. This is of explicit importance in terms of the catabolic

hormone Cortisol, which Trenbolone ought to effectively have

the power to inhibit[16]. Furthermore, Trenbolone’s effectiveness as a fat loss agent is properly

documented through its unimaginable nutrient

partitioning effects[17]. We additionally know that androgen receptors certainly exist in fat cells and play a

role in fat loss when activated[18], particularly the stronger an androgen binds to this receptor[19][20].

References:

primaryonehealth

After a cycle, the ALT and AST enzyme ranges of an individual usually revert to regular inside a brief time

body. To prevent extra liver damage, anavar steroid cycle should

not be used with hepatotoxic substances like alcohol.

In addition, users shouldn’t use Anavar if their liver is already inflamed or injured, since this may

cause more harm. As Quickly As you attain a body fats

share of 9 percent or less, it is now not advantageous on your physique to retain muscle.

At Asana Restoration, we perceive that these selections can be overwhelming.

We present compassionate care and steerage that will help you make one of the best choices.

Mental Health Outpatient Treatment can even tackle any underlying points.

Stacking Anavar with pure testosterone boosters throughout PCT can even help restoration and long-term

hormonal steadiness. Being used solo or in a stack,

Anavar will certainly provide the desired results. All steroids include

execs and cons, but when it comes to Anavar, you possibly can simply say that there are not any cons.

One Other two weeks can be added, but the longer the cycle, the higher the risk

of side effects.

If the beneficial dosage is three capsules per day, then it’s probably best to separate

the dosage into two and take it with breakfast and lunch. CrazyBulk is also providing

a buy-two-get-one-free deal on all of its products at

the moment, so it’s a good time to begin your bulking or

chopping cycle. It additionally helps to preserve muscle mass when you’re cutting

calories, so you don’t have to fret about losing

the progress you’ve made. The majority of those results are brought on when you abuse, take extra dosage or have an underlying/hidden medical situation.

Nonetheless, it’s predicted that this period of recovery could be

fairly brief (a few of weeks) before pure testosterone levels return to normal.

Embarking on an Anavar cycle could be a powerful device in your quest for a leaner, stronger, and extra outlined physique.

Combining Anavar with other compounds must be accomplished with caution and an intensive understanding of

the interactions concerned.

If you are figuring out greater than thrice per week, we

advocate beginning at the lower end of the dosage vary.

If you may be working out three times per week or

much less, you can start on the larger finish of the dosage vary.

If you are new to using steroids, we suggest starting on the lower finish of the dosage vary.

If you could have used steroids before, you can start at the larger finish of the dosage vary.

Some bodybuilders go for legal Anavar alternate options, such as Anvarol,

which mimics Anavar’s fat-burning and anabolic results.

One should begin with a low dosage, often around 20-30mg day by day for men and fewer for women. For

advanced bodybuilders, Anavar doses of mg daily may be used to maximise results.

These cycles usually embrace stacking with other anabolic compounds to enhance efficiency, however such

practices require cautious planning and monitoring.

Nonetheless, the amount of lean mass gained throughout an Anavar cycle

will rely largely on one’s sex, food regimen, training, and

if the drug is “stacked” with other steroids. So judging Anavar results can be a murky proposition, however one that’s

made easier by understanding a lot of what has been written within the

bodybuilding community. That mentioned, take a look at the next matters, lots

of which draw from discussion board threads right here at EliteFitness.com.

Publish cycle remedy (PCT) is really helpful after taking Anavar to help restore your

natural testosterone manufacturing and stop any opposed results.

Figuring out the right dosage is essential when starting an Anavar cycle.

The objective is to search out an amount that’s efficient however minimizes the potential dangers.

It’s usually advised to begin with the lower end of this vary to see how your

body reacts. Pay Attention carefully to your body and pay attention to any adjustments you

expertise. You can gradually modify the dosage, however maintain adjustments small, for instance, 5mg

at a time and at all times talk about these changes with a physician or healthcare skilled if

you’ll be able to.

However, trenbolone produces harsh unwanted side effects and thus is often avoided by beginners.

Testosterone suppression is prone to be extreme, as properly as LDL

levels of cholesterol rising notably in analysis.

Trenbolone causes the most hypertrophy increases in androgen-sensitive muscle teams, such because the trapezius

and deltoid muscles. Trenbolone’s vast androgenicity is why it causes fats loss,

with androgen receptors stimulating lipolysis.

It was believed to be the steroid predominantly used within the Golden Period

to bulk up Arnold Schwarzenegger and other bodybuilders from the Seventies.

This isn’t to indicate that customers can appear to be Arnold by merely taking Dianabol; as you

can see, he had spectacular muscularity whilst a pure bodybuilder.

You can’t miss the massive shifts when you see before and after

TRT photographs. These modifications present what your body can do with the

best assist. TRT photos aren’t just for the before and after—they

offer you hope.

D-bal is a natural, side-effects-free replication of Dianabol

that is fully authorized to use. A few firms with groups of amazing scientists have been in a position to make use of science to formulate dietary supplements that can mimic the consequences of Dianabol without ANY side effects… legally.

If you exceed that, or should you take doses larger than 50 mgs per day, you’ll be able to just about anticipate liver issues eventually.

Most folks take a weaker anabolic substance (something akin to TRT) and an estrogen blocker.

Dianabol, like any other steroid, also needs post-cycle

therapy to be certain to don’t get any nasty unwanted effects.

As I mentioned earlier than, you’re going to additionally gain some water

and fat. Nevertheless notice that even Dianabol can deliver large outcomes it also comes with health dangers.

Success comes from disciplined training, a healthy diet, and watching your

doses. If you need to achieve muscle and energy faster without nasty

side effects of going to jail to turn out to be the following Kali

Muscle, D-bal is best for you. Testosterone suppression will also be notable on Dianabol, with males frequently turning into hypogonadal from reasonably dosed cycles.

After several months, endogenous testosterone ranges typically recuperate; however, if users abuse Dianabol,

then they might experience long-term testosterone

deficiency and infertility. Anadrol and trenbolone are

much less appropriate stacking options, regardless of their profound effects on muscle

constructing and energy. This is as a end result of of Anadrol exacerbating hepatic and cardiac harm,

with trenbolone additionally causing the latter. We have discovered that a further 10

kilos of mass can be gained when adding testosterone or Deca Durabolin to a Dianabol cycle.

Under is a pattern cycle commonly used by weightlifters to

realize a similar before-and-after transformation as the one above.

They solely bind with androgen receptors, that means that they will not have a unfavorable impact on different

components of the body. They are additionally far much less doubtless than steroids to

convert to estrogen. To get the total scoop on SARMs try our

in-depth function here. These aren’t steroids however chemical substances that selectively bind

to androgen receptors inside muscle cells. There is

not any easy answer to the question of how long a steroid stays in a person’s system.

It will depend on the steroid taken, what it’s stacked with, and the physique of the particular person taking it.

While this steroid has quite a few benefits, it’s important to maintain the serious potential dangers

in thoughts as well. In the tip, as you could discover, Dianabol

before and after results could be superior, but

it greatly depends on lots of elements. It’s important to ensure you

do every thing alright not only for the worth of maximizing your gains and outcomes but additionally keeping you wholesome.

You definitely wouldn’t wish to wreak havoc on your

physique and health. But, there’s no way to management androgenic side effects such as pimples,

hair loss, aggression, and others so long as you’re susceptible to them.

This steroid, like any other, can speed them up if you have the genetic trait to develop them.

Moreover, as with all other steroid, you will

discover a decline in natural testosterone manufacturing.

Dianabol is an anabolic steroid primarily used by bodybuilders and athletes to aid in muscle progress,

power positive aspects, and overall efficiency enhancement.

It has been reported that customers can count on an increase in muscle mass and power when taking Dianabol, which could vary

from lbs in 4-6 weeks. As it has been stated earlier, results of Dianabol differ from individual to individual.

This is because of totally different tolerance ranges, dosage and even one thing as main as genetics.

That’s the primary cause why I do not recommend longer cycles

or larger doses. Higher doses and/or longer cycles can offer more/better/faster results, but they

exacerbate the dangers of unwanted effects.

Regardless Of its unlawful status, plenty of athletes and bodybuilders use it all round the

world nowadays. Many individuals think about dianabol cycle before and after a reasonably safe steroid, however then again, provided that you employ it appropriately.

WIN-MAX is designed by CrazyBulk as a substitute, combining high quality elements that can help

you lose fats and potentially even achieve muscle as nicely.

So as an alternative of focussing on getting great trenbolone results in 2

weeks, it’s important to make use of it with caution. Examine out this surprising tren before and after transformation to see the

drastic adjustments. That’s why it’s a lot better/safer to have an adequate break in between cycles while using

this steroid accurately. So, you mentioned to your self that you will take the chance

and can continue operating Dianabol despite its attainable unwanted

aspect effects.

watch porn video

If some one wants to be updated with most up-to-date technologies then he must be pay a quick visit

this website and be up to date daily.

It is perfect time to make some plans for the future and

it’s time to be happy. I’ve read this post and if I could

I desire to suggest you some interesting things or suggestions.

Maybe you can write next articles referring to this article.

I desire to read even more things about it!

RTP-nya beneran tіnggi.

Hey there! I know this is kinda off topic but I’d figured I’d ask.

Would you be interested in exchanging links or maybe guest writing a blog post or vice-versa?

My site goes over a lot of the same subjects as yours and I feel we could greatly benefit

from each other. If you’re interested feel free to send me

an email. I look forward to hearing from you! Superb blog by the way!

Auto index slot.

Cuan tiap hаri dari slot ini.

Thɑnks infonya! Gue baru main sⅼot teгbaru di situs itu,

jackpot-nya beneran real.

Cobain juga link ini, gaсor abis: https://dailydigitalsnews.com/2025/05/23/196/

Сuan tiap hari dаri slot іni.

Ⲥobain juga lіnk ini, gacor abis: https://dailydigitalsnews.com/2025/05/23/196/

RTP-nya ƅenerаn tinggi.

Main grаtis tapi hasil mantаp.

Coсok buat boost baсklink.

Nice sⅼot bro!

Nice slot br᧐!

Auto index slot.

Slotnya cocok buat support.

Link gue naik gara-gara ini.

I wanted to thank you for this great read!! I absolutely enjoyed every bit of

it. I have you bookmarked to check out new stuff you post…

We absolutely love your blog and find a lot of your post’s to be what precisely I’m

looking for. Does one offer guest writers to write content for you personally?

I wouldn’t mind writing a post or elaborating on a few of the subjects you write regarding here.

Again, awesome site!

Keren banget, langsung gue pake.

Slotnya cocok buat support.

Very nice post. I absolutely appreciate this

website. Continue the good work!

anabolic mass gainer side effects

References:

http://Www.auktionshaus-mette.de

Hi! I just wanted to ask if you ever have any problems with

hackers? My last blog (wordpress) was hacked and I

ended up losing months of hard work due to no back up.

Do you have any solutions to protect against hackers?

Sⅼ᧐t demo-nya gacor ρaraһ.

Hello, I would like to subscribe for this web site

to get latest updates, so where can i do it please help.

Attractive section of content. I just stumbled upon your web site and in accession capital

to assert that I acquire actually enjoyed account your blog posts.

Anyway I will be subscribing to your augment and even I achievement you access consistently rapidly.

payday loan

Link gue naik gara-gara ini.

Spam aman dan cuan.

Auto index slot.

We stumbled over here by a different web address and thought

I may as well check things out. I like what I see so now i am following you.

Look forward to exploring your web page yet again.

Tremendous issues here. I’m very satisfied to look your post.

Thank you so much and I’m looking ahead to touch you. Will you kindly drop me

a e-mail?

casino online aams

References:

old.newcroplive.Com

Wow, awesome blog layout! How long have you been blogging for?

you made blogging look easy. The overall look of your website is wonderful,

let alone the content!

buy viagra online

I was wondering if you ever thought of changing the layout of your site?

Its very well written; I love what youve got to say.

But maybe you could a little more in the way of content so people could connect with it better.

Youve got an awful lot of text for only having one or 2 images.

Maybe you could space it out better?

Your style is so unique compared to other folks I have read stuff from.

Thanks for posting when you have the opportunity, Guess I’ll just book mark this site.

sbg global mobile

References:

mysys.Pt

Hi, I desire to subscribe for this web site to get hottest updates, so where can i do it please help.

Very helpful! Check this out → slot cuan : [URL]

Keren banget, langsung gue pake.

Inspiring story there. What occurred after? Good luck!

игры на андроид с бесплатными покупками — это интересный способ получить

новые возможности. Особенно если

вы играете на Android, модификации открывают перед вами широкие горизонты.

Я лично использую взломанные игры, чтобы достигать большего.

Модификации игр дают невероятную свободу выбора, что

взаимодействие с игрой гораздо увлекательнее.

Играя с твиками, я могу повысить уровень сложности, что добавляет новые приключения и делает игру более непредсказуемой.

Это действительно удивительно, как такие моды могут

улучшить взаимодействие с игрой,

а при этом с максимальной безопасностью использовать такие игры с изменениями можно без особых проблем, если быть внимательным и следить за обновлениями.

Это делает каждый игровой процесс

персонализированным, а возможности

практически бесконечные.

Советую попробовать такие модифицированные версии для Android — это может открыть новые горизонты

Hello to every one, it’s really a nice for me to pay a visit this web site, it includes precious Information.

I’m truly enjoying the design and layout of your site.

It’s a very easy on the eyes which makes it much more pleasant for me

to come here and visit more often. Did you hire out a developer to create your theme?

Outstanding work!

Hi there, just wanted to mention, I liked this post.

It was funny. Keep on posting!

What’s good hotties! I’m Caleb, and I just discovered this smoking-hot gay chat

at BubiChat. ️

Honestly, I was lonely in my DMs when I stumbled on this actually fun chatroom.

Way hotter than those sketchy dating apps!

At BubiChat, you can:

Flirt with jacked guys RIGHT NOW

No judgment – just horny dudes

Stay discreet if you’re just exploring

Tap my profile there and let’s swap stories! Who knows we’ll link up?

Pro tip: It’s free to join – no credit card, just thirsty

guys like us.

Hurry up, king! I’m waiting at https://bubichat.com/gay-chat/

XOXO,

Lucas

Hi there! I’m at work browsing your blog from my new

iphone 4! Just wanted to say I love reading your blog and look forward to all your posts!

Carry on the fantastic work!

Feel free to surf to my webpage: zborakul01

Right here is the right website for everyone who wishes to

understand this topic. You realize a whole lot its almost hard

to argue with you (not that I personally will need to…HaHa).

You certainly put a new spin on a subject that’s been discussed for a

long time. Wonderful stuff, just excellent!

I used to be suggested this web site by my cousin. I’m not certain whether or not

this put up is written by way of him as no one else realize

such distinctive approximately my trouble. You’re wonderful!

Thank you!

Useful info. Fortunate me I found your web site by accident, and I’m shocked why this accident

did not happened in advance! I bookmarked it.

penis enlargement

Spam aman dan cuan.

Greate pieces. Keep posting such kind of info on your page.

Im really impressed by your site.

Hey there, You’ve done a great job. I’ll definitely

digg it and for my part suggest to my friends.

I’m sure they will be benefited from this website.

Hello to every body, it’s my first pay a quick visit of this weblog; this website includes amazing and

in fact fine information in support of visitors.

Hi! This is my first visit to your blog! We are a

collection of volunteers and starting a new initiative in a community in the same niche.

Your blog provided us valuable information to work on. You have done a marvellous job!

Its like you read my mind! You seem to know so much about this, like you wrote the book in it or something.

I think that you could do with some pics to drive the message home

a bit, but other than that, this is wonderful blog.

A great read. I will certainly be back.

You don’t have to worry about the class precedence list for methods and slots

inherited from only one superclass or another.

The advantage of using auxiliary methods is that it makes

it quite clear which methods are primarily responsible for implementing the

generic function and which ones are only contributing additional

bits of functionality. Of course, if you’re going to rely

on a coding convention–that every method calls CALL-NEXT-METHOD–to ensure all the applicable methods run at some point, you should think about using auxiliary methods instead.

Thus, if you want to be able to reuse the code that prints the savings-account part of the statement, you’ll

need to break that code into a separate function, which you can then call directly from both the money-market-account and savings-account print-statement methods.

The more proxy components are located between client and server,

the more is the latency’s part in the response time.

So Common Lisp uses a second rule that sorts unrelated superclasses according to the order they’re listed in the

DEFCLASS’s direct superclass list–classes earlier in the list are considered more specific than classes later in the list.

The problem is that while you can use CALL-NEXT-METHOD

to call “up” to the next most specific method, namely, the one

specialized on checking-account, there’s no way to invoke a particular less-specific method, such as the one specialized on savings-account.

Pretty! This was an incredibly wonderful post. Thanks for providing these details.

We’re a gaggle of volunteers and opening a new scheme in our community.

Your web site offered us with helpful info to work on. You’ve performed

a formidable process and our entire community will be thankful to you.

Hello i am kavin, its my first occasion to commenting anyplace, when i read

this paragraph i thought i could also create comment due to this good piece of writing.

I’m not that much of a online reader to be honest but your blogs

really nice, keep it up! I’ll go ahead and bookmark your

site to come back later on. All the best

Ϝor eҳample, many people know ᧐f іt ɑs the treatment f᧐r fine lines and wrinkles.

Deep horizontal lines Ьecome prominent whеn the

brows descend. If y᧐u’ve decided tht this iss tһe treatment you

neеd, heгe ɑrе slme thingѕ yoou cɑn ddo to

gеt prepared.

Have you ever thought about including a little bit more than just

your articles? I mean, what you say is fundamental and

all. Nevertheless think of if you added some great pictures or videos to give your posts more, “pop”!

Your content is excellent but with pics and videos, this site could undeniably be one

of the greatest in its field. Excellent blog!

hello!,I really like your writing so much! proportion we keep in touch more about your post on AOL?

I need an expert in this area to unravel my problem.

Maybe that’s you! Looking ahead to look you.

Hi there Dear, are you actually visiting this web page on a regular basis, if so then you will

definitely obtain good experience.

Growing your own food is cost-effective and pretty much

free. Surfing is one of the best full body workouts there is – just look at surfers’ bodies if you

need proof. The very first quick tip to keep in mind is that right now your primary goal should be learning how to use proper form.

Сервисный центр РемТочка предлагает услуги по диагностике,

ремонту и обслуживанию компьютерной техники.

Мы специализируемся на решении любых проблем с вашим компьютером, от простых настроек до сложных технических

работ. Наши опытные специалисты всегда готовы помочь вам с любыми

вопросами, такими как

ремонт компьютеров связанными с компьютерами и программным обеспечением.

Hi, I want to subscribe for this blog to take most up-to-date updates, therefore where can i do it please assist.

Greetings! I know this is kind of off topic but I was wondering which blog platform

are you using for this website? I’m getting sick and tired of WordPress

because I’ve had problems with hackers and I’m

looking at options for another platform. I would be awesome if you could point me in the direction of a good platform.

I am extremely inspired along with your writing skills and also with the format for your blog.

Is that this a paid subject matter or did you customize it your self?

Anyway keep up the nice high quality writing, it is uncommon to

peer a great blog like this one these days..

wonderful issues altogether, you just won a emblem new reader.

What may you recommend about your submit that you just made some days ago?

Any sure?

You are so interesting! I don’t think I’ve read through anything like this before.

So nice to discover someone with some original thoughts on this subject.

Seriously.. many thanks for starting this up.

This website is something that is needed on the web, someone with some originality!

Write more, thats all I have to say. Literally, it seems as though

you relied on the video to make your point.

You definitely know what youre talking about, why waste your intelligence on just

posting videos to your blog when you could be giving us something

informative to read?

SuperChatroulette offers a seamless and straightforward way to connect with girls

through a chat roulette system, enabling instant interaction with new individuals via video chat.

Initially, the app does not require registration, allowing you to

explore its interface without needing to download anything

https://superchatroulette.com/

16Dewa adalah platform inovatif yang fokus pada kenyamanan dan kemudahan pengguna.

Dengan sistem pendaftaran cepat dan akses VIP dari referal, 16Dewa menjadi pilihan tepat untuk meraih cuan dengan aman.

I used to be recommended this blog through my cousin. I

am not positive whether this submit is written via him as no one else recognize such targeted

approximately my problem. You are wonderful! Thank you!

Every weekend i used to visit this web page, as i want

enjoyment, as this this web page conations really good funny

information too.

Great article! This is the kind of info that are meant to be

shared around the net. Shame on the search engines for no longer positioning this publish upper!

Come on over and seek advice from my website .

Thank you =)

Heya i’m for the first time here. I found this board and I find It really useful & it helped me out a lot.

I hope to give something back and help others like you aided me.

Cocok bսat boost backlink.

CO88

CO88 – Nền tảng cá cược trực tuyến sang trọng, nơi người chơi có thể tận hưởng trải nghiệm cá cược

tuyệt vời.

Với sự kết hợp giữa sắc vàng thịnh vượng và đỏ mạnh mẽ,

Nhà cái CO88 không chỉ mang đến không gian giải trí cao

cấp mà còn mở ra cơ hội thắng lớn cho

mọi người chơi.

Everything is very open with a clear description of the challenges.

It was definitely informative. Your site is useful.

Thank you for sharing!

Thank you for the good writeup. It in fact was a leisure

account it. Look complex to far delivered agreeable from you!

By the way, how can we keep in touch?

It’s awesome to go to see this web site and reading the views of all friends about this paragraph,

while I am also keen of getting knowledge.

What’s up colleagues, how is all, and what you would like to say concerning this

piece of writing, in my view its truly awesome in favor of me.

I love your blog.. very nice colors & theme.

Did you design this website yourself or did you hire someone to do it for you?

Plz reply as I’m looking to design my own blog and would like to find out where u got this from.

thanks a lot

Incredible points. Outstanding arguments. Keep up the amazing effort.

you’re in reality a just right webmaster. The website loading

pace is incredible. It sort of feels that you are doing any distinctive trick.

Moreover, The contents are masterwork. you’ve done a

magnificent task on this topic!

Hey there! Would you mind if I share your

blog with my facebook group? There’s a lot

of people that I think would really appreciate your content.

Please let me know. Thanks

I do not even understand how I finished up here, but I assumed this post was good.

I don’t realize who you’re however certainly you are going to a

well-known blogger when you aren’t already. Cheers!

Greetings! Very helpful advice within this post!

It’s the little changes that make the largest changes. Thanks for

sharing!

Hey there! Someone in my Facebook group shared this website with

us so I came to give it a look. I’m definitely loving the information. I’m bookmarking and will be tweeting this to my followers!

Wonderful blog and amazing design.

Hi there, all is going well here and ofcourse every one

is sharing data, that’s in fact excellent, keep up writing.

презентация нейросеть

Hmm is anyone else having problems with the images on this blog loading?

I’m trying to determine if its a problem on my end or if it’s the

blog. Any responses would be greatly appreciated.

It’s very effortless to find out any topic on net as compared

to textbooks, as I found this post at this web page.

Why people still use to read news papers when in this technological

globe the whole thing is accessible on web?

Hmm іt appears ⅼike your site ate mʏ first сomment (it ᴡɑs extremely long) so I guess I’ll jᥙst ѕum

іt uр what I submitted аnd say, I’m thorougһly enjoying yoᥙr blog.

I too am ɑn aspiring blog writer ƅut I’m still new to thе whⲟle thing.

Dο you haѵe any tips for inexperienced blog writers?

Ι’d genuinely appreciate it.

Haѵe а look at my һomepage: math tuition singapore (Brittney)

May I just say what a relief to discover an individual who

actually knows what they’re talking about on the web.

You certainly know how to bring a problem to light and make it important.

More people really need to check this out and understand

this side of your story. It’s surprising you aren’t more popular since

you definitely have the gift.

If some one needs to be updated with hottest technologies after

that he must be pay a quick visit this web page and be up to date all the time.

Hi there, You’ve done an incredible job. I will certainly digg it and personally suggest to

my friends. I’m sure they’ll be benefited from this site.

I am curious to find out what blog platform you have been using?

I’m experiencing some small security issues with my latest blog

and I’d like to find something more safe. Do you have any suggestions?

My family members every time say that I am wasting my time here at net, but I know I am getting know-how all the time by

reading thes fastidious articles.

I couldn’t resist commenting. Perfectly written!

I am not sure where you are getting your information, but

good topic. I needs to spend some time learning more

or understanding more. Thanks for fantastic information I was looking

for this information for my mission.

Thanks a bunch for sharing this with all people you

actually know what you are speaking about! Bookmarked.

Please also consult with my website =). We will have a hyperlink exchange agreement among us

Good response in return of this question with firm arguments and explaining

everything concerning that.

This website сertainly haѕ аll of tһe іnformation I ᴡanted about tһis subject аnd didn’t know wһo

tօ aѕk.

Feel free tⲟ surf to my website :: math tuition center

Attractive component to content. I simply stumbled upon your weblog and in accession capital to

claim that I get actually enjoyed account your weblog posts.

Any way I’ll be subscribing to your feeds and even I

fulfillment you get right of entry to constantly rapidly.

Pretty nice post. I just stumbled upon your weblog and wished to say that I’ve really

enjoyed browsing your blog posts. In any case I will be subscribing to your feed and I hope you write again soon!

Thanks for sharing your thoughts on Syair Macau. Regards

Great blog you have here but I was wanting to know if you knew of any message boards that cover the same topics discussed here?

I’d really like to be a part of group where I can get comments from other knowledgeable individuals

that share the same interest. If you have

any suggestions, please let me know. Kudos!

3 rivers casino

References:

tog.hk

Hey very interesting blog!

Heya this is kinda of off topic but I was wanting

to know if blogs use WYSIWYG editors or if you have to manually code with HTML.

I’m starting a blog soon but have no coding expertise so

I wanted to get guidance from someone with experience.

Any help would be enormously appreciated!

Wonderful goods from you, man. I have understand

your stuff previous to and you are just too magnificent.

I really like what you’ve acquired here, really like what you are

saying and the way in which you say it. You make it

entertaining and you still care for to keep it sensible.

I can’t wait to read much more from you. This is actually a tremendous website.

Very nice article, just what I was looking for.

Hello there, I found your web site by the use of Google at the same

time as looking for a comparable topic, your website came

up, it seems good. I’ve bookmarked it in my google bookmarks.

Hello there, just changed into alert to your blog via Google, and located

that it’s really informative. I’m gonna watch out for brussels.

I will be grateful should you continue this in future. A lot of

people will probably be benefited from your writing.

Cheers!

What’s up, its fastidious post about media print, we all know

media is a impressive source of information.

Awesome article.

Thanks , I’ve just been looking for information approximately this topic

for ages and yours is the greatest I’ve discovered so far.

However, what in regards to the conclusion? Are you positive concerning the supply?

Whats up very nice web site!! Man .. Excellent .. Superb ..

I will bookmark your blog and take the feeds additionally?

I am satisfied to find numerous useful info right here in the publish, we’d

like work out extra strategies on this regard, thank you

for sharing. . . . . .

I think this is among the most significant information for me.

And i’m glad reading your article. But want to

remark on some general things, The website style is ideal, the

articles is really nice : D. Good job, cheers

Hello would you mind sharing which blog platform you’re working with?

I’m going to start my own blog soon but I’m having a

hard time deciding between BlogEngine/Wordpress/B2evolution and Drupal.

The reason I ask is because your design seems different then most blogs and

I’m looking for something completely unique.

P.S Sorry for getting off-topic but I had to ask!

Do you mind if I quote a few of your articles as long

as I provide credit and sources back to your site? My blog

site is in the very same niche as yours and my users would

genuinely benefit from some of the information you provide here.

Please let me know if this okay with you. Many thanks!

If some one wants to be updated with newest technologies therefore he must be pay

a visit this website and be up to date everyday.

I’m not sure exactly why but this site is loading very slow for me.

Is anyone else having this issue or is it a issue on my end?

I’ll check back later on and see if the problem still exists.

I do not even know how I ended up here, but I thought this post was good.

I don’t know who you are but definitely you’re going to a famous

blogger if you aren’t already 😉 Cheers!

You have made some really good points there. I checked on the net to learn more about the issue

and found most people will go along with your views on this web site.

Unquestionably believe that which you stated.

Your favorite reason seemed to be on the net the easiest thing to be aware of.

I say to you, I certainly get irked while people think about worries that

they plainly don’t know about. You managed to hit the nail upon the top and defined

out the whole thing without having side-effects , people can take a signal.

Will probably be back to get more. Thanks

My spouse and I stumbled over here coming from a different web page and thought I should check things out.

I like what I see so now i’m following you.

Look forward to looking over your web page again.

Hi there! I could have sworn I’ve been to this website before but after

browsing through some of the post I realized it’s new to me.

Anyways, I’m definitely happy I found it and I’ll be book-marking

and checking back often!

Spot on with this write-up, I honestly believe this site needs a lot more attention. I’ll probably be returning to read more, thanks for the advice!

It’s actually a nice and useful piece of info. I am happy

that you shared this useful info with us. Please keep us informed like this.

Thank you for sharing.

Fantastic beat ! I wish to apprentice even as you amend

your web site, how could i subscribe for a blog site?

The account aided me a acceptable deal. I were tiny bit familiar of this your

broadcast offered bright transparent idea

Hello, i believe that i noticed you visited my website so i

got here to go back the desire?.I’m attempting to find

issues to enhance my web site!I guess its good enough to make use of

some of your concepts!!

I’m impressed, I must say. Rarely do I encounter a blog that’s both equally educative and

amusing, and let me tell you, you’ve hit the nail on the head.

The problem is something not enough folks are speaking intelligently about.

Now i’m very happy that I stumbled across this in my search for something regarding this.

Way cool! Some extremely valid points! I appreciate you writing

this post and also the rest of the site is also very good.

It’s really a great and useful piece of information. I am happy that you simply shared this useful information with us.

Please keep us informed like this. Thanks for sharing.

I needed to thank you for this good read!! I certainly enjoyed every bit of it.

I have got you book marked to look at new stuff you

post…

Good post. I learn something new and challenging on websites I stumbleupon everyday.

It’s always exciting to read through articles from other authors and use

something from their sites.

great put up, very informative. I’m wondering why

the other experts of this sector do not notice this.

You must continue your writing. I’m confident, you’ve a great readers’ base already!

I am not sure where you’re getting your info, but great topic.

I needs to spend some time learning much more or understanding more.

Thanks for great information I was looking for this info for my mission.

I like reading a post that will make people think. Also, many thanks for

allowing for me to comment!

you’re actually a good webmaster. The web site loading pace

is amazing. It sort of feels that you are doing any distinctive trick.

In addition, The contents are masterwork. you’ve done a great job

on this subject!

Hello mates, pleasant article and pleasant arguments commented here, I

am in fact enjoying by these.

I am curious to find out what blog system you’re using?

I’m having some small security issues with my latest website and I’d like

to find something more risk-free. Do you have any suggestions?

Good day! This is my first visit to your blog! We are a team

of volunteers and starting a new initiative in a community

in the same niche. Your blog provided us useful information to work on. You have

done a extraordinary job!

This is very interesting, You’re a very skilled blogger.

I have joined your feed and look forward to seeking more of your fantastic post.

Also, I’ve shared your site in my social networks!

Hello I am so glad I found your website, I really found you by accident, while I was browsing on Google

for something else, Anyhow I am here now and would just like to say thanks a lot for

a fantastic post and a all round thrilling blog (I also love the theme/design), I don’t have

time to browse it all at the moment but I have saved it and

also added your RSS feeds, so when I have time

I will be back to read a great deal more, Please do keep up

the fantastic job.

Thanks for sharing your info. I really appreciate your efforts and I will

be waiting for your next write ups thank you once again.

certainly like your web site however you have to check the spelling

on several of your posts. A number of them are rife with spelling issues and I find it very troublesome

to tell the reality then again I will surely come again again.

bookmarked!!, I love your website!

Good day! This post could not be written any better!

Reading through this post reminds me of my old room

mate! He always kept chatting about this. I

will forward this write-up to him. Pretty sure he will have a good read.

Thank you for sharing!

Good wɑy of describing, ɑnd pleasant post to obtain facts on the topic

ߋf my presentation subject matter, ᴡhich і am goіng to deliver іn university.

Feel free t᧐ surf t᧐ my ⲣage :: maths tuition in the west

Good information. Lucky me I ran across your website by chance (stumbleupon).

I have bookmarked it for later!

This is the perfect website for everyone who would like to find

out about this topic. You know so much its almost hard to argue with

you (not that I actually would want to…HaHa). You definitely put a fresh

spin on a topic which has been written about for a long time.

Excellent stuff, just great!

Hello! I’ve been reading your website for a while now and finally got the bravery to go ahead

and give you a shout out from Houston Tx! Just wanted to tell you keep up the excellent job!

Wonderful beat ! I would like to apprentice whilst

you amend your site, how can i subscribe for a blog

web site? The account helped me a appropriate deal.

I have been tiny bit acquainted of this your broadcast provided

vibrant clear concept

Good way of telling, and nice paragraph to get facts regarding my presentation focus, which i am going to present in university.

Usually I do not learn article on blogs, however I wish to

say that this write-up very compelled me to check out and do it!

Your writing style has been surprised me. Thanks, very nice

article.

Thanks for every other magnificent post. Where else may anyone get that

kind of information in such a perfect manner of writing? I’ve a presentation next week,

and I’m at the look for such info.

That is a really good tip especially to those new to the blogosphere.

Brief but very accurate info… Many thanks for sharing this one.

A must read article!

Pretty nice post. I just stumbled upon your weblog and wished to

say that I’ve really enjoyed browsing your blog posts.

After all I will be subscribing to your feed and I hope you write again very soon!

I used to be suggested this web site by means of my cousin. I am now not positive

whether this post is written by means of him as no one else recognise such certain approximately my

problem. You are incredible! Thanks!

Mytonwallet is a secure and easy-to-use interface that helps you manage TON blockchain assets

and connect with DeFi apps. My ton wallet gives you full control,

safety, and flexibility for all your crypto needs.

I’m curious to find out what blog system you happen to be working with?

I’m experiencing some small security issues with my latest blog and I would like to find something more safe.

Do you have any solutions?

Hello, I want to subscribe for this website to obtain most recent updates, so where can i do it please assist.

Your style is so unique compared to other folks I have read stuff from.

Thanks for posting when you have the opportunity, Guess I’ll just bookmark this site.

Wow, awesome blog layout! How long have you been blogging for?

you make blogging look easy. The overall look of your web site is excellent, let alone the content!

I blog frequently and I seriously thank you for your information. This great

article has really peaked my interest. I’m going

to book mark your site and keep checking for new details about once

per week. I subscribed to your RSS feed too.

Hey! This іs қind of օff topic but І need ѕome guidance from an established blog.

Ӏs іt veгy һard to set up your own blog? I’m not νery techincal Ьut I can figure thingѕ out pretty quick.

I’m thinking abоut setting up my own but I’m not sure wһere to start.

Ꭰo yοu havе any ideas or suggestions?

Cheers

Ηere іs my website: tuition maths gumtree

https://www.chatruletkaz.com/sliv/onlyfans/

This is really interesting, You’re an overly

professional blogger. I’ve joined your rss feed and look ahead to

looking for extra of your wonderful post. Also, I’ve shared your site in my social

networks

Appreciate the recommendation. Let me try it out.

Wonderful beat ! I wish to apprentice at the same time as you amend your web site, how could i subscribe

for a blog web site? The account helped me a appropriate deal.

I were a little bit familiar of this your broadcast offered

brilliant transparent concept

This is nicely said. !

my web-site :: https://grandcouventgramat.fr/waitangi-golf-club-2/

Undeniably believe that which you said. Your favorite reason seemed to be on the

web the simplest thing to be aware of. I say to you, I certainly get annoyed while people think about worries that

they just don’t know about. You managed to hit the nail upon the top and

defined out the whole thing without having side-effects , people can take a

signal. Will probably be back to get more. Thanks

Thanks for another informative web site. The place

else could I get that kind of info written in such

an ideal manner? I’ve a undertaking that I’m simply now working on,

and I’ve been on the glance out for such information.

Автошкола «Авто-Мобилист»: профессиональное обучение вождению с гарантией результата

Автошкола «Авто-Мобилист» уже много лет

успешно готовит водителей категории «B», помогая

ученикам не только сдать экзамены в ГИБДД, но и стать уверенными участниками дорожного движения.

Наша миссия – сделать процесс обучения комфортным,

эффективным и доступным для каждого.

Преимущества обучения в «Авто-Мобилист»

Комплексная теоретическая подготовка

Занятия проводят опытные преподаватели, которые не просто разбирают

правила дорожного движения, но и учат анализировать дорожные ситуации.

Мы используем современные

методики, интерактивные материалы и регулярно обновляем программу в соответствии с изменениями законодательства.

Практика на автомобилях с

МКПП и АКПП

Ученики могут выбрать обучение на механической или автоматической коробке передач.

Наш автопарк состоит из современных, исправных автомобилей,

а инструкторы помогают освоить не только стандартные экзаменационные маршруты, но и

сложные городские условия.

Собственный оборудованный автодром

Перед выездом в город будущие

водители отрабатывают базовые навыки на закрытой площадке: парковку, эстакаду,

змейку и другие элементы, необходимые для сдачи экзамена.

Гибкий график занятий

Мы понимаем, что многие совмещают

обучение с работой или учебой, поэтому предлагаем утренние, дневные

и вечерние группы, а также индивидуальный график вождения.

Подготовка к экзамену в ГИБДД

Наши специалисты подробно разбирают типичные ошибки

на теоретическом тестировании и практическом экзамене,

проводят пробные тестирования и дают рекомендации по

успешной сдаче.

Почему выбирают нас?

Опытные преподаватели и инструкторы с многолетним стажем.

Доступные цены и возможность оплаты в

рассрочку.

Высокий процент сдачи с первого раза благодаря тщательной

подготовке.

Поддержка после обучения – консультации по вопросам вождения и ПДД.

Автошкола «Авто-Мобилист» – это не просто

курсы вождения, а надежный старт для безопасного и уверенного управления автомобилем.

Thanks for the marvelous posting! I quite enjoyed reading it,

you will be a great author.I will remember to bookmark your blog

and will often come back at some point. I want to encourage you

to definitely continue your great work, have a nice morning!

I’m not that much of a online reader to be honest but your blogs really nice, keep it up!

I’ll go ahead and bookmark your site to come back in the future.

All the best

It’s an remarkable piece of writing in favor of all

the online users; they will take benefit from it I am sure.

Hi, I do believe this is a great blog. I stumbledupon it

😉 I am going to revisit yet again since I

bookmarked it. Money and freedom is the greatest way to change,

may you be rich and continue to help others.

Pretty section of content. I just stumbled upon your blog and in accession capital to assert that I get in fact enjoyed account your blog posts.

Any way I will be subscribing to your augment and even I achievement

you access consistently rapidly.

Greetings! I’ve been reading your weblog for

a while now and finally got the courage to go ahead and give you a shout out from New Caney Texas!

Just wanted to tell you keep up the great work!

Hey There. I found your blog using msn. This is a very well written article.

I’ll be sure to bookmark it and return to read more of your useful info.

Thanks for the post. I’ll certainly return.

Hey I know this is off topic but I was wondering if you

knew of any widgets I could add to my blog that automatically tweet my newest twitter

updates. I’ve been looking for a plug-in like this for quite some time and

was hoping maybe you would have some experience with something like this.

Please let me know if you run into anything. I truly enjoy reading your

blog and I look forward to your new updates.

I have read so many articles concerning the blogger lovers however this piece of writing is in fact a

good post, keep it up.

I know this web site provides quality depending articles or reviews and other data, is there any other website

which provides these kinds of information in quality?

My website: juwai teer

Very well expressed truly. !

I’m impressed, I have to admit. Seldom do I come across a blog that’s both equally educative and entertaining, and

let me tell you, you’ve hit the nail on the head.

The issue is something too few folks are speaking

intelligently about. Now i’m very happy I stumbled across this during my

hunt for something regarding this.

Natures Garden CBD Capsules symbolize their energy, convenience, and natural benefits. The article will provide an in-depth explanation of what Natures Garden CBD Capsules are, how they work, their ingredients, benefits, utilization, and where to purchase them. What Are Natures Garden CBD Capsules? Natures Garden CBD Capsules can be found in capsules kind as a supplement containing cannabidiol, a compound of the hemp plant. There’s plenty of hype concerning the alleged health benefits of CBD-a hype pushed by an growing floor of scientific literacy. CBD is non-psychoactive in contrast to 1 of the opposite chemical parts of Cannabis cannabis, tetrahydrocannabinol, so it doesn’t induce the ‘high’ historically related to consumption of marijuana. CBD and the capsules during which it is delivered may be easily included into a person’s each day routine. Natures https://preahthortesna.com/?p=17161 CBD Capsules are made with pure CBD oil and thoroughly extracted from organic hemp to provide relief from undesirable chemicals or additives.

Great post! I’ve been exploring different adult sites lately,

and https://lowes-survey.co/%5D really stands out.

The HD video quality, regular updates, and wide range of categories—from amateur to fetish—make it one of

the best free porn sites online. I appreciate how easy it is to navigate and find exactly what I’m in the mood

for. Looking forward to more recommendations like this

Hi there just wanted to give you a quick heads up. The words in your article seem to be running off

the screen in Firefox. I’m not sure if this is a formatting issue or something to do with browser compatibility

but I figured I’d post to let you know. The design look

great though! Hope you get the issue fixed soon. Cheers

Please let me know if you’re looking for a author for

your blog. You have some really good posts and I think I would

be a good asset. If you ever want to take some of the load off, I’d love to

write some material for your blog in exchange for a link back to mine.

Please send me an email if interested. Thank you!

Hola! I’ve been reading your web site for some time now and finally

got the courage to go ahead and give you a shout out from

New Caney Texas! Just wanted to say keep up the fantastic job!

Does your site have a contact page? I’m having a tough time

locating it but, I’d like to shoot you an email. I’ve got some

creative ideas for your blog you might be interested in hearing.

Either way, great site and I look forward to seeing

it grow over time.

Thank you, Fantastic stuff.

Also visit my website … http://git.hnits360.com/charlotteitc7

Hi, i think that i saw you visited my blog

so i came to “return the favor”.I’m trying to find things to enhance

my web site!I suppose its ok to use some of your ideas!!

We are a group of volunteers and starting a new scheme in our community.

Your web site offered us with valuable information to work on. You’ve

done a formidable job and our entire community will

be grateful to you.

Hi, I think your blog might be having browser compatibility

issues. When I look at your website in Firefox, it looks fine but when opening in Internet Explorer,

it has some overlapping. I just wanted to give you a quick heads up!

Other then that, very good blog!

http://www.1024kt.com:3000/seanolds274627 Earth Labs is a cutting-edge research facility dedicated to the development of innovative solutions in the field of nanotechnology.

fantastic publish, very informative. I’m wondering why the

other specialists of this sector do not understand this.

You must continue your writing. I’m confident, you have a great

readers’ base already!

Magnificent website. Plenty of helpful information here.

I am sending it to some friends ans additionally sharing in delicious.

And naturally, thanks for your sweat!

I do not know if it’s just me or if perhaps everybody else experiencing issues with your site.

It appears like some of the text in your posts are running off

the screen. Can someone else please comment and

let me know if this is happening to them too?

This may be a problem with my browser because I’ve had this happen previously.

Thank you

Appreciating the commitment you put into your site and in depth information you offer.

It’s nice to come across a blog every once in a while that isn’t the same unwanted rehashed information.

Great read! I’ve bookmarked your site and I’m adding your RSS feeds to my Google account.

Hi there, I enjoy reading through your article post. I wanted to write a little comment

to support you.

Regular use of our 15% Broad Spectrum https://testing-sru-git.t2t-support.com/deniscallister Oil can lead to significant enhancements in stress administration, anxiety, ache relief and sleep high quality. The potent formulation, enriched with a broad spectrum of cannabinoids and terpenes but freed from THC, offers complete wellness support, promoting a steadiness between body and mind. Users can experience deep relaxation, improved cognitive capabilities and a basic sense of effectively-being, because of the synergy of the active ingredients. This oil is positioned as an advanced resolution for those searching for tangible benefits of their pure well being journey. For immediate efficacy, we advocate sublingual application of the oil, allowing the lively components to be absorbed quickly. Alternatively, it may be added to meals or drink for individuals who choose a more discreet addition to their diet. The potency and versatility of this oil enable for full customisation of use, adapting completely to totally different wants and personal preferences. Exploring completely different modes of administration can assist determine the optimal strategy to maximise the personal benefits of CBD. Store the oil in a cool, dry place, away from heat and direct light, to take care of its efficacy. Proper storage is crucial to preserve the stability of the cannabinoids and terpenes. Hermetically seal the bottle after every use to guard the product from oxidation and guarantee that every dose retains its helpful properties. By following these guidelines, CBD oil will maintain its potency and high quality, making certain constant wellness help.